Generalisierungsfehler

Der Generalisierungsfehler ist eine zentrale Kennzahl im maschinellen Lernen und quantifiziert die Fähigkeit eines Modells, Ergebnisse für unbekannte Daten vorherzusagen und so eine robuste Leistung in realen Anwendungen sicherzustellen.

Der Generalisierungsfehler, auch als Out-of-Sample-Fehler oder Risiko bezeichnet, ist ein zentrales Konzept im maschinellen Lernen und der statistischen Lerntheorie. Er quantifiziert, wie gut ein Modell oder Algorithmus Ergebnisse für unbekannte Daten vorhersagen kann – basierend auf seinem Training mit einem endlichen Datensatz. Das primäre Ziel bei der Bewertung des Generalisierungsfehlers ist es, die Fähigkeit eines Modells zu verstehen, auf neuen, bisher ungesehenen Daten gute Leistungen zu erbringen, statt nur auf den Trainingsdaten. Dieses Konzept ist entscheidend für die Entwicklung von Modellen, die sowohl genau als auch robust in realen Anwendungen sind.

Verständnis des Generalisierungsfehlers

Im Kern ist der Generalisierungsfehler die Abweichung zwischen den Vorhersagen eines Modells und den tatsächlichen Ergebnissen auf neuen Daten. Dieser Fehler entsteht aus verschiedenen Quellen, darunter Modellungenauigkeiten, Stichprobenfehler und inhärentes Rauschen in den Daten. Während einige dieser Fehler durch Techniken wie Modellauswahl und Parametertuning minimiert werden können, sind andere – wie das Rauschen – nicht reduzierbar.

Bedeutung im maschinellen Lernen

Im überwachten Lernen dient der Generalisierungsfehler als entscheidende Kennzahl zur Bewertung der Leistungsfähigkeit von Algorithmen. Er stellt sicher, dass ein Modell nicht nur die Trainingsdaten abbildet, sondern auch effektiv Vorhersagen in realen Szenarien ermöglicht. Das ist essenziell für Anwendungsbereiche von Data Science bis hin zu KI-gesteuerter Automatisierung in Chatbots und anderen KI-Systemen.

Overfitting und Underfitting

Der Generalisierungsfehler steht in engem Zusammenhang mit den Begriffen Overfitting und Underfitting:

- Overfitting tritt auf, wenn ein Modell die Trainingsdaten zu gut lernt – einschließlich des Rauschens – und dadurch auf unbekannten Daten schlecht abschneidet.

- Underfitting entsteht, wenn ein Modell zu einfach ist, um die zugrunde liegenden Muster in den Daten zu erkennen, wodurch es sowohl auf Trainings- als auch auf unbekannten Daten schwach performt.

Mathematische Definition

Mathematisch wird der Generalisierungsfehler ( I[f] ) einer Funktion ( f ) als Erwartungswert einer Verlustfunktion ( V ) über die gemeinsame Wahrscheinlichkeitsverteilung der Input-Output-Paare ( (x, y) ) definiert:

[ I[f] = \int_{X \times Y} V(f(\vec{x}), y) \rho(\vec{x}, y) d\vec{x} dy ]

Hierbei ist ( \rho(\vec{x}, y) ) die gemeinsame Wahrscheinlichkeitsverteilung von Eingaben und Ausgaben, die in der Praxis typischerweise unbekannt ist. Stattdessen berechnen wir den empirischen Fehler (oder das empirische Risiko) basierend auf den Beispieldaten:

[ I_n[f] = \frac{1}{n} \sum_{i=1}^{n} V(f(\vec{x}_i), y_i) ]

Ein Algorithmus generalisiert gut, wenn der Unterschied zwischen Generalisierungsfehler und empirischem Fehler gegen Null geht, wenn die Stichprobengröße ( n ) gegen unendlich strebt.

Bias-Varianz-Tradeoff

Der Bias-Varianz-Tradeoff ist ein zentrales Prinzip zum Verständnis des Generalisierungsfehlers. Er beschreibt das Spannungsfeld zwischen zwei Fehlertypen:

- Bias: Fehler aufgrund zu einfacher Annahmen im Modell, wodurch die zugrunde liegenden Trends der Daten nicht erfasst werden.

- Varianz: Fehler durch eine zu hohe Sensibilität gegenüber kleinen Schwankungen in den Trainingsdaten, was oft zu Overfitting führt.

Das Ziel ist, ein Gleichgewicht zu finden, bei dem sowohl Bias als auch Varianz minimiert werden, um einen niedrigen Generalisierungsfehler zu erreichen. Dieses Gleichgewicht ist entscheidend für die Entwicklung genauer und robuster Modelle.

Techniken zur Minimierung des Generalisierungsfehlers

Es gibt verschiedene Techniken zur Minimierung des Generalisierungsfehlers:

- Cross-Validation: Verfahren wie die k-fache Kreuzvalidierung helfen dabei, die Modellleistung auf unbekannten Daten zu bewerten, indem die Daten mehrfach in Trainings- und Validierungssets aufgeteilt werden.

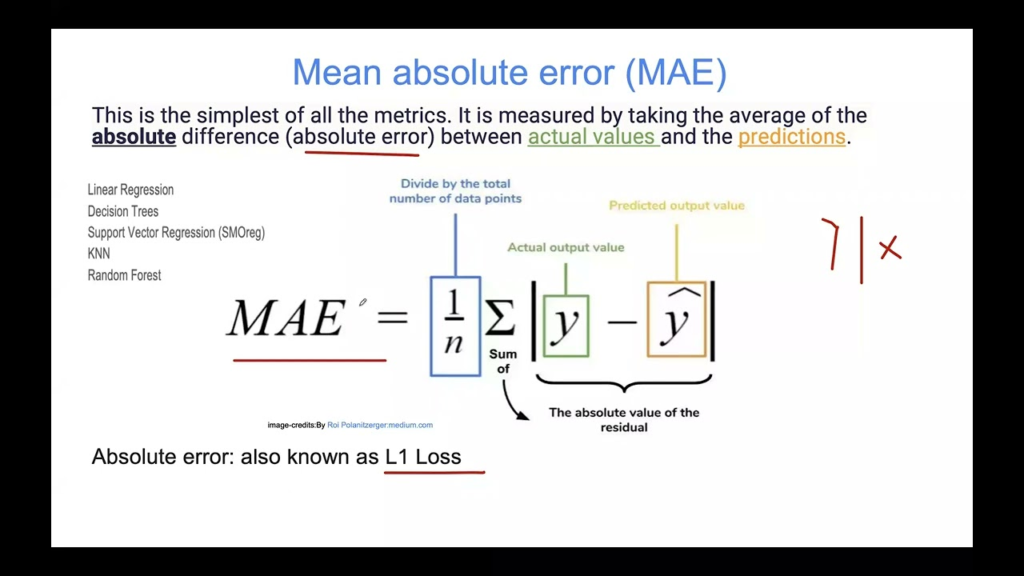

- Regularisierung: Methoden wie L1-(Lasso) und L2-(Ridge-)Regularisierung fügen eine Strafe für große Koeffizienten hinzu und verhindern so zu komplexe Modelle, die zu Overfitting neigen.

- Modellauswahl: Die Wahl der passenden Modellkomplexität in Abhängigkeit vom Problem und Datensatz hilft, den Bias-Varianz-Tradeoff effektiv zu steuern.

- Ensemble-Methoden: Techniken wie Bagging und Boosting kombinieren mehrere Modelle, um die Generalisierung durch Verringerung von Varianz und Bias zu verbessern.

Anwendungsfälle und Beispiele

KI- und Machine-Learning-Anwendungen

In KI-Anwendungen wie Chatbots ist ein niedriger Generalisierungsfehler entscheidend, damit der Bot auf eine Vielzahl von Nutzeranfragen präzise reagieren kann. Wenn ein Chatbot-Modell zu stark auf die Trainingsdaten angepasst ist, funktioniert es vielleicht nur bei vordefinierten Fragen, versagt aber bei neuen Nutzeranfragen.

Data-Science-Projekte

In der Data Science sind Modelle mit geringem Generalisierungsfehler unerlässlich, um Vorhersagen zu treffen, die auch auf unterschiedlichen Datensätzen verallgemeinerbar sind. Beispielsweise muss ein Modell in der prädiktiven Analytik, das auf historischen Daten trainiert wurde, zukünftige Trends akkurat vorhersagen können.

Überwachtes Lernen

Im überwachten Lernen besteht das Ziel darin, eine Funktion zu entwickeln, die für jeden Eingabewert den Ausgabewert vorhersagen kann. Der Generalisierungsfehler gibt Aufschluss darüber, wie gut diese Funktion auf neuen, im Training nicht enthaltenen Daten performt.

Bewertung von Lernalgorithmen

Der Generalisierungsfehler dient zur Bewertung der Leistungsfähigkeit von Lernalgorithmen. Durch die Analyse von Lernkurven, die Trainings- und Validierungsfehler im Zeitverlauf darstellen, lässt sich erkennen, ob ein Modell zu Overfitting oder Underfitting neigt.

Statistische Lerntheorie

In der statistischen Lerntheorie ist es zentral, die Differenz zwischen Generalisierungsfehler und empirischem Fehler zu begrenzen. Verschiedene Stabilitätsbedingungen, wie die Leave-One-Out-Cross-Validation-Stabilität, werden eingesetzt, um zu beweisen, dass ein Algorithmus gut generalisiert.

Generalisierungsfehler im maschinellen Lernen

Der Generalisierungsfehler ist ein entscheidendes Konzept im maschinellen Lernen und beschreibt die Differenz zwischen der Fehlerrate eines Modells auf Trainingsdaten und unbekannten Daten. Er spiegelt wider, wie gut ein Modell Ergebnisse für neue, ungesehene Beispiele vorhersagen kann.

Literaturhinweise:

Some observations concerning Off Training Set (OTS) error von Jonathan Baxter, veröffentlicht am 18. November 2019, untersucht eine Form des Generalisierungsfehlers, den sogenannten Off Training Set (OTS) error. Das Paper diskutiert einen Satz, der besagt, dass ein geringer Trainingsfehler nicht zwangsläufig einen geringen OTS-Fehler bedeutet, sofern nicht bestimmte Annahmen über die Zielfunktion gemacht werden. Der Autor argumentiert jedoch, dass die Anwendbarkeit des Satzes auf Modelle beschränkt ist, bei denen die Verteilung der Trainingsdaten nicht mit der der Testdaten überlappt – was in der Praxis meist nicht der Fall ist. Mehr erfahren

Stopping Criterion for Active Learning Based on Error Stability von Hideaki Ishibashi und Hideitsu Hino, veröffentlicht am 9. April 2021, stellt ein Stoppkriterium für Active Learning basierend auf Fehlerstabilität vor. Dieses Kriterium stellt sicher, dass die Änderung des Generalisierungsfehlers beim Hinzufügen neuer Beispiele durch die Annotierungskosten begrenzt ist und für jedes Bayes’sche Active-Learning-Framework geeignet ist. Die Studie zeigt, dass das vorgeschlagene Kriterium den optimalen Stoppzeitpunkt für Active Learning bei verschiedenen Modellen und Datensätzen effektiv bestimmt. Mehr erfahren

Häufig gestellte Fragen

- Was ist der Generalisierungsfehler im maschinellen Lernen?

Der Generalisierungsfehler bezeichnet die Differenz zwischen der Leistung eines Modells auf Trainingsdaten und seiner Fähigkeit, Ergebnisse für unbekannte Daten vorherzusagen. Er ist eine entscheidende Kennzahl, um zu bewerten, wie gut ein Modell in realen Szenarien funktioniert.

- Wie kann der Generalisierungsfehler minimiert werden?

Techniken wie Cross-Validation, Regularisierung, sorgfältige Modellauswahl und Ensemble-Methoden helfen dabei, den Generalisierungsfehler zu minimieren, indem sie Bias und Varianz ausbalancieren und so die Vorhersageleistung eines Modells für neue Daten verbessern.

- Warum ist der Generalisierungsfehler wichtig?

Das Verstehen und Minimieren des Generalisierungsfehlers stellt sicher, dass KI- und Machine-Learning-Modelle zuverlässig auf neue, reale Daten reagieren – und nicht nur auf die Beispiele, auf denen sie trainiert wurden.

- Was ist der Bias-Varianz-Tradeoff?

Der Bias-Varianz-Tradeoff beschreibt das Gleichgewicht zwischen Fehlern, die durch zu einfache Modellannahmen entstehen (Bias), und Fehlern, die durch eine zu starke Anpassung an Trainingsdaten verursacht werden (Varianz). Das richtige Gleichgewicht hilft, den Generalisierungsfehler zu minimieren.

Bereit, Ihre eigene KI zu erstellen?

Beginnen Sie mit dem Aufbau robuster KI-Modelle mit FlowHunt. Entdecken Sie intuitive Tools, um den Generalisierungsfehler zu minimieren und die Genauigkeit in der Praxis zu maximieren.