Stable Diffusion

Stable Diffusion ist ein führendes Text-zu-Bild-KI-Modell, das es Nutzern ermöglicht, fotorealistische Visualisierungen aus Prompts mithilfe fortschrittlicher latenter Diffusion und Deep-Learning-Techniken zu erstellen.

Stable Diffusion

Stable Diffusion ist ein Text-zu-Bild-KI-Modell, das mithilfe von Deep Learning hochwertige Bilder aus Beschreibungen erstellt. Für bessere Ergebnisse, insbesondere bei komplexen Elementen wie Händen, werden Techniken wie negative Prompts und Referenzbilder eingesetzt.

Stable Diffusion ist ein fortschrittliches Text-zu-Bild-Generierungsmodell, das Deep-Learning-Techniken nutzt, um hochwertige, fotorealistische Bilder auf Basis von Textbeschreibungen zu erzeugen. Entwickelt als latentes Diffusionsmodell stellt es einen bedeutenden Durchbruch im Bereich der generativen künstlichen Intelligenz dar, da es die Prinzipien von Diffusionsmodellen und maschinellem Lernen kombiniert, um Bilder zu erzeugen, die den gegebenen Text-Prompts sehr genau entsprechen.

Stable Diffusion verwendet Deep Learning und Diffusionsmodelle, um Bilder zu generieren, indem zufälliges Rauschen verfeinert wird, bis kohärente Visualisierungen entstehen. Trotz umfassenden Trainings mit Millionen von Bildern hat das Modell Schwierigkeiten mit komplexen Elementen wie Händen. Im Laufe der Zeit werden diese Probleme durch größere Datensätze jedoch minimiert und die Bildqualität wird immer realistischer.

Hände mit negativen Prompts korrigieren

Eine effektive Methode, um das Problem mit den Händen zu beheben, ist die Verwendung von negativen Prompts. Durch das Hinzufügen von Phrasen wie (-bad anatomy) oder (-bad hands -unnatural hands) zu Ihren Prompts können Sie die KI anweisen, verzerrte Merkmale zu vermeiden. Seien Sie jedoch vorsichtig mit übermäßigem Gebrauch von negativen Prompts, da diese die kreative Vielfalt des Modells einschränken können.

Referenzbilder nutzen

Eine weitere Technik besteht darin, Referenzbilder einzusetzen, um die KI zu leiten. Indem Sie ein {image}-Tag mit einem Link zu einem Referenzbild in Ihren Prompt einfügen, geben Sie der KI eine visuelle Vorlage für eine genaue Handdarstellung. Dies ist besonders nützlich, um korrekte Proportionen und Posen der Hände zu erhalten.

Techniken kombinieren für optimale Ergebnisse

Für die besten Resultate kombinieren Sie negative Prompts und Referenzbilder. Dieser zweigleisige Ansatz stellt sicher, dass die KI häufige Fehler vermeidet und sich an hochwertigen Beispielen orientiert.

Fortgeschrittene Tipps

- Verfeinern Sie Ihre Prompts, indem Sie Details wie

(-bent fingers)oder(realistische Perspektiven)angeben, um die Handqualität weiter zu verbessern.

Durch das Beherrschen dieser Techniken können Sie die Handdarstellung in Ihren Stable-Diffusion-Kreationen deutlich verbessern und Werke mit der Finesse eines erfahrenen Künstlers erzielen. Suchen Sie Ihre Referenzbilder heraus, erstellen Sie präzise Prompts und beobachten Sie, wie Ihre KI-Kunst sich weiterentwickelt!

Wie funktioniert Stable Diffusion?

Im Kern wandelt Stable Diffusion Text-Prompts durch eine Reihe von Rechenprozessen in visuelle Darstellungen um. Das Verständnis der Funktionsweise umfasst Diffusionsmodelle, latente Räume und neuronale Netze.

Diffusionsmodelle

Diffusionsmodelle sind eine Klasse generativer Modelle im maschinellen Lernen, die Daten erzeugen, indem sie einen Diffusionsprozess umkehren. Dabei wird den Daten – wie Bildern – nach und nach Rauschen hinzugefügt, bis sie nicht mehr von Zufallsrauschen zu unterscheiden sind. Das Modell lernt dann, diesen Prozess umzukehren, indem es das Rauschen schrittweise entfernt, um die Originaldaten wiederherzustellen. Dieser umgekehrte Diffusionsprozess ist der Schlüssel zur Generierung neuer, kohärenter Daten aus Zufallsrauschen.

Latente Diffusionsmodelle

Stable Diffusion verwendet speziell ein latentes Diffusionsmodell. Im Gegensatz zu klassischen Diffusionsmodellen, die direkt im hochdimensionalen Pixelraum von Bildern arbeiten, agieren latente Diffusionsmodelle in einem komprimierten latenten Raum. Dieser latente Raum ist eine niedrigdimensionale Darstellung der Daten, die wesentliche Merkmale einfängt und gleichzeitig die Rechenkomplexität reduziert. Durch das Arbeiten im latenten Raum kann Stable Diffusion hochauflösende Bilder effizienter erzeugen.

Der umgekehrte Diffusionsprozess

Der zentrale Mechanismus von Stable Diffusion ist der umgekehrte Diffusionsprozess im latenten Raum. Ausgehend von einem zufälligen Rausch-Latentvektor verfeinert das Modell diese Repräsentation schrittweise, indem es bei jedem Schritt das Rauschen vorhersagt und entfernt. Diese Verfeinerung wird von der Textbeschreibung des Nutzers geleitet. Der Prozess läuft so lange, bis der Latentvektor in einen Zustand überführt ist, der beim Decodieren ein Bild erzeugt, das dem Textprompt entspricht.

Architektur von Stable Diffusion

Die Architektur von Stable Diffusion integriert mehrere Schlüsselfunktionen, die zusammenarbeiten, um Text-Prompts in Bilder umzuwandeln.

1. Variational Autoencoder (VAE)

Der VAE dient als Encoder-Decoder-System, das Bilder in den latenten Raum komprimiert und sie anschließend wieder in Bilder rekonstruiert. Der Encoder wandelt ein Bild in seine latente Darstellung um und erfasst dabei die grundlegenden Merkmale in reduzierter Form. Der Decoder nimmt diese latente Repräsentation und rekonstruiert daraus das detaillierte Bild.

Dieser Prozess ist entscheidend, da das Modell so mit niedrigdimensionalen Daten arbeiten und den Rechenaufwand gegenüber dem Arbeiten im vollen Pixelraum stark reduzieren kann.

2. U-Net Neural Network

Das U-Net ist eine spezialisierte Architektur eines neuronalen Netzes, die innerhalb von Stable Diffusion für Bildverarbeitungsaufgaben verwendet wird. Es besteht aus einem Encoder- und einem Decoderpfad mit Skip-Connections zwischen gespiegelten Ebenen. Im Kontext von Stable Diffusion fungiert das U-Net als Rauschprädiktor während des umgekehrten Diffusionsprozesses.

In jedem Zeitschritt des Diffusionsprozesses sagt das U-Net die Menge an Rauschen in der latenten Repräsentation voraus. Diese Vorhersage wird genutzt, um den Latentvektor zu verfeinern, indem das geschätzte Rauschen abgezogen wird – so wird der latente Raum schrittweise bis hin zu einem Bild, das dem Textprompt entspricht, entrauscht.

3. Text-Conditionierung mit CLIP

Um Textinformationen einzubinden, verwendet Stable Diffusion einen Text-Encoder, der auf dem Modell CLIP (Contrastive Language-Image Pretraining) basiert. CLIP wurde entwickelt, um Text- und Bildinformationen zu verstehen und in einen gemeinsamen latenten Raum zu überführen.

Wenn ein Nutzer einen Textprompt eingibt, wandelt der Textencoder diesen in Embeddings – numerische Repräsentationen der Textdaten – um. Diese Embeddings konditionieren das U-Net während des umgekehrten Diffusionsprozesses und steuern die Bilderzeugung so, dass sie den Inhalt des Textprompts widerspiegelt.

Stable Diffusion in der Praxis

Stable Diffusion ist vielseitig bei der Bilderzeugung einsetzbar und kann auf unterschiedliche Weise genutzt werden.

Text-zu-Bild-Generierung

Der Hauptanwendungsfall von Stable Diffusion ist die Generierung von Bildern aus Text-Prompts. Die Nutzer geben eine Beschreibung ein und das Modell erzeugt das passende Bild. Beispielsweise könnte ein Nutzer “Ein ruhiger Strand bei Sonnenuntergang mit Palmen” eingeben und erhält ein entsprechendes Bild.

Diese Fähigkeit ist besonders in kreativen Branchen, bei der Inhaltserstellung und im Design wertvoll, wo eine schnelle Visualisierung von Ideen gefragt ist.

Bild-zu-Bild-Generierung

Stable Diffusion kann nicht nur Bilder von Grund auf neu erstellen, sondern auch bestehende Bilder anhand von Textanweisungen verändern. Gibt man ein Ausgangsbild und einen Textprompt vor, erzeugt das Modell ein neues Bild, das die beschriebenen Änderungen enthält.

So könnte ein Nutzer ein Tagesbild einer Stadt eingeben mit dem Prompt “Wechsle zu Nacht mit Neonlichtern” und erhält ein entsprechend angepasstes Bild.

Inpainting und Bildbearbeitung

Inpainting beschreibt das Ausfüllen fehlender oder beschädigter Bildbereiche. Stable Diffusion ist hierin besonders stark, da es mithilfe von Textprompts den Wiederaufbau bestimmter Bildbereiche steuern kann. Nutzer können Bereiche eines Bildes maskieren und beschreiben, was dort erscheinen soll.

Das ist nützlich für die Fotorestaurierung, das Entfernen unerwünschter Objekte oder das gezielte Ändern von Bildelementen bei gleichbleibender Gesamtästhetik.

Videoerstellung und Animation

Durch das Erzeugen von Bildsequenzen mit leichten Variationen kann Stable Diffusion auch für Animationen oder Video-Inhalte genutzt werden. Tools wie Deforum erweitern die Möglichkeiten von Stable Diffusion, um dynamische visuelle Inhalte zu erstellen, die von Textprompts über die Zeit gesteuert werden.

Das eröffnet Potenziale für Animation, visuelle Effekte und dynamische Inhaltserstellung ohne traditionelle Frame-für-Frame-Animationstechniken.

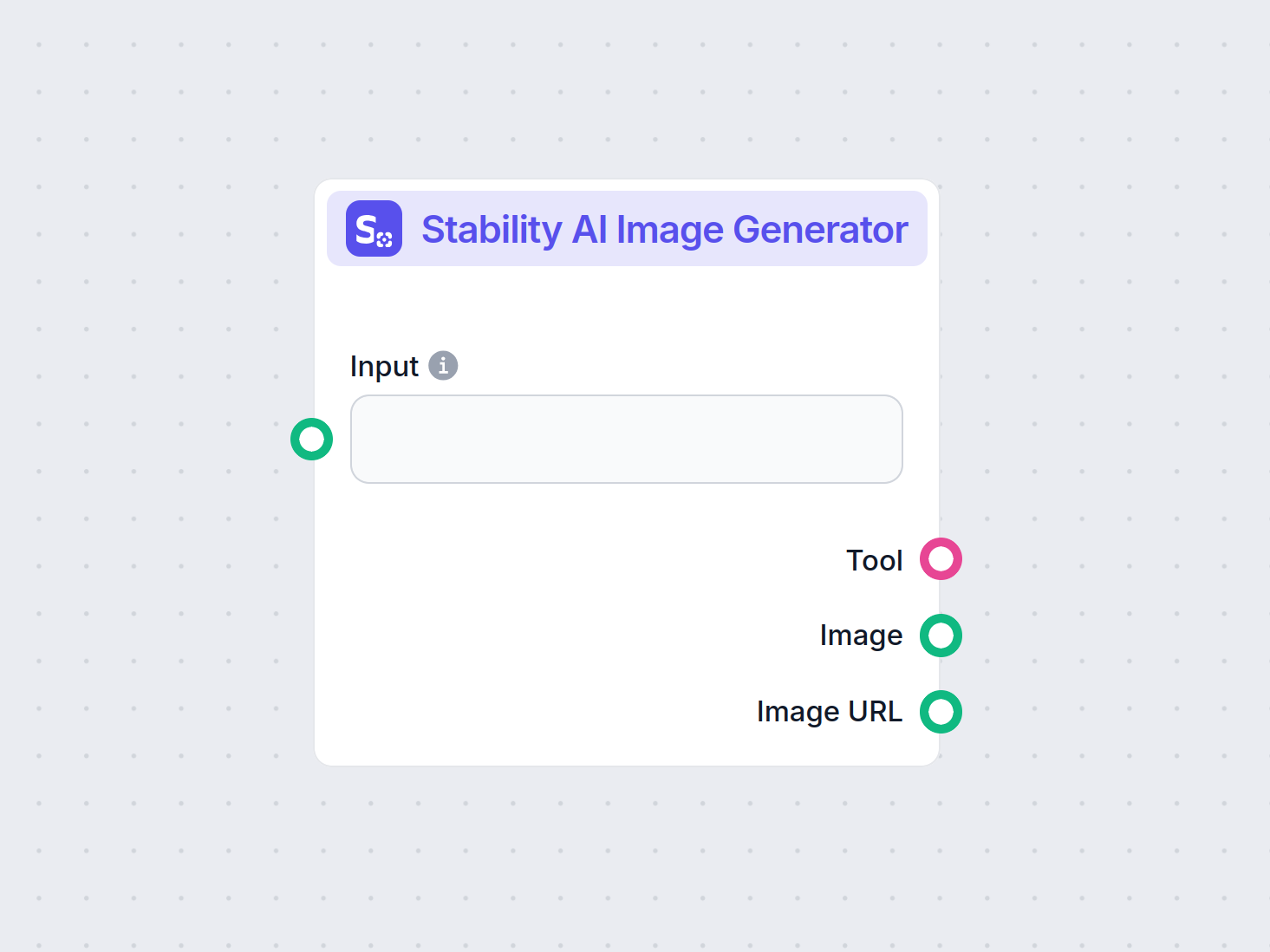

Anwendungen in KI-Automatisierung und Chatbots

Die Fähigkeit von Stable Diffusion, Bilder aus Textbeschreibungen zu generieren, macht es zu einem leistungsstarken Werkzeug für KI-Automatisierung und Chatbot-Entwicklung.

Verbesserte Nutzerinteraktion

Die Integration von Stable Diffusion in Chatbots ermöglicht die Generierung visueller Inhalte als Antwort auf Nutzeranfragen. Beispielsweise könnte ein Chatbot im Kundenservice visuelle Anleitungen oder Illustrationen “on the fly” generieren.

Textprompts und CLIP-Embeddings

Textprompts werden mit dem CLIP-Textencoder in Embeddings umgewandelt. Diese sind entscheidend für die Steuerung der Bildgenerierung und stellen sicher, dass das Ergebnis mit der Textbeschreibung des Nutzers übereinstimmt.

Umgekehrter Diffusionsprozess

Der umgekehrte Diffusionsprozess verfeinert die latente Repräsentation schrittweise durch Entfernen des vorhergesagten Rauschens. In jedem Zeitschritt berücksichtigt das Modell die Text-Embeddings und den aktuellen Zustand des Latentvektors, um die Rauschkomponente präzise vorherzusagen.

Umgang mit verrauschten Bildern

Das Modell beherrscht den Umgang mit verrauschten Bildern durch Training auf großen Datensätzen, wodurch es lernt, Bilder effektiv zu unterscheiden und zu entrauschen. Dadurch kann es auch aus Zufallsrauschen klare Bilder generieren.

Arbeiten im latenten Raum vs. Pixelraum

Das Arbeiten im latenten Raum ist recheneffizient, da dieser weniger Dimensionen als der Pixelraum aufweist. Dadurch sind die Operationen weniger ressourcenintensiv und Stable Diffusion kann hochauflösende Bilder ohne hohen Rechenaufwand erzeugen.

Vorteile von Stable Diffusion

- Zugänglichkeit: Läuft auf handelsüblicher Hardware mit GPU und ist damit für viele Nutzer erreichbar.

- Flexibilität: Beherrscht mehrere Aufgaben, darunter Text-zu-Bild- und Bild-zu-Bild-Generierung.

- Open Source: Unter einer permissiven Lizenz veröffentlicht, was Community-Entwicklung und Anpassung fördert.

- Hohe Qualität: Erzeugt detaillierte und fotorealistische Bilder, geeignet für professionelle Anwendungen.

Anwendungsfälle und Beispiele

Kreative Inhaltserstellung

Künstler und Designer können mit Stable Diffusion Visualisierungen anhand von Konzeptbeschreibungen schnell prototypen und so den kreativen Prozess beschleunigen.

Marketing und Werbung

Marketingteams können individuelle Bilder für Kampagnen, Social Media und Werbung erstellen, ohne umfangreiche Grafikressourcen zu benötigen.

Spieleentwicklung

Spieleentwickler können Assets, Umgebungen und Konzeptgrafiken durch Beschreibungen generieren und so die Asset-Pipeline optimieren.

E-Commerce

Händler können Produktbilder in verschiedenen Settings oder Konfigurationen erzeugen und so die Produktvisualisierung und das Kundenerlebnis verbessern.

Bildung

Lehrkräfte und Content Creators können Illustrationen und Diagramme zur Verdeutlichung komplexer Sachverhalte erzeugen und so Lernmaterialien ansprechender gestalten.

Forschung und Entwicklung

Forschende im Bereich künstliche Intelligenz und Computer Vision können mit Stable Diffusion die Möglichkeiten von Diffusionsmodellen und latenten Räumen weiter erforschen.

Technische Anforderungen

Für die effektive Nutzung von Stable Diffusion sind einige technische Voraussetzungen zu beachten.

- Hardware: Ein Computer mit GPU (Grafikprozessor) wird für effiziente Berechnungen empfohlen.

- Software: Kompatibilität mit Machine-Learning-Frameworks wie PyTorch oder TensorFlow sowie Zugriff auf die notwendigen Bibliotheken und Abhängigkeiten.

Erste Schritte mit Stable Diffusion

So starten Sie mit Stable Diffusion:

- Umgebung einrichten: Installieren Sie die erforderliche Software, darunter Python und die relevanten Machine-Learning-Bibliotheken.

- Modell beschaffen: Laden Sie das Stable Diffusion Modell aus einer vertrauenswürdigen Quelle herunter. Aufgrund der Open-Source-Lizenz ist es häufig über Repositories wie GitHub verfügbar.

- Text-Prompts vorbereiten: Definieren Sie die Prompts, die Ihre Wunschbilder beschreiben.

- Modell ausführen: Starten Sie das Modell mit den Text-Prompts und passen Sie die Parameter gegebenenfalls an, um die Ausgabe zu optimieren.

- Ausgaben interpretieren und verwenden: Analysieren Sie die generierten Bilder und integrieren Sie sie in Ihre Projekte oder Workflows.

Integration in KI-Automatisierung

Für Entwickler von KI-Automatisierung und Chatbots kann Stable Diffusion zur Funktionssteigerung integriert werden.

- API-Zugang: Nutzen Sie APIs, um programmgesteuert mit dem Stable Diffusion Modell zu interagieren.

- Echtzeit-Generierung: Implementieren Sie die Bilderzeugung als Antwort auf Nutzereingaben in Ihre Anwendungen.

- Anpassung: Passen Sie das Modell mit domänenspezifischen Daten an, um die Ausgaben auf bestimmte Anwendungsfälle zuzuschneiden.

Ethische Überlegungen

Beim Einsatz von Stable Diffusion sollten ethische Aspekte beachtet werden.

- Angemessenheit der Inhalte: Stellen Sie sicher, dass die generierten Inhalte den Standards entsprechen und keine schädlichen oder anstößigen Bilder erzeugt werden.

- Urheberrecht: Achten Sie auf mögliche Copyright-Probleme, insbesondere bei der Generierung von Bildern, die bestehenden Werken oder Marken ähneln könnten.

- Bias und Fairness: Erkennen und adressieren Sie eventuelle Verzerrungen in den Trainingsdaten, die die Modellausgaben beeinflussen könnten.

Forschung zu Stable Diffusion

Stable Diffusion ist ein zentrales Thema bei generativen Modellen, insbesondere für Data Augmentation und Bildsynthese. Aktuelle Studien beleuchten verschiedene Aspekte und zeigen die vielfältigen Anwendungsmöglichkeiten.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments von Fuxi Wen (2013):

Stellt einen Diffusions-LMP-Algorithmus für verteilte Schätzungen in Alpha-Stable-Rauschumgebungen vor. Die Studie vergleicht Diffusions-LMP mit Diffusions-LMS und zeigt verbesserte Leistung unter Alpha-Stable-Bedingungen. Wichtig für robuste Schätztechniken in verrauschten Umgebungen. Mehr erfahrenStable Diffusion for Data Augmentation in COCO and Weed Datasets von Boyang Deng (2024):

Untersucht den Einsatz von Stable-Diffusion-Modellen zur Erzeugung hochauflösender synthetischer Bilder für kleine Datensätze. Mithilfe von Techniken wie Image-to-Image-Translation, Dreambooth und ControlNet wird die Effizienz in Klassifizierungs- und Detektionsaufgaben bewertet. Die Ergebnisse zeigen vielversprechende Anwendungen. Mehr erfahrenDiffusion and Relaxation Controlled by Tempered α-stable Processes von Aleksander Stanislavsky, Karina Weron und Aleksander Weron (2011):

Leitet Eigenschaften von anomaler Diffusion und nicht-exponentieller Relaxation mit temperierten α-stabilen Prozessen her. Das Modell schließt Subdiffusion als Spezialfall ein und adressiert das Problem der unendlichen Momente bei α-stabilen Prozessen. Mehr erfahrenEvaluating a Synthetic Image Dataset Generated with Stable Diffusion von Andreas Stöckl (2022):

Bewertet synthetische Bilder aus Stable Diffusion anhand der Wordnet-Taxonomie. Die Studie analysiert, wie korrekt das Modell verschiedene Konzepte abbildet, und macht Unterschiede in der Repräsentationsgenauigkeit deutlich. Diese Bewertungen sind für die Rolle von Stable Diffusion bei Data Augmentation wichtig. Mehr erfahrenComparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion von Sanchayan Vivekananthan (2024):

Untersucht drei generative Frameworks: VAEs, GANs und Stable Diffusion. Die Studie beleuchtet Stärken und Schwächen der einzelnen Modelle, wobei Stable Diffusion bei bestimmten Syntheseaufgaben besonders überzeugt. Mehr erfahren

Stable Diffusion in Python implementieren

Sehen wir uns an, wie ein Stable-Diffusion-Modell in Python mit der Hugging-Face-Diffusers-Bibliothek umgesetzt wird.

Voraussetzungen

- Python 3.7 oder höher

- PyTorch

- Transformers

- Diffusers

- Accelerate

- Xformers (optional für Performanceverbesserung)

Installieren Sie die notwendigen Bibliotheken:

pip install torch transformers diffusers accelerate

pip install xformers # Optional

Stable Diffusion Pipeline laden

Die Diffusers-Bibliothek bietet einen einfachen Weg, vortrainierte Modelle zu laden:

from diffusers import StableDiffusionPipeline

import torch

# Stable Diffusion Modell laden

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Modell auf die GPU verschieben für schnellere Inferenz

Bilder aus Text generieren

Um Bilder zu erzeugen, geben Sie einfach einen Textprompt an:

prompt = "Eine ruhige Landschaft mit Bergen und einem See, fotorealistisch, 8K-Auflösung"

image = pipe(prompt).images[0]

# Bild speichern oder anzeigen

image.save("generated_image.png")

Code-Erklärung

- StableDiffusionPipeline: Diese Pipeline enthält alle Komponenten des Stable-Diffusion-Modells: VAE, U-Net, Text-Encoder und Scheduler.

- from_pretrained: Lädt ein vortrainiertes Modell, das durch

model_idangegeben wird. - torch_dtype: Gibt den Datentyp der Modellparameter an;

torch.float16reduziert den Speicherbedarf. - to(“cuda”): Verschiebt das Modell auf die GPU.

- pipe(prompt): Generiert ein Bild basierend auf dem Prompt.

Anpassung des Generierungsprozesses

Sie können verschiedene Parameter anpassen:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Anzahl der Denoising-Schritte

guidance

Häufig gestellte Fragen

- Was ist Stable Diffusion?

Stable Diffusion ist ein fortschrittliches KI-Modell zur Erzeugung hochwertiger, fotorealistischer Bilder aus Text-Prompts. Es nutzt latente Diffusion und Deep Learning, um Textbeschreibungen in Visualisierungen umzuwandeln.

- Wie funktioniert Stable Diffusion?

Stable Diffusion wandelt Text-Prompts mithilfe eines CLIP-Text-Encoders in Bild-Embeddings um und entstört dann schrittweise eine latente Repräsentation, die vom Prompt geleitet wird, sodass ein kohärentes Bild entsteht.

- Was sind typische Anwendungsfälle für Stable Diffusion?

Stable Diffusion wird für kreative Inhaltserstellung, Marketingmaterialien, Spieleasset-Produktion, Produktvisualisierung im E-Commerce, Bildungsillustrationen und KI-gestützte Chatbots eingesetzt.

- Kann Stable Diffusion bestehende Bilder verändern?

Ja, Stable Diffusion unterstützt Bild-zu-Bild-Übersetzung und Inpainting, sodass Nutzer bestehende Bilder verändern oder fehlende Teile anhand von Text-Prompts ergänzen können.

- Welche Hardware-Anforderungen gibt es für Stable Diffusion?

Für eine effiziente Bildgenerierung mit Stable Diffusion wird ein Computer mit moderner GPU empfohlen. Das Modell benötigt außerdem Python und Bibliotheken wie PyTorch und Diffusers.

- Ist Stable Diffusion Open Source?

Ja, Stable Diffusion ist unter einer permissiven Open-Source-Lizenz veröffentlicht, was Community-Beiträge, Anpassungen und breite Zugänglichkeit fördert.

Erkunden Sie die KI-gestützte Bilderzeugung

Entfesseln Sie Ihre Kreativität mit Stable Diffusion und sehen Sie, wie KI Ihre Ideen in beeindruckende Visuals verwandeln kann.