Servidor MCP Langflow-DOC-QA-SERVER

Langflow-DOC-QA-SERVER lleva potentes capacidades de preguntas y respuestas sobre documentos a tu stack de IA, permitiendo integrar fácilmente búsqueda, automatización de soporte y extracción de conocimiento para mejorar la productividad.

¿Qué hace el Servidor MCP “Langflow-DOC-QA-SERVER”?

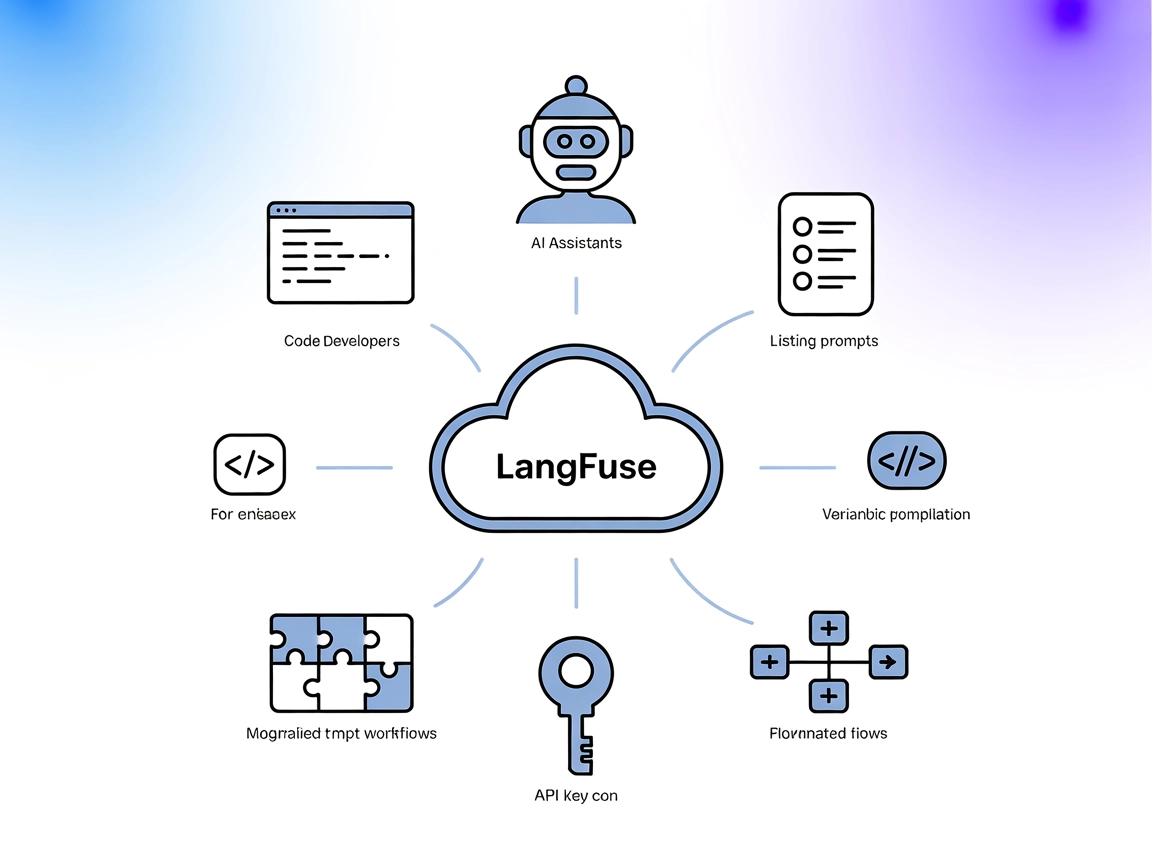

Langflow-DOC-QA-SERVER es un servidor Model Context Protocol (MCP) diseñado para tareas de preguntas y respuestas (Q&A) sobre documentos, potenciado por Langflow. Actúa como un puente entre asistentes de IA y un backend Langflow, permitiendo a los usuarios consultar documentos de forma sencilla. Aprovechando MCP, este servidor expone las capacidades de Q&A sobre documentos como herramientas y recursos accesibles por clientes de IA, permitiendo así flujos de desarrollo avanzados. Los desarrolladores pueden integrar recuperación de documentos, respuesta a preguntas e interacción con modelos de lenguaje de gran tamaño (LLMs) en sus aplicaciones, facilitando la mejora de la productividad en tareas como búsqueda de documentación, automatización de soporte y extracción de información.

Lista de Prompts

No hay plantillas de prompt documentadas en el repositorio o README.

Lista de Recursos

No se documentan ni listan recursos específicos en el repositorio o README.

Lista de Herramientas

No se listan herramientas explícitas en un server.py o archivo de servidor equivalente según la documentación disponible.

Casos de Uso de este Servidor MCP

- Búsqueda de documentos y Q&A

Integra búsqueda en lenguaje natural sobre documentos para respuestas instantáneas, mejorando el acceso al conocimiento organizacional. - Bots de soporte automatizado

Utiliza el servidor como backend para bots que responden preguntas de usuarios sobre documentación subida o indexada. - Gestión del conocimiento

Permite a equipos extraer información de grandes colecciones de documentos, incrementando la productividad. - Automatización de flujos de trabajo

Automatiza tareas repetitivas de investigación o recuperación de información integrando capacidades de Q&A de documentos en los flujos de trabajo.

Cómo configurarlo

Windsurf

- Asegúrate de que los prerrequisitos estén instalados (por ejemplo, Node.js, backend de Langflow).

- Abre tu archivo de configuración de Windsurf.

- Añade el servidor MCP Langflow-DOC-QA-SERVER usando el siguiente fragmento JSON:

{ "mcpServers": { "langflow-doc-qa": { "command": "npx", "args": ["@GongRzhe/Langflow-DOC-QA-SERVER@latest"] } } } - Guarda la configuración y reinicia Windsurf.

- Verifica que el servidor esté funcionando y accesible.

Protección de claves API

Utiliza variables de entorno para proteger las claves API:

{

"mcpServers": {

"langflow-doc-qa": {

"command": "npx",

"args": ["@GongRzhe/Langflow-DOC-QA-SERVER@latest"],

"env": {

"API_KEY": "${API_KEY}"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

Claude

- Instala las dependencias requeridas.

- Localiza el archivo de configuración de Claude.

- Añade la configuración del servidor MCP como se muestra arriba.

- Reinicia Claude.

- Confirma la conectividad con Langflow-DOC-QA-SERVER.

Cursor

- Prepara el backend de Langflow e instala Node.js si es necesario.

- Edita la configuración de Cursor.

- Inserta el JSON de configuración del servidor MCP.

- Guarda los cambios y reinicia Cursor.

- Prueba la integración del servidor.

Cline

- Asegúrate de que todos los prerrequisitos estén completos.

- Actualiza el archivo de configuración de Cline.

- Añade la configuración JSON del servidor MCP.

- Reinicia Cline para que los cambios tengan efecto.

- Valida la integración.

Cómo usar este MCP dentro de los flujos

Uso de MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo de FlowHunt, comienza añadiendo el componente MCP a tu flujo y conectándolo a tu agente de IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración del sistema MCP, inserta los detalles de tu servidor MCP usando este formato JSON:

{

"langflow-doc-qa": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá usar este MCP como herramienta con acceso a todas sus funciones y capacidades. Recuerda cambiar “langflow-doc-qa” por el nombre real de tu servidor MCP y reemplazar la URL por la de tu propio servidor MCP.

Resumen

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | Presente en README |

| Lista de Prompts | ⛔ | No documentado |

| Lista de Recursos | ⛔ | No documentado |

| Lista de Herramientas | ⛔ | No documentado |

| Protección de claves API | ✅ | Mostrada en ejemplo |

| Soporte de sampling (menos relevante) | ⛔ | No documentado |

Nuestra opinión

El MCP Langflow-DOC-QA-SERVER es un servidor minimalista y orientado a demostración que explica claramente su propósito y configuración, pero carece de documentación sobre plantillas de prompt, recursos y herramientas. Sus instrucciones de instalación son genéricas y basadas en convenciones estándar de MCP. Esto limita su utilidad de forma inmediata, pero lo convierte en un ejemplo claro para la integración básica.

Puntuación MCP

| ¿Tiene LICENCIA? | ✅ (MIT) |

|---|---|

| ¿Tiene al menos una herramienta? | ⛔ |

| Número de forks | 7 |

| Número de estrellas | 11 |

Calificación: 4/10 — El proyecto tiene un alcance claro y es open source, pero carece de documentación detallada y recursos específicos sobre sus características MCP, recursos y herramientas.

Preguntas frecuentes

- ¿Qué es Langflow-DOC-QA-SERVER?

Langflow-DOC-QA-SERVER es un servidor Model Context Protocol (MCP) diseñado para tareas de preguntas y respuestas sobre documentos, actuando como un puente entre asistentes de IA y un backend Langflow para consultas avanzadas de documentos.

- ¿Cuáles son los principales casos de uso para este servidor MCP?

Permite búsqueda de documentos y Q&A, potencia bots de soporte automatizado, apoya la gestión del conocimiento para equipos y permite la automatización de flujos de trabajo integrando Q&A de documentos en procesos empresariales.

- ¿Cómo configuro Langflow-DOC-QA-SERVER con FlowHunt?

Agrega la configuración del servidor MCP a tu flujo de trabajo como se muestra en las instrucciones de instalación, asegurando que las dependencias requeridas (como Node.js y un backend Langflow) estén presentes. Protege las claves API usando variables de entorno.

- ¿Incluye Langflow-DOC-QA-SERVER plantillas de prompts, recursos o herramientas?

No. El servidor está enfocado en demostración y actualmente no documenta plantillas de prompts, recursos ni herramientas específicas.

- ¿Langflow-DOC-QA-SERVER es open source?

Sí, es open source bajo la licencia MIT.

Comienza con Langflow-DOC-QA-SERVER

Integra Langflow-DOC-QA-SERVER en tus flujos de trabajo de FlowHunt para Q&A avanzado de documentos y gestión del conocimiento. Desbloquea acceso instantáneo al conocimiento organizacional y automatiza el soporte.