Serveur MCP Databricks Genie

Reliez votre assistant IA à Databricks avec le serveur MCP Genie pour débloquer l’interrogation en langage naturel, l’accès aux métadonnées de l’espace de travail et la gestion de conversations multi-tours, afin d’optimiser vos flux de travail axés sur les données.

Que fait le serveur MCP « Databricks Genie » ?

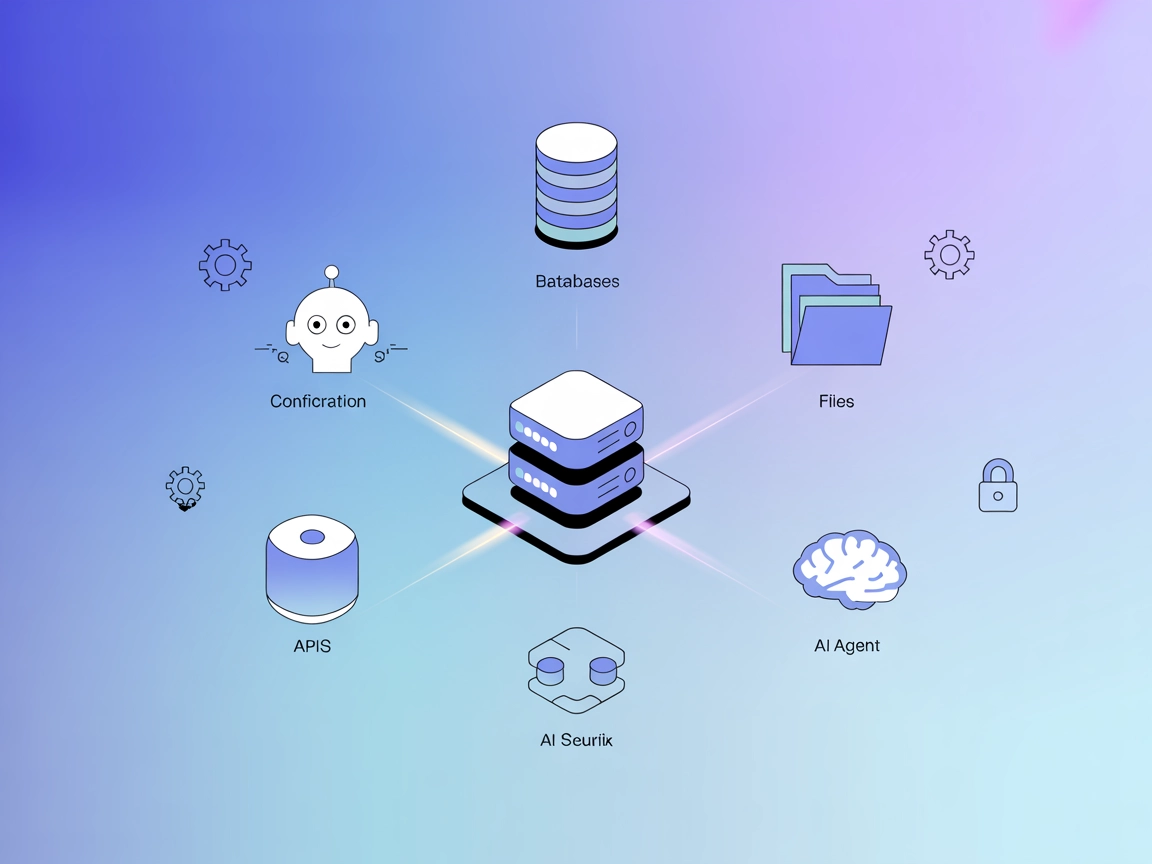

Le serveur MCP Databricks Genie est un serveur Model Context Protocol (MCP) conçu pour faire le lien entre les assistants IA et l’API Databricks Genie. Cette intégration permet aux grands modèles de langage (LLM) d’interagir avec des environnements Databricks en utilisant le langage naturel. Grâce à ce serveur, les LLM peuvent effectuer des actions telles que lister les espaces Genie, récupérer les métadonnées de l’espace de travail, initier et gérer des conversations Genie, et exécuter des requêtes SQL — le tout via des outils MCP standardisés. En agissant comme connecteur, le serveur MCP Databricks Genie permet aux développeurs d’améliorer leurs flux de travail avec l’exploration de données conversationnelle, l’interrogation SQL directe et une interaction fluide avec les agents conversationnels Databricks, simplifiant ainsi le développement et l’analyse axés sur les données.

Liste des prompts

Aucun modèle de prompt explicite n’est documenté dans le dépôt.

Liste des ressources

Aucune ressource explicite n’est décrite dans le dépôt.

Liste des outils

- get_genie_space_id()

Liste les IDs et titres des espaces Genie disponibles dans votre espace de travail Databricks. - get_space_info(space_id: str)

Récupère le titre et la description de métadonnées d’un espace Genie spécifié. - ask_genie(space_id: str, question: str)

Démarre une nouvelle conversation Genie en posant une question en langage naturel et renvoie la requête SQL ainsi que les tables de résultats. - follow_up(space_id: str, conversation_id: str, question: str)

Poursuit une conversation Genie existante avec une question de suivi.

Cas d’usage de ce serveur MCP

- Exploration de données conversationnelle

Les développeurs et analystes peuvent utiliser le langage naturel pour interroger de façon interactive les données Databricks via Genie, rendant l’analyse plus accessible et intuitive. - Génération automatisée de requêtes SQL

Le serveur convertit les questions en langage naturel en requêtes SQL, les exécute sur les espaces Genie et retourne des résultats structurés, ce qui fait gagner du temps et réduit les erreurs. - Récupération des métadonnées de l’espace de travail

Récupérez facilement les métadonnées (titres, descriptions) des espaces Genie pour comprendre et documenter les ressources de données disponibles. - Gestion de la conversation

Maintenez le contexte lors de conversations multi-tours, permettant des workflows analytiques complexes où les questions se construisent sur les réponses précédentes. - Intégration avec les assistants IA

Ajoutez facilement les capacités Genie de Databricks à des IDE ou interfaces de chat alimentés par l’IA, simplifiant les workflows de data science dans vos outils habituels.

Comment le configurer

Windsurf

- Assurez-vous que Python 3.7+ est installé sur votre système.

- Clonez le dépôt Databricks Genie MCP et installez les dépendances.

- Créez un fichier

.envavec vos identifiants Databricks (DATABRICKS_HOSTetDATABRICKS_TOKEN). - Dans la configuration Windsurf, ajoutez le serveur MCP à l’aide de l’extrait JSON suivant :

{ "mcpServers": { "databricks-genie": { "command": "python", "args": ["main.py"] } } } - Redémarrez Windsurf et vérifiez que le serveur apparaît dans vos serveurs MCP disponibles.

- Sécurisation des clés API :

Utilisez les variables d’environnement pour sécuriser vos identifiants. Exemple :{ "env": { "DATABRICKS_HOST": "your-databricks-instance.cloud.databricks.com", "DATABRICKS_TOKEN": "your-personal-access-token" }, "inputs": {} }

Claude

- Installez Python 3.7+ et les dépendances depuis le dépôt.

- Configurez le fichier

.envavec votre hôte et token Databricks. - Depuis le répertoire du projet, exécutez :

mcp install main.py - Ouvrez Claude Desktop, allez dans Ressources → Ajouter une ressource, et sélectionnez votre serveur MCP Genie.

- Commencez à discuter avec vos données Databricks.

Cursor

- Vérifiez que toutes les dépendances sont en place et que

.envest configuré. - Ajoutez ce qui suit à votre configuration Cursor :

{ "mcpServers": { "databricks-genie": { "command": "python", "args": ["main.py"] } } } - Sauvegardez la configuration et redémarrez Cursor.

- Vérifiez la connexion au serveur et assurez-vous que les variables d’environnement sont définies comme ci-dessus.

Cline

- Installez Python 3.7+, clonez le dépôt et configurez votre

.env. - Ajoutez le serveur MCP dans la configuration Cline :

{ "mcpServers": { "databricks-genie": { "command": "python", "args": ["main.py"] } } } - Redémarrez Cline et vérifiez que le serveur MCP est actif.

- Utilisez les variables d’environnement pour protéger vos identifiants.

Comment utiliser ce MCP dans les flows

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP à votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et reliez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section configuration du MCP système, insérez les détails de votre serveur MCP au format JSON suivant :

{

"databricks-genie": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA pourra utiliser ce MCP comme outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “databricks-genie” par le vrai nom de votre serveur MCP et l’URL par celle de votre propre serveur MCP.

Vue d’ensemble

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Présentation | ✅ | |

| Liste des prompts | ⛔ | Aucun modèle de prompt décrit dans le dépôt |

| Liste des ressources | ⛔ | Aucune ressource MCP explicite documentée |

| Liste des outils | ✅ | 4 outils : voir section ci-dessus |

| Sécurisation des clés API | ✅ | Décrit via .env et exemple JSON |

| Support Sampling (moins important à l’éval.) | ⛔ | Non mentionné |

Notre avis

Le serveur MCP Databricks Genie offre un pont pratique entre Databricks et les LLM, avec des instructions de configuration claires et des outils efficaces. Cependant, il manque de modèles de prompt, de ressources explicites et de documentation sur des fonctionnalités MCP avancées comme le sampling ou les roots. Les outils principaux sont bien définis et utiles pour les utilisateurs Databricks. Globalement, il obtient un score supérieur à la moyenne mais bénéficierait d’une utilisation plus riche des fonctionnalités MCP.

Score MCP

| Dispose d’une LICENCE | Oui (MIT) |

|---|---|

| Au moins un outil | Oui |

| Nombre de Forks | 1 |

| Nombre d’étoiles | 3 |

Questions fréquemment posées

- Qu'est-ce que le serveur MCP Databricks Genie ?

C'est un serveur Model Context Protocol qui relie les grands modèles de langage à Databricks Genie, permettant l'interaction en langage naturel, la génération de requêtes SQL et la récupération des métadonnées de l'espace de travail directement depuis des assistants IA.

- Quelles tâches peut-on effectuer via le serveur MCP Genie ?

Vous pouvez lister les espaces Genie, récupérer les métadonnées d'un espace, initier et gérer des conversations Genie en langage naturel, et lancer ou poursuivre des requêtes SQL.

- Comment le serveur MCP Genie améliore-t-il les flux de données ?

Il facilite l'exploration de données en autorisant des requêtes conversationnelles multi-tours et la génération automatisée de SQL, rendant l'analyse plus accessible et réduisant la rédaction manuelle de SQL.

- Comment les identifiants sont-ils sécurisés ?

Les identifiants comme l'hôte Databricks et le token sont gérés via des variables d'environnement, jamais en dur, garantissant la sécurité des informations sensibles.

- Ce serveur fournit-il des modèles de prompt ou des ressources explicites ?

Non, le dépôt n'inclut pas de modèles de prompt explicites ni de ressources MCP additionnelles, mais les outils principaux pour la conversation et la requête SQL sont entièrement pris en charge.

Boostez Databricks avec Genie MCP

Débloquez l'analyse de données conversationnelle et l'interrogation SQL directe dans FlowHunt en connectant votre espace de travail Databricks au serveur MCP Genie.