Descrizione del componente

Come funziona il componente LLM DeepSeek

Cos’è il componente LLM DeepSeek?

Il componente LLM DeepSeek collega i modelli DeepSeek al tuo Flow. Mentre i Generatori e gli Agenti sono dove avviene la vera magia, i componenti LLM ti permettono di cambiare e controllare il modello utilizzato.

Ricorda che collegare un componente LLM è opzionale. Tutti i componenti che usano un LLM hanno ChatGPT-4o come predefinito. I componenti LLM ti permettono di cambiare modello e controllare le impostazioni del modello.

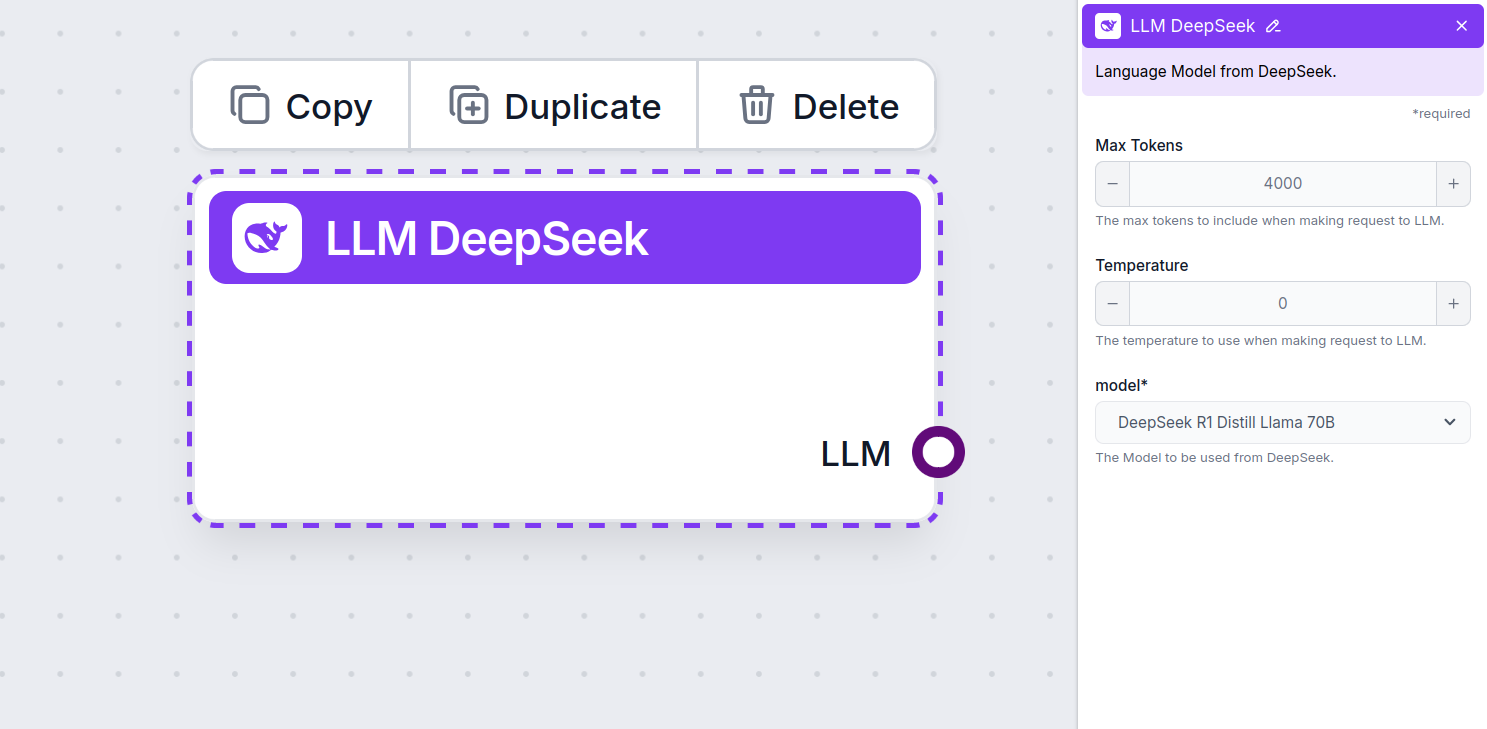

Impostazioni del componente LLM Gemini

Max Tokens

I token rappresentano le unità individuali di testo che il modello elabora e genera. L’uso dei token varia tra i modelli e un singolo token può essere una parola, una sottoparola o un singolo carattere. I modelli sono solitamente tariffati a milioni di token.

L’impostazione dei max tokens limita il numero totale di token che possono essere elaborati in una singola interazione o richiesta, garantendo che le risposte siano generate entro limiti ragionevoli. Il limite predefinito è di 4.000 token, la dimensione ottimale per riassumere documenti e più fonti per generare una risposta.

Temperature

La temperature controlla la variabilità delle risposte, variando da 0 a 1.

Una temperature di 0.1 renderà le risposte molto dirette ma potenzialmente ripetitive e poco ricche.

Una temperatura alta di 1 permette la massima creatività nelle risposte ma aumenta il rischio di risposte irrilevanti o addirittura allucinatorie.

Ad esempio, la temperature consigliata per un bot di assistenza clienti è tra 0.2 e 0.5. Questo livello dovrebbe mantenere le risposte rilevanti e coerenti, consentendo comunque una certa naturale variazione.

Model

Questo è il selettore del modello. Qui troverai tutti i modelli DeepSeek supportati. Supportiamo tutti gli ultimi modelli Gemini:

- DeepSeek R1: Il modello open source leggero cinese che ha conquistato il mondo all’inizio del 2025. Attualmente è il modello DeepSeek più veloce e migliore, che supera facilmente il modello o1 di OpenAI.

Come aggiungere l’LLM DeepSeek al tuo Flow

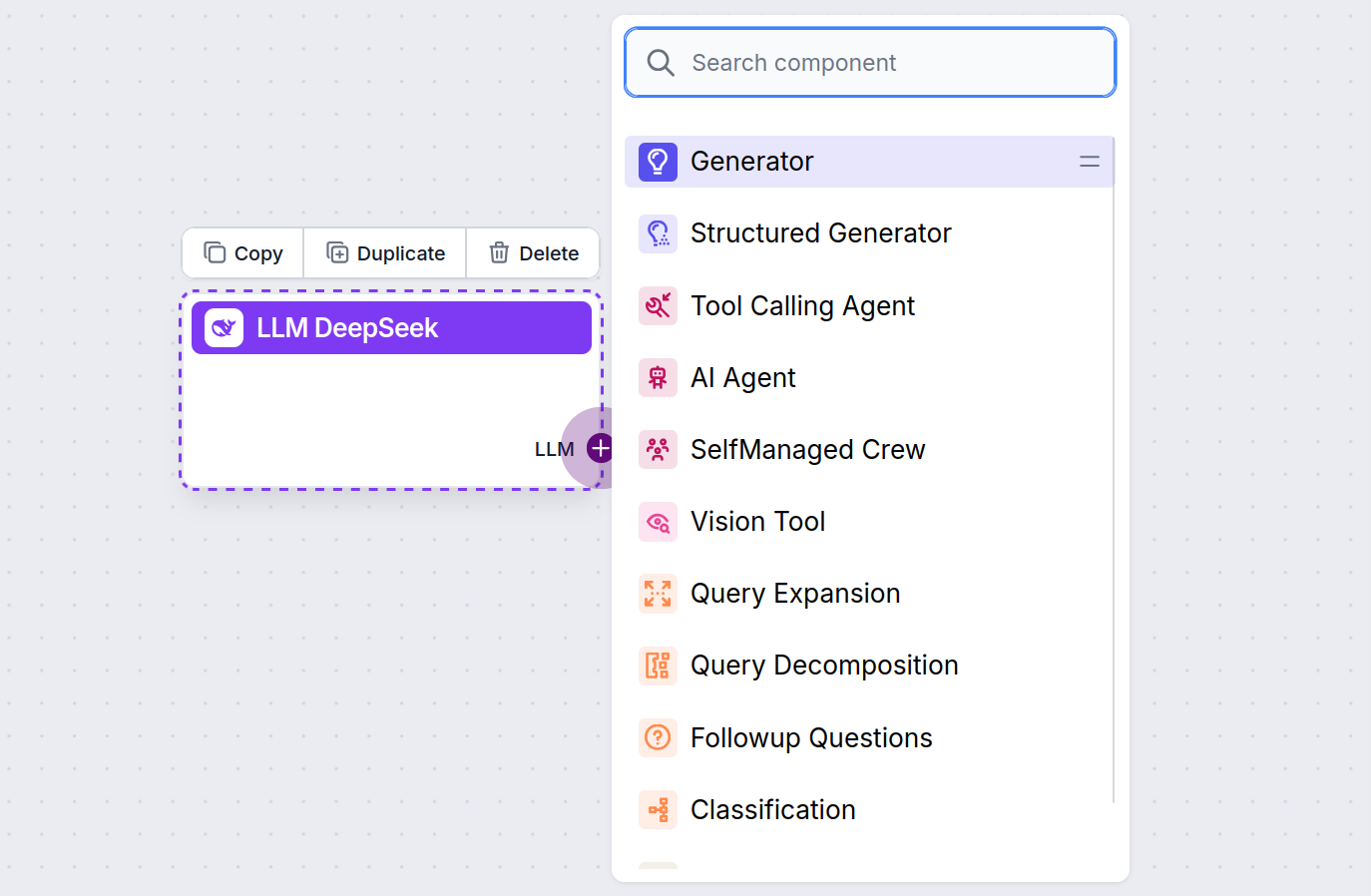

Noterai che tutti i componenti LLM hanno solo una maniglia di output. L’input non passa attraverso il componente, poiché questo rappresenta solo il modello, mentre la generazione vera e propria avviene negli AI Agent e Generator.

La maniglia LLM è sempre viola. La maniglia di input LLM si trova su ogni componente che utilizza l’AI per generare testo o elaborare dati. Puoi vedere le opzioni cliccando sulla maniglia:

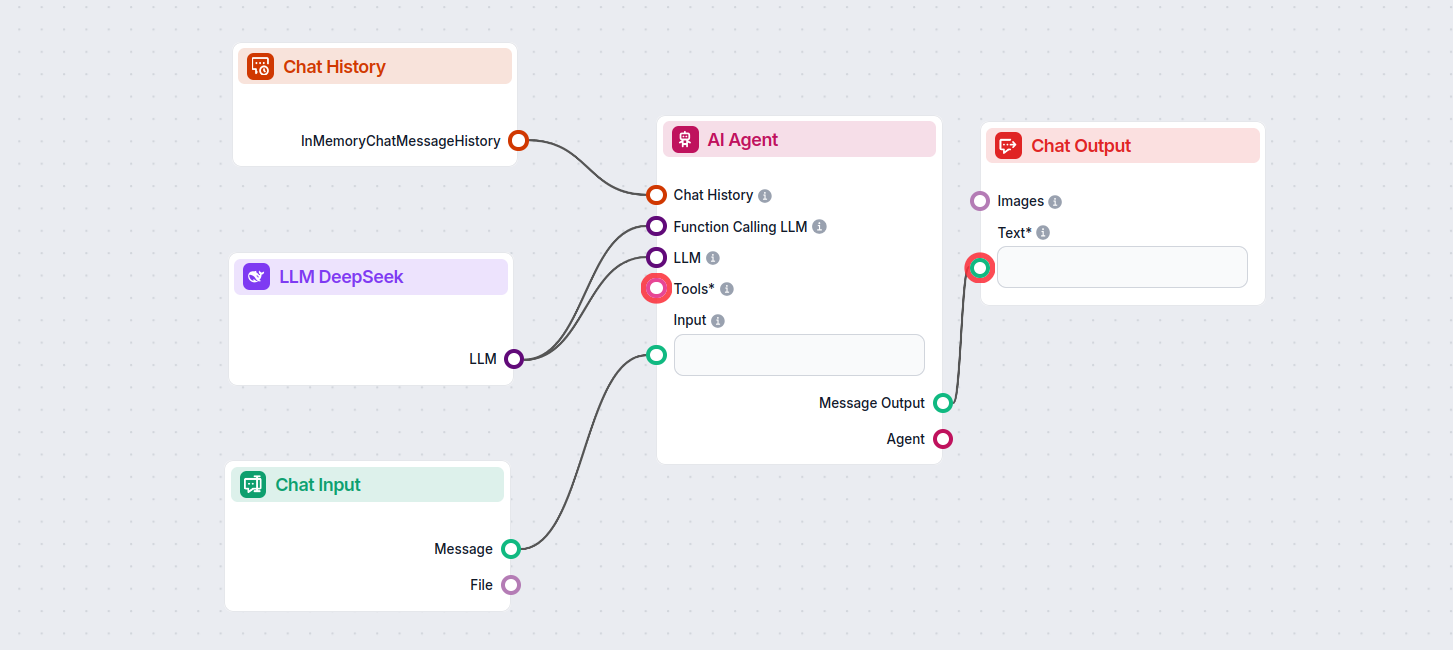

Questo ti permette di creare tutti i tipi di strumenti. Vediamo il componente in azione. Ecco un semplice Flow Chatbot AI che utilizza DeepSeek R1 per generare risposte. Puoi considerarlo come un chatbot DeepSeek di base.

Questo semplice Flow Chatbot include:

- Input chat: Rappresenta il messaggio che un utente invia in chat.

- Cronologia chat: Garantisce che il chatbot possa ricordare e tenere conto delle risposte precedenti.

- Output chat: Rappresenta la risposta finale del chatbot.

- AI Agent: Un agente AI autonomo che genera risposte.

- LLM DeepSeek: Il collegamento ai modelli di generazione DeepSeek.

Domande frequenti

- Cos'è LLM DeepSeek in FlowHunt?

LLM DeepSeek è un componente di FlowHunt che ti consente di connettere e controllare i modelli DeepSeek AI per la generazione di testo e immagini, consentendo chatbot potenti e flussi automatizzati.

- Quali modelli DeepSeek sono supportati?

FlowHunt supporta tutti gli ultimi modelli DeepSeek, incluso DeepSeek R1, noto per la sua velocità e prestazioni, specialmente rispetto ad altri modelli AI leader.

- Come posso personalizzare le impostazioni di LLM DeepSeek?

Puoi regolare il numero massimo di token per la lunghezza della risposta e la temperature per la creatività, oltre a cambiare modello DeepSeek direttamente dal pannello di FlowHunt.

- È necessario collegare un componente LLM DeepSeek?

No, collegare un componente LLM è opzionale. Per impostazione predefinita, FlowHunt usa ChatGPT-4o, ma aggiungendo LLM DeepSeek puoi scegliere e controllare quale modello AI alimenta i tuoi flussi.

Prova FlowHunt con DeepSeek

Inizia a costruire chatbot AI e strumenti di automazione più intelligenti utilizzando i modelli DeepSeek avanzati—il tutto senza configurazioni complesse o abbonamenti multipli.