Descrizione del componente

Come funziona il componente LLM OpenAI

Cos’è il componente LLM Open AI?

Il componente LLM OpenAI collega i modelli ChatGPT al tuo flusso. Mentre i Generator e gli Agent sono dove avviene la vera magia, i componenti LLM ti permettono di controllare il modello utilizzato. Tutti i componenti vengono forniti con ChatGPT-4 per impostazione predefinita. Puoi collegare questo componente se desideri cambiare modello o avere un maggiore controllo su di esso.

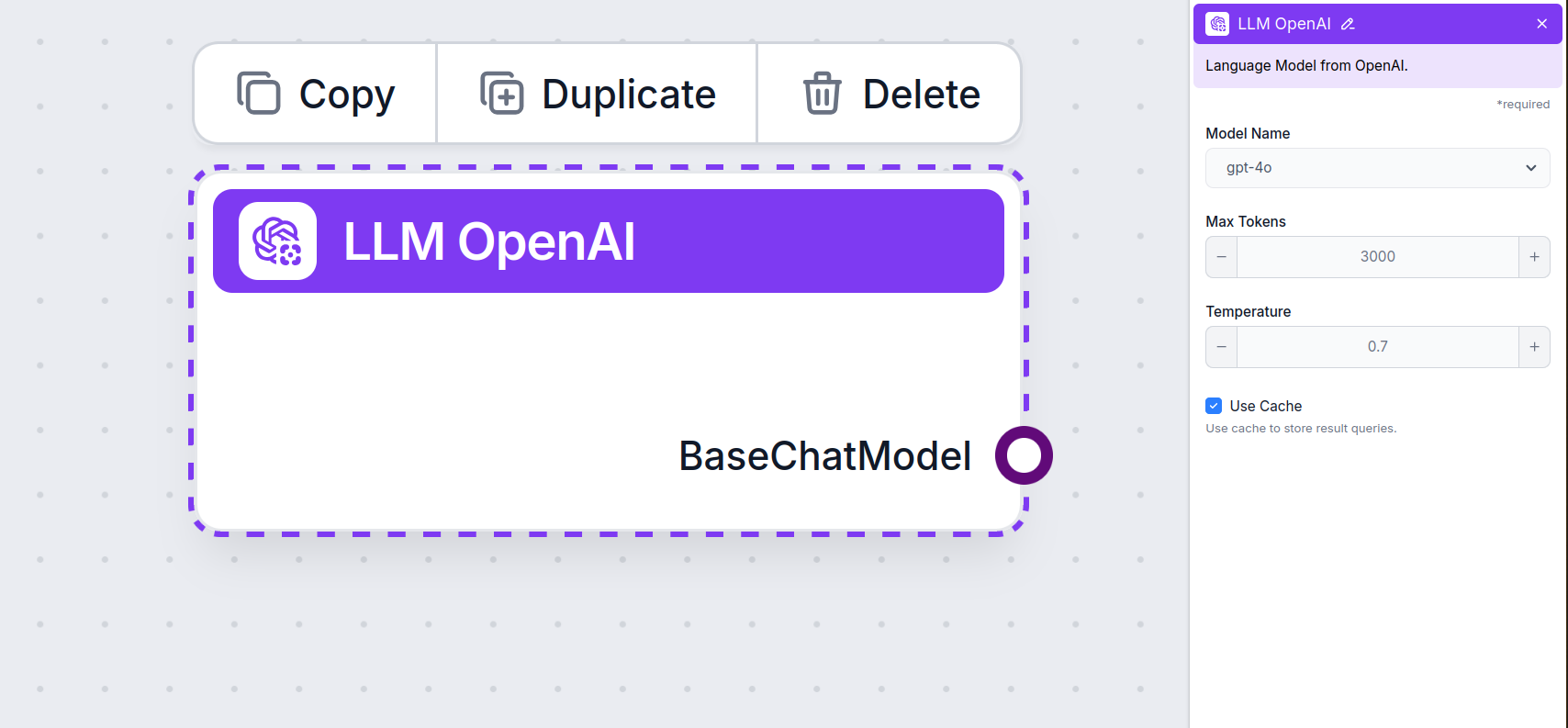

Impostazioni del componente LLM OpenAI

Nome Modello

Questo è il selettore del modello. Qui troverai tutti i modelli OpenAI supportati da FlowHunt. ChatGPT offre un elenco completo di modelli con capacità e prezzi diversi. Ad esempio, utilizzare il meno avanzato e più vecchio GPT-3.5 costerà meno rispetto al nuovissimo 4o, ma la qualità e la velocità dell’output ne risentiranno.

Modelli OpenAI disponibili in FlowHunt:

- GPT-4o – L’ultimo e più popolare modello di OpenAI. Un modello multimodale in grado di elaborare testo, immagini e audio e cercare sul web. Scopri di più qui.

- GPT-4o Mini – Una versione più piccola ed economica di GPT-4o, che offre prestazioni migliorate rispetto a GPT-3.5 Turbo, con una finestra di contesto da 128K e oltre il 60% di riduzione dei costi. Scopri come gestisce i compiti.

- o1 Mini – Una versione semplificata del modello o1, progettata per compiti di ragionamento complessi, offrendo un equilibrio tra prestazioni ed efficienza. Vedi come si è comportato nei nostri test.

- o1 Preview – Un modello avanzato con capacità di ragionamento migliorate, eccellente nella risoluzione di problemi complessi, in particolare nella programmazione e nel ragionamento scientifico, disponibile in anteprima. Scopri come ragiona e gestisce i compiti.

- gpt-4-vision-preview – Modello di anteprima che accetta sia input di testo che di immagini, supportando funzionalità come la modalità JSON e la chiamata parallela di funzioni, migliorando le capacità di interazione multimodale. Scopri di più qui.

- GPT-3.5 Turbo – Una versione legacy di GPT, ottima per compiti semplici senza spendere troppo. Consulta i nostri test sull’Agente IA per confrontarla con i modelli più recenti.

Quando scegli il modello giusto per il compito, considera la qualità e la velocità richieste. I modelli più vecchi sono ideali per risparmiare sui compiti di massa semplici e per la chat. Se devi generare contenuti o cercare sul web, ti consigliamo di optare per un modello più nuovo e raffinato.

Max Tokens

I token rappresentano le singole unità di testo che il modello elabora e genera. L’uso dei token varia in base ai modelli, e un singolo token può essere una parola, una sottoparola o anche un solo carattere. I modelli sono solitamente tariffati a milioni di token.

L’impostazione max tokens limita il numero totale di token che possono essere processati in una singola interazione o richiesta, garantendo che le risposte vengano generate entro limiti ragionevoli. Il limite predefinito è 4.000 token, che è la dimensione ottimale per riassumere documenti e più fonti per generare una risposta.

Temperature

La temperatura controlla la variabilità delle risposte, con un valore da 0 a 1.

Una temperatura di 0,1 renderà le risposte molto precise ma potenzialmente ripetitive e scarse.

Una temperatura alta di 1 consente la massima creatività nelle risposte ma crea il rischio di risposte irrilevanti o addirittura allucinatorie.

Ad esempio, la temperatura consigliata per un bot di assistenza clienti è tra 0,2 e 0,5. Questo livello dovrebbe mantenere le risposte pertinenti e aderenti allo script, consentendo comunque una naturale variazione nelle risposte.

Come aggiungere LLM OpenAI al tuo flusso

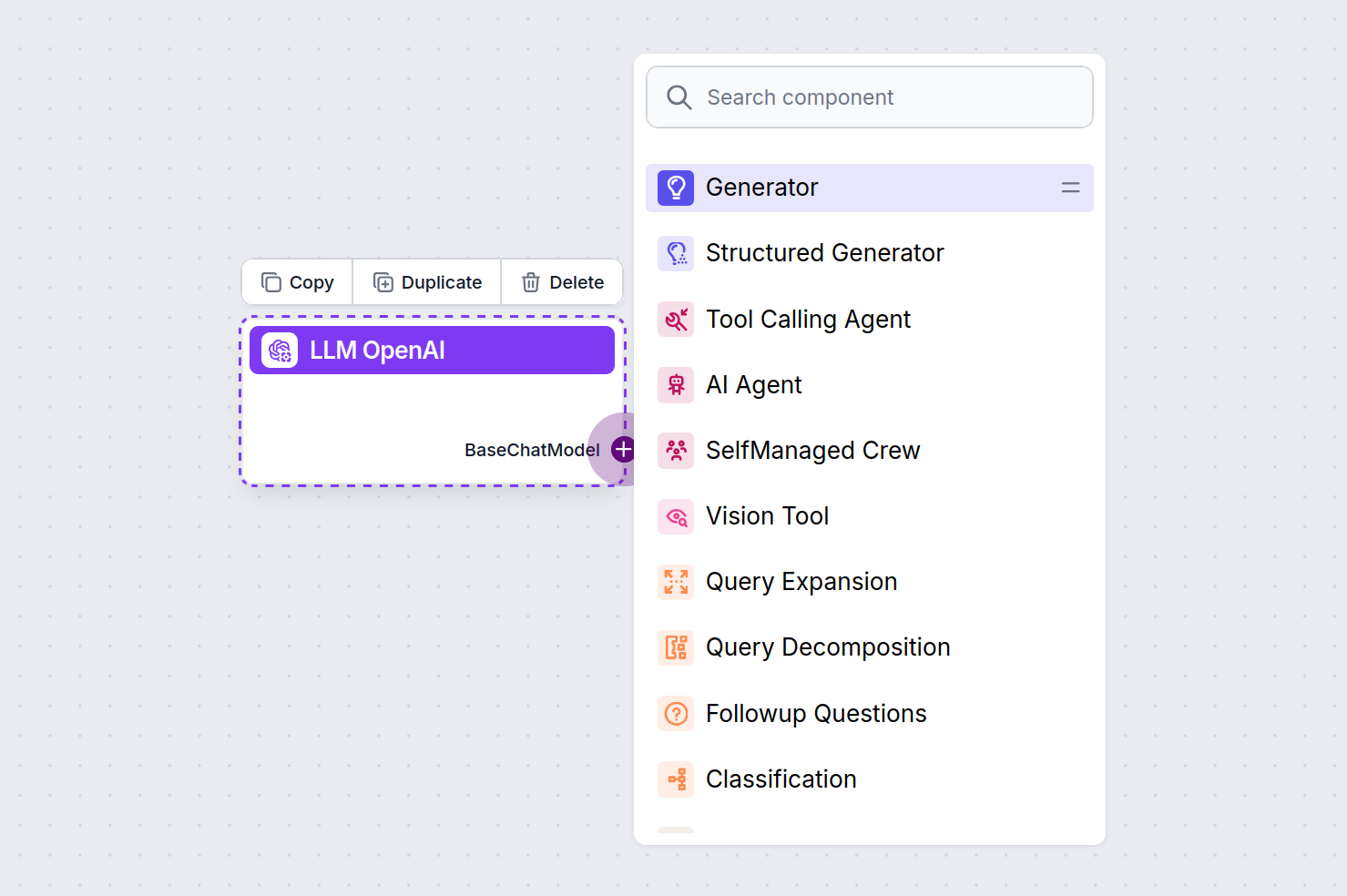

Noterai che tutti i componenti LLM hanno solo una maniglia di output. L’input non passa attraverso il componente, poiché rappresenta solo il modello, mentre la generazione effettiva avviene in AI Agent e Generator.

La maniglia LLM è sempre viola. La maniglia di input LLM si trova su qualsiasi componente che utilizza l’IA per generare testo o elaborare dati. Puoi vedere le opzioni cliccando sulla maniglia:

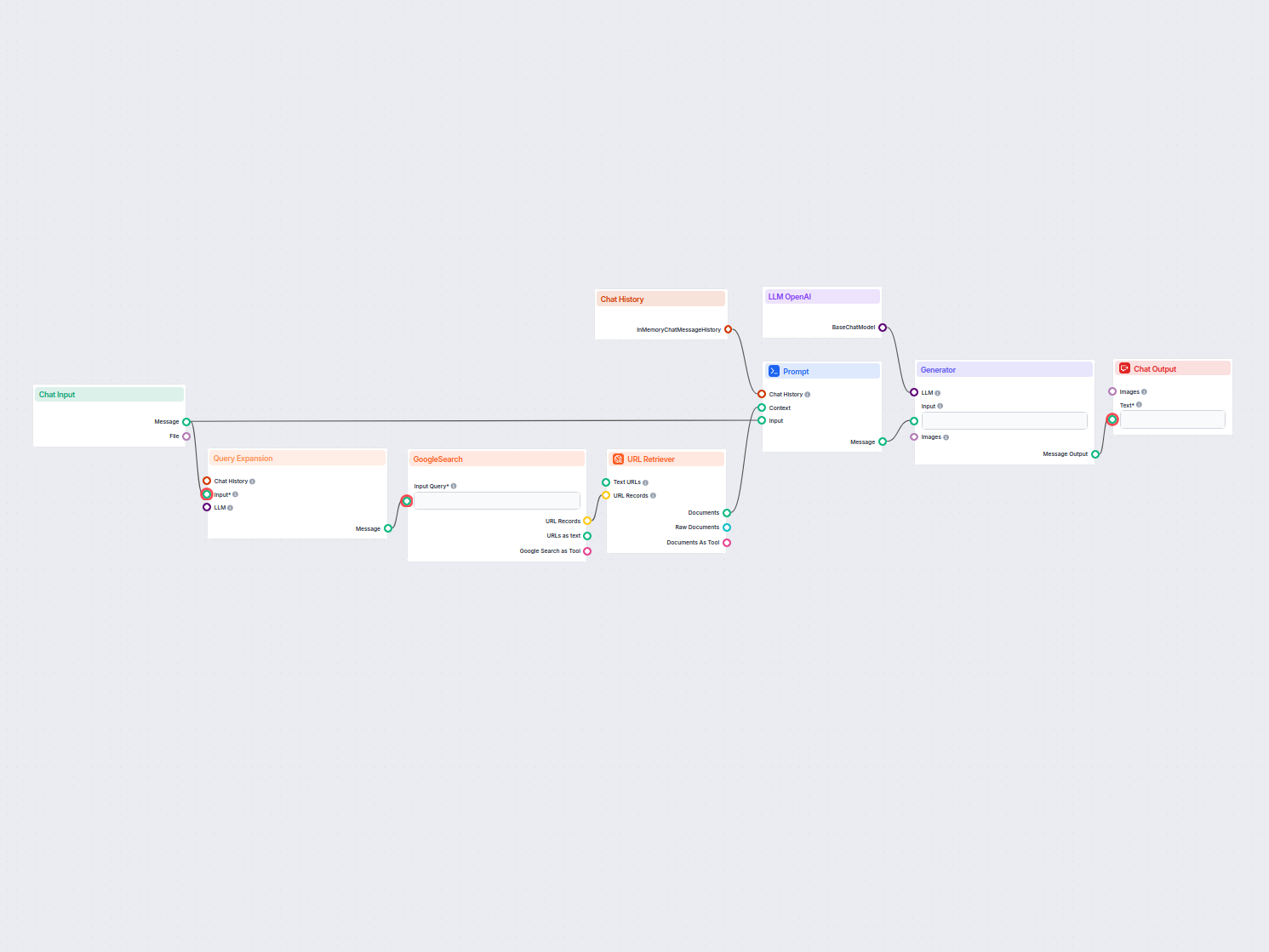

Questo ti permette di creare ogni tipo di strumento. Vediamo il componente in azione. Ecco un semplice flusso chatbot alimentato da Agent che utilizza o1 Preview per generare risposte. Puoi pensarlo come un chatbot ChatGPT di base.

Questo semplice flusso Chatbot include:

- Input chat: rappresenta il messaggio inviato dall’utente in chat.

- Cronologia chat: garantisce che il chatbot possa ricordare e tenere conto delle risposte precedenti.

- Output chat: rappresenta la risposta finale del chatbot.

- Agente IA: un agente IA autonomo che genera risposte.

- LLM OpenAI: la connessione ai modelli di generazione testo di OpenAI.

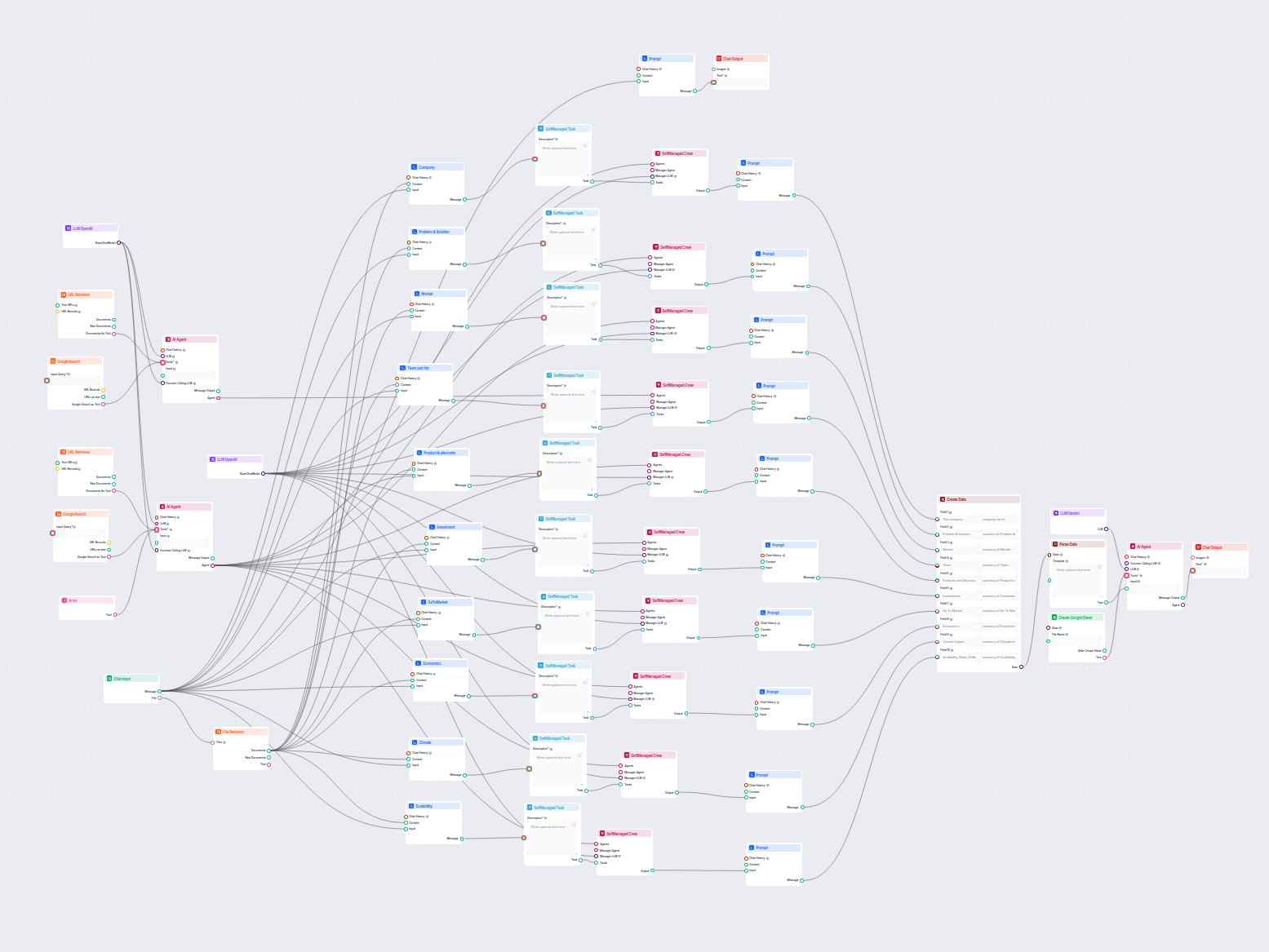

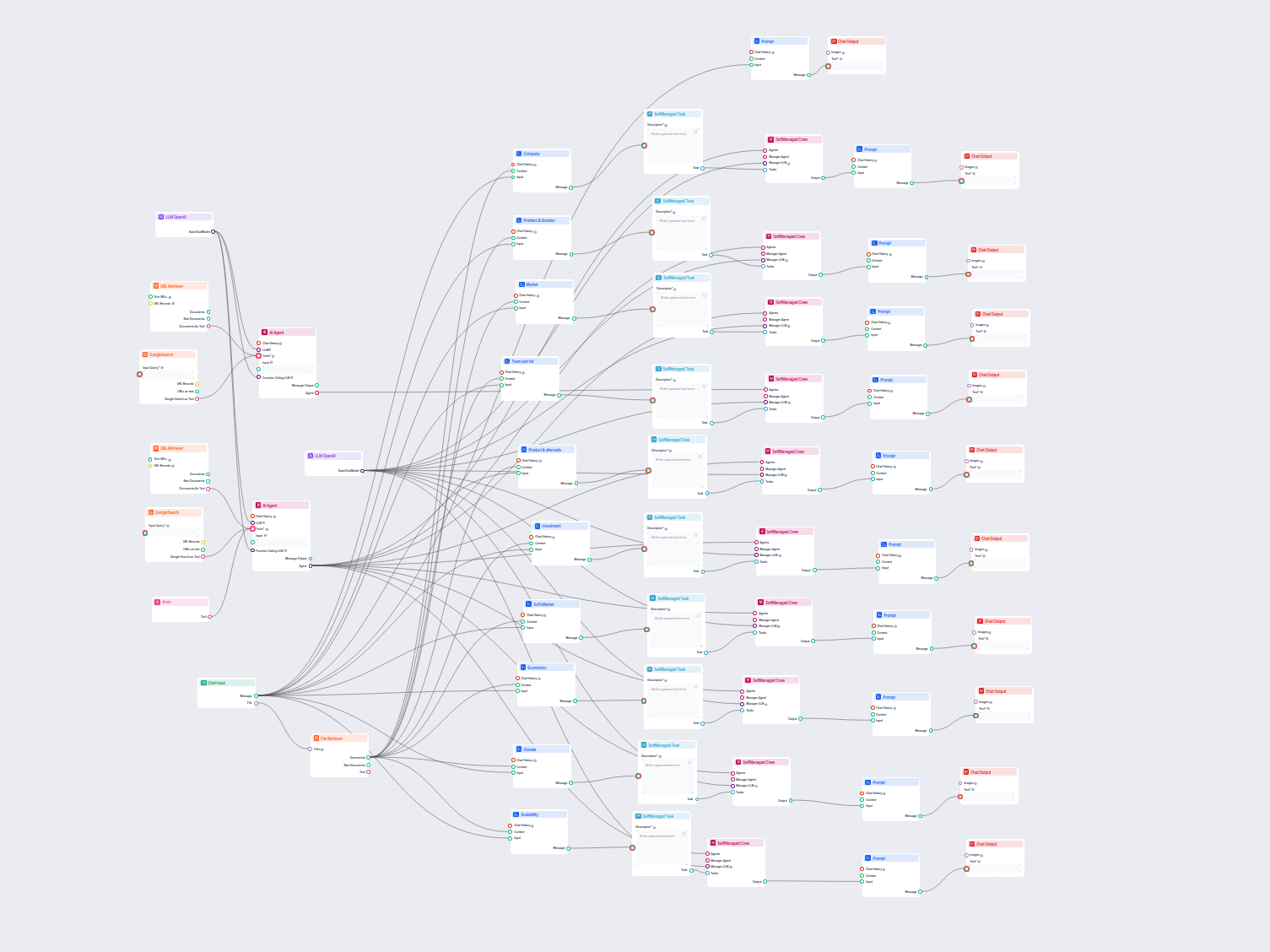

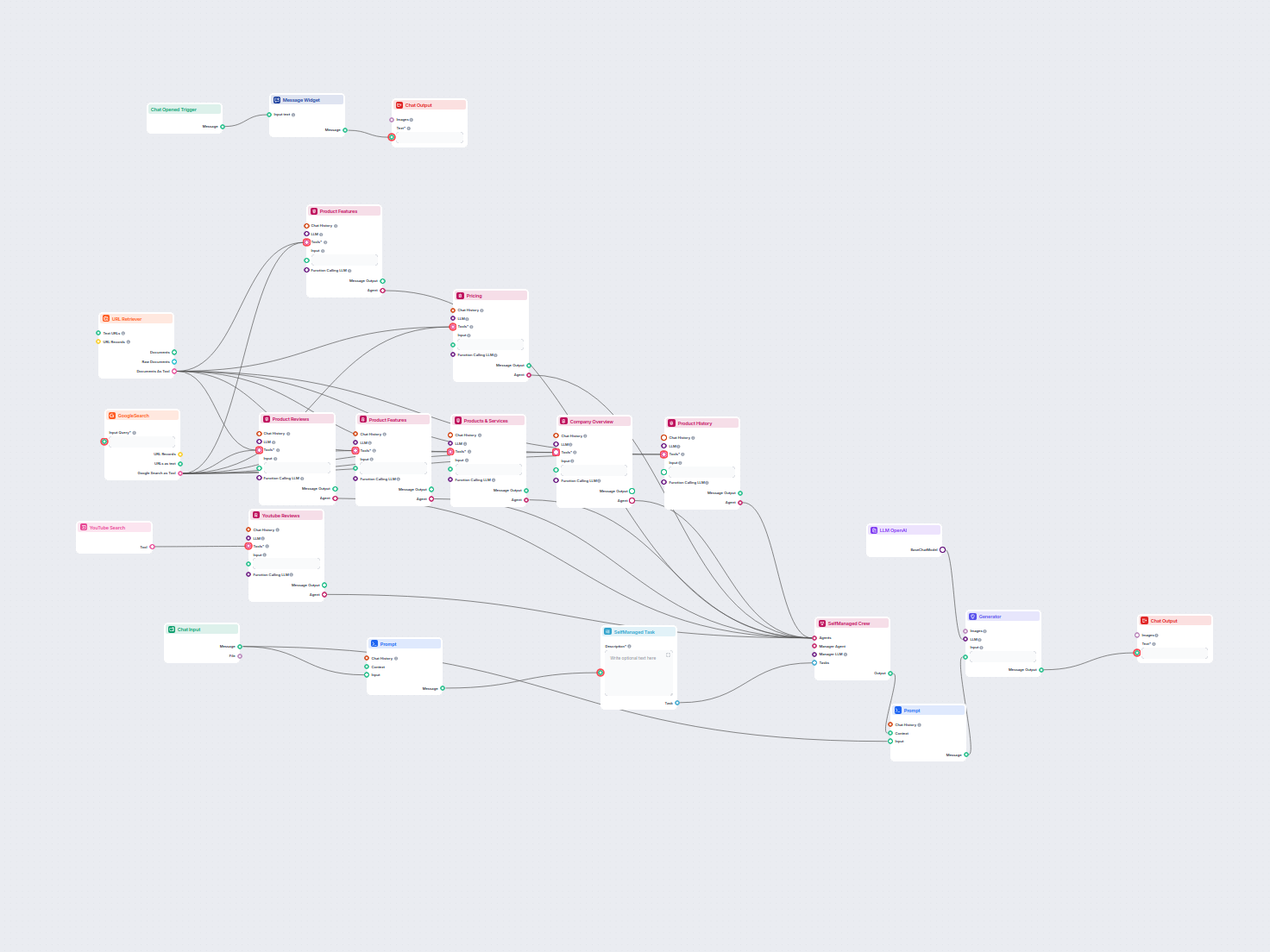

Esempi di modelli di flusso che utilizzano il componente LLM OpenAI

Per aiutarti a iniziare rapidamente, abbiamo preparato diversi modelli di flusso di esempio che mostrano come utilizzare efficacemente il componente LLM OpenAI. Questi modelli presentano diversi casi d'uso e best practice, rendendo più facile per te comprendere e implementare il componente nei tuoi progetti.

Domande frequenti

- Cosa sono gli LLM?

I Large Language Models sono tipi di IA addestrati per elaborare, comprendere e generare testo simile a quello umano. Un esempio comune è ChatGPT, che può fornire risposte elaborate a quasi qualsiasi domanda.

- Posso collegare direttamente un LLM all'Output Chat?

No, il componente LLM è solo una rappresentazione del modello di IA. Cambia il modello che il Generatore utilizzerà. L'LLM predefinito nel Generatore è ChatGPT-4o.

- Quali LLM sono disponibili nei Flussi?

Al momento è disponibile solo il componente OpenAI. Abbiamo in programma di aggiungerne altri in futuro.

- Devo aggiungere un LLM al mio flusso?

No, i Flussi sono una funzione versatile con molti casi d'uso anche senza la necessità di un LLM. Aggiungi un LLM se vuoi creare un chatbot conversazionale che generi liberamente risposte testuali.

- Il componente LLM OpenAI genera la risposta?

Non proprio. Il componente rappresenta solo il modello e crea le regole da seguire. È il componente generatore che lo collega all'input ed esegue la richiesta tramite l'LLM per creare l'output.

Pronto a creare la tua IA?

Chatbot intelligenti e strumenti di IA sotto lo stesso tetto. Collega blocchi intuitivi per trasformare le tue idee in Flussi automatizzati.