Componente Prompt in FlowHunt

Il componente Prompt in FlowHunt specifica ruoli e comportamento del bot per risposte AI personalizzate. Controlla l’output con template personalizzati per costruire chatbot efficaci e sensibili al contesto.

Descrizione del componente

Come funziona il componente Componente Prompt in FlowHunt

Senza un buon prompt, tutti i bot si comporterebbero allo stesso modo e spesso sbaglierebbero le risposte. I prompt forniscono istruzioni e contesto al modello linguistico, aiutandolo a capire che tipo di testo deve produrre.

Panoramica del componente Prompt

Il componente Prompt è progettato per generare template di prompt flessibili da utilizzare nei flussi AI, consentendo l’inserimento dinamico di variabili e contesto. Questo componente è particolarmente utile in scenari di intelligenza artificiale conversazionale, come chatbot o assistenti virtuali, dove è essenziale creare prompt adattabili e consapevoli del contesto.

Cosa fa il componente?

Il componente Prompt crea un template di prompt che può incorporare diverse variabili dinamiche, come input dell’utente, cronologia chat, istruzioni di sistema e messaggi di contesto. Sfruttando queste variabili, il componente ti aiuta a strutturare prompt ricchi e sensibili al contesto che migliorano la performance e la pertinenza dei modelli o agenti AI a valle.

Caratteristiche principali

- Template dinamici: Costruisci prompt che includono automaticamente informazioni disponibili come la cronologia chat, l’input utente e il contesto.

- Variabili personalizzate: Supporta l’inserimento di variabili come

{input},{human_input},{context},{chat_history},{system_message}e{all_input_variables}direttamente nel template del prompt. - Supporto per messaggi di sistema: Permette l’aggiunta di istruzioni a livello di sistema per influenzare il comportamento dell’AI.

- Riutilizzabile nei flussi: L’output di questo componente può essere usato come input per altri componenti, come LLM (Large Language Models) o ulteriori passaggi di elaborazione.

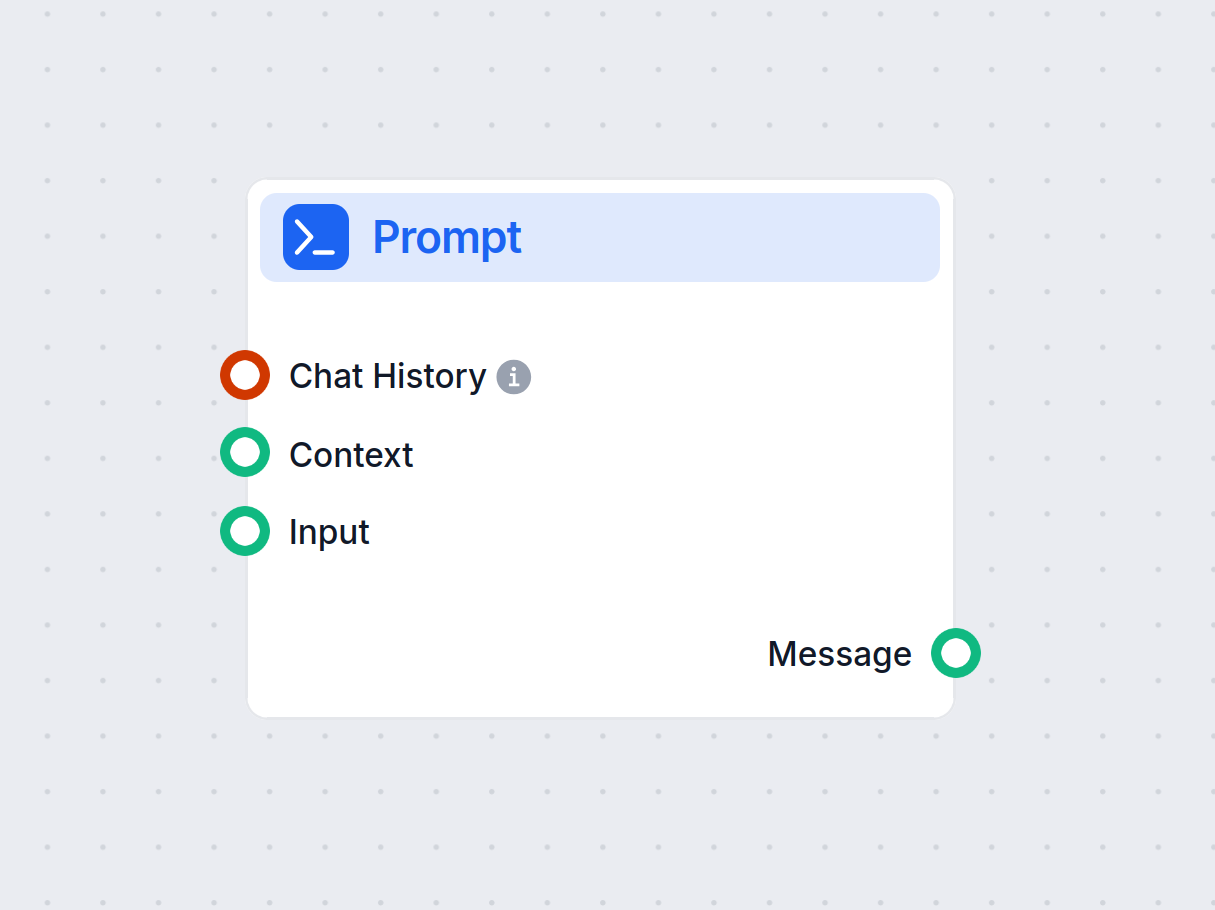

Input

I seguenti input possono essere forniti al componente Prompt:

| Nome input | Tipo | Obbligatorio | Descrizione |

|---|---|---|---|

| Cronologia Chat | InMemoryChatMessageHistory | No | Messaggi delle conversazioni precedenti. Utile per mantenere il contesto o generare query alternative. |

| Contesto | Message | No | Informazioni contestuali aggiuntive da includere nel prompt. |

| Input | Message | No | L’input o il messaggio principale dell’utente. |

| Messaggio di sistema | Stringa (multilinea) | No | Istruzioni a livello di sistema per guidare il comportamento dell’AI. |

| Template | Prompt (multilinea) | No | Il vero e proprio template del prompt, con supporto alle variabili dinamiche per la personalizzazione. |

Output

- Messaggio:

Il componente restituisce un singolo oggetto messaggio che contiene il prompt costruito, con tutte le variabili dinamiche sostituite con i rispettivi valori.

| Nome output | Tipo | Descrizione |

|---|---|---|

| Messaggio | Message | Il prompt generato, pronto per l’uso nei componenti AI a valle. |

Esempi d’uso

- AI conversazionale: Genera automaticamente prompt per chatbot in base all’input utente, alla cronologia delle conversazioni e al contesto aggiuntivo.

- Generazione aumentata dal recupero: Personalizza i prompt per i task di retrieval includendo interazioni passate pertinenti e istruzioni di sistema.

- Istruzioni personalizzate: Adatta facilmente i prompt a diversi compiti o profili utente modificando il template e il messaggio di sistema.

Perché usare questo componente?

- Migliora il Prompt Engineering: Gestisci e aggiorna facilmente i template dei prompt senza hardcoding.

- Aumenta la pertinenza dell’AI: Grazie a contesto, messaggi di sistema e cronologia, i prompt sono più informativi e precisi.

- Maggiore flessibilità: Supporta un’ampia gamma di casi d’uso, dalle semplici domande/risposte alle conversazioni complesse e multi-turno.

Tabella riepilogativa

| Caratteristica | Vantaggio |

|---|---|

| Iniezione dinamica di variabili | Prompt adattabili e sensibili al contesto |

| Supporto per la cronologia chat | Mantiene la continuità nelle interazioni multi-turno |

| Integrazione del messaggio di sistema | Affina la personalità o le istruzioni dell’AI |

| Integrazione semplice nei flussi | Semplifica la creazione di prompt per l’AI a valle |

Questo componente è uno strumento fondamentale per chiunque voglia costruire flussi AI sofisticati e sensibili al contesto, dove la costruzione del prompt è la chiave per ottenere risultati di alta qualità.

Template

Questa è un’impostazione avanzata e opzionale. Puoi creare template di prompt con variabili specifiche per controllare pienamente l’output della chat. Ad esempio:

Come esperto SEO, analizza il contenuto dell’URL e crea un titolo lungo fino a 65 caratteri.— Contenuto dell’URL —{input}Task: Genera un titolo simile ad altri usando la query {human_input}. Non cambiare {human_input} nel nuovo titolo. NUOVO TITOLO:

Il prompt di default è il seguente:

Sei un assistente AI modello linguistico.

Il tuo compito è generare una risposta basata sulla query di input.

Se viene fornito un contesto, usalo per generare la risposta alla query INPUT e HUMAN_INPUT.

Formatta la risposta in markdown.

RISPOSTA IN LINGUA: {lang}

VARIABILI:

{"session_start_time": "2025-06-03 07:35:22", "current_page_url": "https://app.flowhunt.io/aistudio/flows/de6c2e2c-d817-4b2f-af2c-12dba3f46870?ws=74be5f74-d7c5-4076-839d-8ac1771a3b75"}

INPUT: {input}

RISPOSTA:

Il prompt predefinito copia la stessa struttura delle impostazioni del componente. Puoi sovrascrivere le impostazioni modificando e usando le variabili nel campo template. Creare i tuoi template ti dà un maggiore controllo sull’output.

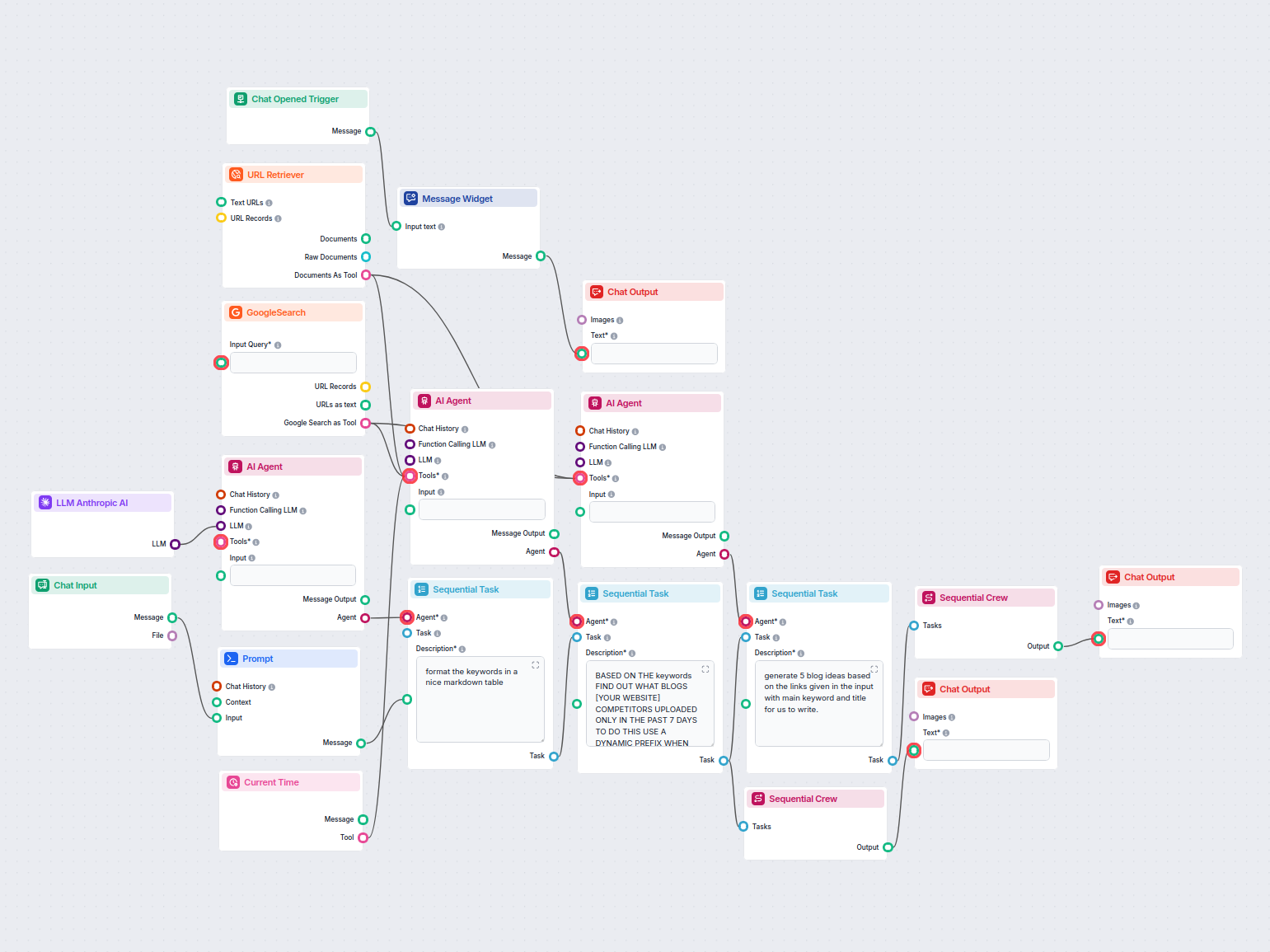

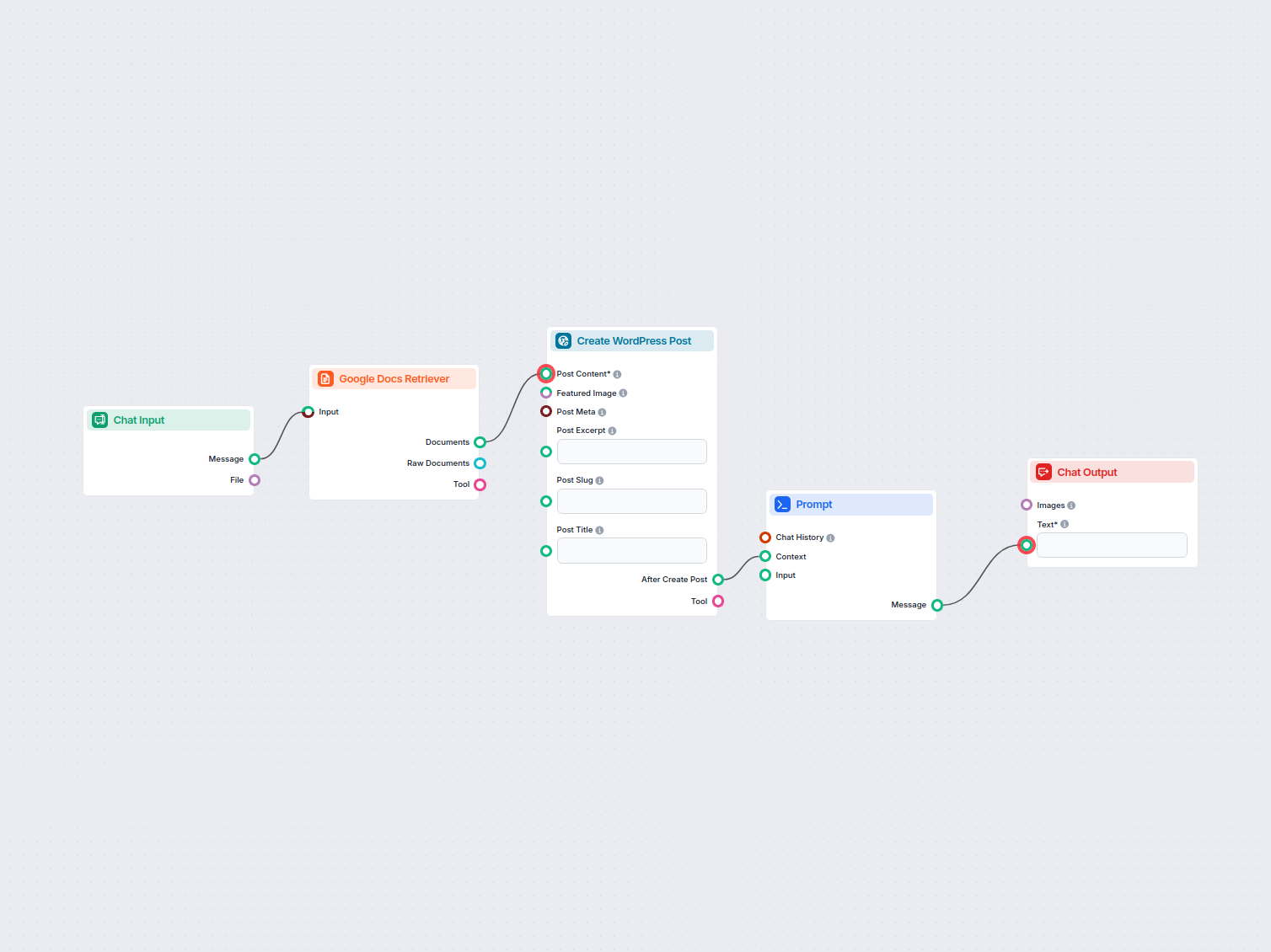

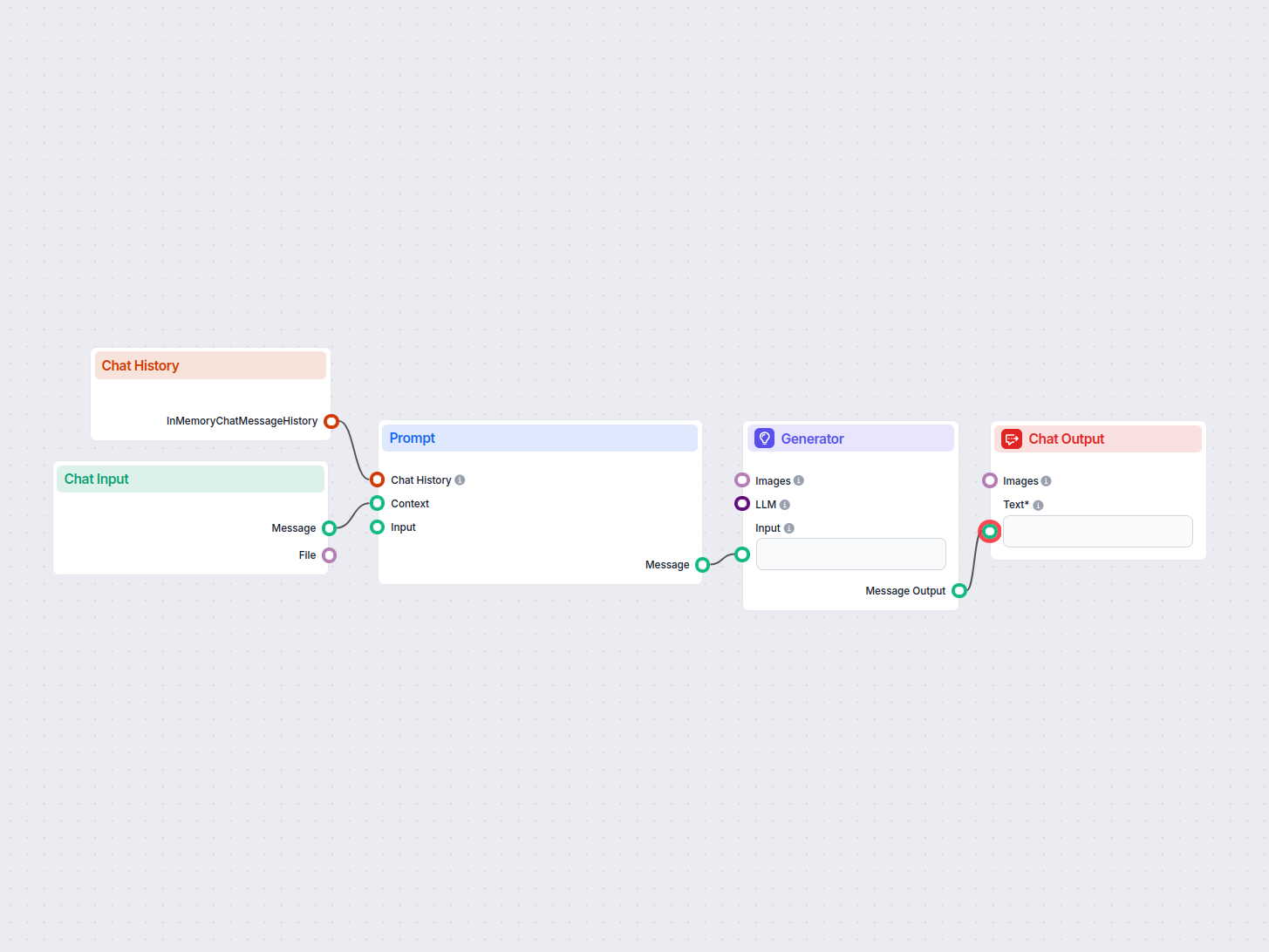

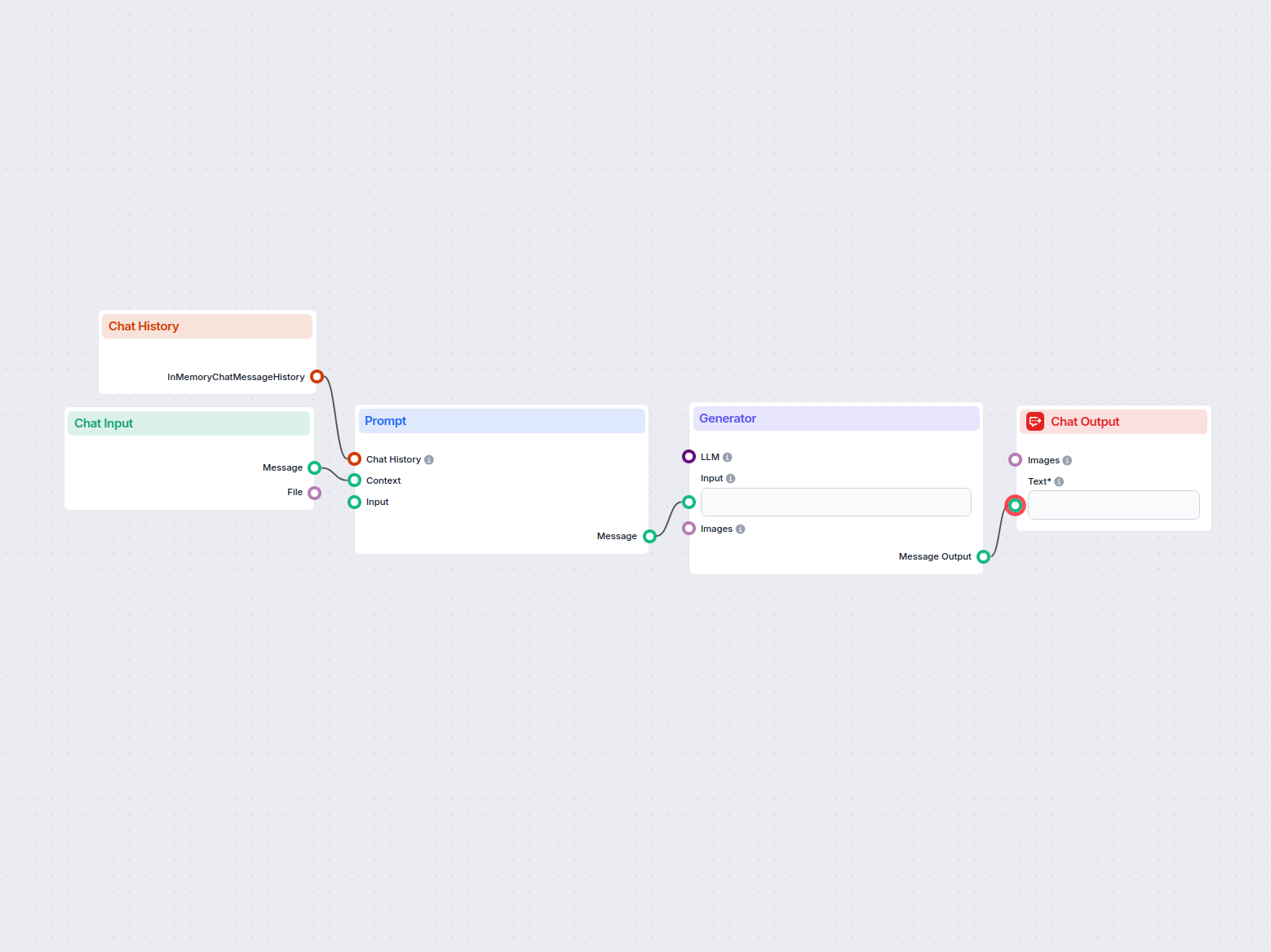

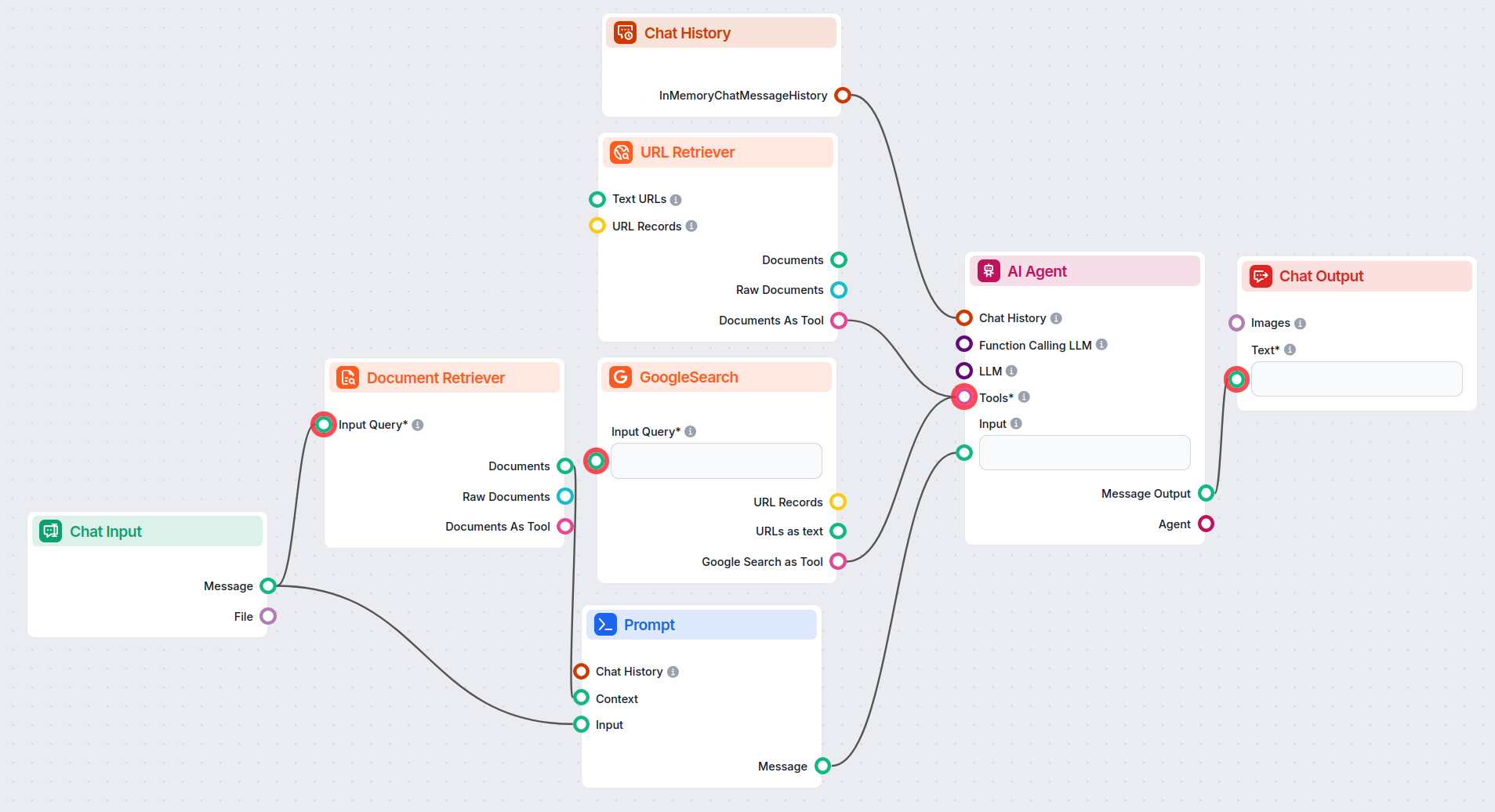

Come collegare il componente Prompt al tuo flusso

Il prompt è un componente opzionale che modifica e specifica ulteriormente l’output finale. Richiede il collegamento di diversi componenti:

- Cronologia chat: Collegare la cronologia non è obbligatorio ma spesso vantaggioso. Ricordare i messaggi precedenti rende le risposte future più pertinenti.

- Contesto: Qualsiasi testo significativo può servire da contesto. La scelta più comune è collegare la conoscenza dai retriever.

- Input: Solo il componente Chat Input può essere collegato qui.

L’output di questo componente è un testo che può essere collegato a vari componenti. Nella maggior parte dei casi, si prosegue subito con il componente Generatore per collegare il prompt a un LLM.

Esempio

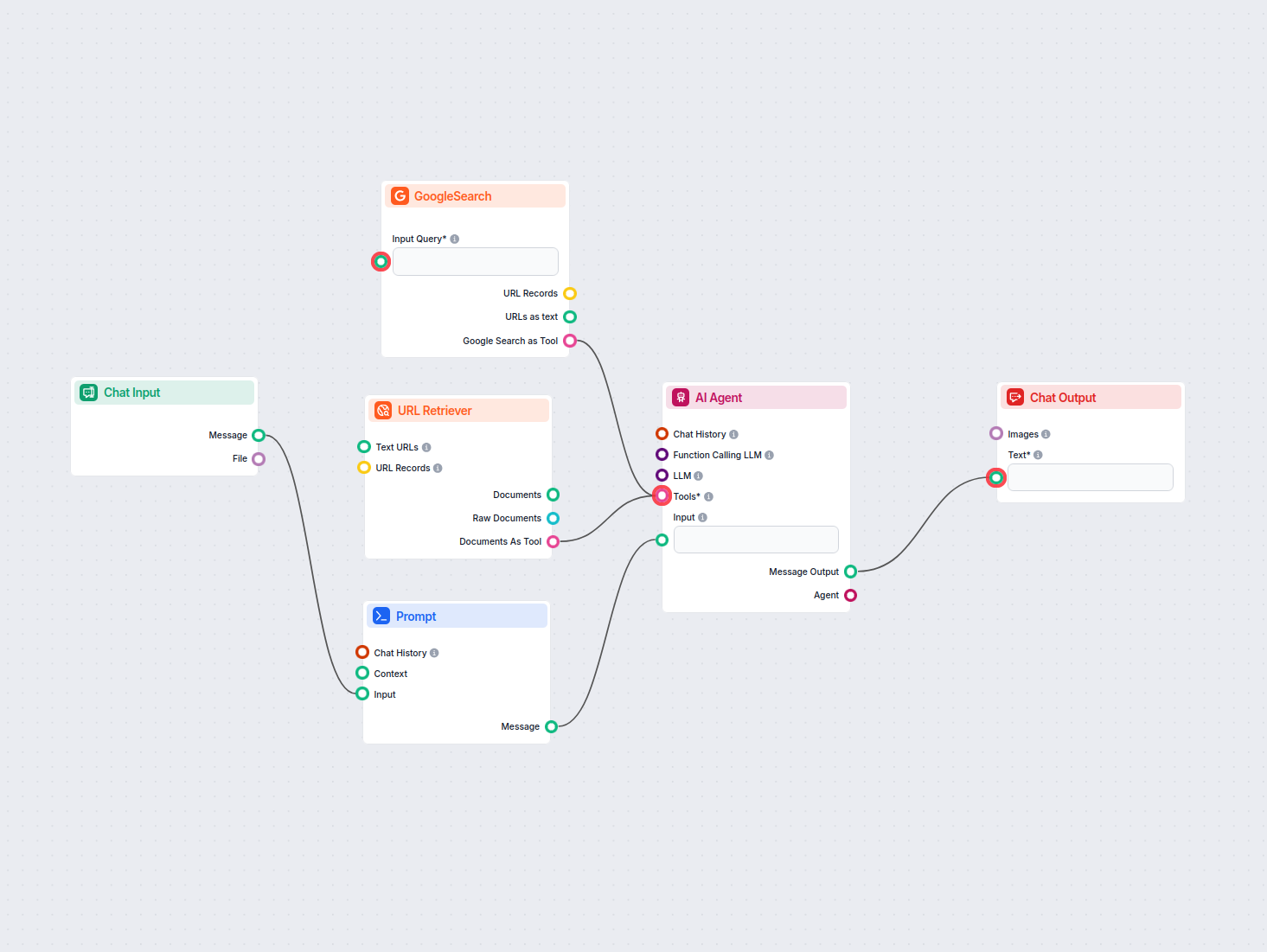

Creiamo un bot molto semplice. Amplieremo l’esempio del bot cavaliere medievale visto prima. Anche se parla in modo buffo, la sua missione principale è essere un bot di assistenza clienti utile e vogliamo che dia informazioni pertinenti.

Facciamo una domanda tipica di customer service al nostro bot. Chiederemo il prezzo di URLsLab. Per ottenere una risposta corretta, dobbiamo:

- Dargli un contesto: In questo esempio, usiamo il componente URL retriever per fornirgli una pagina con tutte le informazioni necessarie.

- Collegare l’input: L’input è sempre il messaggio umano dal componente Chat Input.

- Cronologia chat: È opzionale, ma colleghiamola per questo caso specifico.

- Template: Manteniamo il prompt, “Sei un bot di assistenza clienti utile che parla come un cavaliere medievale.”. I prompt possono essere molto più elaborati. Consulta la nostra libreria di prompt per ispirazione.

- Aggiungi Generatore: Vogliamo che il bot abbia capacità conversazionali. Per farlo, collega il Generatore. Il Prompt serve da input per il generatore.

Il flusso risultante sarà simile a questo:

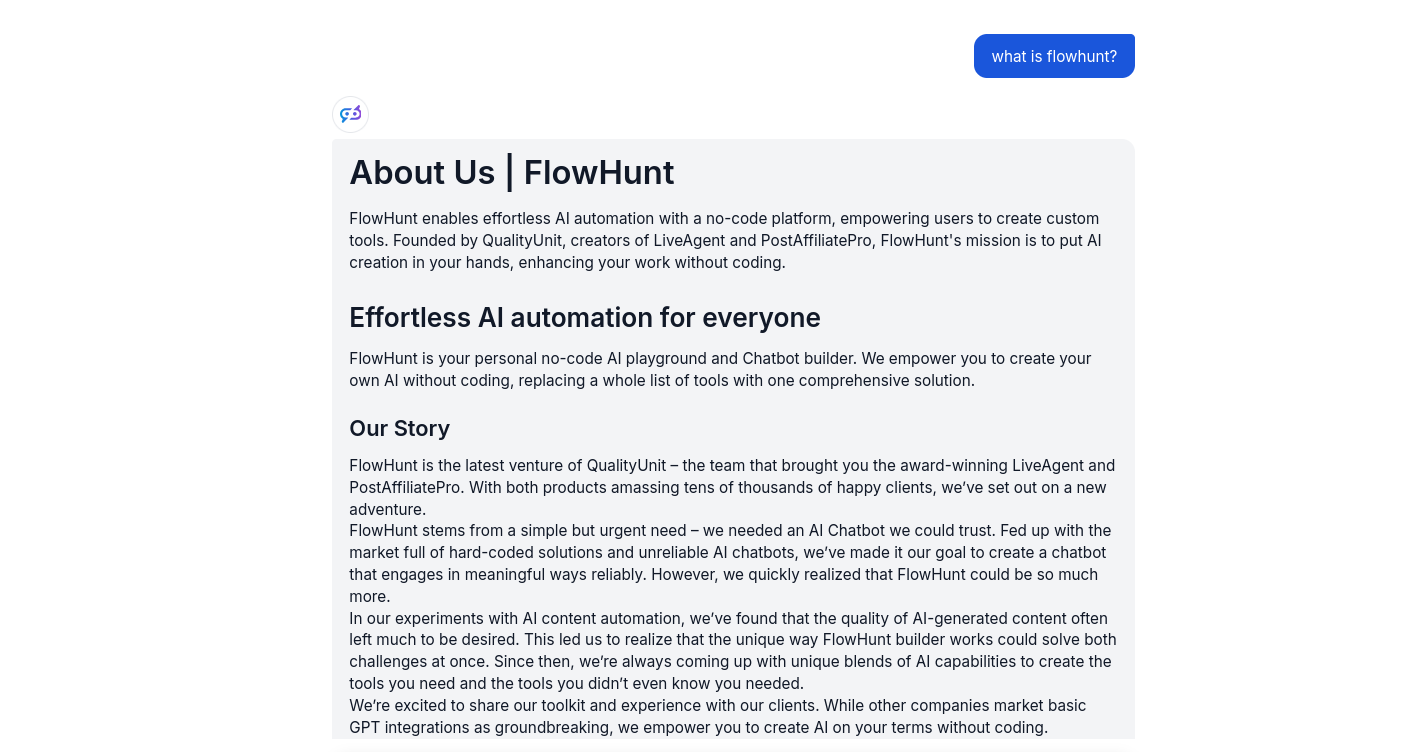

È il momento di testare la conoscenza del nostro bot cavaliere medievale. L’URL che gli abbiamo fornito contiene i prezzi di URLsLab. Quindi chiediamoglielo:

Ora il nostro bot risponde alle domande di base con un linguaggio pomposo d’altri tempi. Ma, cosa più importante, il bot aderisce al suo ruolo centrale di assistente clienti utile e utilizza con successo le informazioni dell’URL specificato.

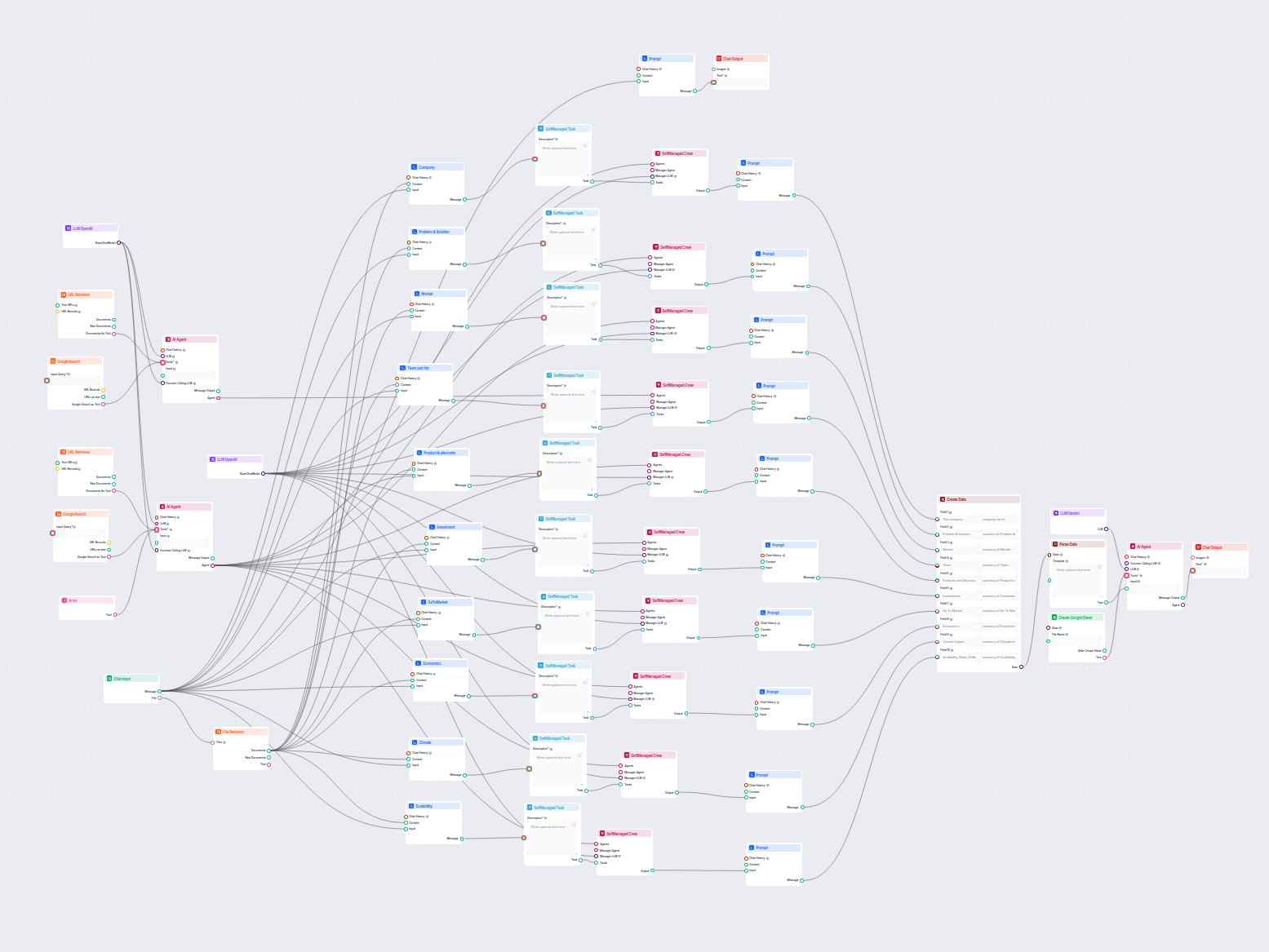

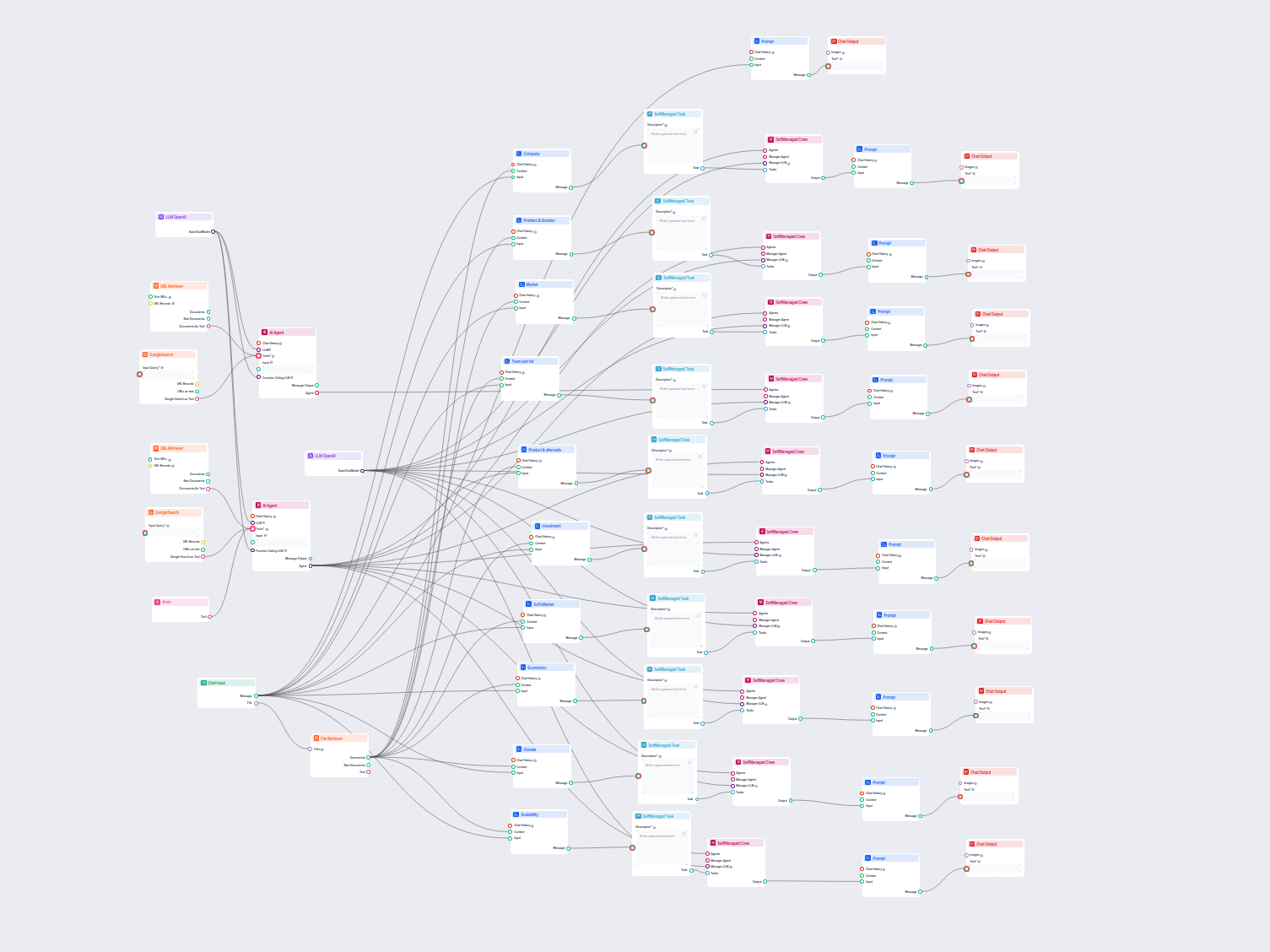

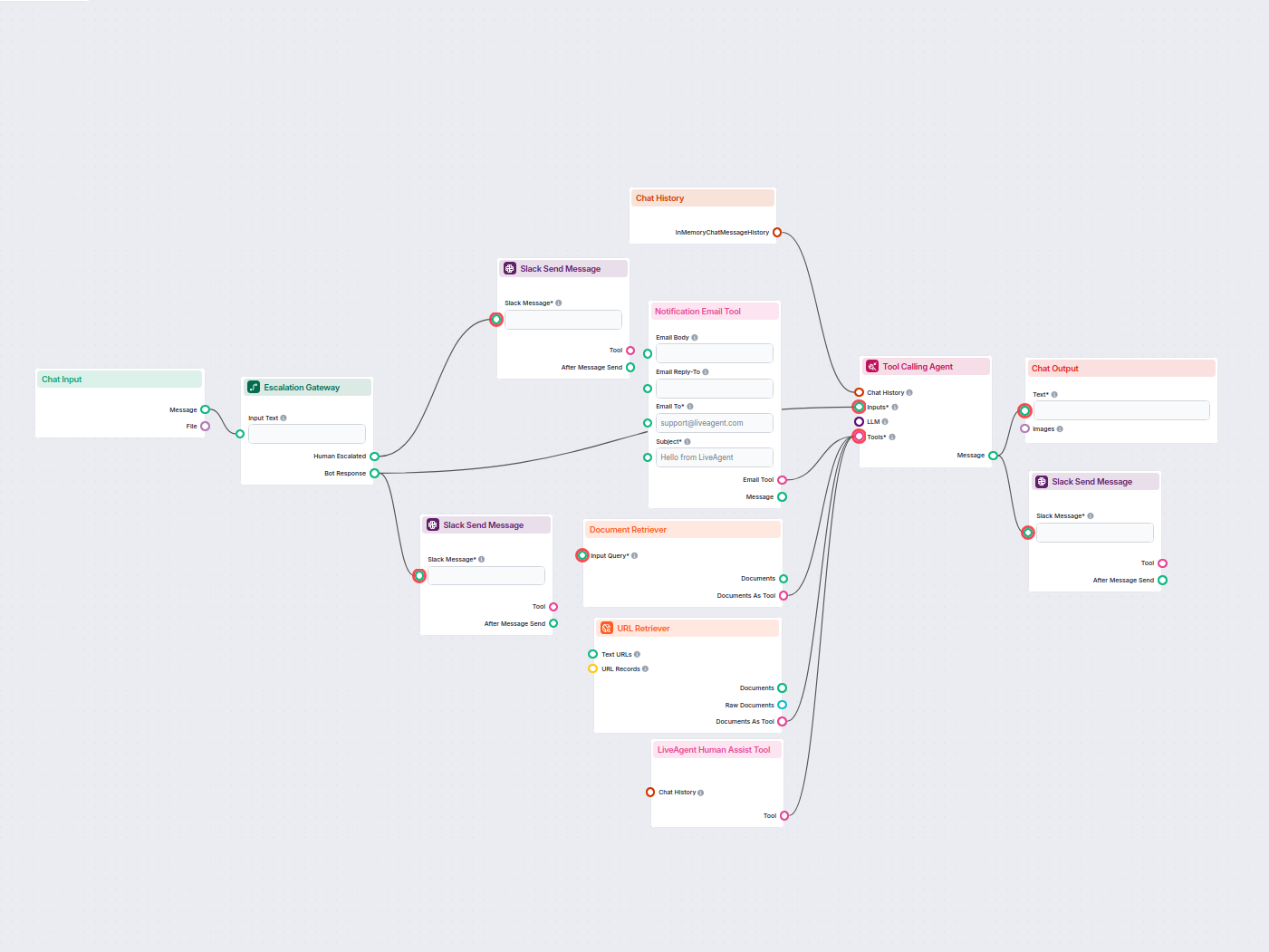

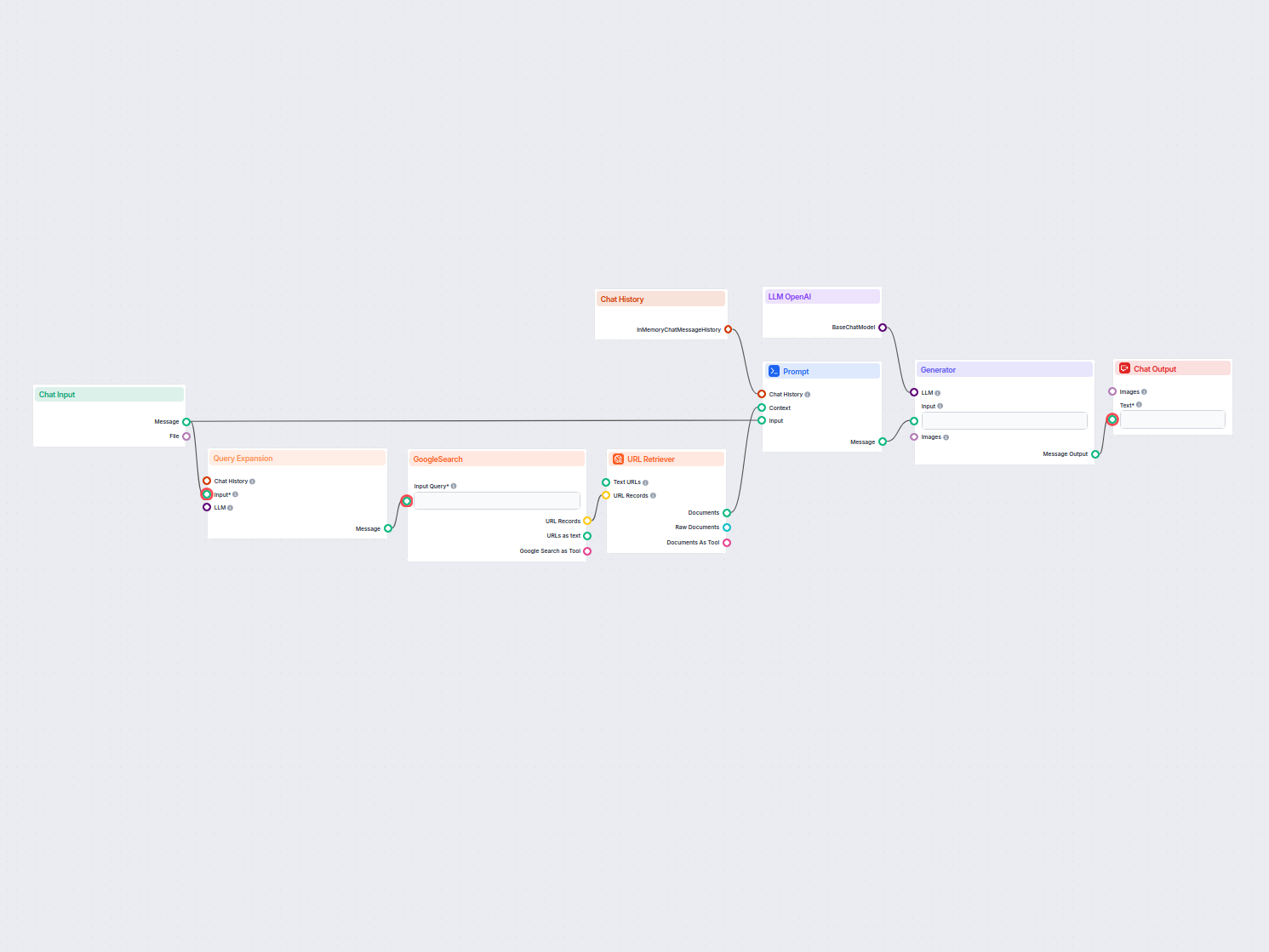

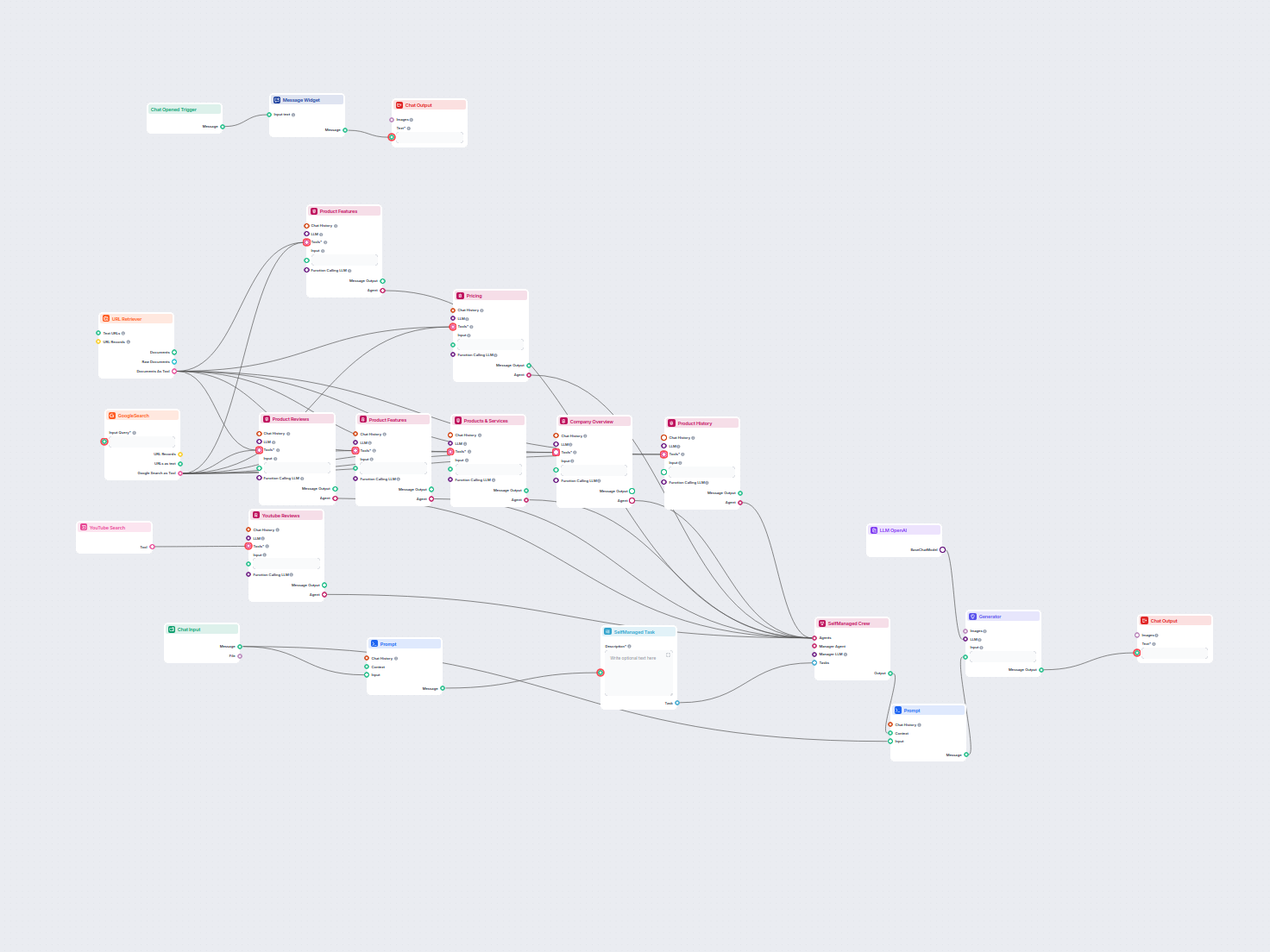

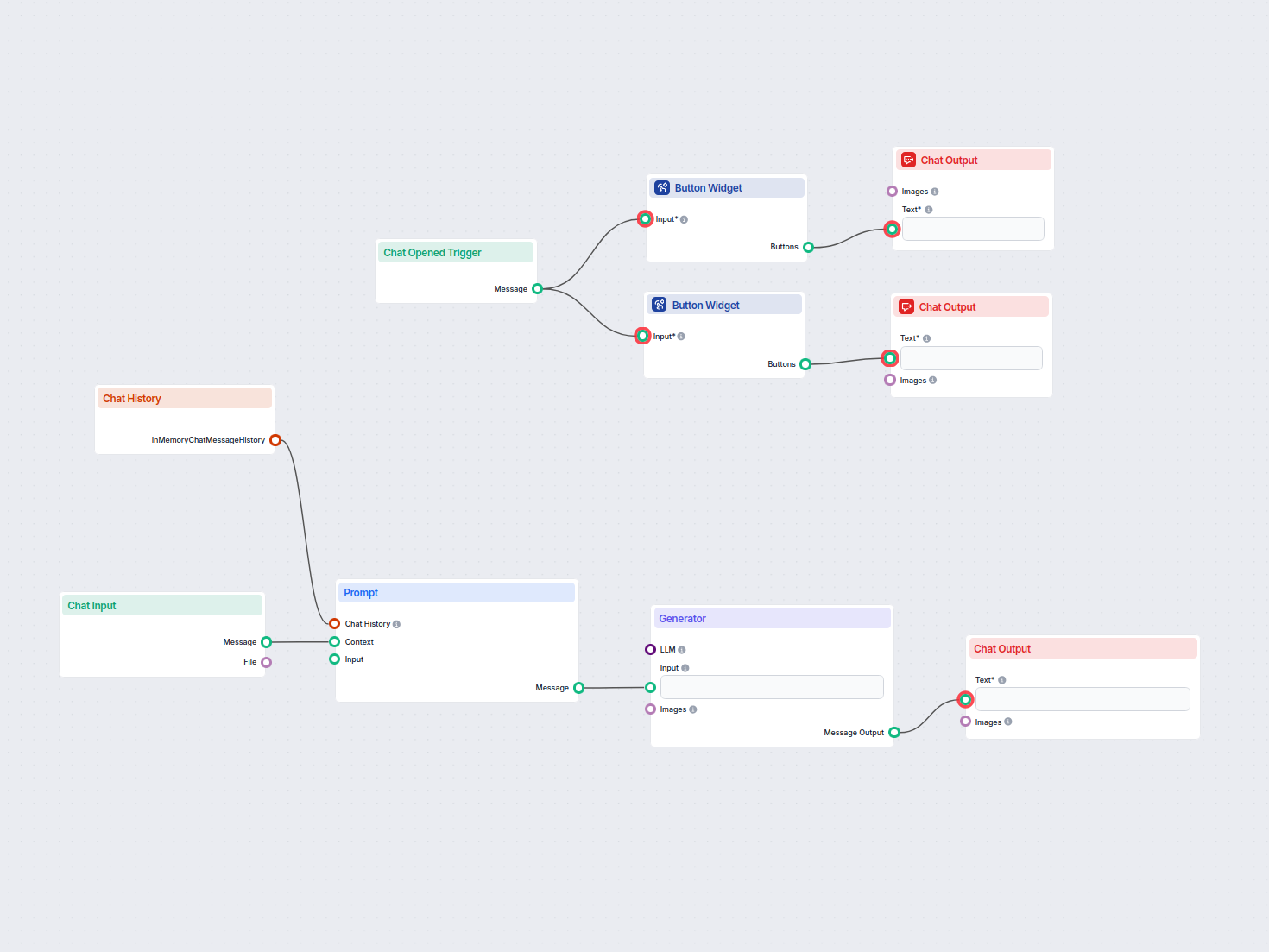

Esempi di modelli di flusso che utilizzano il componente Componente Prompt in FlowHunt

Per aiutarti a iniziare rapidamente, abbiamo preparato diversi modelli di flusso di esempio che mostrano come utilizzare efficacemente il componente Componente Prompt in FlowHunt. Questi modelli presentano diversi casi d'uso e best practice, rendendo più facile per te comprendere e implementare il componente nei tuoi progetti.

Mostrando 1 a 60 di 69 risultati

Domande frequenti

- Cos’è il componente Prompt?

Il componente Prompt fornisce al bot istruzioni e contesto, assicurando che risponda nel modo desiderato.

- Devo sempre includere Prompt nei miei flussi?

Includerlo in molti casi d’uso è un’ottima idea, ma il componente è opzionale.

- Cos’è il messaggio di sistema?

È un campo di testo modificabile in cui imposti la personalità e il ruolo del bot. Basta compilare il template: 'Sei un {role} che {behavior}.' Ad esempio, 'Sei un bot di assistenza clienti utile che parla come un cavaliere medievale.'

- Devo sempre includere Prompt nei miei flussi?

Sicuramente è una buona idea includerlo in molti casi d’uso, ma il componente è opzionale.

Prova il componente Prompt di FlowHunt

Inizia a costruire chatbot AI personalizzati e contestualizzati con l’intuitiva funzione Prompt di FlowHunt. Definisci ruoli, comportamenti e controlla l’output per automazioni più intelligenti.