Descrizione del componente

Come funziona il componente LLM xAI

Cos’è il componente LLM xAI?

Il componente LLM xAI collega il modello Grok al tuo flow. Mentre i Generator e gli Agent sono dove avviene la vera magia, i componenti LLM ti permettono di controllare il modello utilizzato. Tutti i componenti hanno ChatGPT-4 come impostazione predefinita. Puoi collegare questo componente se desideri cambiare modello o avere un maggiore controllo su di esso.

Ricorda che collegare un componente LLM è opzionale. Tutti i componenti che usano un LLM hanno ChatGPT-4o come default. I componenti LLM ti permettono di cambiare il modello e controllarne le impostazioni.

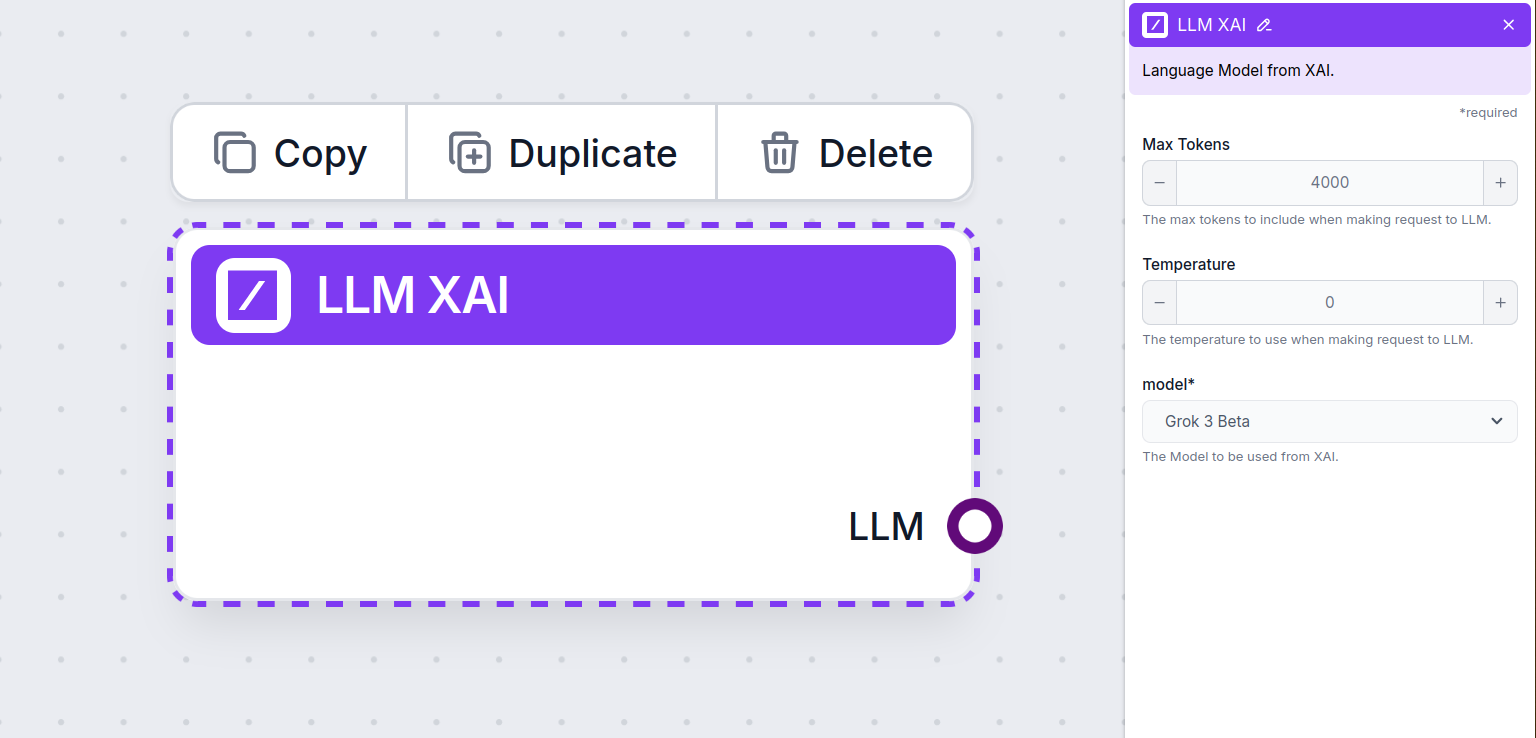

Impostazioni del componente LLM xAI

Max Token

I token rappresentano le unità individuali di testo che il modello elabora e genera. L’utilizzo dei token varia in base ai modelli, e un singolo token può essere qualsiasi cosa: da parole o sottoparti di parole fino a un singolo carattere. I modelli sono solitamente tariffati in milioni di token.

L’impostazione max token limita il numero totale di token che possono essere elaborati in una singola interazione o richiesta, garantendo che le risposte siano generate entro limiti ragionevoli. Il limite predefinito è di 4.000 token, dimensione ottimale per sintetizzare documenti e più fonti per generare una risposta.

Temperatura

La temperatura controlla la variabilità delle risposte, spaziando da 0 a 1.

Una temperatura di 0.1 renderà le risposte molto precise ma potenzialmente ripetitive e carenti.

Una temperatura alta di 1 permette la massima creatività nelle risposte ma comporta il rischio di risposte irrilevanti o persino allucinatorie.

Ad esempio, la temperatura consigliata per un bot di assistenza clienti è tra 0.2 e 0.5. Questo livello dovrebbe mantenere le risposte rilevanti e in linea con lo script, consentendo comunque una naturale variazione.

Modello

Questa è la selezione del modello. Qui troverai tutti i modelli supportati dal provider xAI. Il modello di punta di xAI per il testo si chiama Grok. Al momento, supportiamo solo il modello grok-beta, poiché è l’unico rilasciato per l’uso tramite API pubblica.

Vuoi saperne di più su Grok-beta e vedere come si confronta con altri modelli? Dai un’occhiata a questo articolo.

Come aggiungere LLM xAI al tuo flow

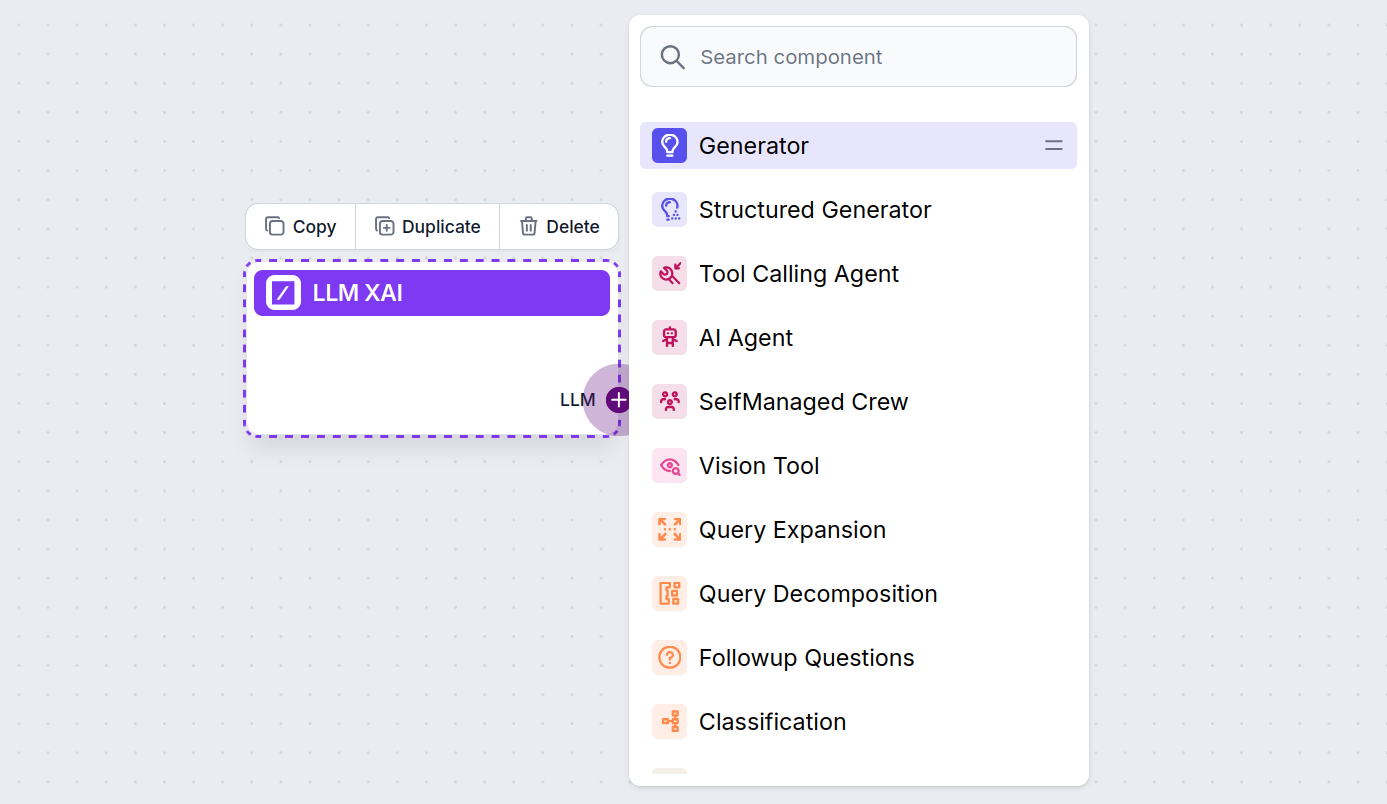

Noterai che tutti i componenti LLM hanno solo un output handle. L’input non passa attraverso il componente, poiché rappresenta solo il modello, mentre la generazione effettiva avviene negli AI Agent e Generator.

L’handle LLM è sempre viola. L’input handle LLM si trova su qualsiasi componente che utilizza l’AI per generare testo o elaborare dati. Puoi vedere le opzioni facendo clic sull’handle:

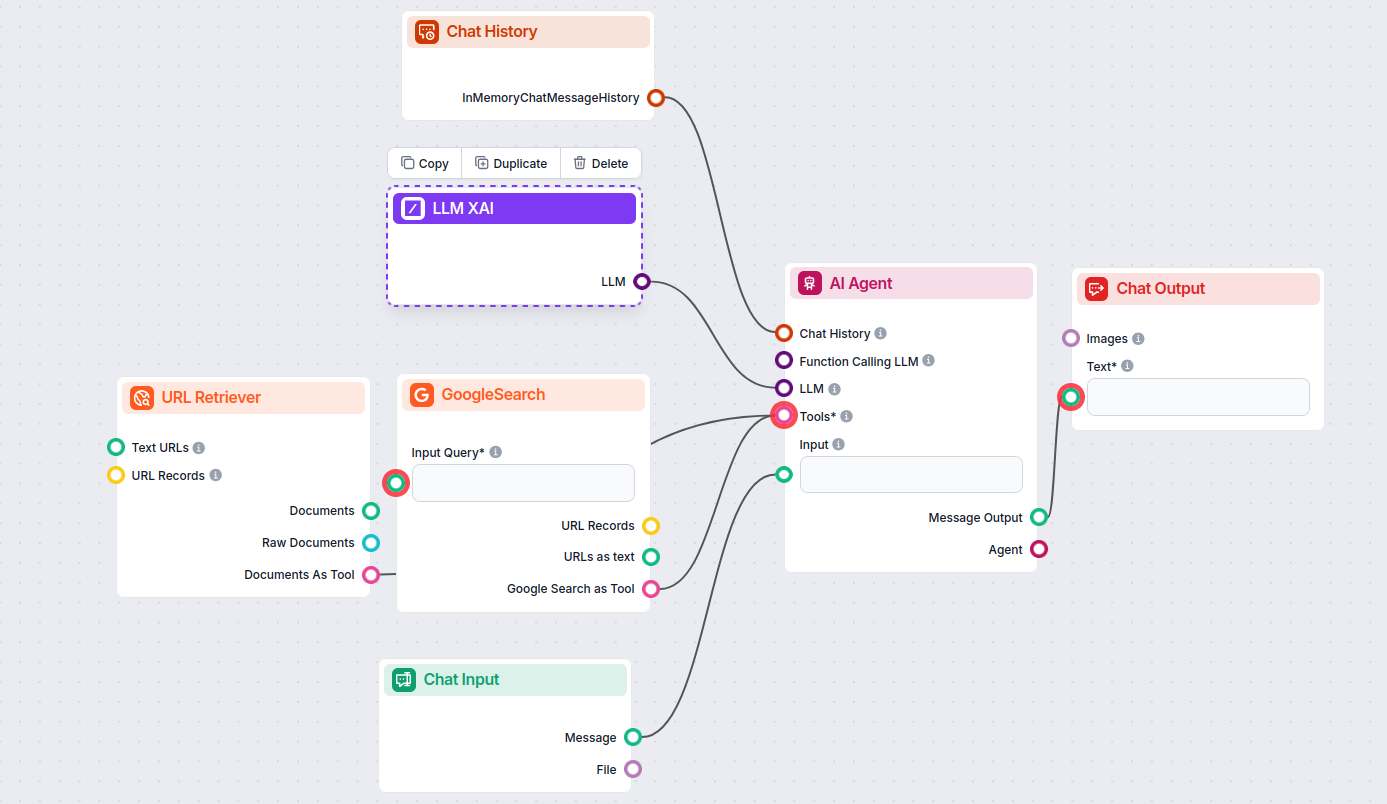

Questo ti permette di creare ogni tipo di strumento. Vediamo il componente in azione. Ecco un semplice Flow chatbot AI Agent che utilizza grok-beta di xAI per generare risposte. Puoi pensarlo come un chatbot xAI di base.

Questo semplice Chatbot Flow include:

- Input chat: rappresenta il messaggio inviato dall’utente in chat.

- Cronologia chat: assicura che il chatbot possa ricordare e tener conto delle risposte precedenti.

- Output chat: rappresenta la risposta finale del chatbot.

- AI Agent: un agente AI autonomo che genera risposte.

- LLM xAI: la connessione ai modelli di generazione del testo di xAI.

Domande frequenti

- Cos'è LLM xAI in FlowHunt?

LLM xAI è un componente di FlowHunt che ti permette di collegare e controllare i modelli di generazione del testo dei provider xAI, come Grok-beta, all'interno dei tuoi flussi e chatbot AI.

- Quali modelli xAI supporta FlowHunt?

Attualmente, FlowHunt supporta il modello grok-beta di xAI, con ulteriori modelli che verranno aggiunti non appena saranno disponibili tramite API pubblica.

- Quali impostazioni posso controllare con il componente LLM xAI?

Puoi regolare max token, temperatura (variabilità delle risposte) e selezionare tra i modelli xAI disponibili per adattare il comportamento del tuo chatbot o strumento AI.

- È obbligatorio collegare il componente LLM xAI per ogni chatbot?

No, è opzionale. Per impostazione predefinita, i componenti usano ChatGPT-4o, ma puoi collegare LLM xAI per passare ai modelli xAI o avere un controllo maggiore.

- Come aggiungo il componente LLM xAI al mio progetto FlowHunt?

Basta aggiungere il componente LLM al tuo flow; funge da selettore del modello. La generazione effettiva del testo avviene negli AI Agent e Generator collegati ad esso.

Prova oggi LLM xAI di FlowHunt

Inizia a creare chatbot AI e strumenti più intelligenti con FlowHunt. Connettiti ai migliori modelli xAI come Grok-beta in una dashboard flessibile e senza codice.