Funzioni di Attivazione

Le funzioni di attivazione introducono la non linearità nelle reti neurali, permettendo loro di apprendere schemi complessi essenziali per le applicazioni di IA e deep learning.

Le funzioni di attivazione sono fondamentali per l’architettura delle reti neurali artificiali (ANN), influenzando in modo significativo la capacità della rete di apprendere ed eseguire compiti complessi. Questo articolo del glossario approfondisce la complessità delle funzioni di attivazione, esaminando il loro scopo, i tipi e le applicazioni, in particolare nell’ambito dell’IA, del deep learning e delle reti neurali.

Che cos’è una Funzione di Attivazione?

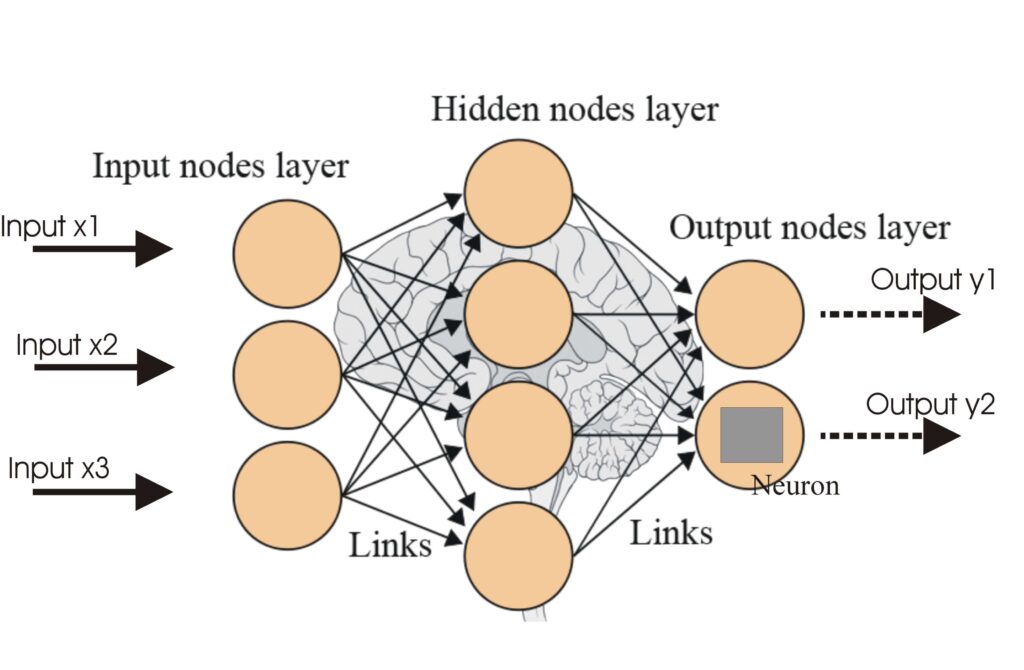

Una funzione di attivazione in una rete neurale è un’operazione matematica applicata all’output di un neurone. Determina se un neurone debba essere attivato o meno, introducendo non linearità nel modello, il che consente alla rete di apprendere schemi complessi. Senza queste funzioni, una rete neurale si comporterebbe essenzialmente come un modello di regressione lineare, indipendentemente dalla sua profondità o dal numero di strati.

Scopo delle Funzioni di Attivazione

- Introduzione della Non Linearità: Le funzioni di attivazione permettono alle reti neurali di catturare relazioni non lineari nei dati, essenziali per risolvere compiti complessi.

- Output Limitato: Limitano l’output dei neuroni a un intervallo specifico, prevenendo valori estremi che possono ostacolare il processo di apprendimento.

- Propagazione del Gradiente: Durante la retropropagazione, le funzioni di attivazione aiutano nel calcolo dei gradienti, necessari per aggiornare pesi e bias nella rete.

Tipi di Funzioni di Attivazione

Funzioni di Attivazione Lineari

- Equazione: $f(x) = x$

- Caratteristiche: Non viene introdotta alcuna non linearità; gli output sono direttamente proporzionali agli input.

- Caso d’Uso: Spesso utilizzata nello strato di output per compiti di regressione in cui i valori di output non sono limitati a un intervallo specifico.

- Limite: Tutti gli strati collasserebbero in un unico strato, perdendo la profondità della rete.

Funzioni di Attivazione Non Lineari

Funzione Sigmoid

- Equazione: $f(x) = \frac{1}{1 + e^{-x}}$

- Caratteristiche: Gli output variano tra 0 e 1; curva a forma di “S”.

- Caso d’Uso: Adatta per problemi di classificazione binaria.

- Limite: Può soffrire del problema del gradiente che svanisce, rallentando l’apprendimento nelle reti profonde.

Funzione Tanh

- Equazione: $f(x) = \tanh(x) = \frac{2}{1 + e^{-2x}} – 1$

- Caratteristiche: Gli output variano tra -1 e 1; centrata sullo zero.

- Caso d’Uso: Comunemente utilizzata negli strati nascosti delle reti neurali.

- Limite: Anch’essa soggetta al problema del gradiente che svanisce.

ReLU (Rectified Linear Unit)

- Equazione: $f(x) = \max(0, x)$

- Caratteristiche: Output zero per input negativi e lineare per input positivi.

- Caso d’Uso: Ampiamente utilizzata nel deep learning, in particolare nelle reti neurali convoluzionali.

- Limite: Può soffrire del problema del “dying ReLU” in cui i neuroni smettono di apprendere.

Leaky ReLU

- Equazione: $f(x) = \max(0.01x, x)$

- Caratteristiche: Consente un piccolo gradiente non nullo quando l’unità è inattiva.

- Caso d’Uso: Affronta il problema del dying ReLU consentendo una piccola pendenza per valori negativi.

Funzione Softmax

- Equazione: $f(x_i) = \frac{e^{x_i}}{\sum_{j} e^{x_j}}$

- Caratteristiche: Converte i logit in probabilità che sommano a 1.

- Caso d’Uso: Utilizzata nello strato di output delle reti neurali per problemi di classificazione multiclasse.

Funzione Swish

- Equazione: $f(x) = x \cdot \text{sigmoid}(x)$

- Caratteristiche: Liscia e non monotona, consente una migliore ottimizzazione e convergenza.

- Caso d’Uso: Spesso usata nei modelli deep learning all’avanguardia per prestazioni migliori rispetto a ReLU.

Applicazioni nell’IA e nel Deep Learning

Le funzioni di attivazione sono parte integrante di varie applicazioni di IA, tra cui:

- Classificazione delle Immagini: Funzioni come ReLU e Softmax sono fondamentali nelle reti neurali convoluzionali per l’elaborazione e la classificazione delle immagini.

- Elaborazione del Linguaggio Naturale: Le funzioni di attivazione aiutano ad apprendere schemi complessi nei dati testuali, permettendo ai modelli linguistici di generare testo simile a quello umano.

- Automazione IA: Nella robotica e nei sistemi automatizzati, le funzioni di attivazione facilitano i processi decisionali interpretando gli input dei dati sensoriali.

- Chatbot: Consentono ai modelli conversazionali di comprendere e rispondere efficacemente alle richieste degli utenti, apprendendo da schemi di input diversificati.

Sfide e Considerazioni

- Problema del Gradiente che Svanisce: Le funzioni Sigmoid e Tanh possono portare a gradienti molto piccoli, ostacolando il processo di apprendimento. Tecniche come l’uso di ReLU o sue varianti possono mitigare questo problema.

- Dying ReLU: Un problema significativo in cui i neuroni possono bloccarsi durante l’addestramento e smettere di apprendere. Leaky ReLU e altre forme modificate possono aiutare a risolvere questo problema.

- Costo Computazionale: Alcune funzioni, come sigmoid e softmax, sono computazionalmente intensive e potrebbero non essere adatte per applicazioni in tempo reale.

Domande frequenti

- Cos'è una funzione di attivazione nelle reti neurali?

Una funzione di attivazione è un'operazione matematica applicata all'output di un neurone, che introduce non linearità e consente alle reti neurali di apprendere schemi complessi oltre le semplici relazioni lineari.

- Perché le funzioni di attivazione sono importanti nell'IA e nel deep learning?

Le funzioni di attivazione permettono alle reti neurali di risolvere problemi complessi e non lineari, consentendo l'apprendimento di schemi intricati e rendendole cruciali per compiti come la classificazione delle immagini, l'elaborazione del linguaggio e l'automazione.

- Quali sono i principali tipi di funzioni di attivazione?

I tipi più comuni includono Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax e Swish, ognuno con caratteristiche e casi d'uso specifici nei diversi strati delle reti neurali.

- Quali sfide sono associate alle funzioni di attivazione?

Le sfide comuni includono il problema del gradiente che svanisce (soprattutto con Sigmoid e Tanh), il dying ReLU e l'elevato costo computazionale di funzioni come Softmax nelle applicazioni in tempo reale.

Pronto a creare la tua IA?

Chatbot intelligenti e strumenti di IA sotto lo stesso tetto. Collega blocchi intuitivi per trasformare le tue idee in Flussi automatizzati.