BERT

BERT è un modello NLP rivoluzionario di Google che utilizza Transformer bidirezionali per permettere alle macchine di comprendere il linguaggio in modo contestuale, alimentando applicazioni IA avanzate.

Che cos’è BERT?

BERT, acronimo di Bidirectional Encoder Representations from Transformers, è un framework open-source di machine learning per l’elaborazione del linguaggio naturale (NLP). Sviluppato dai ricercatori di Google AI Language e presentato nel 2018, BERT ha rivoluzionato l’NLP permettendo alle macchine di comprendere il linguaggio in modo più simile agli esseri umani.

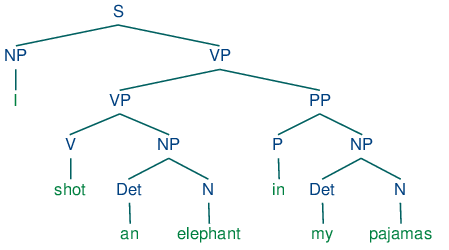

Alla base, BERT aiuta i computer a interpretare il significato di espressioni ambigue o dipendenti dal contesto, considerando le parole circostanti in una frase—sia prima che dopo la parola target. Questo approccio bidirezionale consente a BERT di cogliere tutte le sfumature del linguaggio, rendendolo estremamente efficace in molteplici compiti NLP.

Contesto e Storia di BERT

L’evoluzione dei modelli linguistici

Prima di BERT, la maggior parte dei modelli linguistici elaborava il testo in modo unidirezionale (da sinistra a destra o viceversa), limitando la capacità di cogliere il contesto.

Modelli precedenti come Word2Vec e GloVe generavano word embedding indipendenti dal contesto, assegnando a ogni parola un unico vettore indipendentemente dal contesto. Questo approccio faticava con parole polisemiche (es. “banca” come istituto finanziario vs. argine del fiume).

L’introduzione dei Transformer

Nel 2017, viene introdotta l’architettura Transformer nell’articolo “Attention Is All You Need”. I Transformer sono modelli di deep learning che usano il self-attention, permettendo di pesare dinamicamente l’importanza di ciascuna parte dell’input.

I Transformer hanno rivoluzionato l’NLP elaborando tutte le parole di una frase simultaneamente, abilitando l’addestramento su larga scala.

Sviluppo di BERT

I ricercatori di Google hanno costruito BERT sull’architettura Transformer, presentandolo nell’articolo del 2018 “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding”. L’innovazione di BERT è stata l’addestramento bidirezionale, considerando sia il contesto a sinistra che a destra.

BERT è stato pre-addestrato su tutta la Wikipedia inglese (2,5 miliardi di parole) e BookCorpus (800 milioni di parole), acquisendo una profonda comprensione di pattern, sintassi e semantica.

Architettura di BERT

Panoramica

BERT è uno stack di encoder dell’architettura Transformer (utilizza solo l’encoder, non il decoder). È composto da più livelli (12 o 24 blocchi Transformer), ciascuno con self-attention e reti neurali feed-forward.

Tokenizzazione ed Embedding

BERT utilizza la tokenizzazione WordPiece, suddividendo le parole in unità sub-word per gestire parole rare o fuori vocabolario.

Ogni token in input è rappresentato dalla somma di tre embedding:

- Token Embedding: Token individuali (parole o sub-word).

- Segment Embedding: Indicano se un token appartiene alla frase A o B.

- Position Embedding: Forniscono informazioni sulla posizione di ciascun token.

Questi aiutano BERT a comprendere sia la struttura sia la semantica.

Meccanismo di Self-Attention

Il self-attention permette a BERT di pesare l’importanza di ciascun token rispetto a tutti gli altri nella sequenza, cogliendo dipendenze indipendentemente dalla distanza.

Ad esempio, in “La banca ha aumentato i tassi di interesse,” il self-attention aiuta BERT a collegare “banca” a “tassi di interesse”, comprendendo “banca” come istituto finanziario.

Addestramento Bidirezionale

L’addestramento bidirezionale di BERT consente di cogliere il contesto da entrambe le direzioni. Questo avviene tramite due obiettivi di training:

- Masked Language Modeling (MLM): Oscura casualmente alcuni token in input e allena BERT a prevederli in base al contesto.

- Next Sentence Prediction (NSP): Allena BERT a prevedere se la frase B segue la frase A, aiutando a comprendere le relazioni tra frasi.

Come funziona BERT

Masked Language Modeling (MLM)

Nel MLM, BERT seleziona casualmente il 15% dei token per una possibile sostituzione:

- 80% sostituiti con

[MASK] - 10% sostituiti con un token casuale

- 10% lasciati invariati

Questa strategia favorisce una comprensione più profonda della lingua.

Esempio:

- Originale: “The quick brown fox jumps over the lazy dog.”

- Mascherato: “The quick brown

[MASK]jumps over the lazy[MASK].” - Il modello prevede “fox” e “dog”.

Next Sentence Prediction (NSP)

L’NSP aiuta BERT a comprendere le relazioni tra frasi.

- 50% delle volte, la frase B è la vera frase successiva.

- 50% delle volte, la frase B è casuale dal corpus.

Esempi:

- Frase A: “La pioggia cadeva copiosamente.”

- Frase B: “Lei ha preso l’ombrello.” → “IsNext”

- Frase B: “Mi piace giocare a scacchi.” → “NotNext”

Fine-Tuning per Task Specifici

Dopo il pretraining, BERT viene affinato su compiti NLP specifici aggiungendo layer di output. Il fine-tuning richiede meno dati e potenza di calcolo rispetto all’addestramento da zero.

Come viene utilizzato BERT

BERT alimenta molti compiti NLP, spesso raggiungendo risultati all’avanguardia.

Analisi del Sentiment

BERT può classificare il sentiment (es. recensioni positive/negative) con grande finezza.

- Esempio: L’e-commerce usa BERT per analizzare le recensioni e migliorare i prodotti.

Question Answering

BERT capisce le domande e fornisce risposte in base al contesto.

- Esempio: Un chatbot usa BERT per rispondere a “Qual è la politica di reso?” facendo riferimento ai documenti di policy.

Named Entity Recognition (NER)

Il NER identifica e classifica entità chiave (nomi, organizzazioni, date).

- Esempio: Gli aggregatori di notizie estraggono entità per consentire agli utenti ricerche tematiche.

Traduzione Automatica

Anche se non è pensato per la traduzione, la profonda comprensione linguistica di BERT supporta la traduzione combinato con altri modelli.

Sintesi del Testo

BERT può generare riassunti concisi individuando i concetti chiave.

- Esempio: Studi legali riassumono contratti per accesso rapido alle informazioni.

Generazione e Completamento del Testo

BERT predice parole o sequenze mascherate, aiutando la generazione di testo.

- Esempio: I client email suggeriscono la parola successiva durante la digitazione.

Esempi di casi d’uso

Google Search

Nel 2019 Google ha iniziato a usare BERT per migliorare gli algoritmi di ricerca, comprendendo meglio il contesto e l’intento delle query.

Esempio:

- Query di ricerca: “Can you get medicine for someone pharmacy?”

- Con BERT: Google comprende che l’utente sta chiedendo se può ritirare farmaci per qualcun altro.

Automazione IA e Chatbot

BERT alimenta i chatbot, migliorando la comprensione degli input degli utenti.

- Esempio: I chatbot di supporto clienti usano BERT per gestire domande complesse senza intervento umano.

Applicazioni in ambito sanitario

Modelli BERT specializzati come BioBERT elaborano testi biomedici.

- Esempio: I ricercatori usano BioBERT per drug discovery e analisi della letteratura scientifica.

Analisi di documenti legali

I professionisti legali usano BERT per analizzare e riassumere testi giuridici.

- Esempio: Gli studi legali identificano più velocemente clausole di responsabilità con BERT.

Varianti ed estensioni di BERT

Esistono diverse varianti di BERT per efficienza o domini specifici:

- DistilBERT: Più piccolo, veloce e leggero, con il 95% delle prestazioni di BERT usando il 40% di parametri in meno.

Uso: Ambienti mobile. - TinyBERT: Ancora più compatto, riduce dimensioni e tempi di inferenza.

- RoBERTa: Addestrato con batch più grandi e più dati, senza NSP, ottenendo prestazioni superiori.

- BioBERT: Pre-addestrato su testi biomedici per l’NLP in ambito sanitario.

- PatentBERT: Ottimizzato per classificazione di brevetti.

- SciBERT: Adattato per testi scientifici.

- VideoBERT: Integra dati visivi e testuali per la comprensione di video.

BERT in IA, Automazione IA e Chatbot

Potenziamento delle applicazioni IA

La comprensione contestuale di BERT alimenta numerose applicazioni IA:

- Migliore comprensione del linguaggio: Interpreta il testo con sfumature e contesto.

- Efficienza nel transfer learning: Modelli pre-addestrati da affinare con pochi dati.

- Versatilità: Riduce la necessità di modelli specifici per compito.

Impatto sui chatbot

BERT ha notevolmente migliorato la qualità di chatbot e automazione IA.

Esempi:

- Supporto clienti: I chatbot comprendono e rispondono in modo accurato.

- Assistenti virtuali: Migliore riconoscimento e risposta ai comandi.

- Bot di traduzione linguistica: Mantiene contesto e accuratezza.

Automazione IA

BERT consente l’automazione IA nell’elaborazione di grandi volumi di testo senza intervento umano.

Casi d’uso:

- Elaborazione documentale: Smistamento, tagging e sintesi automatizzati.

- Moderazione dei contenuti: Identificazione di contenuti inappropriati.

- Reportistica automatizzata: Estrazione di informazioni chiave per i report.

Ricerca su BERT

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

Autori: Jacob Devlin, Ming-Wei Chang, Kenton Lee, Kristina Toutanova

Presenta l’architettura di BERT e l’efficacia su diversi benchmark, consentendo la condizionamento congiunto sia del contesto a sinistra che a destra.

Leggi di piùMulti-Task Bidirectional Transformer Representations for Irony Detection

Autori: Chiyu Zhang, Muhammad Abdul-Mageed

Applica BERT al rilevamento dell’ironia, sfruttando il multi-task learning e il pretraining per l’adattamento ai domini. Raggiunge un F1 macro di 82.4.

Leggi di piùSketch-BERT: Learning Sketch Bidirectional Encoder Representation from Transformers by Self-supervised Learning of Sketch Gestalt

Autori: Hangyu Lin, Yanwei Fu, Yu-Gang Jiang, Xiangyang Xue

Introduce Sketch-BERT per il riconoscimento e il recupero di schizzi, applicando l’apprendimento auto-supervisionato e nuove reti di embedding.

Leggi di piùTransferring BERT Capabilities from High-Resource to Low-Resource Languages Using Vocabulary Matching

Autore: Piotr Rybak

Propone il vocabulary matching per adattare BERT a lingue a bassa risorsa, democratizzando la tecnologia NLP.

Leggi di più

Domande frequenti

- Cos’è BERT?

BERT (Bidirectional Encoder Representations from Transformers) è un framework open-source di machine learning per l’elaborazione del linguaggio naturale, sviluppato da Google AI nel 2018. Permette alle macchine di comprendere il linguaggio in modo contestuale considerando il contesto da entrambi i lati di una parola tramite l’architettura Transformer.

- In cosa BERT si differenzia dai precedenti modelli linguistici?

A differenza dei precedenti modelli unidirezionali, BERT elabora il testo in modo bidirezionale, riuscendo così a cogliere il contesto completo di una parola guardando sia le parole precedenti sia quelle successive. Questo porta a una comprensione più profonda delle sfumature linguistiche, migliorando le prestazioni in vari compiti NLP.

- Quali sono le principali applicazioni di BERT?

BERT è ampiamente utilizzato per l’analisi del sentiment, question answering, riconoscimento di entità nominate, traduzione automatica, sintesi del testo, generazione di testo e per potenziare chatbot IA e sistemi di automazione.

- Quali sono alcune varianti importanti di BERT?

Le varianti più note di BERT includono DistilBERT (una versione più leggera), TinyBERT (ottimizzato per velocità e dimensioni), RoBERTa (con pretraining ottimizzato), BioBERT (per testi biomedici) e modelli specifici di settore come PatentBERT e SciBERT.

- Come viene addestrato BERT?

BERT viene pre-addestrato utilizzando il Masked Language Modeling (MLM), in cui alcune parole casuali vengono oscurate e previste, e il Next Sentence Prediction (NSP), dove il modello apprende la relazione tra coppie di frasi. Dopo il pretraining, viene affinato su compiti NLP specifici con livelli aggiuntivi.

- Che impatto ha avuto BERT su chatbot IA e automazione?

BERT ha notevolmente migliorato la comprensione contestuale dei chatbot IA e degli strumenti di automazione, consentendo risposte più accurate, un migliore supporto clienti e una gestione avanzata dei documenti con minimo intervento umano.

Pronto a creare la tua IA?

Chatbot intelligenti e strumenti IA sotto lo stesso tetto. Collega blocchi intuitivi per trasformare le tue idee in Flussi automatizzati.