Vettore di Embedding

Un vettore di embedding rappresenta numericamente i dati in uno spazio multidimensionale, consentendo ai sistemi IA di catturare relazioni semantiche per compiti come classificazione, clustering e raccomandazioni.

Un vettore di embedding è una rappresentazione numerica densa dei dati in cui ogni elemento di dato viene mappato a un punto in uno spazio multidimensionale. Questa mappatura serve a catturare le informazioni semantiche e le relazioni contestuali fra i diversi dati. I punti dati simili sono collocati più vicini in questo spazio, facilitando compiti come classificazione, clustering e raccomandazione.

Definizione dei vettori di embedding

I vettori di embedding sono essenzialmente array di numeri che racchiudono le proprietà intrinseche e le relazioni dei dati che rappresentano. Traducendo tipi di dati complessi in questi vettori, i sistemi IA possono eseguire varie operazioni in modo più efficiente.

Importanza e applicazioni

I vettori di embedding sono alla base di molte applicazioni di IA e ML. Semplificano la rappresentazione di dati ad alta dimensione, rendendo più semplice la loro analisi e interpretazione.

1. Elaborazione del Linguaggio Naturale (NLP)

- Word Embeddings: Tecniche come Word2Vec e GloVe convertono le singole parole in vettori, catturando relazioni semantiche e informazioni contestuali.

- Sentence Embeddings: Modelli come Universal Sentence Encoder (USE) generano vettori per intere frasi, racchiudendone significato e contesto.

- Document Embeddings: Tecniche come Doc2Vec rappresentano interi documenti come vettori, catturandone il contenuto semantico e il contesto.

2. Elaborazione di Immagini

- Image Embeddings: Le reti neurali convoluzionali (CNN) e modelli pre-addestrati come ResNet generano vettori per le immagini, catturando diverse caratteristiche visive per compiti come classificazione e rilevamento oggetti.

3. Sistemi di Raccomandazione

- User Embeddings: Questi vettori rappresentano le preferenze e i comportamenti degli utenti, aiutando nelle raccomandazioni personalizzate.

- Product Embeddings: Vettori che catturano attributi e caratteristiche di un prodotto, facilitando il confronto e la raccomandazione dei prodotti.

Come vengono creati i vettori di embedding

La creazione dei vettori di embedding prevede diversi passaggi:

- Raccolta dati: Raccogli un ampio dataset pertinente al tipo di embedding che vuoi creare (ad esempio, testo, immagini).

- Preprocessing: Pulisci e prepara i dati rimuovendo rumore, normalizzando il testo, ridimensionando le immagini, ecc.

- Selezione del modello: Scegli un modello di rete neurale adatto ai tuoi dati.

- Training: Allena il modello sul dataset, permettendo di apprendere pattern e relazioni.

- Generazione dei vettori: Durante l’apprendimento, il modello genera vettori numerici che rappresentano i dati.

- Valutazione: Valuta la qualità degli embedding misurandone la performance su compiti specifici o tramite valutazione umana.

Tipi di vettori di embedding

- Word Embeddings: Catturano il significato delle singole parole.

- Sentence Embeddings: Rappresentano intere frasi.

- Document Embeddings: Rappresentano testi lunghi come articoli o libri.

- Image Embeddings: Catturano caratteristiche visive delle immagini.

- User Embeddings: Rappresentano preferenze e comportamenti degli utenti.

- Product Embeddings: Catturano attributi e caratteristiche dei prodotti.

Generare vettori di embedding

La libreria Transformers di Huggingface offre modelli all’avanguardia come BERT, RoBERTa e GPT-3. Questi modelli sono pre-addestrati su vasti dataset e forniscono embedding di alta qualità che possono essere ulteriormente ottimizzati per compiti specifici, rendendoli ideali per la creazione di applicazioni NLP robuste.

Installare Huggingface Transformers

Per prima cosa, assicurati di avere installato la libreria transformers nel tuo ambiente Python. Puoi installarla tramite pip:

pip install transformers

Caricare un modello pre-addestrato

Successivamente, carica un modello pre-addestrato dall’hub dei modelli di Huggingface. In questo esempio useremo BERT.

from transformers import BertModel, BertTokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

Tokenizzazione del testo

Tokenizza il tuo testo di input per prepararlo al modello.

inputs = tokenizer("Hello, Huggingface!", return_tensors='pt')

Generazione dei vettori di embedding

Passa il testo tokenizzato attraverso il modello per ottenere gli embedding.

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

4. Esempio: Generare vettori di embedding con BERT

Ecco un esempio completo che mostra i passaggi appena descritti:

from transformers import BertModel, BertTokenizer

# Carica il modello BERT pre-addestrato e il tokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

# Tokenizza il testo di input

text = "Hello, Huggingface!"

inputs = tokenizer(text, return_tensors='pt')

# Genera i vettori di embedding

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

print(embedding_vectors)

Consigli e buone pratiche

- Usa la GPU: Per dataset di grandi dimensioni, sfrutta l’accelerazione GPU per velocizzare la generazione degli embedding.

- Elaborazione a blocchi: Processa più frasi in batch per migliorare l’efficienza.

- Fine-tuning del modello: Ottimizza i modelli pre-addestrati sul tuo dataset specifico per ottenere performance migliori.

Problemi comuni e risoluzione

- Problemi di memoria: Se incontri errori di memoria, prova a ridurre la dimensione del batch o usa un modello più leggero.

- Errori di tokenizzazione: Assicurati che il testo sia tokenizzato correttamente per evitare errori di dimensione.

- Compatibilità del modello: Verifica che tokenizer e modello siano compatibili tra loro.

Visualizzazione dei vettori di embedding

Tecniche di riduzione della dimensionalità

SNE (Stochastic Neighbor Embedding)

SNE è un metodo precoce di riduzione della dimensionalità, sviluppato da Geoffrey Hinton e Sam Roweis. Funziona calcolando le similarità tra coppie di punti nello spazio ad alta dimensione e cerca di preservare queste similarità in uno spazio a dimensione ridotta.

t-SNE (t-distributed Stochastic Neighbor Embedding)

Evoluzione di SNE, t-SNE è ampiamente usato per visualizzare dati ad alta dimensione. Minimizza la divergenza tra due distribuzioni: una che rappresenta le similarità tra coppie di punti nello spazio originale e l’altra nello spazio ridotto, utilizzando una distribuzione t di Student a coda pesante.

UMAP (Uniform Manifold Approximation and Projection)

UMAP è una tecnica più recente che offre calcolo più veloce e migliore conservazione della struttura globale rispetto a t-SNE. Costruisce un grafo ad alta dimensione e ne ottimizza uno a bassa dimensione per renderli il più simili possibile.

Strumenti e librerie

Diversi strumenti e librerie facilitano la visualizzazione dei vettori di embedding:

- Matplotlib e Seaborn: Utilizzati comunemente per il plotting e la visualizzazione dei dati in Python.

- t-SNE in Python: Disponibile in librerie come Scikit-learn e TensorFlow.

- UMAP: Implementato come libreria standalone in Python.

Domande frequenti

- Cos'è un vettore di embedding?

Un vettore di embedding è una rappresentazione numerica densa dei dati, che assegna a ciascun dato una posizione in uno spazio multidimensionale per catturare relazioni semantiche e contestuali.

- Come vengono usati i vettori di embedding nell’IA?

I vettori di embedding sono fondamentali nell’IA per semplificare dati complessi, abilitando compiti come classificazione del testo, riconoscimento di immagini e raccomandazioni personalizzate.

- Come posso generare vettori di embedding?

I vettori di embedding possono essere generati utilizzando modelli pre-addestrati come BERT della libreria Huggingface Transformers. Tokenizzando i tuoi dati e passandoli attraverso questi modelli, ottieni embedding di alta qualità per ulteriori analisi.

- Quali sono alcune tecniche per visualizzare i vettori di embedding?

Tecniche di riduzione della dimensionalità come t-SNE e UMAP sono comunemente usate per visualizzare vettori di embedding ad alta dimensione, aiutando a interpretare e analizzare i pattern nei dati.

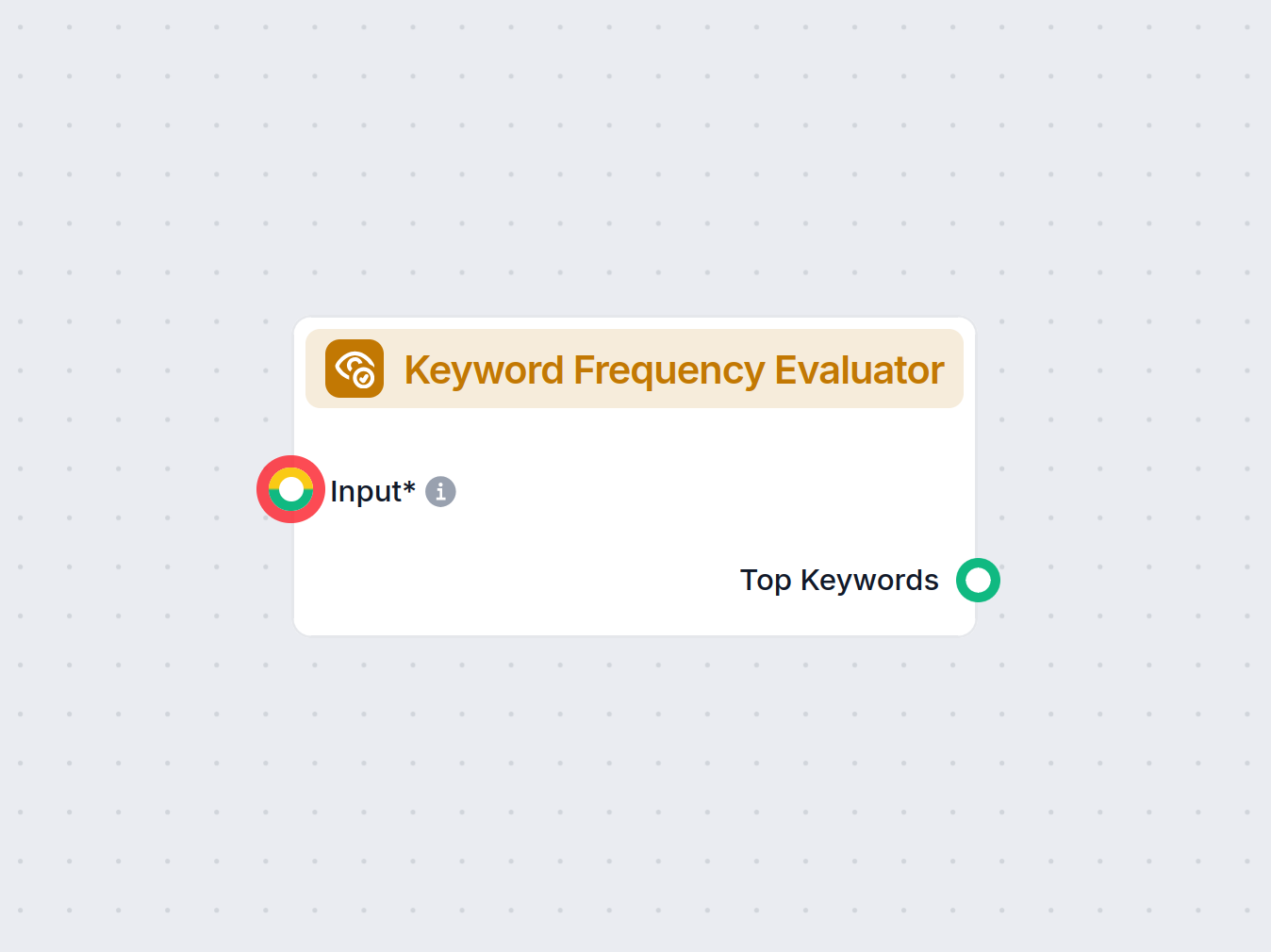

Costruisci soluzioni IA con FlowHunt

Inizia a creare i tuoi strumenti di IA e chatbot con la piattaforma no-code di FlowHunt. Trasforma facilmente le tue idee in Flows automatizzati.