Errore di Addestramento

L’errore di addestramento misura quanto bene un modello IA si adatta ai suoi dati di addestramento, ma un errore basso da solo non garantisce buone prestazioni nel mondo reale.

L’errore di addestramento, nel contesto dell’intelligenza artificiale (IA) e del machine learning, si riferisce alla discrepanza tra le previsioni di un modello e i risultati effettivi durante la fase di addestramento del modello. È una metrica fondamentale che misura quanto bene un modello sta performando sul dataset su cui è stato addestrato. L’errore di addestramento viene calcolato come la perdita media sui dati di addestramento, spesso espressa in percentuale o come valore numerico. Fornisce un’indicazione della capacità del modello di apprendere dai dati di addestramento.

L’errore di addestramento è un concetto essenziale nel machine learning, poiché riflette la capacità del modello di cogliere i pattern nei dati di addestramento. Tuttavia, un errore di addestramento basso non implica necessariamente che il modello si comporterà bene su dati non visti, motivo per cui è fondamentale considerarlo insieme ad altre metriche come l’errore di test.

Caratteristiche Chiave

- Errore di Addestramento Basso: Indica che il modello si adatta bene ai dati di addestramento. Tuttavia, questo non è sempre auspicabile, poiché potrebbe suggerire overfitting, ovvero che il modello coglie anche il rumore assieme ai pattern sottostanti nei dati di addestramento. L’overfitting può portare a una scarsa generalizzazione su nuovi dati, che rappresenta una sfida significativa nello sviluppo di modelli IA robusti.

- Errore di Addestramento Alto: Suggerisce che il modello è troppo semplice e non riesce a cogliere i pattern sottostanti nei dati, situazione nota come underfitting. L’underfitting può verificarsi quando un modello non è abbastanza complesso per rappresentare accuratamente i dati, portando sia a errori di addestramento che di test elevati.

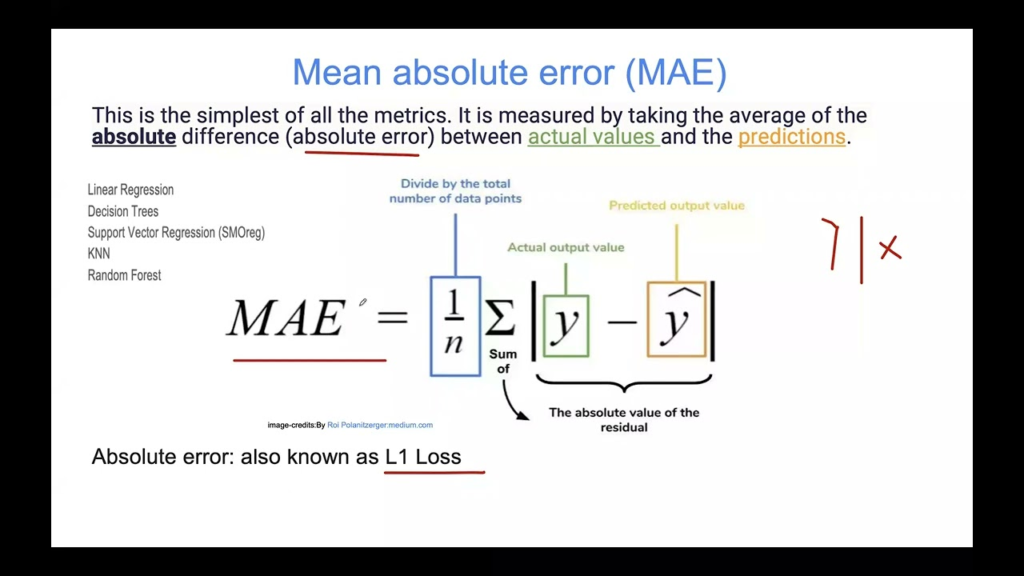

- Calcolo: Comunemente calcolato con metriche come l’Errore Quadratico Medio (MSE), la Radice dell’Errore Quadratico Medio (RMSE) o il tasso di errore di classificazione (1 – accuratezza). Queste metriche forniscono una valutazione quantitativa delle prestazioni del modello sui dati di addestramento, aiutando a identificare potenziali problemi durante lo sviluppo del modello.

Importanza dell’Errore di Addestramento nella Valutazione del Modello

L’errore di addestramento è cruciale per comprendere quanto efficacemente un modello di machine learning sta imparando dai dati in ingresso. Tuttavia, non è una misura sufficiente delle prestazioni del modello se interpretata senza contesto. Deve essere sempre considerata insieme all’errore di test per valutare la capacità di generalizzazione del modello su nuovi dati.

La relazione tra errore di addestramento ed errore di test può essere visualizzata tramite le learning curve, che mostrano come cambiano le prestazioni di un modello al variare della complessità. Analizzando queste curve, i data scientist possono identificare se un modello sta soffrendo di underfitting o overfitting e apportare le giuste modifiche per migliorarne la capacità di generalizzazione.

Overfitting e Underfitting

L’errore di addestramento è strettamente correlato ai concetti di overfitting e underfitting:

Overfitting: Si verifica quando il modello apprende troppo bene i dati di addestramento, cogliendo rumore e fluttuazioni come se fossero pattern reali. Questo porta spesso a un errore di addestramento basso ma un errore di test elevato. L’overfitting può essere mitigato utilizzando tecniche come pruning, cross-validation e regolarizzazione. Queste tecniche aiutano il modello a cogliere i veri pattern sottostanti senza adattarsi al rumore nei dati.

Underfitting: Accade quando il modello è troppo semplice per catturare la struttura sottostante dei dati, portando a errori di addestramento e di test entrambi elevati. Aumentare la complessità del modello o migliorare l’ingegnerizzazione delle feature può aiutare a ridurre l’underfitting. Migliorando la capacità del modello di rappresentare i dati, l’underfitting può essere limitato, portando a migliori prestazioni sia sui dati di addestramento che di test.

Errore di Addestramento vs. Errore di Test

L’errore di addestramento va confrontato con l’errore di test per valutare la capacità di generalizzazione di un modello. Mentre l’errore di addestramento misura le prestazioni sui dati già visti dal modello, l’errore di test valuta le prestazioni su dati non visti. Un piccolo divario tra questi errori suggerisce una buona generalizzazione, mentre un divario ampio indica overfitting.

Comprendere la differenza tra errore di addestramento ed errore di test è essenziale per costruire modelli che funzionino bene nelle applicazioni reali. Bilanciando questi errori, i data scientist possono sviluppare modelli non solo accurati sui dati di addestramento, ma anche affidabili su dati nuovi e mai visti prima.

Casi d’Uso ed Esempi

Caso d’Uso 1: Regressione Lineare

Un modello di regressione lineare addestrato per prevedere i prezzi delle case potrebbe mostrare un errore di addestramento basso ma un errore di test elevato se va in overfitting, cogliendo fluttuazioni minori come se fossero trend significativi. La regolarizzazione o la riduzione della complessità del modello possono aiutare a ottenere un migliore equilibrio tra errore di addestramento ed errore di test. Applicando queste tecniche, i data scientist possono migliorare la capacità del modello di generalizzare, garantendo previsioni più accurate in scenari reali.

Caso d’Uso 2: Alberi Decisionali

Nei modelli ad albero decisionale, l’errore di addestramento può essere minimizzato facendo crescere alberi più profondi che catturano ogni dettaglio nei dati di addestramento. Tuttavia, ciò porta spesso a overfitting, dove l’errore di test aumenta a causa di scarsa generalizzazione. Potare l’albero rimuovendo i rami con scarso potere predittivo può migliorare l’errore di test, anche se aumenta leggermente l’errore di addestramento. Ottimizzando la struttura dell’albero, i data scientist possono migliorare le prestazioni del modello sia sui dati di addestramento che di test.

Misurare l’Errore di Addestramento nella Pratica

Per misurare l’errore di addestramento nella pratica, considera i seguenti passaggi usando Scikit-learn in Python:

- Importa le librerie necessarie: Utilizza librerie come

DecisionTreeClassifiereaccuracy_scoredi Scikit-learn. - Prepara i dati: Suddividi il tuo dataset in feature (

X) e variabile target (y). - Addestra il modello: Allena il modello sui dati di addestramento.

- Fai previsioni: Usa il modello addestrato per prevedere le etichette sui dati di addestramento.

- Calcola l’errore di addestramento: Usa la funzione

accuracy_scoreper calcolare l’accuratezza, poi ottieni l’errore di addestramento come1 - accuratezza.

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score

# Supponendo che X_train e y_train siano definiti

clf = DecisionTreeClassifier()

clf.fit(X_train, y_train)

y_train_pred = clf.predict(X_train)

training_accuracy = accuracy_score(y_train, y_train_pred)

training_error = 1 - training_accuracy

print(f"Accuratezza Addestramento: {training_accuracy}")

print(f"Errore di Addestramento: {training_error}")

Questo approccio pratico consente ai data scientist di valutare quantitativamente l’errore di addestramento e prendere decisioni informate per migliorare il modello.

Comprendere il Compromesso Bias-Varianza

Il compromesso bias-varianza è un aspetto essenziale nell’addestramento dei modelli. Un bias elevato (underfitting) porta a un errore di addestramento alto, mentre un’elevata varianza (overfitting) comporta un errore di addestramento basso ma potenzialmente un errore di test elevato. Raggiungere un equilibrio è fondamentale per le prestazioni del modello.

Gestendo il compromesso bias-varianza, i data scientist possono sviluppare modelli che generalizzano bene su nuovi dati, garantendo prestazioni affidabili in varie applicazioni.

Sfide Comuni e Soluzioni

- Squilibrio dei dati: Assicurati che tutte le classi nel dataset siano sufficientemente rappresentate nei dati di addestramento per evitare bias. Tecniche come il resampling e l’uso di metriche di valutazione adeguate possono aiutare a risolvere questa sfida.

- Data Leakage: Evita di utilizzare informazioni dei dati di test durante la fase di addestramento per mantenere l’integrità del modello. È fondamentale separare rigorosamente i dati di addestramento da quelli di test per valutare accuratamente le prestazioni del modello.

- Outlier: Gestisci attentamente gli outlier poiché possono distorcere le prestazioni del modello, portando a valutazioni errate dell’errore di addestramento. Tecniche come la normalizzazione robusta e il rilevamento degli outlier possono aiutare a mitigare il problema.

- Data Drift: Monitora i dati nel tempo per assicurarti che il modello rimanga rilevante e aggiorna il modello se necessario per gestire cambiamenti nella distribuzione dei dati. Valutando continuamente le prestazioni, i data scientist possono mantenere l’accuratezza e l’affidabilità del modello nel tempo.

Ricerca sull’Errore di Addestramento nell’IA

- A Case for Backward Compatibility for Human-AI Teams

In questo studio, i ricercatori esplorano le dinamiche dei team uomo-IA, sottolineando l’importanza di comprendere le prestazioni dell’IA, inclusi i suoi errori. Il paper evidenzia il potenziale impatto negativo degli aggiornamenti dei sistemi IA sulla fiducia degli utenti e sulle prestazioni del team. Gli autori introducono il concetto di compatibilità degli aggiornamenti IA con l’esperienza utente e propongono un obiettivo di ri-addestramento che penalizza i nuovi errori per migliorare la compatibilità. Questo approccio mira a bilanciare il compromesso tra prestazioni e compatibilità degli aggiornamenti. Lo studio presenta risultati empirici che dimostrano come gli attuali algoritmi di machine learning spesso non producano aggiornamenti compatibili e suggerisce una soluzione per migliorare l’esperienza utente. Leggi di più. - Automation of Trimming Die Design Inspection by Zigzag Process Between AI and CAD Domains

Questo articolo affronta l’integrazione di moduli IA con software CAD per automatizzare l’ispezione dei progetti di stampi di tranciatura nell’industria manifatturiera. I moduli IA sostituiscono le ispezioni manuali svolte tradizionalmente dagli ingegneri, raggiungendo un’elevata accuratezza anche con dati di addestramento limitati. Lo studio riporta una significativa riduzione dei tempi di ispezione e degli errori, con un errore medio di misurazione di solo il 2,4%. Il processo prevede un’interazione a zigzag tra IA e CAD, offrendo un’operazione fluida “one-click” senza l’intervento di esperti. Questo approccio dimostra la capacità dell’IA di migliorare l’efficienza nei processi di controllo qualità. Leggi di più. - AI-based Arabic Language and Speech Tutor

Questa ricerca esplora l’uso di IA, machine learning e NLP per creare un ambiente di apprendimento adattivo per gli studenti di lingue. Il tutor basato su IA fornisce feedback dettagliati sugli errori, inclusa l’analisi linguistica e esercizi personalizzati per migliorare i risultati di apprendimento. Il sistema è progettato per insegnare il dialetto arabo marocchino e offre un approccio individualizzato all’addestramento della pronuncia. Le prime valutazioni mostrano risultati promettenti nel migliorare l’esperienza di apprendimento. Questo lavoro evidenzia il potenziale dell’IA nella tecnologia educativa, in particolare nell’acquisizione linguistica. Leggi di più.

Domande frequenti

- Cos’è l’errore di addestramento nel machine learning?

L’errore di addestramento è la differenza tra le previsioni di un modello e i risultati effettivi durante la fase di addestramento. Quantifica quanto bene il modello si adatta ai dati di addestramento.

- Perché l’errore di addestramento è importante?

Aiuta a valutare quanto bene un modello apprende dai dati su cui è stato addestrato, ma deve essere controllato insieme all’errore di test per evitare overfitting o underfitting.

- Come si calcola l’errore di addestramento?

L’errore di addestramento è solitamente calcolato come la perdita media sul dataset di addestramento usando metriche come l’Errore Quadratico Medio (MSE), la Radice dell’Errore Quadratico Medio (RMSE) o il tasso di errore di classificazione (1 – accuratezza).

- Qual è la differenza tra errore di addestramento ed errore di test?

L’errore di addestramento misura le prestazioni sui dati già visti dal modello, mentre l’errore di test misura le prestazioni su dati nuovi. Un piccolo divario indica buona generalizzazione; un grande divario indica overfitting.

- Come posso ridurre l’errore di addestramento?

Puoi ridurre l’errore di addestramento aumentando la complessità del modello, migliorando l’ingegnerizzazione delle feature o ottimizzando i parametri del modello. Tuttavia, ridurre troppo l’errore di addestramento può portare ad overfitting.

Pronto a creare la tua IA?

Chatbot intelligenti e strumenti IA sotto lo stesso tetto. Collega blocchi intuitivi per trasformare le tue idee in Flows automatizzati.