Incorporamenti di Parole

Gli incorporamenti di parole mappano le parole in vettori in uno spazio continuo, catturandone il significato e il contesto per applicazioni NLP migliorate.

Elaborazione del Linguaggio Naturale (NLP) - Incorporamenti

Gli incorporamenti di parole sono fondamentali nella NLP, fungendo da ponte nell’interazione uomo-computer. Scopri i suoi aspetti chiave, il funzionamento e le applicazioni oggi stesso!") per diversi motivi:

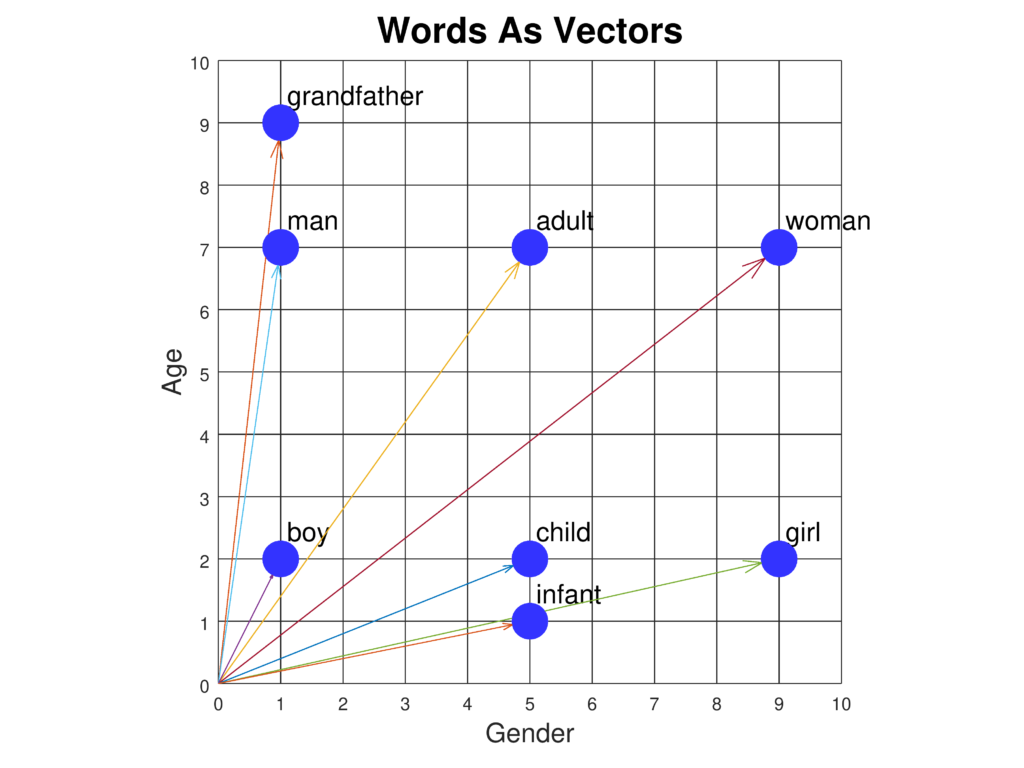

- Comprensione Semantica: Permettono ai modelli di catturare il significato delle parole e le loro relazioni reciproche, consentendo una comprensione più sfumata del linguaggio. Ad esempio, gli incorporamenti possono cogliere analogie come “re sta a regina come uomo sta a donna.”

- Riduzione della Dimensionalità: Rappresentare le parole in uno spazio denso e a bassa dimensionalità riduce il carico computazionale e migliora l’efficienza nell’elaborazione di grandi vocabolari.

- Transfer Learning: Gli incorporamenti pre-addestrati possono essere utilizzati in diversi compiti NLP, riducendo la necessità di grandi quantità di dati e risorse computazionali specifiche per il compito.

- Gestione di Grandi Vocabolari: Gestiscono in modo efficiente vocabolari vasti e trattano meglio le parole rare, migliorando le prestazioni del modello su dataset eterogenei.

Concetti e Tecniche Chiave

- Rappresentazioni Vettoriali: Le parole vengono trasformate in vettori in uno spazio ad alta dimensionalità. La vicinanza e la direzione tra questi vettori indicano la similarità semantica e le relazioni tra le parole.

- Significato Semantico: Gli incorporamenti racchiudono l’essenza semantica delle parole, permettendo ai modelli di eseguire analisi del sentiment, riconoscimento di entità e traduzione automatica con maggiore accuratezza.

- Riduzione della Dimensionalità: Condensando dati ad alta dimensionalità in formati più gestibili, gli incorporamenti migliorano l’efficienza computazionale dei modelli NLP.

- Reti Neurali: Molti incorporamenti sono generati tramite reti neurali, come nei modelli Word2Vec e GloVe, che apprendono da ampi corpora di testo.

Tecniche Comuni di Incorporamento di Parole

- Word2Vec: Sviluppata da Google, questa tecnica utilizza modelli come Continuous Bag of Words (CBOW) e Skip-gram per prevedere una parola in base al suo contesto o viceversa.

- GloVe (Global Vectors for Word Representation): Utilizza statistiche di co-occorrenza globale delle parole per derivare gli incorporamenti, enfatizzando le relazioni semantiche tramite fattorizzazione di matrici.

- FastText: Migliora Word2Vec incorporando informazioni sui sottoparole (n-grammi di caratteri), consentendo una gestione migliore delle parole rare e di quelle fuori vocabolario.

- TF-IDF (Term Frequency-Inverse Document Frequency): Un metodo basato sulla frequenza che enfatizza le parole significative in un documento rispetto a un corpus, pur mancando della profondità semantica degli incorporamenti neurali.

Casi d’Uso nella NLP

- Classificazione del Testo: Gli incorporamenti migliorano la classificazione del testo fornendo ricche rappresentazioni semantiche, aumentando l’accuratezza dei modelli in compiti come analisi del sentiment e rilevamento dello spam.

- Traduzione Automatica: Facilitano la traduzione tra lingue catturando le relazioni semantiche, essenziali per sistemi come Google Translate.

- Riconoscimento di Entità Nominate (NER): Aiutano a identificare e classificare entità come nomi, organizzazioni e luoghi comprendendo contesto e semantica.

- Recupero di Informazioni e Ricerca: Migliorano i motori di ricerca catturando le relazioni semantiche, consentendo risultati più pertinenti e sensibili al contesto.

- Sistemi di Domanda-Risposta: Migliorano la comprensione delle domande e del contesto, portando a risposte più accurate e rilevanti.

Sfide e Limiti

- Polisemia: Gli incorporamenti classici hanno difficoltà con parole che hanno più significati. Gli incorporamenti contestuali come BERT mirano a risolvere questo problema fornendo vettori diversi in base al contesto.

- Bias nei Dati di Addestramento: Gli incorporamenti possono perpetuare bias presenti nei dati di addestramento, influenzando l’equità e l’accuratezza delle applicazioni.

- Scalabilità: L’addestramento degli incorporamenti su grandi corpora richiede risorse computazionali ingenti, anche se tecniche come i sottoparole e la riduzione della dimensionalità possono alleviare questo problema.

Modelli Avanzati e Sviluppi

- BERT (Bidirectional Encoder Representations from Transformers): Un modello basato su transformer che genera incorporamenti contestuali delle parole considerando l’intero contesto della frase, offrendo prestazioni superiori su numerosi compiti NLP.

- GPT (Generative Pre-trained Transformer): Si focalizza sulla produzione di testo coerente e contestualmente rilevante, utilizzando incorporamenti per comprendere e generare testo simile a quello umano.

Ricerche sugli Incorporamenti di Parole nella NLP

Learning Word Sense Embeddings from Word Sense Definitions

Qi Li, Tianshi Li, Baobao Chang (2016) propongono un metodo per affrontare la sfida delle parole polisemiche e omonime negli incorporamenti, creando un incorporamento per ogni senso della parola utilizzando le definizioni dei sensi. Il loro approccio sfrutta l’addestramento basato su corpus per ottenere incorporamenti di alta qualità per i sensi delle parole. I risultati sperimentali mostrano miglioramenti nei compiti di similarità delle parole e disambiguazione dei sensi. Lo studio dimostra il potenziale degli incorporamenti per senso nell’ottimizzare le applicazioni NLP. Leggi di piùNeural-based Noise Filtering from Word Embeddings

Kim Anh Nguyen, Sabine Schulte im Walde, Ngoc Thang Vu (2016) introducono due modelli per migliorare gli incorporamenti di parole attraverso il filtraggio del rumore. Identificano informazioni superflue negli incorporamenti tradizionali e propongono tecniche di apprendimento non supervisionato per creare incorporamenti denoising. Questi modelli utilizzano una rete neurale deep feed-forward per potenziare le informazioni salienti riducendo il rumore. I risultati evidenziano prestazioni superiori degli incorporamenti denoising su compiti di benchmark. Leggi di piùA Survey On Neural Word Embeddings

Erhan Sezerer, Selma Tekir (2021) offrono una panoramica esaustiva sugli incorporamenti neurali di parole, tracciandone l’evoluzione e l’impatto sulla NLP. Il sondaggio copre le teorie di base ed esplora diversi tipi di incorporamenti, come quelli per senso, morfemici e contestuali. Il documento discute anche dataset di riferimento e valutazioni delle prestazioni, evidenziando l’effetto trasformativo degli incorporamenti neurali sulle attività NLP. Leggi di piùImproving Interpretability via Explicit Word Interaction Graph Layer

Arshdeep Sekhon, Hanjie Chen, Aman Shrivastava, Zhe Wang, Yangfeng Ji, Yanjun Qi (2023) si concentrano sul miglioramento dell’interpretabilità dei modelli NLP tramite WIGRAPH, un layer di rete neurale che costruisce un grafo globale di interazione tra le parole. Questo layer può essere integrato in qualsiasi classificatore di testo NLP, migliorando sia l’interpretabilità che le prestazioni predittive. Lo studio sottolinea l’importanza delle interazioni tra parole nella comprensione delle decisioni del modello. Leggi di piùWord Embeddings for Banking Industry

Avnish Patel (2023) esplora l’applicazione degli incorporamenti di parole nel settore bancario, evidenziandone il ruolo in compiti come analisi del sentiment e classificazione del testo. Lo studio esamina l’uso sia di incorporamenti statici (es. Word2Vec, GloVe) sia di modelli contestuali, sottolineando il loro impatto sui compiti NLP specifici del settore. Leggi di più

Domande frequenti

- Cosa sono gli incorporamenti di parole?

Gli incorporamenti di parole sono rappresentazioni vettoriali dense delle parole, che mappano parole semanticamente simili in punti vicini in uno spazio continuo, permettendo ai modelli di comprendere il contesto e le relazioni nel linguaggio.

- Come migliorano gli incorporamenti di parole i compiti NLP?

Migliorano i compiti NLP catturando le relazioni semantiche e sintattiche, riducendo la dimensionalità, abilitando il transfer learning e migliorando la gestione delle parole rare.

- Quali sono le tecniche comuni per creare incorporamenti di parole?

Le tecniche più diffuse includono Word2Vec, GloVe, FastText e TF-IDF. I modelli neurali come Word2Vec e GloVe apprendono gli incorporamenti da grandi corpora di testo, mentre FastText incorpora informazioni sui sottoparole.

- Quali sfide affrontano gli incorporamenti di parole?

Gli incorporamenti classici hanno difficoltà con la polisemia (parole con più significati), possono perpetuare bias nei dati e possono richiedere risorse computazionali significative per l’addestramento su grandi corpora.

- Come vengono utilizzati gli incorporamenti di parole nelle applicazioni reali?

Vengono utilizzati in classificazione del testo, traduzione automatica, riconoscimento di entità nominate, recupero di informazioni e sistemi di domanda-risposta per migliorare accuratezza e comprensione contestuale.

Prova FlowHunt per Soluzioni NLP

Inizia a costruire soluzioni AI avanzate con strumenti intuitivi per NLP, inclusi incorporamenti di parole e altro ancora.