Chat MCP Server

Un client MCP pulito ed educativo per interagire con più LLM tramite un’interfaccia chat desktop unificata, perfetto per apprendimento, prototipazione e sviluppo.

Cosa fa il server MCP “Chat MCP”?

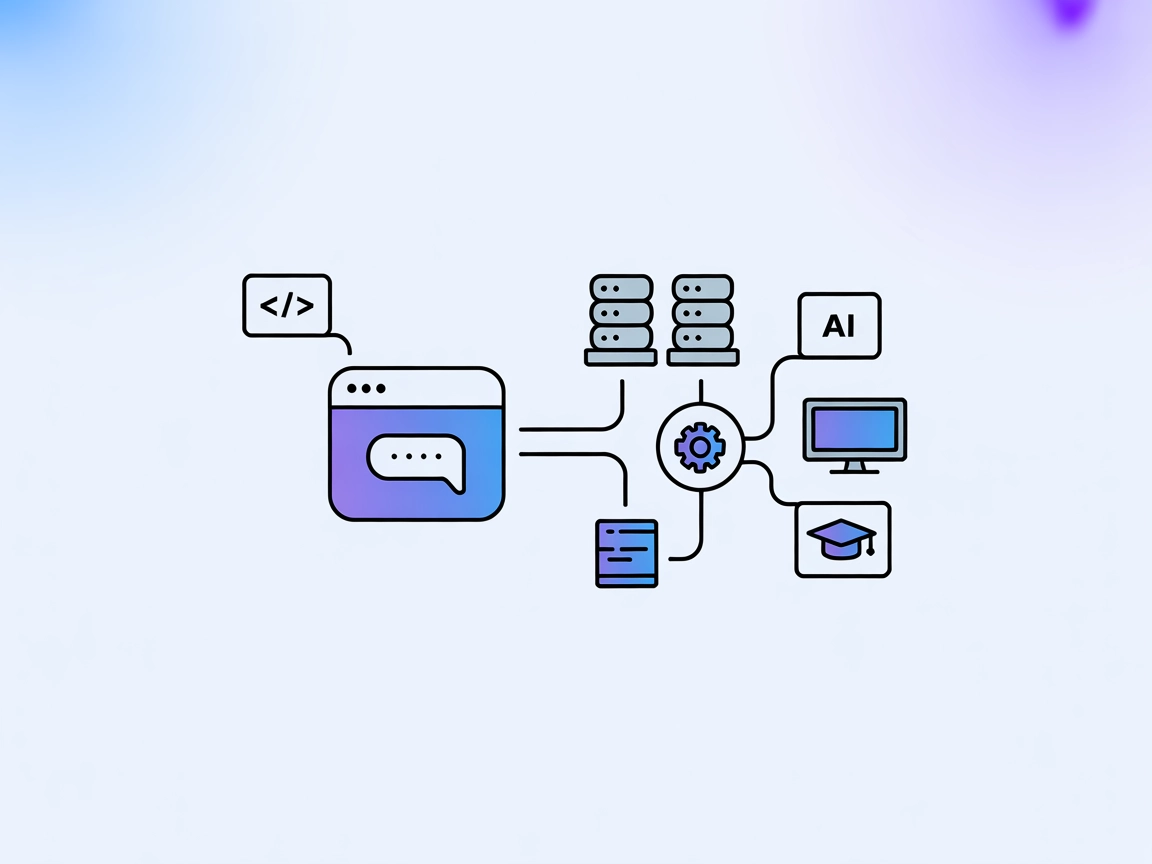

Chat MCP è un’applicazione desktop di chat che sfrutta il Model Context Protocol (MCP) per interfacciarsi con diversi Large Language Models (LLM). Costruito con Electron per la compatibilità multipiattaforma, Chat MCP permette agli utenti di connettersi e gestire diversi backend LLM, fornendo un’interfaccia unificata per testare, interagire e configurare vari modelli AI. Il suo codice minimalista è pensato per aiutare sviluppatori e ricercatori a comprendere i principi fondamentali di MCP, prototipare rapidamente con diversi server e semplificare i flussi di lavoro che coinvolgono LLM. Le caratteristiche chiave includono la configurazione dinamica degli LLM, la gestione multi-client e l’adattabilità sia per desktop che per ambienti web.

Elenco dei Prompt

Nessun template di prompt è menzionato nella documentazione o nei file del repository disponibili.

Elenco delle Risorse

Nessuna risorsa MCP esplicita è documentata nel repository o negli esempi di configurazione.

Elenco degli Strumenti

Nessuno strumento specifico è elencato o descritto all’interno del repository o in server.py (il repo non contiene un file server.py né definizioni equivalenti di strumenti).

Casi d’uso di questo server MCP

Piattaforma Unificata di Test LLM

Chat MCP consente agli sviluppatori di configurare e testare rapidamente diversi provider e modelli LLM in un’unica interfaccia, semplificando il processo di valutazione.Applicazione Chat AI Multipiattaforma

Supportando Linux, macOS e Windows, Chat MCP può essere utilizzato come client chat desktop per interagire con modelli AI su tutti i principali sistemi operativi.Sviluppo e Debug di Integrazioni MCP

Grazie al codice pulito, gli sviluppatori possono usare Chat MCP come riferimento o punto di partenza per costruire o fare debug alle proprie applicazioni compatibili MCP.Strumento Didattico per MCP

L’approccio minimalista del progetto lo rende ideale per imparare il Model Context Protocol e sperimentare la connettività con LLM.

Come configurarlo

Windsurf

- Installa Node.js: Scarica e installa Node.js da nodejs.org.

- Clona il repository:

git clone https://github.com/AI-QL/chat-mcp.git - Modifica la configurazione:

Modificasrc/main/config.jsoncon i tuoi dettagli API LLM e impostazioni MCP. - Installa le dipendenze:

npm install - Avvia l’app:

npm start

Esempio di configurazione JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://api.aiql.com",

"path": "/v1/chat/completions",

"model": "gpt-4o-mini",

"mcp": true

}

}

Nota: Proteggi le tue chiavi API utilizzando variabili di ambiente o storage cifrato (non direttamente supportato nella configurazione fornita, ma raccomandato).

Claude

- Installa Node.js: Ottieni Node.js da nodejs.org.

- Scarica/clona Chat MCP.

- Modifica

src/main/config.jsoncon endpoint e dettagli API compatibili Claude. - Esegui

npm install. - Avvia con

npm start.

Esempio JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://anthropic.api.endpoint",

"path": "/v1/messages",

"model": "claude-3-opus",

"mcp": true

}

}

Nota: Usa variabili di ambiente per dati sensibili.

Cursor

- Installa Node.js.

- Clona il repository Chat MCP.

- Aggiorna

src/main/config.jsonper il backend Cursor. - Installa le dipendenze.

- Avvia l’applicazione.

Esempio JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://cursor.api.endpoint",

"path": "/v1/chat/completions",

"model": "cursor-model",

"mcp": true

}

}

Nota: Usa variabili di ambiente per le chiavi API.

Cline

- Installa Node.js.

- Clona il repository.

- Modifica

src/main/config.jsoncon i dettagli API di Cline. - Esegui

npm install. - Avvia con

npm start.

Esempio JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://cline.api.endpoint",

"path": "/v1/chat/completions",

"model": "cline-model",

"mcp": true

}

}

Nota: Proteggi le chiavi API tramite variabili di ambiente.

Esempio di protezione delle chiavi API:

{

"chatbotStore": {

"apiKey": "${API_KEY}",

"url": "https://api.example.com",

"path": "/v1/chat/completions",

"model": "your-model",

"mcp": true

}

}

Imposta API_KEY nel tuo ambiente prima di avviare l’app.

Come usare questo MCP all’interno dei flow

Utilizzare MCP in FlowHunt

Per integrare server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"chat-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI sarà in grado di utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “chat-mcp” con il vero nome del tuo server MCP e di sostituire la URL con quella del tuo server MCP.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP documentata |

| Elenco degli Strumenti | ⛔ | Nessuno strumento elencato |

| Protezione delle chiavi API | ✅ | Consigliata; non supportata nativamente, ma raccomandata |

| Supporto sampling (meno rilevante in valutazione) | ⛔ | Nessuna menzione di supporto sampling |

In base alle informazioni disponibili, Chat MCP è un client MCP semplice, educativo e flessibile, ma manca di funzionalità MCP avanzate (strumenti, risorse, sampling, roots) nella documentazione e setup pubblici. Il suo valore principale è essere un front-end chat pulito e facilmente modificabile. Nel complesso, è un buon punto di partenza per imparare MCP o come base per integrazioni più avanzate.

MCP Score

| Ha una LICENSE | ✅ Apache-2.0 |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 31 |

| Numero di Stelle | 226 |

Domande frequenti

- Cos'è Chat MCP?

Chat MCP è un'app desktop di chat multipiattaforma costruita con Electron, progettata per connettersi a diversi backend LLM utilizzando il Model Context Protocol (MCP). Fornisce un'interfaccia unificata per il prototipaggio, il test e la configurazione degli LLM.

- Quali sono i principali casi d'uso di Chat MCP?

Chat MCP è ideale per testare LLM, effettuare il debug di integrazioni MCP, imparare i principi MCP e come implementazione di riferimento pulita o base per strumenti di chat più avanzati.

- Come proteggo le mie chiavi API in Chat MCP?

Sebbene la configurazione predefinita di Chat MCP usi testo in chiaro, si consiglia di impostare valori sensibili come le chiavi API come variabili di ambiente e di riferirsi a queste nella configurazione.

- Chat MCP supporta funzionalità MCP avanzate come tools e risorse?

No, la documentazione pubblica e il codice non includono funzionalità MCP avanzate come tools o risorse. Chat MCP si concentra nel fornire un'interfaccia chat minimalista ed estendibile per LLM.

- Posso usare Chat MCP con FlowHunt?

Sì. Chat MCP può essere integrato come server MCP all'interno di FlowHunt aggiungendo il componente MCP al tuo flow e configurandolo usando i dettagli server in formato JSON. Consulta la documentazione per i passaggi dettagliati.

Prova Chat MCP con FlowHunt

Esplora e interagisci con più LLM utilizzando Chat MCP. Perfetto per imparare MCP, prototipare rapidamente e vivere esperienze chat unificate.