Deepseek Thinker MCP Server

Porta il ragionamento trasparente e gli output AI chain-of-thought di Deepseek nei tuoi assistenti abilitati MCP con supporto per distribuzioni cloud e locali.

Cosa fa il server MCP “Deepseek Thinker”?

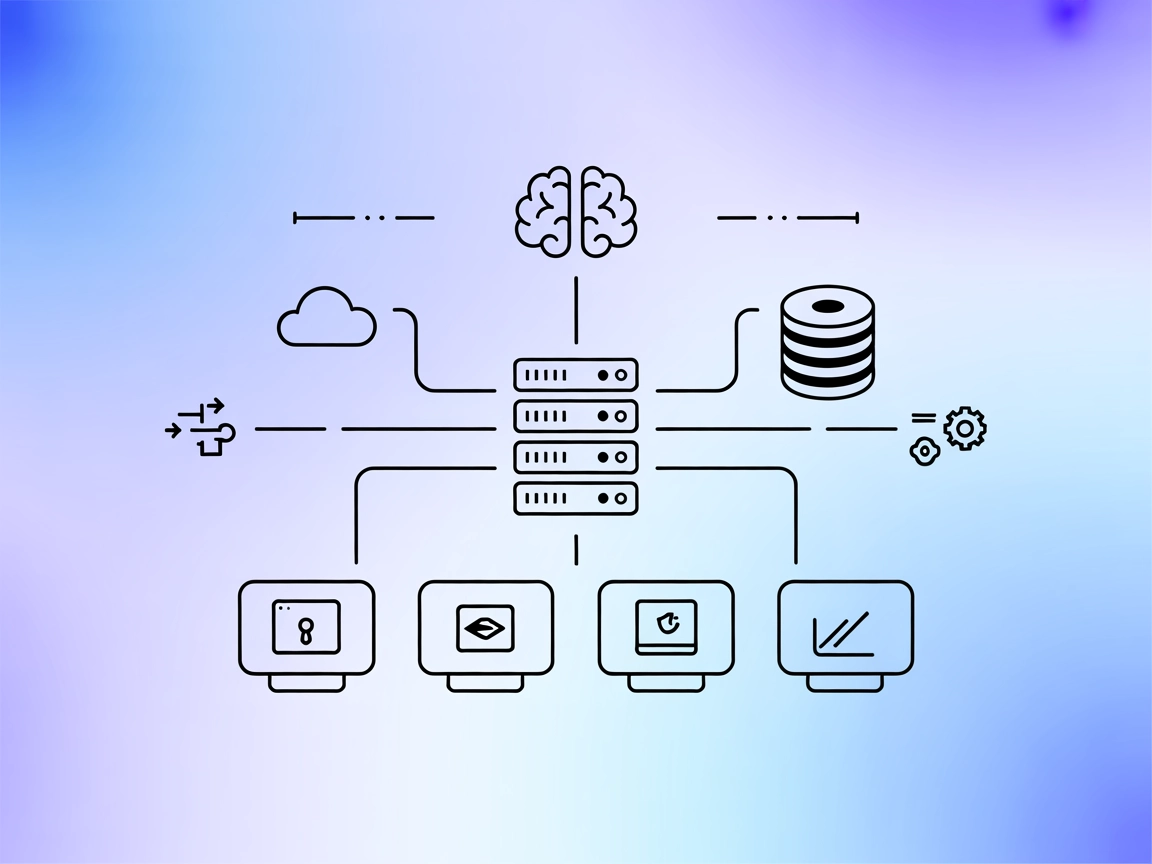

Deepseek Thinker MCP Server agisce come provider Model Context Protocol (MCP), fornendo contenuti di ragionamento del modello Deepseek ai client AI abilitati MCP, come Claude Desktop. Permette agli assistenti AI di accedere ai processi di pensiero e agli output di ragionamento di Deepseek sia tramite il servizio API Deepseek sia da un server Ollama locale. Integrando questo server, gli sviluppatori possono potenziare i propri flussi di lavoro AI con ragionamenti mirati, sfruttando le capacità di inferenza cloud o locale. Questo server è particolarmente utile in scenari in cui sono richieste catene di ragionamento dettagliate o output chain-of-thought (CoT) per informare compiti AI downstream, risultando prezioso per sviluppo avanzato, debug e arricchimento degli agenti AI.

Elenco dei Prompt

Nessun template di prompt esplicito è menzionato nel repository o nella documentazione.

Elenco delle Risorse

Nessuna risorsa MCP esplicita è riportata nella documentazione o nel codice.

Elenco degli Strumenti

- get-deepseek-thinker

- Descrizione: Esegue il ragionamento utilizzando il modello Deepseek.

- Parametro di input:

originPrompt(stringa) — Il prompt originale dell’utente. - Restituisce: Risposta testuale strutturata contenente il processo di ragionamento.

Casi d’Uso di questo MCP Server

- Potenzia il ragionamento AI

- Sfrutta gli output chain-of-thought dettagliati di Deepseek per arricchire le risposte dei client AI e fornire passaggi di ragionamento trasparenti.

- Integrazione con Claude Desktop

- Collegati facilmente a Claude Desktop o piattaforme AI simili per abilitare capacità di ragionamento avanzate tramite MCP.

- Modalità di Inferenza Doppia

- Scegli tra inferenza cloud (OpenAI API) o locale (Ollama) per soddisfare esigenze di privacy, costo o latenza.

- Debug & Analisi per Sviluppatori

- Usa il server per esporre e analizzare il ragionamento del modello per ricerca, debugging e studi di interpretabilità.

- Distribuzione Flessibile

- Esegui il server localmente o in ambienti cloud per soddisfare vari requisiti di flusso di lavoro.

Come configurarlo

Windsurf

- Prerequisiti: Assicurati che Node.js e npx siano installati sul tuo sistema.

- File di Configurazione: Individua il file di configurazione di Windsurf (es.

windsurf_config.json). - Aggiungi Deepseek Thinker MCP Server: Inserisci il seguente frammento JSON nell’oggetto

mcpServers:{ "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } - Salva e Riavvia: Salva le modifiche e riavvia Windsurf.

- Verifica: Controlla l’integrazione del server MCP nel client Windsurf.

Claude

- Prerequisiti: Node.js e npx installati.

- Modifica Configurazione: Apri

claude_desktop_config.json. - Aggiungi MCP Server:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Salva la Configurazione: Scrivi le modifiche e riavvia Claude Desktop.

- Verifica: Conferma che Deepseek Thinker sia disponibile nell’elenco strumenti MCP.

Cursor

- Assicurati dei Prerequisiti: Node.js e npx devono essere installati.

- Individua Config Cursor: Apri il file di configurazione MCP di Cursor.

- Inserisci Dettagli MCP Server:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Salva & Riavvia: Applica le modifiche e riavvia Cursor.

- Controlla Integrazione: Verifica che Deepseek Thinker sia operativo.

Cline

- Prerequisiti: Assicurati che Node.js e npx siano pronti.

- Modifica Config Cline: Apri il file di configurazione di Cline.

- Aggiungi Blocco MCP Server:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Salva e Riavvia: Salva la configurazione e riavvia Cline.

- Verifica Funzionalità: Assicurati che il server sia elencato e accessibile.

Nota: Protezione delle API Key

Per tutte le piattaforme, API key e valori sensibili dovrebbero essere forniti utilizzando variabili d’ambiente nella sezione env. Esempio:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Per la modalità locale Ollama, imposta USE_OLLAMA su "true" nell’oggetto env:

"env": {

"USE_OLLAMA": "true"

}

Come usare questo MCP nei flussi

Usare MCP in FlowHunt

Per integrare server MCP nel tuo flusso FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI sarà in grado di usare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “deepseek-thinker” con il nome reale del tuo server MCP e impostare l’URL corretto.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita trovata |

| Elenco degli Strumenti | ✅ | Strumento get-deepseek-thinker |

| Protezione API Key | ✅ | Variabili d’ambiente in configurazione |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ | Non menzionato |

Sulla base delle due tabelle seguenti, Deepseek Thinker MCP Server offre uno strumento focalizzato per l’integrazione del ragionamento, è facile da configurare, ma manca di template di prompt dettagliati e definizioni esplicite di risorse. Il progetto è open source, ha un seguito moderato e supporta la gestione sicura delle credenziali. Ottiene un 6/10 per completezza e utilità complessiva come server MCP.

MCP Score

| Ha una LICENSE | ⛔ (Nessun file LICENSE rilevato) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 12 |

| Numero di Star | 51 |

Domande frequenti

- Cos'è Deepseek Thinker MCP Server?

È un server Model Context Protocol che porta il ragionamento del modello Deepseek nei client AI abilitati MCP, offrendo output di chain-of-thought e pensiero trasparente del modello per flussi di lavoro AI avanzati e debugging.

- Quali strumenti offre Deepseek Thinker MCP Server?

Fornisce lo strumento 'get-deepseek-thinker' per eseguire ragionamenti con il modello Deepseek e restituire output strutturati di ragionamento.

- Posso usare Deepseek Thinker con modelli AI locali?

Sì, Deepseek Thinker supporta sia l'inferenza basata su cloud che quella locale (Ollama). Imposta la variabile d'ambiente 'USE_OLLAMA' su 'true' per la modalità locale.

- Come posso fornire le API key in modo sicuro?

API key e valori sensibili dovrebbero essere archiviati nella sezione 'env' della configurazione del server MCP come variabili d'ambiente, non hardcodate nei file sorgente.

- Cosa succede se supero i limiti di memoria o token?

I limiti sono determinati dal modello o API Deepseek sottostante; superarli può troncare le risposte o causare errori, quindi regola la tua configurazione e gli input di conseguenza.

- Ci sono dei prompt template o risorse MCP aggiuntive?

Non sono forniti template di prompt espliciti o risorse MCP aggiuntive nella documentazione attuale di Deepseek Thinker MCP Server.

Potenzia la tua AI con il ragionamento Deepseek

Integra Deepseek Thinker MCP Server per offrire ai tuoi agenti AI capacità di ragionamento dettagliato e ottimizzare i flussi di sviluppo.