Server MCP LlamaCloud

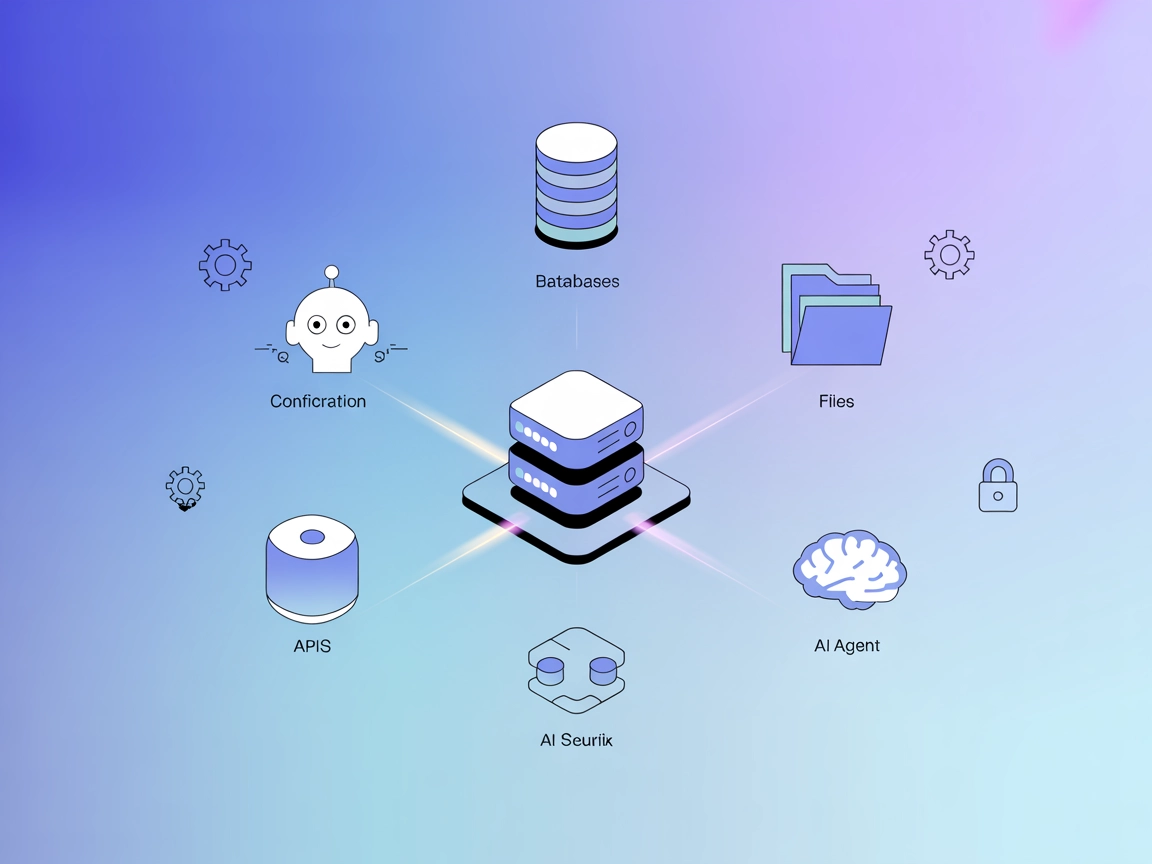

Il Server MCP LlamaCloud mette in collegamento i large language model con indici documentali gestiti e sicuri, permettendo un rapido recupero di informazioni aziendali e risposte AI contestuali.

Cosa fa il server MCP “LlamaCloud”?

Il Server MCP LlamaCloud è un server Model Context Protocol (MCP) basato su TypeScript che collega gli assistenti AI a molteplici indici gestiti su LlamaCloud. Espone ogni indice LlamaCloud come uno strumento dedicato, dando la possibilità agli agenti AI di eseguire ricerche e recuperare dati su una vasta gamma di insiemi strutturati di documenti—come archivi SEC o dati specifici aziendali—direttamente tramite l’interfaccia MCP. Questa impostazione migliora i workflow di sviluppo permettendo un facile accesso a dati esterni, facilitando attività come recupero contestuale dei dati, ricerca documentale e integrazione della conoscenza per applicazioni AI. Grazie agli argomenti configurabili da linea di comando, gli sviluppatori possono impostare e gestire rapidamente più indici come strumenti MCP, rendendo LlamaCloud un ponte flessibile tra LLM e repository documentali su scala enterprise.

Elenco dei Prompt

Non sono menzionati prompt template espliciti nella documentazione o nel codice disponibile per il Server MCP LlamaCloud.

Elenco delle Risorse

Nessuna risorsa specifica è elencata o descritta nella documentazione o nel codice disponibile per il Server MCP LlamaCloud.

Elenco degli Strumenti

- get_information_index_name

Ogni indice LlamaCloud definito nella configurazione diventa uno strumento (ad es.get_information_10k-SEC-Tesla). Ogni strumento espone un parametroqueryche consente la ricerca all’interno del relativo indice gestito.

Casi d’uso di questo Server MCP

- Ricerca Documentale Aziendale

Gli sviluppatori possono configurare strumenti per diversi indici documentali aziendali (ad es. archivi SEC per Tesla o Apple), permettendo agli agenti AI di recuperare e riassumere informazioni aziendali rilevanti su richiesta. - Integrazione della Conoscenza negli Agenti AI

Assistenti alimentati da LLM possono accedere a fonti dati autorevoli (come documenti SEC 10k) per risposte più accurate e consapevoli del contesto. - Recupero Informazioni Multi-Indice

Collegandosi contemporaneamente a più indici, il server abilita scenari di ricerca trasversale tra repository per attività di ricerca o compliance. - Pipeline Dati Personalizzate

I team possono collegare insiemi documentali proprietari agli indici LlamaCloud ed esporli in modo sicuro ai workflow AI per analytics o reportistica interna.

Come configurarlo

Windsurf

- Assicurati di avere Node.js e npx installati.

- Apri il file di configurazione del client MCP di Windsurf.

- Aggiungi il Server MCP LlamaCloud sotto l’oggetto

mcpServerscome mostrato sotto. - Inserisci il nome del progetto LlamaCloud e la chiave API nella sezione

env. - Salva la configurazione e riavvia Windsurf.

{

"mcpServers": {

"llamacloud": {

"command": "npx",

"args": [

"-y",

"@llamaindex/mcp-server-llamacloud",

"--index",

"10k-SEC-Tesla",

"--description",

"10k SEC documents from 2023 for Tesla",

"--index",

"10k-SEC-Apple",

"--description",

"10k SEC documents from 2023 for Apple"

],

"env": {

"LLAMA_CLOUD_PROJECT_NAME": "<YOUR_PROJECT_NAME>",

"LLAMA_CLOUD_API_KEY": "<YOUR_API_KEY>"

}

}

}

}

Claude

- Assicurati che Node.js e npx siano installati.

- Trova la configurazione MCP di Claude:

- Mac:

~/Library/Application Support/Claude/claude_desktop_config.json - Windows:

%APPDATA%/Claude/claude_desktop_config.json

- Mac:

- Aggiungi la configurazione del Server MCP LlamaCloud nell’oggetto

mcpServers(vedi esempio Windsurf sopra). - Inserisci le tue credenziali API nella sezione

env. - Salva le modifiche e riavvia Claude.

Cursor

- Installa Node.js e npx se non già presenti.

- Apri il file di configurazione MCP del client Cursor.

- Inserisci la configurazione del Server MCP LlamaCloud come mostrato nell’esempio Windsurf.

- Fornisci le tue credenziali API.

- Salva e riavvia Cursor.

Cline

- Assicurati che Node.js e npx siano disponibili.

- Trova o crea il file di configurazione MCP del client Cline.

- Aggiungi la configurazione del Server MCP LlamaCloud sotto

mcpServers, utilizzando l’esempio sopra. - Inserisci le tue credenziali API LlamaCloud.

- Salva e riavvia Cline.

Proteggere le chiavi API

Usa variabili ambiente nella sezione env della configurazione. Esempio:

"env": {

"LLAMA_CLOUD_PROJECT_NAME": "<YOUR_PROJECT_NAME>",

"LLAMA_CLOUD_API_KEY": "<YOUR_API_KEY>"

}

Evita il più possibile di esporre segreti in chiaro.

Come utilizzare questo MCP all’interno dei flow

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"llamacloud": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “llamacloud” con il nome effettivo del tuo server MCP e di sostituire l’URL con quello del tuo server MCP.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | Intro e riepilogo delle funzionalità disponibili |

| Elenco dei Prompt | ⛔ | Nessun prompt template esplicito documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa specifica elencata |

| Elenco degli Strumenti | ✅ | Ogni indice diventa uno strumento get_information_INDEXNAME con parametro query |

| Protezione delle chiavi API | ✅ | Uso di env nella config, indicazioni chiare mostrate |

| Supporto sampling (meno importante in valutazione) | ⛔ | Non menzionato nella documentazione disponibile |

La nostra opinione

Il Server MCP LlamaCloud è focalizzato e semplice da configurare per collegare LLM a indici documentali gestiti. Manca di risorse avanzate e prompt template, ma l’approccio tool-based per ogni indice è pulito e ben documentato. In base alle tabelle, è una scelta solida e diretta per sviluppatori che necessitano di recupero documentale robusto, ma non per chi cerca funzionalità MCP avanzate come risorse, roots o sampling.

VALUTAZIONE: 6/10

MCP Score

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 17 |

| Numero di Stelle | 77 |

Domande frequenti

- Cos’è il Server MCP LlamaCloud?

Il Server MCP LlamaCloud è un server Model Context Protocol basato su TypeScript che consente agli assistenti AI di accedere a molteplici indici gestiti su LlamaCloud. Ogni indice diventa uno strumento ricercabile, consentendo un recupero documentale efficiente da fonti come archivi SEC o dati aziendali proprietari.

- Che tipo di attività abilita il Server MCP LlamaCloud?

Permette ad agenti basati su LLM di effettuare recupero contestuale dei dati, ricerca documentale aziendale, integrazione della conoscenza e query su più indici, rendendolo ideale per workflow di ricerca, compliance e analytics.

- Come posso proteggere le mie chiavi API durante la configurazione del server?

Utilizza sempre la sezione `env` nel file di configurazione MCP per conservare informazioni sensibili come nomi progetto e chiavi API. Evita di inserire segreti direttamente nel codice o in file di testo semplice.

- Come si usa il Server MCP LlamaCloud con FlowHunt?

Aggiungi il componente MCP al tuo flow FlowHunt, quindi inserisci la configurazione MCP LlamaCloud nel pannello MCP. Imposta transport, name e URL per collegare il tuo agente AI a tutti gli strumenti disponibili sul server.

- Il Server MCP LlamaCloud supporta prompt template o risorse?

No, l’implementazione attuale non fornisce prompt template espliciti o gestione avanzata delle risorse. Il focus è su un recupero documentale robusto e basato su strumenti tramite indici gestiti.

Collega FlowHunt al Server MCP LlamaCloud

Sblocca una potente ricerca documentale enterprise e l’integrazione della conoscenza nei tuoi workflow AI tramite il Server MCP LlamaCloud.