LLM Context MCP Server

Collega senza soluzione di continuità agenti AI a progetti di codice e testo con LLM Context MCP Server—ottimizzando i flussi di lavoro di sviluppo con assistenza sicura, ricca di contesto e automatizzata.

Cosa fa il server “LLM Context” MCP?

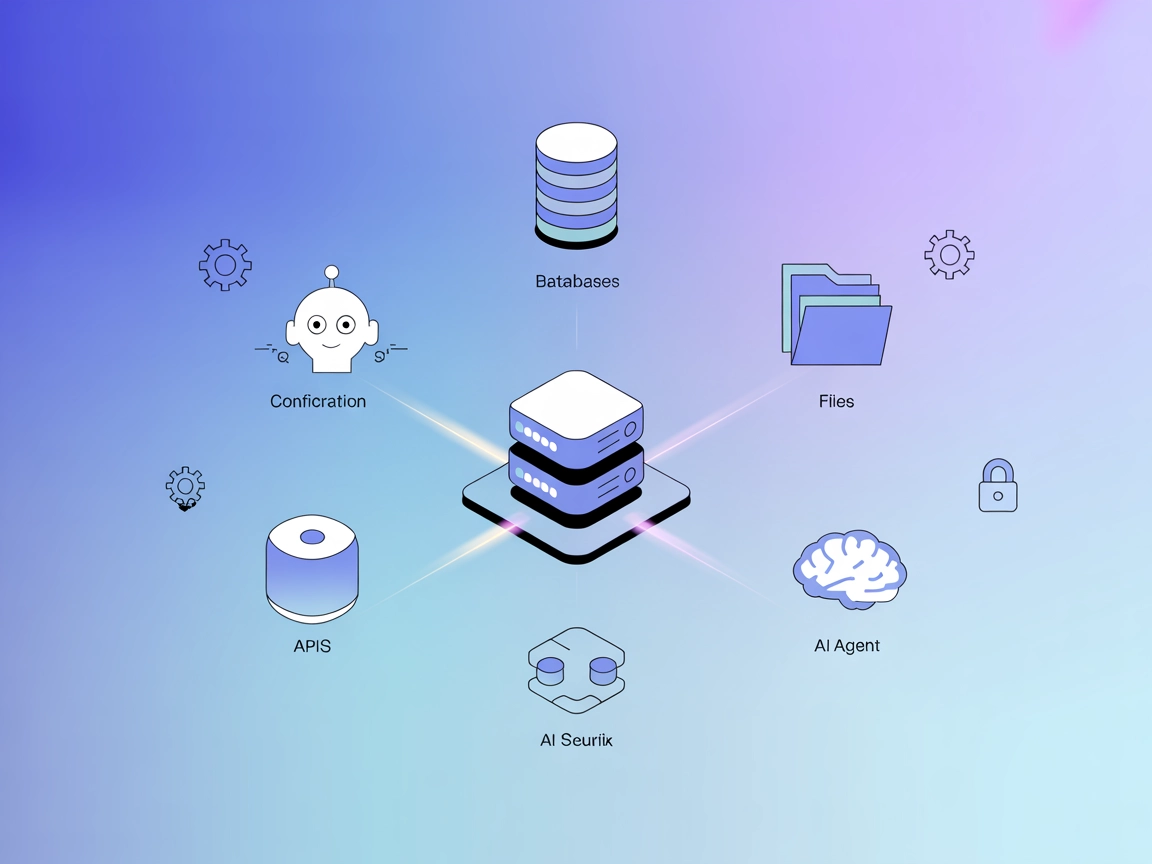

LLM Context MCP Server è uno strumento progettato per collegare senza soluzione di continuità gli assistenti AI con progetti di codice e testo esterni, migliorando il flusso di lavoro di sviluppo tramite il Model Context Protocol (MCP). Sfruttando i pattern .gitignore per una selezione intelligente dei file, consente agli sviluppatori di iniettare contenuti altamente rilevanti direttamente nelle interfacce chat LLM o di utilizzare un workflow semplificato tramite clipboard. Questo permette di svolgere in modo efficiente attività come revisione del codice, generazione di documentazione ed esplorazione dei progetti con assistenza AI consapevole del contesto. LLM Context è particolarmente efficace sia per repository di codice che per raccolte di documenti testuali, rendendolo un ponte versatile tra i dati di progetto e i flussi di lavoro AI.

Elenco dei Prompt

Nessuna informazione trovata nel repository riguardo a template di prompt definiti.

Elenco delle Risorse

Nessuna risorsa esplicita è menzionata nei file o nella documentazione forniti.

Elenco degli Strumenti

Nessun file server.py o equivalente che elenca strumenti è presente nella struttura visibile del repository. Nessuna informazione sugli strumenti esposti è stata trovata.

Casi d’Uso di questo MCP Server

- Automazione della Revisione del Codice: Inietta segmenti di codice rilevanti nelle interfacce LLM per assistere revisioni del codice automatiche o assistite.

- Generazione di Documentazione: Consente all’AI di accedere e riassumere la documentazione direttamente dai file di progetto.

- Esplorazione del Progetto: Aiuta sviluppatori e agenti AI a comprendere rapidamente grandi codebase o progetti di testo mettendo in evidenza file chiave e outline.

- Workflow con Clipboard: Permette agli utenti di copiare contenuti da e verso la clipboard per una rapida condivisione con LLM, migliorando la produttività nei workflow chat-based.

Come configurarlo

Windsurf

- Assicurati di avere Node.js e Windsurf installati.

- Individua il file di configurazione di Windsurf (ad es.

windsurf.config.json). - Aggiungi il server LLM Context MCP utilizzando il seguente frammento JSON:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Salva la configurazione e riavvia Windsurf.

- Verifica la configurazione controllando che il server MCP compaia in Windsurf.

Claude

- Installa Node.js e assicurati che Claude supporti l’integrazione MCP.

- Modifica il file di configurazione di Claude per includere il server MCP:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Salva il file e riavvia Claude.

- Conferma che il server sia disponibile nelle impostazioni MCP di Claude.

Cursor

- Installa eventuali prerequisiti per l’editor Cursor.

- Apri il file di configurazione MCP di Cursor.

- Aggiungi il server LLM Context MCP:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Salva le modifiche e riavvia Cursor.

- Verifica che il server MCP sia operativo.

Cline

- Installa Node.js e Cline.

- Modifica la configurazione di Cline per registrare il server MCP:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Salva e riavvia Cline.

- Verifica che il server MCP sia ora accessibile.

Messa in Sicurezza delle API Key

Imposta variabili d’ambiente per proteggere le API key e i segreti. Esempio di configurazione:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": [],

"env": {

"API_KEY": "${LLM_CONTEXT_API_KEY}"

},

"inputs": {

"apiKey": "${LLM_CONTEXT_API_KEY}"

}

}

}

}

Come utilizzare questo MCP all’interno dei flow

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"llm-context": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come uno strumento con accesso a tutte le sue funzioni e capacità. Ricorda di modificare “llm-context” con il nome effettivo del tuo server MCP e di sostituire l’URL con quello del tuo server MCP personale.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessuna informazione trovata |

| Elenco delle Risorse | ⛔ | Nessuna informazione trovata |

| Elenco degli Strumenti | ⛔ | Nessuna informazione trovata |

| Messa in Sicurezza delle API Key | ✅ | Esempio di variabile d’ambiente fornito |

| Supporto Sampling (meno rilevante per la valutazione) | ⛔ | Nessuna informazione trovata |

In base alle due tabelle, questo MCP server presenta una solida panoramica e buone pratiche di sicurezza ma manca di documentazione chiara riguardo prompt, risorse e strumenti. Pertanto, è più utile per workflow di condivisione di contesto di base e richiede ulteriore documentazione per sfruttare appieno le funzionalità avanzate di MCP.

MCP Score

| Ha una LICENSE | ✅ (Apache-2.0) |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 18 |

| Numero di Stelle | 231 |

Domande frequenti

- Cos'è il server LLM Context MCP?

Il server LLM Context MCP collega agenti AI a progetti di codice e testo esterni, fornendo una selezione intelligente del contesto tramite pattern .gitignore e abilitando flussi di lavoro avanzati come revisione del codice, generazione di documentazione ed esplorazione dei progetti direttamente nelle interfacce chat LLM.

- Quali sono i principali casi d'uso per questo MCP Server?

I casi d'uso principali includono automazione della revisione del codice, generazione di documentazione, esplorazione rapida dei progetti e condivisione di contenuti tramite clipboard con gli LLM per aumentare la produttività nei workflow basati su chat.

- Come configuro in modo sicuro le API key per il server LLM Context MCP?

Imposta variabili d'ambiente con le tue API key (ad es. LLM_CONTEXT_API_KEY) e riferiscile nella configurazione del server MCP per mantenere le chiavi fuori dal codice sorgente e dai file di configurazione.

- Il server include template di prompt o strumenti integrati?

No, la versione attuale non prevede prompt definiti né strumenti espliciti, rendendolo ideale per workflow di condivisione di contesto di base ma richiedendo ulteriori personalizzazioni per funzionalità avanzate.

- Quale licenza utilizza il server LLM Context MCP?

Questo server è open-source con licenza Apache-2.0.

- Come posso usare il server LLM Context MCP in FlowHunt?

Aggiungi il componente MCP al tuo flow FlowHunt, inserisci i dettagli del server MCP nel pannello di configurazione usando il formato JSON fornito e collegalo al tuo agente AI per un'automazione potenziata e contestuale.

Potenzia il tuo workflow AI con LLM Context MCP

Integra il server LLM Context MCP in FlowHunt per automazioni più intelligenti e contestuali nei tuoi processi di coding e documentazione.