mcp-proxy Server MCP

Collega assistenti AI a strumenti e sistemi attraverso diversi protocolli di trasporto MCP usando il server MCP mcp-proxy per FlowHunt.

Cosa fa il server MCP “mcp-proxy”?

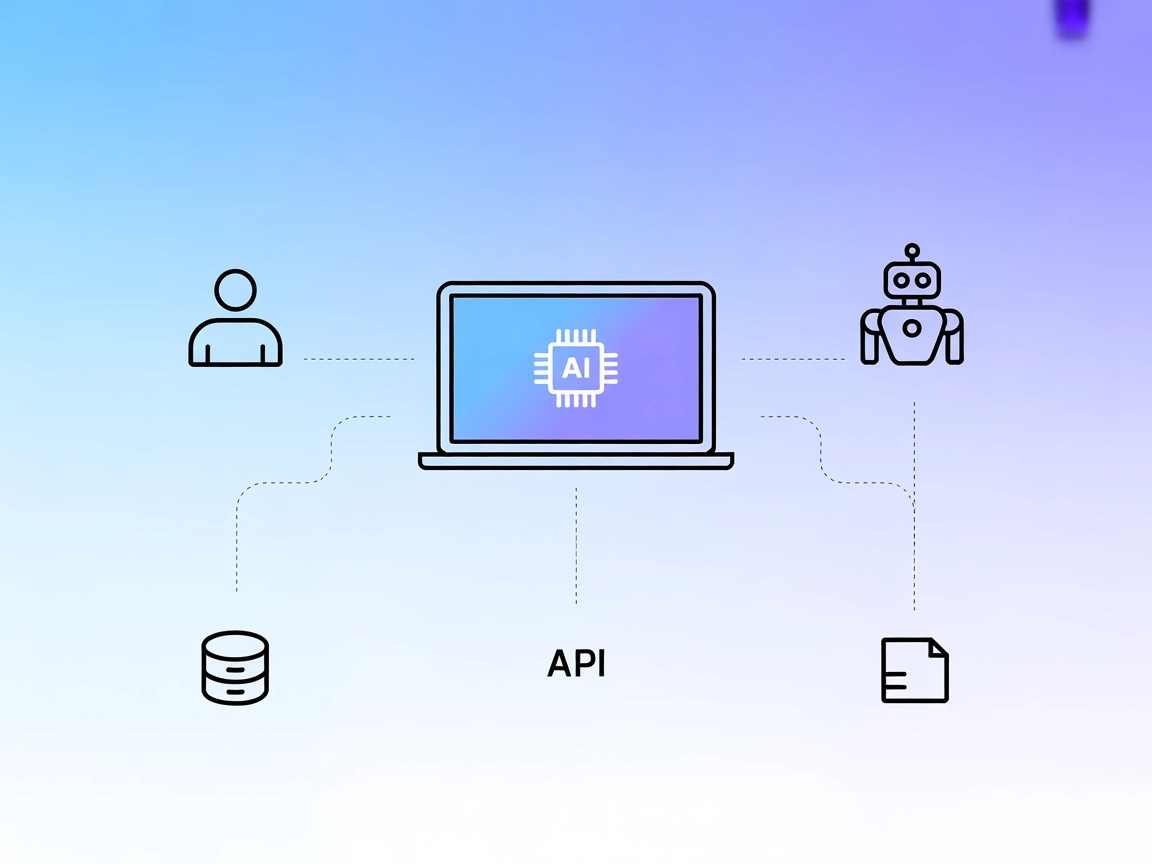

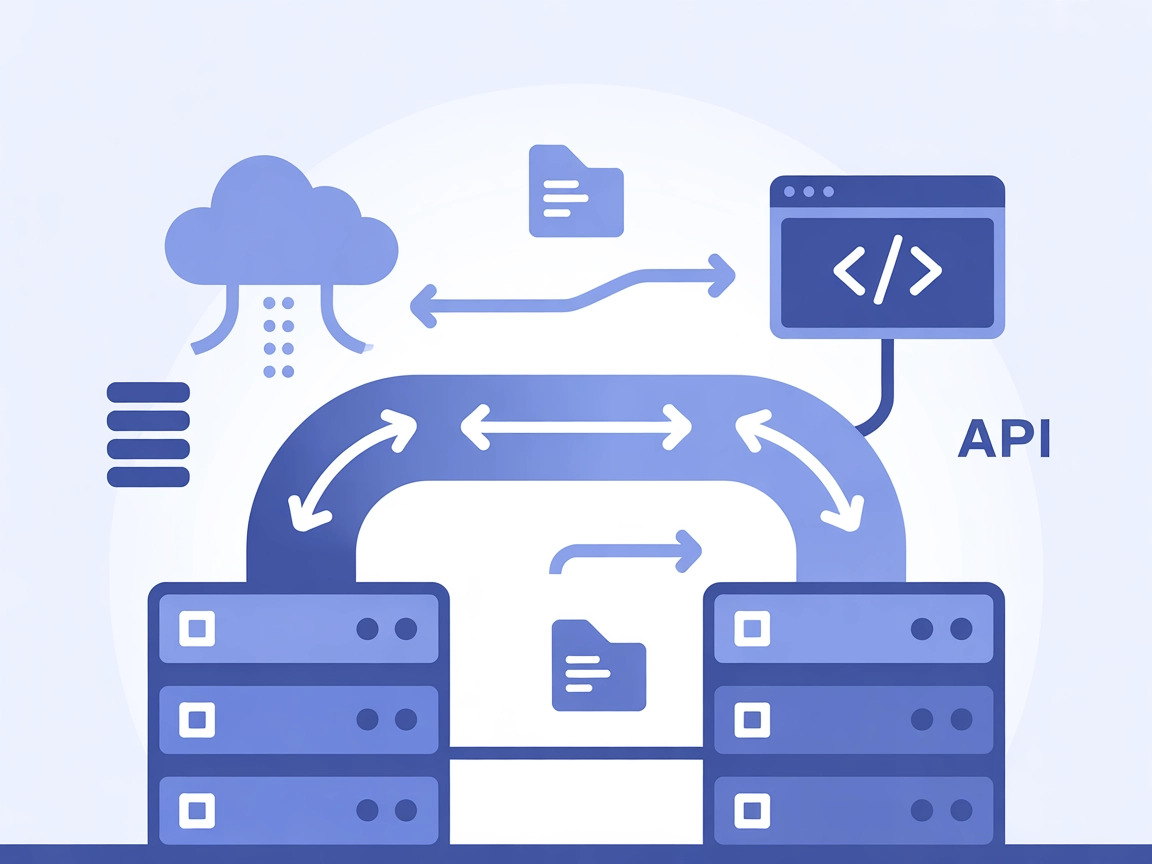

Il server MCP mcp-proxy funge da ponte tra i trasporti MCP Streamable HTTP e stdio, permettendo una comunicazione senza soluzione di continuità tra assistenti AI e diversi tipi di server o client Model Context Protocol (MCP). La sua funzione principale è tradurre tra questi due protocolli di trasporto ampiamente utilizzati, consentendo l’accesso a strumenti, risorse e flussi di lavoro progettati per un protocollo anche tramite l’altro senza necessità di modifiche. Questo migliora i flussi di lavoro di sviluppo rendendo possibile agli assistenti AI interagire con fonti dati esterne, API o servizi che usano diversi meccanismi di trasporto, abilitando così attività come query su database, gestione file o interazioni API tra sistemi eterogenei.

Elenco dei Prompt

Nel repository non sono menzionati template di prompt.

Elenco delle Risorse

Nella documentazione o nel codice del repository non sono descritte risorse MCP esplicite.

Elenco degli Strumenti

Nella documentazione o nel codice visibile del repository non sono definiti strumenti (ad es. nessuna funzione, tool o server.py con definizioni di strumenti esplicite).

Casi d’uso di questo server MCP

- Bridging di Protocollo: permette ai client MCP che usano il trasporto stdio di comunicare con server che usano Streamable HTTP e viceversa, ampliando l’interoperabilità.

- Integrazione di Sistemi Legacy: facilita l’integrazione di strumenti o server MCP legacy con piattaforme AI moderne basate su HTTP, riducendo la necessità di riscrittura.

- Miglioramento del Flusso di Lavoro AI: consente agli assistenti AI di accedere a una gamma più ampia di strumenti e servizi colmando i gap tra protocolli, arricchendo le possibili azioni e fonti dati.

- Sviluppo Cross-Platform: rende più semplice sviluppare e testare strumenti basati su MCP su ambienti che prediligono trasporti diversi, migliorando la flessibilità per gli sviluppatori.

Come configurarlo

Windsurf

- Assicurati che Python sia installato nel sistema.

- Clona il repository

mcp-proxyoppure installalo tramite PyPI se disponibile. - Modifica il file di configurazione di Windsurf per aggiungere il server MCP mcp-proxy.

- Usa il seguente snippet JSON nella configurazione:

{ "mcpServers": { "mcp-proxy": { "command": "mcp-proxy", "args": [] } } } - Riavvia Windsurf e verifica che il server mcp-proxy sia in esecuzione.

Claude

- Assicurati che Python sia installato.

- Clona o installa il server mcp-proxy.

- Apri la configurazione/impostazioni di Claude per i server MCP.

- Aggiungi la seguente configurazione:

{ "mcpServers": { "mcp-proxy": { "command": "mcp-proxy", "args": [] } } } - Salva e riavvia Claude, poi verifica la connettività.

Cursor

- Installa Python e il pacchetto mcp-proxy.

- Apri le impostazioni dell’estensione o del server MCP di Cursor.

- Aggiungi questa configurazione:

{ "mcpServers": { "mcp-proxy": { "command": "mcp-proxy", "args": [] } } } - Salva le modifiche e riavvia Cursor.

Cline

- Assicurati che Python sia installato.

- Installa mcp-proxy tramite PyPI o clona il repository.

- Modifica il file di configurazione di Cline:

{ "mcpServers": { "mcp-proxy": { "command": "mcp-proxy", "args": [] } } } - Salva e riavvia Cline.

Protezione delle chiavi API

Puoi proteggere le variabili d’ambiente (ad es. chiavi API) usando env nella configurazione:

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": [],

"env": {

"API_KEY": "${API_KEY}"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

Come usare questo MCP all’interno dei flussi

Utilizzo di MCP in FlowHunt

Per integrare server MCP nel tuo flusso di lavoro FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"mcp-proxy": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI sarà in grado di utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “mcp-proxy” con il vero nome del tuo server MCP e di sostituire l’URL con quello del tuo server MCP.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessuno trovato |

| Elenco delle Risorse | ⛔ | Nessuna trovata |

| Elenco degli Strumenti | ⛔ | Nessuno strumento esplicito definito |

| Protezione delle chiavi API | ✅ | Tramite env nella config |

| Supporto Sampling (meno importante in valutazione) | ⛔ | Nessuna menzione |

| Supporto Roots | ⛔ | Nessuna menzione |

In base a quanto sopra, mcp-proxy è altamente specializzato nella traduzione tra protocolli ma non offre strumenti, prompt o risorse preintegrati. Il suo valore è nell’integrazione e connettività, non nell’offrire utilità LLM dirette.

La nostra opinione

mcp-proxy è un’utilità fondamentale per collegare i protocolli di trasporto MCP, risultando molto preziosa in ambienti dove la mancata compatibilità tra protocolli limita l’interoperabilità degli strumenti AI/LLM. Tuttavia, non offre funzionalità LLM dirette come risorse, prompt o strumenti. Per il suo caso d’uso, è un progetto solido e ben supportato. Valutazione: 6/10 per utilità generale MCP, 9/10 se hai bisogno specificamente di bridging tra protocolli.

Punteggio MCP

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 128 |

| Numero di Star | 1.1k |

Domande frequenti

- A cosa serve il server MCP mcp-proxy?

Il server MCP mcp-proxy collega i trasporti MCP Streamable HTTP e stdio, consentendo una comunicazione fluida tra assistenti AI e una varietà di server o client MCP. Questo permette a flussi di lavoro e strumenti progettati per protocolli diversi di funzionare insieme senza modifiche.

- Quali sono alcuni casi d'uso del server MCP mcp-proxy?

mcp-proxy è ideale per il bridging di protocolli tra diversi trasporti MCP, l'integrazione di sistemi legacy con piattaforme AI moderne, il miglioramento della connettività nei flussi di lavoro AI e il supporto allo sviluppo e test cross-platform.

- mcp-proxy fornisce strumenti o risorse di prompt?

No, mcp-proxy si occupa esclusivamente della traduzione dei protocolli e non offre strumenti integrati, template di prompt o risorse. Il suo valore consiste nell'abilitare interoperabilità e integrazione.

- Come proteggo le chiavi API con mcp-proxy?

Puoi utilizzare variabili d'ambiente nella configurazione del server MCP per proteggere le chiavi API. Ad esempio, usa un blocco 'env' e fai riferimento alle variabili nel tuo JSON di configurazione.

- Come si usa mcp-proxy in FlowHunt?

Aggiungi il componente MCP al tuo flusso FlowHunt, poi configura il server MCP mcp-proxy nella configurazione MCP di sistema usando lo snippet JSON appropriato. Questo consente al tuo agente AI di accedere a tutte le funzionalità rese disponibili dai protocolli MCP collegati.

Prova mcp-proxy con FlowHunt

Colma le lacune nei flussi di lavoro AI e abilita l'interoperabilità tra protocolli con mcp-proxy. Integra sistemi legacy e amplia subito la portata della tua AI.