Integrazione del Server Pinecone MCP

Collega FlowHunt a Pinecone per ricerca semantica avanzata, gestione dati vettoriali e applicazioni AI potenziate da RAG.

Cosa fa il Server “Pinecone” MCP?

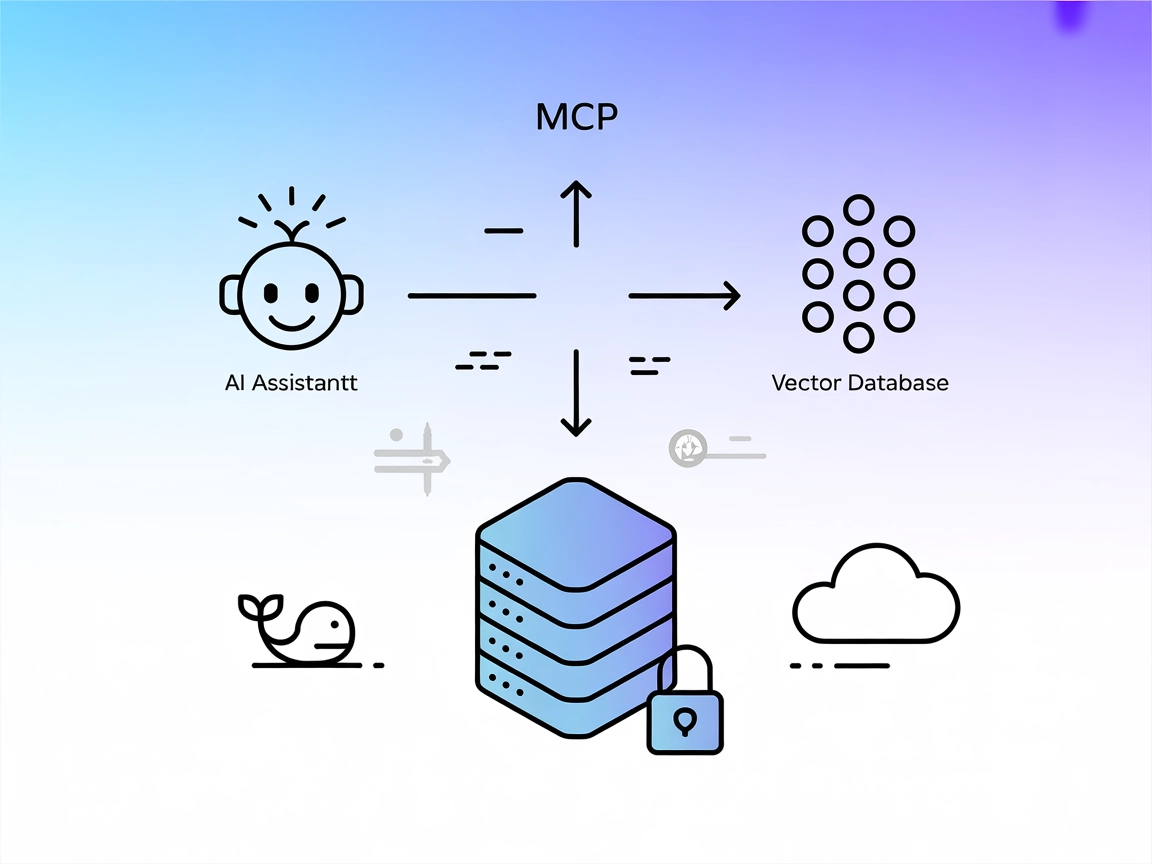

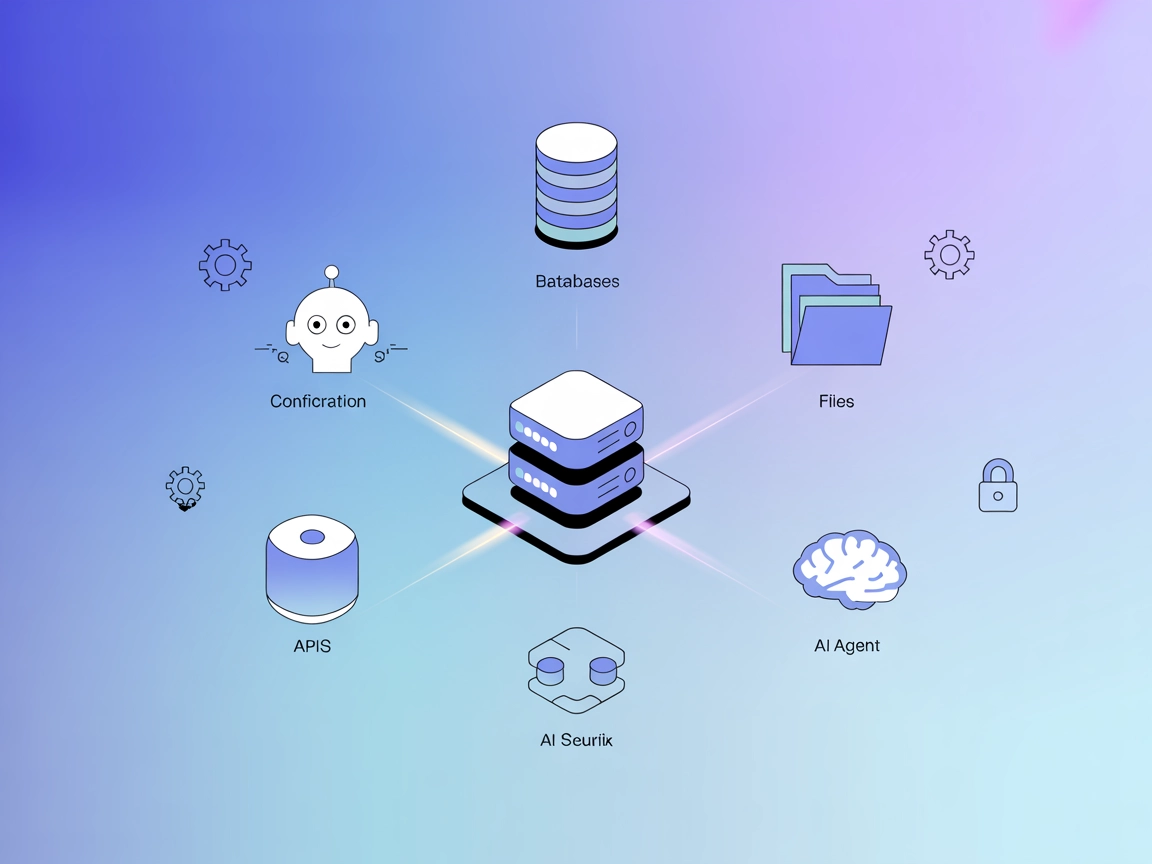

Il Pinecone MCP (Model Context Protocol) Server è uno strumento specializzato che collega assistenti AI ai database vettoriali Pinecone, consentendo la lettura e scrittura fluida dei dati per flussi di lavoro di sviluppo avanzati. Facendo da intermediario, il Pinecone MCP Server permette ai client AI di eseguire attività quali ricerca semantica, recupero documenti e gestione del database all’interno di un indice Pinecone. Supporta operazioni come interrogazione per record simili, gestione documenti e upsert di nuovi embedding. Questa capacità è particolarmente preziosa per applicazioni che coinvolgono la Retrieval-Augmented Generation (RAG), poiché semplifica l’integrazione di dati contestuali nei flussi AI e automatizza complesse interazioni sui dati.

Elenco dei Prompt

Nessun template di prompt esplicito è menzionato nel repository.

Elenco delle Risorse

- Pinecone Index: La risorsa principale, che consente la lettura e scrittura dei dati.

- Document Resource: Rappresenta i documenti archiviati nell’indice Pinecone che possono essere letti o elencati.

- Record Resource: Record individuali all’interno dell’indice Pinecone che possono essere ricercati o upsertati.

- Pinecone Stats Resource: Espone statistiche sull’indice Pinecone, come numero di record, dimensioni e namespace.

Elenco degli Strumenti

- semantic-search: Cerca record nell’indice Pinecone tramite similarità semantica.

- read-document: Legge uno specifico documento dall’indice Pinecone.

- list-documents: Elenca tutti i documenti attualmente archiviati nell’indice Pinecone.

- pinecone-stats: Recupera statistiche sull’indice Pinecone, inclusi numero di record, dimensioni e namespace.

- process-document: Suddivide un documento in chunk, genera embedding e li upserta nell’indice Pinecone.

Casi d’Uso di questo MCP Server

- Gestione Database: Lettura, scrittura e gestione efficiente di dati vettoriali in un indice Pinecone, supportando applicazioni AI su larga scala.

- Ricerca Semantica: Permette agli assistenti AI di effettuare ricerche semantiche sui documenti archiviati, restituendo i risultati più rilevanti in base alla similarità vettoriale.

- Retrieval-Augmented Generation (RAG): Integra conoscenza esterna nei flussi LLM recuperando contesti rilevanti dall’indice Pinecone per informare le risposte AI.

- Suddivisione ed Embedding di Documenti: Suddivide automaticamente i documenti, genera embedding e li inserisce in Pinecone, semplificando il workflow per ricerca e recupero documentale.

- Monitoraggio e Statistiche Indice: Ottieni informazioni in tempo reale su salute e performance dell’indice Pinecone, facilitando ottimizzazione e troubleshooting.

Come configurarlo

Windsurf

- Assicurati di avere Python e Node.js installati.

- Trova il file di configurazione di Windsurf.

- Aggiungi il Pinecone MCP Server usando il seguente snippet JSON:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Salva il file di configurazione e riavvia Windsurf.

- Verifica la presenza degli strumenti Pinecone MCP Server nell’interfaccia.

Proteggi le chiavi API con variabili d’ambiente:

{

"mcpServers": {

"pinecone-mcp": {

"command": "mcp-pinecone",

"env": {

"PINECONE_API_KEY": "your_api_key"

},

"inputs": {

"index_name": "your_index"

}

}

}

}

Claude

- Installa il Pinecone MCP Server usando Python (ad esempio,

pip install mcp-pinecone). - Modifica la configurazione di Claude per aggiungere il server:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Salva la configurazione e riavvia Claude.

- Conferma che il server sia attivo e accessibile come strumento.

Cursor

- Assicurati che Python e mcp-pinecone siano installati.

- Vai al file di configurazione di Cursor.

- Inserisci la seguente voce MCP server:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Salva le modifiche e riavvia Cursor.

- Controlla nell’elenco strumenti la presenza delle operazioni Pinecone.

Cline

- Verifica l’installazione di Python e mcp-pinecone.

- Apri il file di configurazione di Cline.

- Aggiungi il Pinecone MCP Server con:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Salva e riavvia Cline.

- Assicurati di poter accedere agli strumenti Pinecone.

Nota: Proteggi sempre le chiavi API e i valori sensibili con variabili d’ambiente come mostrato sopra.

Come usare questo MCP nei flussi

Utilizzo MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"pinecone-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricordati di cambiare “pinecone-mcp” con il nome effettivo del tuo server MCP e sostituire la URL con quella del tuo server MCP.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | Descrive integrazione DB vettoriale Pinecone |

| Elenco dei Prompt | ⛔ | Nessun template di prompt esplicito trovato |

| Elenco delle Risorse | ✅ | Pinecone index, documenti, record, statistiche |

| Elenco degli Strumenti | ✅ | semantic-search, read-document, list-documents, pinecone-stats, process-document |

| Protezione Chiavi API | ✅ | Esempio fornito con variabili d’ambiente in configurazione |

| Supporto Sampling (meno importante in valutazione) | ⛔ | Nessuna menzione o evidenza trovata |

La nostra opinione

Il Pinecone MCP Server è ben documentato, espone risorse e strumenti chiari e include istruzioni solide per l’integrazione e la sicurezza delle chiavi API. Tuttavia, mancano template di prompt espliciti e documentazione su sampling o supporto roots. Nel complesso, è un server pratico e prezioso per workflow RAG e Pinecone, anche se potrebbe essere migliorato con più esempi di workflow e funzionalità avanzate.

Valutazione: 8/10

MCP Score

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 25 |

| Numero di Stelle | 124 |

Domande frequenti

- Cos'è il Pinecone MCP Server?

Il Pinecone MCP Server collega gli assistenti AI ai database vettoriali Pinecone, abilitando ricerca semantica, gestione documentale e workflow di embedding all'interno di applicazioni AI come FlowHunt.

- Quali strumenti fornisce il Pinecone MCP Server?

Espone strumenti per ricerca semantica, lettura e lista di documenti, recupero delle statistiche degli indici e elaborazione dei documenti in embedding da upsertare nell'indice Pinecone.

- Come supporta Pinecone MCP la Retrieval-Augmented Generation (RAG)?

Il server consente agli agenti AI di recuperare contesti rilevanti da Pinecone, permettendo agli LLM di generare risposte basate su fonti di conoscenza esterne.

- Come posso collegarmi in modo sicuro a un indice Pinecone?

Salva la tua chiave API Pinecone e il nome dell'indice come variabili d'ambiente nel file di configurazione, come mostrato nelle istruzioni di integrazione, per mantenere sicure le credenziali.

- Quali sono gli utilizzi tipici del Pinecone MCP Server?

Gli utilizzi comuni includono ricerca semantica su grandi collezioni di documenti, pipeline RAG, suddivisione e embedding automatica dei documenti, e monitoraggio delle statistiche degli indici Pinecone.

Potenzia i tuoi flussi AI con Pinecone

Abilita ricerca semantica e Retrieval-Augmented Generation in FlowHunt collegando i tuoi agenti AI ai database vettoriali Pinecone.