mcp-rag-local MCP Server

Un server MCP locale a memoria semantica per FlowHunt, costruito con ChromaDB e Ollama. Permette agli agenti AI di memorizzare e recuperare testo, documenti e PDF per significato, supportando potenti workflow RAG e di gestione della conoscenza.

Cosa fa il server MCP “mcp-rag-local”?

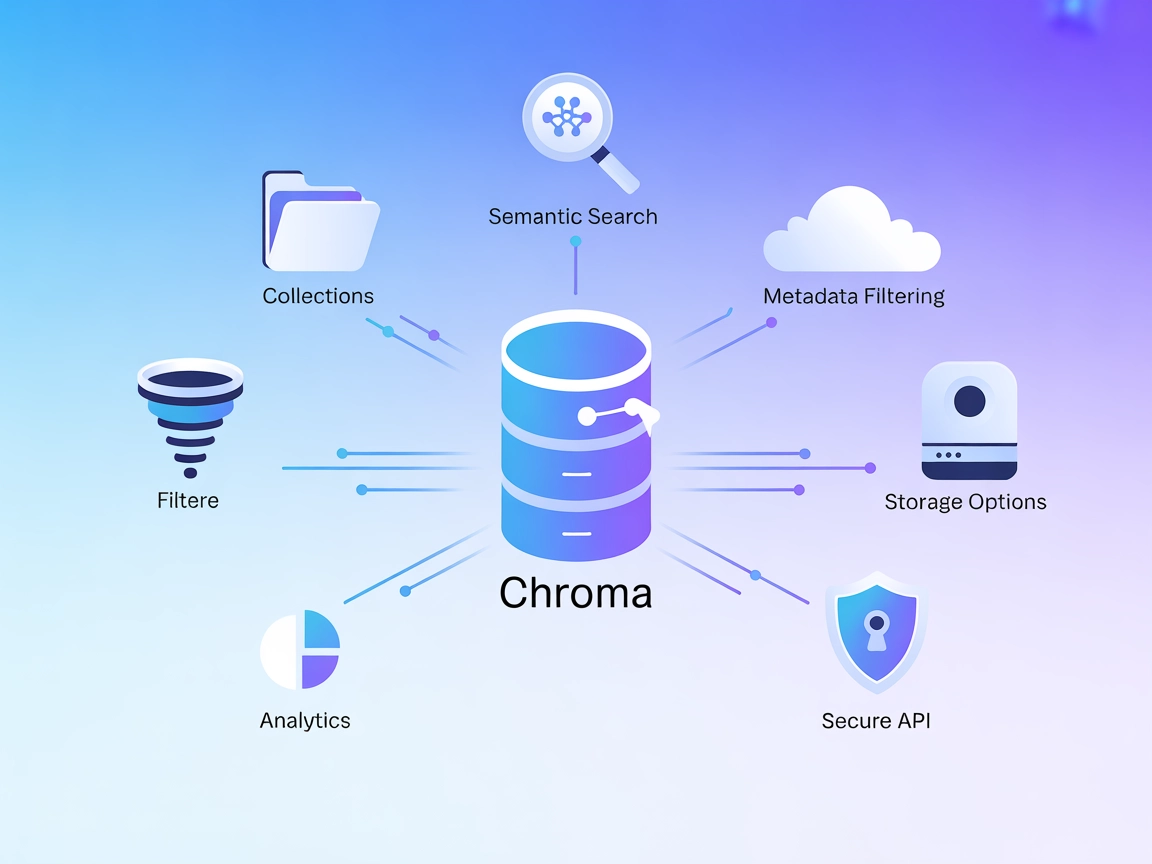

Il server MCP mcp-rag-local è progettato come un server di memoria che consente agli assistenti AI di memorizzare e recuperare passaggi di testo in base al loro significato semantico, non solo tramite parole chiave. Sfruttando Ollama per la generazione di embeddings di testo e ChromaDB per l’archiviazione e la ricerca per similarità vettoriale, permette l’archiviazione (“memorizzazione”) e il recupero fluido dei testi rilevanti per una determinata query. Questo abilita workflow guidati dall’AI come la gestione della conoscenza, il richiamo contestuale e la ricerca semantica. Gli sviluppatori possono interagire con il server per archiviare testi singoli, multipli o anche contenuti di file PDF, e successivamente recuperare le informazioni più contestualmente rilevanti, migliorando produttività e consapevolezza contestuale nelle applicazioni.

Elenco dei Prompt

- Nessun template di prompt esplicito è menzionato nel repository o nella documentazione.

Elenco delle Risorse

- Nessuna risorsa MCP esplicita è documentata nel repository o nel README.

Elenco degli Strumenti

memorize_text

Permette al server di memorizzare un singolo passaggio di testo per un futuro recupero semantico.memorize_multiple_texts

Consente l’archiviazione in batch di più testi contemporaneamente, facilitando l’importazione di conoscenza in massa.memorize_pdf_file

Legge ed estrae fino a 20 pagine per volta da un file PDF, suddivide il contenuto e lo memorizza per il recupero semantico.retrieve_similar_texts

Recupera i passaggi di testo più rilevanti memorizzati in base a una query dell’utente, utilizzando la similarità semantica.

(Nomi degli strumenti dedotti dai pattern d’uso documentati; i nomi esatti potrebbero variare nel codice.)

Casi d’Uso di questo Server MCP

Base di Conoscenza Personale

Sviluppatori e utenti possono costruire una base di conoscenza persistente e ricercabile memorizzando articoli, note o pubblicazioni per un richiamo semantico.Sintesi di Documenti e PDF

Memorizzando interi documenti PDF, gli utenti possono successivamente effettuare query e recuperare sezioni o sintesi rilevanti, semplificando ricerca e revisione.Memoria Conversazionale per Chatbot

Migliora assistenti AI o chatbot con una memoria a lungo termine e consapevole del contesto per risposte più coerenti e pertinenti nel tempo.Motore di Ricerca Semantico

Implementa una funzione di ricerca semantica nelle applicazioni, permettendo agli utenti di trovare informazioni rilevanti in base al significato e non solo alle parole chiave.Ricerca ed Esplorazione Dati

Archivia e interroga documenti tecnici, frammenti di codice o letteratura scientifica per un recupero rapido e basato sul significato durante investigazioni o sviluppo.

Come configurarlo

Windsurf

- Prerequisiti:

- Installa uv come gestore di pacchetti Python.

- Verifica che Docker sia installato e in esecuzione.

- Clona e Installa:

- Clona il repository:

git clone <repository-url>cd mcp-rag-local - Installa le dipendenze usando uv.

- Clona il repository:

- Avvia i Servizi:

- Esegui

docker-compose upper avviare ChromaDB e Ollama. - Scarica il modello di embedding:

docker exec -it ollama ollama pull all-minilm:l6-v2

- Esegui

- Configura il Server MCP:

- Aggiungi alla configurazione MCP di Windsurf (es. in

mcpServers):"mcp-rag-local": { "command": "uv", "args": [ "--directory", "path\\to\\mcp-rag-local", "run", "main.py" ], "env": { "CHROMADB_PORT": "8321", "OLLAMA_PORT": "11434" } }

- Aggiungi alla configurazione MCP di Windsurf (es. in

- Salva e Riavvia:

- Salva la configurazione e riavvia Windsurf.

- Verifica la Configurazione:

- Conferma che il server sia avviato e accessibile.

Claude

- Segui i passaggi 1–3 sopra (prerequisiti, clona/installa, avvia i servizi).

- Aggiungi quanto segue alla configurazione MCP di Claude:

"mcpServers": { "mcp-rag-local": { "command": "uv", "args": [ "--directory", "path\\to\\mcp-rag-local", "run", "main.py" ], "env": { "CHROMADB_PORT": "8321", "OLLAMA_PORT": "11434" } } } - Salva e riavvia Claude.

- Verifica che il server sia elencato e attivo.

Cursor

- Completa i passaggi 1–3 (come sopra).

- Aggiungi alla configurazione di Cursor:

"mcpServers": { "mcp-rag-local": { "command": "uv", "args": [ "--directory", "path\\to\\mcp-rag-local", "run", "main.py" ], "env": { "CHROMADB_PORT": "8321", "OLLAMA_PORT": "11434" } } } - Salva e riavvia Cursor.

- Controlla che il server MCP sia operativo.

Cline

- Ripeti i passaggi 1–3 (prerequisiti, clona/installa, avvia i servizi).

- Nella configurazione di Cline, aggiungi:

"mcpServers": { "mcp-rag-local": { "command": "uv", "args": [ "--directory", "path\\to\\mcp-rag-local", "run", "main.py" ], "env": { "CHROMADB_PORT": "8321", "OLLAMA_PORT": "11434" } } } - Salva, riavvia Cline e verifica la configurazione.

Protezione delle Chiavi API

- Usa le variabili d’ambiente nella sezione

envdella tua configurazione. - Esempio:

"env": { "CHROMADB_PORT": "8321", "OLLAMA_PORT": "11434", "MY_API_KEY": "${MY_API_KEY}" } - Assicurati che le chiavi sensibili non siano salvate in chiaro ma referenziate dall’ambiente.

Come usare questo MCP nei flow

Utilizzo del MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"mcp-rag-local": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “mcp-rag-local” con il nome effettivo del tuo server MCP e sostituire la URL con quella del tuo MCP.

Panoramica

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun prompt/template documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa documentata |

| Elenco degli Strumenti | ✅ | memorize_text, memorize_multiple_texts, ecc. |

| Protezione Chiavi API | ✅ | tramite env in config, esempio mostrato |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ | Non menzionato |

La nostra opinione

Questo MCP è semplice e ben focalizzato sulla memoria semantica, ma manca di funzionalità avanzate come template di prompt, risorse esplicite o supporto sampling/roots. Strumenti e configurazione sono chiari. Ideale per workflow RAG/knowledge locali semplici.

MCP Score

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 1 |

| Numero di Stelle | 5 |

Domande frequenti

- Cos'è il server MCP mcp-rag-local?

È un server MCP locale che offre agli agenti AI la capacità di memorizzare e recuperare testi, documenti e PDF in base al significato semantico. Alimentato da Ollama e ChromaDB, consente gestione della conoscenza, memoria contestuale e ricerca semantica per le tue applicazioni.

- Quali strumenti offre mcp-rag-local?

Fornisce strumenti per memorizzare uno o più passaggi di testo, importare file PDF e recuperare testi simili tramite ricerca semantica. Questo abilita workflow come la costruzione di basi di conoscenza personali, la sintesi di documenti e la memoria conversazionale per chatbot.

- Come configuro mcp-rag-local?

Installa uv e Docker, clona il repository, avvia Ollama e ChromaDB e configura il server MCP nel file di configurazione del tuo client con le porte specificate. Le variabili d'ambiente vengono utilizzate per una configurazione sicura.

- Quali sono i principali casi d'uso?

I casi d'uso includono la creazione di una base di conoscenza semantica, sintesi di documenti/PDF, miglioramento della memoria chatbot, ricerca semantica ed esplorazione di dati di ricerca.

- Come proteggo le chiavi API o le porte?

Usa sempre le variabili d'ambiente nella sezione env della tua configurazione per evitare di inserire informazioni sensibili nel codice, garantendo sicurezza e best practice.

Prova mcp-rag-local con FlowHunt

Potenzia i tuoi flussi di lavoro AI con memoria semantica e ricerca locale di documenti usando mcp-rag-local. Configura in pochi minuti e trasforma il modo in cui i tuoi agenti richiamano e ragionano sulla conoscenza.