De kunst van promptoptimalisatie voor slimmere AI-workflows

Beheers promptoptimalisatie voor AI door duidelijke, contextrijke prompts te maken om de outputkwaliteit te verhogen, kosten te verlagen en verwerkingstijd te verminderen. Ontdek technieken voor slimmere AI-workflows.

Aan de slag met promptoptimalisatie

Promptoptimalisatie betekent dat je de input die je aan een AI-model geeft, verfijnt zodat het de meest nauwkeurige en efficiënte antwoorden mogelijk levert. Het gaat niet alleen om duidelijke communicatie—geoptimaliseerde prompts verminderen ook de rekentijd en zorgen zo voor snellere verwerking en lagere kosten. Of je nu vragen schrijft voor klantenservice-chatbots of complexe rapporten genereert, de manier waarop je je prompts structureert en formuleert is van belang.

Het verschil tussen een goede en een slechte prompt

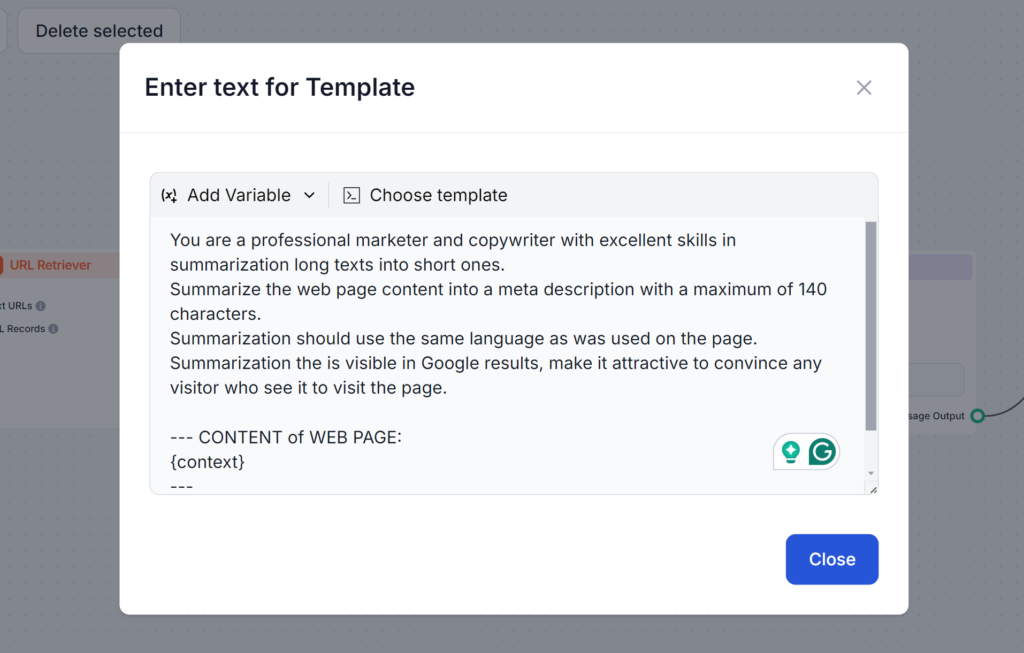

Heb je ooit geprobeerd AI te vragen om een metabeschrijving te schrijven? De kans is groot dat je eerste prompt ongeveer zo ging:

Schrijf een metabeschrijving over het onderwerp promptoptimalisatie.

Deze prompt is om verschillende redenen verkeerd. Als je de lengte van 140 tekens die Google vereist niet aangeeft, zal de AI deze waarschijnlijk overschrijden. Zelfs als de lengte klopt, gebruikt het vaak een andere stijl of maakt het de tekst te beschrijvend en saai om op te klikken. Tot slot, zonder jouw artikel te lezen, kan de AI alleen vage metabeschrijvingen maken.

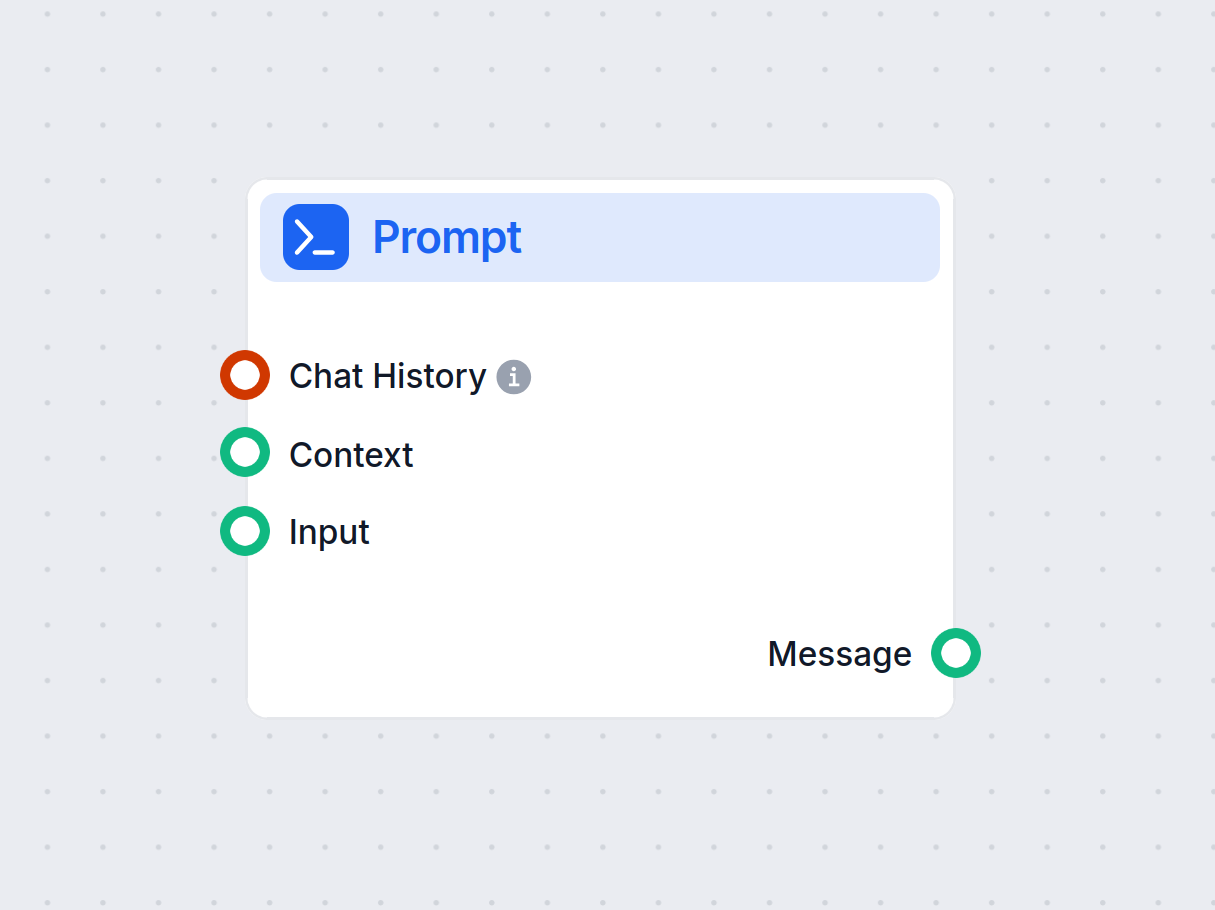

Bekijk de onderstaande prompt. Deze is langer en gebruikt verschillende technieken die we in deze blog zullen behandelen. Wat deze prompt goed doet, is dat het alle mogelijke problemen aanpakt, zodat je direct het gewenste resultaat krijgt:

De basis begrijpen

Tokens zijn de bouwstenen van tekst die AI-modellen verwerken. De modellen breken tekst op in deze tokens. Eén token kan een woord zijn, meerdere woorden of zelfs een deel van een woord. Meer tokens betekenen meestal langzamere antwoorden en hogere rekenkosten. Het begrijpen van tokens is dus essentieel om prompts te verbeteren en ervoor te zorgen dat ze betaalbaar en snel uitvoerbaar zijn.

Waarom tokens belangrijk zijn:

- Kosten: Veel AI-modellen, zoals OpenAI’s ChatGPT, rekenen op basis van het aantal verwerkte tokens.

- Snelheid: Minder tokens zorgen voor snellere antwoorden.

- Duidelijkheid: Een beknopte prompt helpt het model zich op relevante details te richten.

Bijvoorbeeld:

- Prompt met veel tokens:

Kun je alsjeblieft in detail elk aspect uitleggen van hoe machine learning-modellen worden getraind, inclusief alle mogelijke algoritmen? - Prompt met weinig tokens:

Vat het proces van het trainen van machine learning-modellen samen en benoem de belangrijkste algoritmen.

In de prompt met veel tokens moet de AI alle opties uitgebreid behandelen, terwijl de korte prompt om een simpel overzicht vraagt. Door het overzicht kun je vervolgens uitbreiden op basis van je behoeften, zodat je sneller en goedkoper tot het gewenste resultaat komt.

Manieren om effectieve prompts te maken

Effectieve prompts vereisen een combinatie van duidelijkheid, context en creativiteit. Verschillende formaten proberen is aan te raden om te ontdekken wat het beste werkt. Hier zijn enkele belangrijke technieken:

Wees specifiek en duidelijk

Vage prompts kunnen het model in verwarring brengen. Een goed gestructureerde prompt zorgt ervoor dat de AI je intentie begrijpt.

Voorbeeld:

- Vage prompt:

Schrijf over sport. - Specifieke prompt:

Schrijf een blogpost van 200 woorden over de voordelen van regelmatig sporten voor basketballers.

Geef context

Door relevante details toe te voegen, kan de AI antwoorden genereren die aansluiten bij jouw behoeften.

Voorbeeld:

- Zonder context:

Leg fotosynthese uit. - Met context:

Leg fotosynthese uit aan een 10-jarige in eenvoudige taal.

Gebruik voorbeelden

Voorbeelden helpen de AI het gewenste formaat of de gewenste toon te begrijpen.

Voorbeeld:

- Zonder voorbeeld:

Genereer een productreview voor een smartphone. - Met voorbeeld:

Schrijf een positieve review over een smartphone zoals deze: “Ik gebruik de [Productnaam] nu een week, en de camerakwaliteit is uitstekend…”

Experimenteer met sjablonen

Gestandaardiseerde sjablonen voor vergelijkbare taken zorgen voor consistentie en besparen tijd.

Voorbeeldsjabloon voor bloggen:

“Schrijf een blogpost van [aantal woorden] over [onderwerp], met focus op [specifieke details]. Gebruik een vriendelijke toon en verwerk [zoekwoorden].”

Geavanceerde technieken voor contextoptimalisatie

Er zijn verschillende geavanceerde strategieën waarmee je je prompts naar een hoger niveau kunt tillen. Deze technieken gaan verder dan alleen duidelijkheid en structuur, zodat je complexere taken aankunt, dynamische data kunt integreren en AI-antwoorden kunt afstemmen op specifieke domeinen of behoeften. Hier vind je een kort overzicht van elke techniek, met praktische voorbeelden.

Few-shot learning

Few-shot learning betekent dat je een klein aantal voorbeelden in je prompt opneemt om de AI te helpen het gewenste patroon of formaat te begrijpen. Het stelt het model in staat om met minimale data toch effectief te generaliseren, ideaal voor nieuwe of onbekende taken.

Geef gewoon een paar voorbeelden in je prompt zodat het model je verwachtingen begrijpt.

Voorbeeldprompt:

Vertaal de volgende zinnen naar het Frans:

- Goedemorgen → Bonjour

- Hoe gaat het? → Comment ça va?

Nu vertalen: Wat is jouw naam?

Prompt chaining

Prompt chaining betekent dat je complexe taken opdeelt in kleinere, behapbare stappen die op elkaar voortbouwen. Deze methode stelt de AI in staat om meerstapsproblemen systematisch aan te pakken, wat zorgt voor duidelijkheid en precisie in de output.

Voorbeeldprompt:

- Stap 1: Vat dit artikel samen in 100 woorden.

- Stap 2: Maak van de samenvatting een tweet.

Contextuele retrieval

Contextuele retrieval integreert relevante, actuele informatie in de prompt door te verwijzen naar externe bronnen of belangrijke details samen te vatten. Zo geef je de AI toegang tot nauwkeurige en recente data voor beter onderbouwde antwoorden.

Voorbeeld:

“Gebruik gegevens uit dit rapport [link invoegen], en vat de belangrijkste bevindingen over trends in hernieuwbare energie samen.”

Fine-tuning met embeddings

Fine-tuning met embeddings stemt het AI-model af op specifieke taken of domeinen door gebruik te maken van gespecialiseerde datavertegenwoordiging. Deze aanpassing verhoogt de relevantie en nauwkeurigheid van antwoorden in niche- of branchespecifieke toepassingen.

Strategieën voor tokenbeheer

Door het gebruik van tokens te beheren, kun je bepalen hoe snel en kostenefficiënt AI input en output verwerkt. Door het aantal verwerkte tokens te verminderen, kun je kosten besparen en snellere antwoorden krijgen zonder concessies te doen aan de kwaliteit. Hier zijn technieken voor effectief tokenbeheer:

- Schrap onnodige woorden: Vermijd overbodige of omslachtige taal. Houd prompts beknopt en to the point.

- Omslachtig: Zou je alsjeblieft, als je het niet erg vindt, een overzicht kunnen geven van…?

- Beknopt: Geef een overzicht van…

- Gebruik windowing: Richt je op alleen de meest relevante delen van lange input. Door deze op te delen in behapbare stukken kan de AI effectiever inzichten halen zonder steeds de hele input te verwerken.

- Voorbeeld: Haal hoofdpunten uit een document van 10.000 woorden door het te verdelen in secties en voor elke sectie om een samenvatting te vragen.

- Batch en splits input: Groepeer meerdere prompts voor efficiëntie.

- Voorbeeld: Combineer meerdere gerelateerde vragen in één prompt met duidelijke scheidingstekens.

Hoe houd je de prestaties in de gaten

Optimalisatie stopt niet bij het schrijven van betere prompts. Houd de prestaties regelmatig bij en stuur bij op basis van feedback. Doorlopend monitoren zorgt voor gestage verfijning en geeft je de kans om gerichte verbeteringen door te voeren.

Richt je op deze kernpunten:

- Antwoordnauwkeurigheid: Voldoen de uitkomsten aan de verwachtingen?

- Efficiëntie: Zijn het tokengebruik en de verwerkingstijden acceptabel?

- Relevantie: Blijven de antwoorden on-topic?

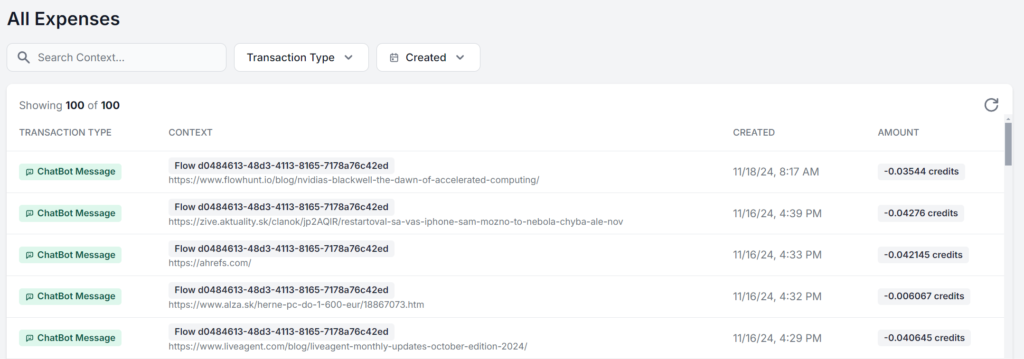

De beste aanpak is werken in een interface waarin je per prompt je exacte gebruik kunt zien en analyseren. Hier zie je dezelfde FlowHunt AI-workflow die vijf keer draait, waarbij alleen het bronmateriaal verandert. Het verschil in kosten is slechts centen, maar als de charges zich opstapelen wordt het verschil snel merkbaar:

Conclusie

Of je nu alleen het maximale uit het gratis limiet van AI-modellen wilt halen of je AI-strategie op schaal opbouwt, promptoptimalisatie is essentieel voor iedereen die AI gebruikt. Met deze technieken gebruik je AI efficiënt, krijg je nauwkeurige uitkomsten en verlaag je kosten.

Naarmate AI-technologie verder ontwikkelt, wordt het belang van duidelijke en geoptimaliseerde communicatie met modellen alleen maar groter. Ga vandaag nog gratis aan de slag met deze strategieën. FlowHunt stelt je in staat om met verschillende AI-modellen en mogelijkheden te bouwen in één dashboard, wat zorgt voor geoptimaliseerde en efficiënte AI-workflows voor elke taak. Probeer de 14-daagse gratis proefperiode!

Veelgestelde vragen

- Wat is promptoptimalisatie in AI?

Promptoptimalisatie houdt in dat je de input die je aan een AI-model geeft verfijnt, zodat het de meest nauwkeurige en efficiënte antwoorden levert. Geoptimaliseerde prompts verminderen de rekentijd, wat leidt tot snellere verwerking en lagere kosten.

- Waarom is het aantal tokens belangrijk bij prompt engineering?

Het aantal tokens beïnvloedt zowel de snelheid als de kosten van AI-uitvoer. Minder tokens zorgen voor snellere antwoorden en lagere kosten, terwijl beknopte prompts modellen helpen zich op relevante details te richten.

- Wat zijn enkele geavanceerde technieken voor promptoptimalisatie?

Geavanceerde technieken zijn onder andere few-shot learning, prompt chaining, contextuele retrieval en fine-tuning met embeddings. Deze methoden helpen bij het oplossen van complexe taken, het integreren van dynamische data en het afstemmen van antwoorden op specifieke behoeften.

- Hoe kan ik de prestaties van promptoptimalisatie meten?

Houd de nauwkeurigheid van antwoorden, het tokengebruik en de verwerkingstijden in de gaten. Regelmatig meten en bijstellen op basis van feedback helpt prompts te verfijnen en de efficiëntie te behouden.

- Hoe kan FlowHunt helpen bij promptoptimalisatie?

FlowHunt biedt tools en een dashboard om AI-prompts te bouwen, testen en optimaliseren, zodat je kunt experimenteren met verschillende modellen en strategieën voor efficiënte AI-workflows.

Maria is copywriter bij FlowHunt. Een taalliefhebber actief in literaire gemeenschappen, ze is zich er volledig van bewust dat AI de manier waarop we schrijven verandert. In plaats van zich te verzetten, probeert ze te helpen de perfecte balans te vinden tussen AI-workflows en de onvervangbare waarde van menselijke creativiteit.

Probeer FlowHunt voor slimmere AI-workflows

Begin met het bouwen van geoptimaliseerde AI-workflows met FlowHunt. Experimenteer met prompt engineering en verhoog je productiviteit.