De 12-Factor AI Agent: Effectieve AI-systemen Bouwen die Schalen

Ontdek de 12 factoren voor het bouwen van robuuste, schaalbare AI-agenten: van natuurlijke taalconversie en prompt-eigenaarschap tot menselijke samenwerking en stateloos ontwerp. Bouw productieklare AI-systemen die echte bedrijfswaarde leveren.

Wat Maakt een Effectieve AI-Agent?

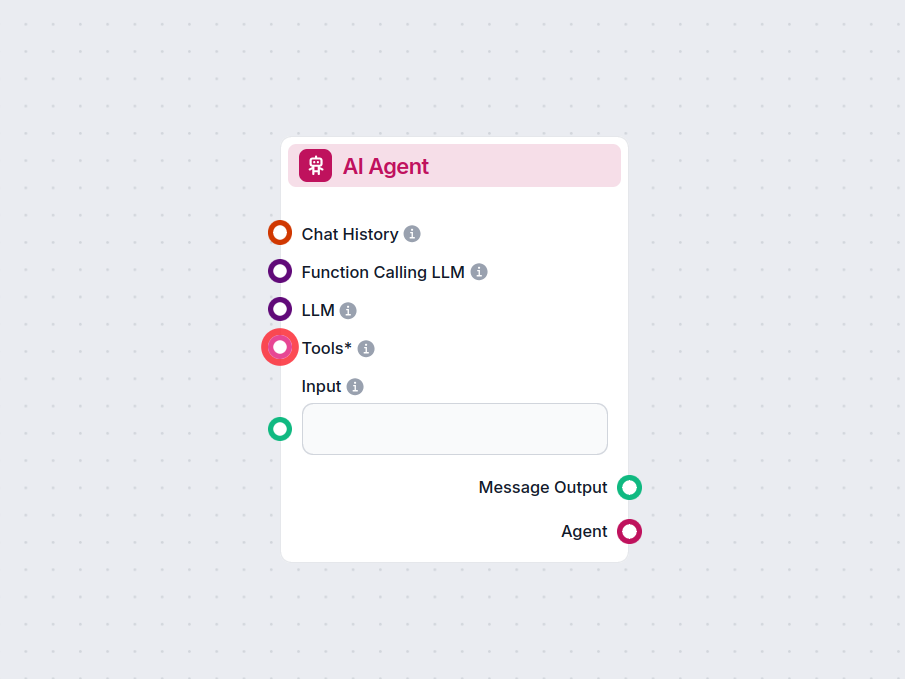

Voordat we ingaan op de factoren, verduidelijken we eerst wat we bedoelen met “AI-agenten.” In de kern zijn dit systemen die natuurlijke taalverzoeken kunnen interpreteren, beslissingen nemen op basis van context en specifieke acties uitvoeren via tools of API’s—terwijl ze samenhangende, doorlopende interacties behouden.

De krachtigste agenten combineren het redeneervermogen van taalmodellen met de betrouwbaarheid van deterministische code. Maar het vinden van die balans vereist zorgvuldige ontwerpkeuzes—precies waar deze factoren op inspelen.

De 12 Factoren voor het Bouwen van Robuuste AI-Agenten

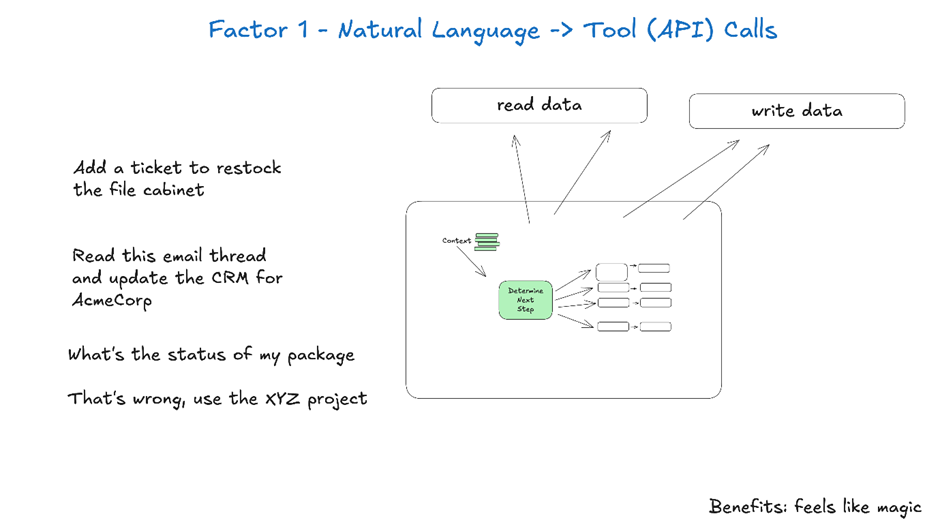

1. Beheers Conversie van Natuurlijke Taal naar Tool-oproepen

Het vermogen om natuurlijke taalverzoeken om te zetten in gestructureerde tool-oproepen vormt de kern van de agentfunctionaliteit. Hiermee kan een agent een eenvoudig commando als “maak een betalingslink aan voor €750 voor Terri voor de AI Tinkerers-bijeenkomst in februari” omzetten in een correct geformatteerde API-call.

{

"function": {

"name": "create_payment_link",

"parameters": {

"amount": 750,

"customer": "cust_128934ddasf9",

"product": "prod_8675309",

"price": "prc_09874329fds",

"quantity": 1,

"memo": "Hey Jeff - zie hieronder de betalingslink voor de AI Tinkerers-bijeenkomst in februari"

}

}

}

De sleutel tot betrouwbare werking is het gebruik van deterministische code om de gestructureerde output van je taalmodel te verwerken. Valideer altijd API-payloads vóór uitvoering om fouten te voorkomen en zorg ervoor dat je LLM consistente JSON-formaten retourneert die betrouwbaar te parsen zijn.

2. Neem Volledig Eigenaarschap over je Prompts

Je prompts zijn de interface tussen je applicatie en het taalmodel—behandel ze als first-class code. Frameworks die prompts abstraheren lijken handig, maar verbergen vaak hoe instructies aan de LLM worden doorgegeven, waardoor fine-tuning lastig of onmogelijk wordt.

Beheer in plaats daarvan je prompts direct door ze expliciet te schrijven:

function DetermineNextStep(thread: string) -> DoneForNow | ListGitTags | DeployBackend | DeployFrontend | RequestMoreInformation {

prompt #"

{{ _.role("system") }}

Je bent een behulpzame assistent die deployments beheert voor frontend- en backendsystemen.

...

{{ _.role("user") }}

{{ thread }}

Wat moet de volgende stap zijn?

"#

}

Deze aanpak biedt je meerdere voordelen:

- Volledige controle om nauwkeurige instructies te schrijven die passen bij jouw use case

- Mogelijkheid om evaluaties en tests te bouwen voor prompts als gewone code

- Transparantie om precies te begrijpen wat de LLM ontvangt

- Vrijheid om te itereren op basis van prestatiegegevens

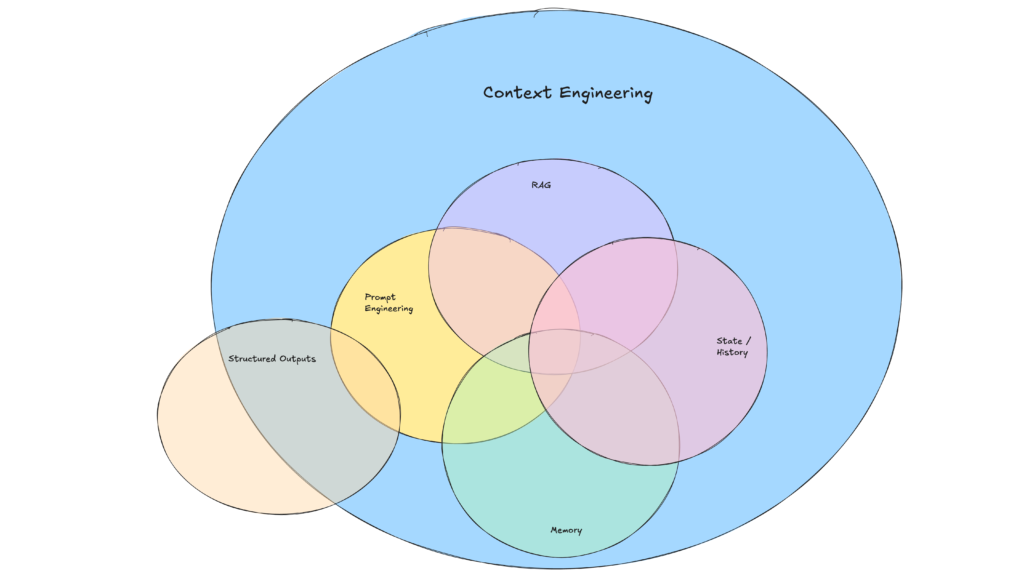

3. Ontwerp je Contextwindow Strategisch

Het contextwindow fungeert als input van de LLM en omvat prompts, gespreksgeschiedenis en externe data. Optimalisatie hiervan verbetert prestaties en tokenefficiëntie.

Ga verder dan standaard message-based formaten naar aangepaste structuren die de informatiedichtheid maximaliseren:

<slack_message>

From: @alex

Channel: #deployments

Text: Kun je de backend deployen?

</slack_message>

<list_git_tags>

intent: "list_git_tags"

</list_git_tags>

<list_git_tags_result>

tags:

- name: "v1.2.3"

commit: "abc123"

date: "2024-03-15T10:00:00Z"

</list_git_tags_result>

Deze aanpak biedt meerdere voordelen:

- Minder tokengebruik door compacte formaten

- Betere filtering van gevoelige data voordat deze naar de LLM gaan

- Flexibiliteit om te experimenteren met formaten die het begrip van de LLM verbeteren

4. Implementeer Tools als Gestructureerde Outputs

Tools zijn in essentie JSON-uitvoer van de LLM die deterministische acties in je code aansturen. Dit zorgt voor een duidelijke scheiding tussen AI-besluitvorming en uitvoeringslogica.

Definieer tool-schema’s duidelijk:

class CreateIssue {

intent: "create_issue";

issue: {

title: string;

description: string;

team_id: string;

assignee_id: string;

};

}

class SearchIssues {

intent: "search_issues";

query: string;

what_youre_looking_for: string;

}

Bouw vervolgens betrouwbare parsers voor LLM-JSON-uitvoer, gebruik deterministische code om de acties uit te voeren en voer de resultaten terug in de context voor iteratieve workflows.

5. Verenig Uitvoering en Bedrijfsstatus

Veel agent-frameworks scheiden uitvoeringsstatus (bijv. huidige stap in een proces) van bedrijfsstatus (bijv. geschiedenis van tool-oproepen en resultaten). Deze scheiding voegt onnodige complexiteit toe.

Sla in plaats daarvan alle status direct op in het contextwindow en leid de uitvoeringsstatus af uit de reeks gebeurtenissen:

<deploy_backend>

intent: "deploy_backend"

tag: "v1.2.3"

environment: "production"

</deploy_backend>

<error>

error running deploy_backend: Kon geen verbinding maken met de deploymentservice

</error>

Deze verenigde aanpak biedt:

- Eenvoud met één bron van waarheid voor status

- Betere debugging door de volledige geschiedenis op één plek

- Gemakkelijk herstel door op elk punt te hervatten door de thread te laden

AI-Agenten in Productie Brengen

6. Ontwerp API’s voor Starten, Pauzeren en Hervatten

Productieklare agenten moeten naadloos integreren met externe systemen, pauzeren voor langlopende taken en hervatten bij triggers via webhooks of andere events.

Implementeer API’s die het starten, pauzeren en hervatten van agenten mogelijk maken, met robuuste statusopslag tussen operaties. Dit maakt mogelijk:

- Flexibele ondersteuning voor asynchrone workflows

- Schone integratie met webhooks en andere systemen

- Betrouwbaar hervatten na onderbrekingen zonder te herstarten

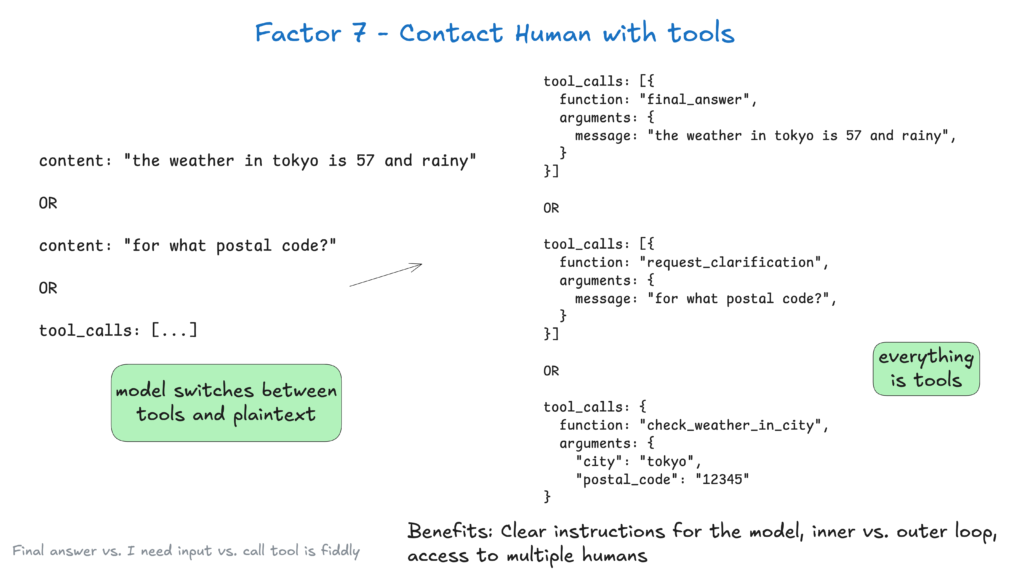

7. Maak Menselijke Samenwerking Mogelijk via Tool-oproepen

AI-agenten hebben vaak menselijke input nodig voor belangrijke beslissingen of onduidelijke situaties. Gebruik van gestructureerde tool-oproepen maakt deze interactie naadloos:

class RequestHumanInput {

intent: "request_human_input";

question: string;

context: string;

options: {

urgency: "low" | "medium" | "high";

format: "free_text" | "yes_no" | "multiple_choice";

choices: string[];

};

}

Deze aanpak biedt een duidelijke specificatie van het interactietype en de urgentie, ondersteunt input van meerdere gebruikers en combineert goed met API’s voor duurzame workflows.

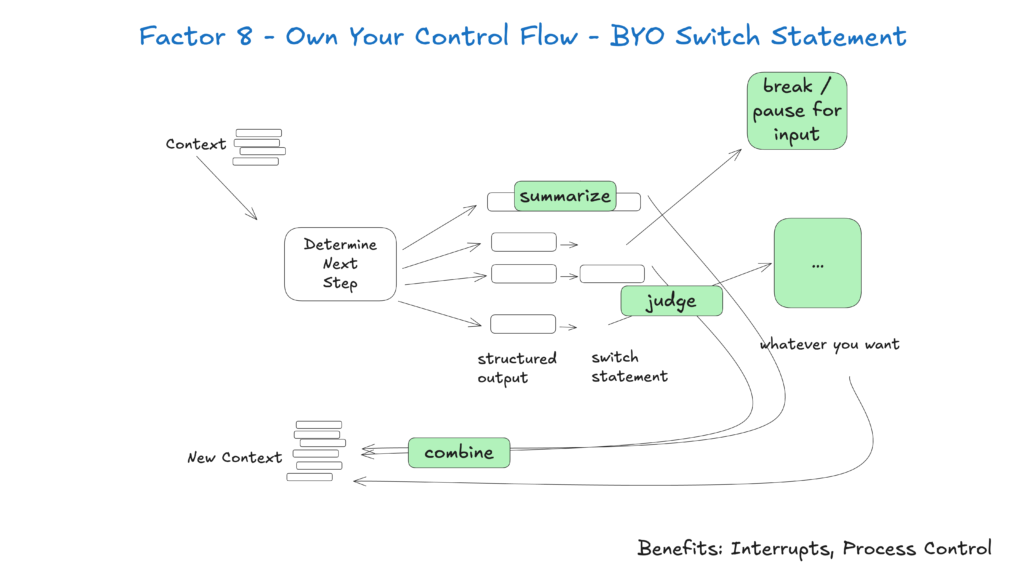

8. Beheer de Flow van je Agent

Aangepaste controlflow stelt je in staat te pauzeren voor menselijke goedkeuring, resultaten te cachen of rate limiting te implementeren—waardoor je het gedrag van de agent afstemt op je behoeften:

async function handleNextStep(thread: Thread) {

while (true) {

const nextStep = await determineNextStep(threadToPrompt(thread));

if (nextStep.intent === 'request_clarification') {

await sendMessageToHuman(nextStep);

await db.saveThread(thread);

break;

} else if (nextStep.intent === 'fetch_open_issues') {

const issues = await linearClient.issues();

thread.events.push({ type: 'fetch_open_issues_result', data: issues });

continue;

}

}

}

Met deze aanpak krijg je:

- Onderbreekbaarheid om te pauzeren voor menselijke review vóór kritieke acties

- Aanpassingsmogelijkheden voor logging, caching of samenvatting

- Betrouwbare afhandeling van langlopende taken

9. Voeg Fouten Compact toe aan de Context voor Zelfherstel

Door fouten direct op te nemen in het contextwindow kunnen AI-agenten leren van mislukkingen en hun aanpak aanpassen:

try {

const result = await handleNextStep(thread, nextStep);

thread.events.push({ type: `${nextStep.intent}_result`, data: result });

} catch (e) {

thread.events.push({ type: 'error', data: formatError(e) });

}

Om dit effectief te laten werken:

- Beperk het aantal herhalingen om oneindige loops te voorkomen

- Schakel over naar mensen na herhaalde fouten

- Formatteer fouten duidelijk zodat de LLM begrijpt wat er misging

Architecturale Best Practices

10. Bouw Kleine, Gefocuste Agenten

Kleine agenten die 3–20 stappen afhandelen, houden contextwindows beheersbaar en verbeteren LLM-prestaties en betrouwbaarheid. Dit biedt:

- Duidelijkheid met een goed omsloten scope per agent

- Minder risico dat de agent de focus verliest

- Eenvoudiger testen en valideren van specifieke functies

Naarmate LLM’s verbeteren, kunnen deze kleine agenten hun scope uitbreiden terwijl de kwaliteit behouden blijft, wat zorgt voor langdurige schaalbaarheid.

11. Maak Triggers Mogelijk vanuit Meerdere Bronnen

Maak je agenten toegankelijk door triggers toe te staan via Slack, e-mail of eventsystemen—waar gebruikers al werken.

Implementeer API’s die agenten starten vanuit verschillende kanalen en via hetzelfde medium reageren. Dit maakt mogelijk:

- Betere toegankelijkheid door integratie met voorkeursplatforms van gebruikers

- Ondersteuning voor event-gedreven automatisering workflows

- Workflows met menselijke goedkeuring voor kritische operaties

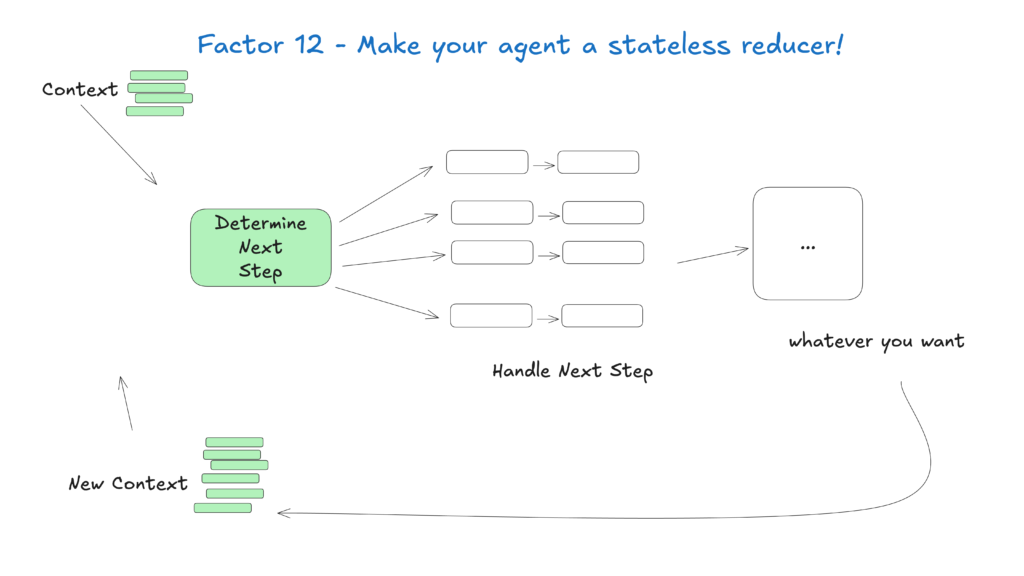

12. Ontwerp Agenten als Stateloze Reducers

Behandel agenten als stateloze functies die inputcontext transformeren naar outputacties. Dit vereenvoudigt statusbeheer, maakt ze voorspelbaar en gemakkelijker te debuggen.

Dit conceptuele model ziet agenten als pure functies zonder interne status, wat oplevert:

- Voorspelbaar gedrag voor gegeven inputs

- Eenvoudiger het opsporen van problemen via de contextgeschiedenis

- Simpler testen en valideren

Bouwen voor de Toekomst

Het veld van AI-agenten ontwikkelt zich snel, maar deze kernprincipes blijven relevant, zelfs als de onderliggende modellen verbeteren. Door te starten met kleine, gefocuste agenten die deze praktijken volgen, kun je systemen creëren die nu waarde leveren en klaar zijn voor toekomstige ontwikkelingen.

Onthoud dat de meest effectieve AI-agenten het redeneervermogen van taalmodellen combineren met de betrouwbaarheid van deterministische code—en deze 12 factoren helpen je die balans te vinden.

Hoe FlowHunt de 12-Factor Methodologie Toepaste

Bij FlowHunt hebben we deze principes in de praktijk gebracht door onze eigen AI-agent te ontwikkelen die automatisch workflow-automatiseringen voor onze klanten creëert. Zo hebben wij de 12-factor methodologie toegepast om een betrouwbaar, productie-klaar systeem te bouwen

Veelgestelde vragen

- Wat is de 12-Factor AI Agent methodologie?

De 12-Factor AI Agent methodologie is een set best practices geïnspireerd op het 12-factor app model, ontworpen om ontwikkelaars te helpen robuuste, onderhoudbare en schaalbare AI-agenten te bouwen die betrouwbaar presteren in echte productieomgevingen.

- Waarom is contextbeheer belangrijk voor AI-agenten?

Contextbeheer zorgt ervoor dat AI-agenten relevante gespreksgeschiedenis, prompts en status behouden, wat de prestaties optimaliseert, het tokengebruik verlaagt en de nauwkeurigheid van besluitvorming verbetert.

- Hoe stellen FlowHunt AI-agenten menselijke samenwerking mogelijk?

FlowHunt AI-agenten structureren tool-oproepen om waar nodig menselijke input te vragen, waardoor naadloze samenwerking, goedkeuringen en duurzame workflows voor complexe of risicovolle scenario's mogelijk zijn.

- Wat zijn de voordelen van het ontwerpen van stateloze AI-agenten?

Stateloze AI-agenten zijn voorspelbaar, eenvoudiger te debuggen en makkelijker te schalen omdat ze inputcontext transformeren naar uitvoeracties zonder verborgen interne status te behouden.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Bouw Schaalbare AI-Agenten met FlowHunt

Klaar om robuuste, productieklare AI-agenten te creëren? Ontdek de tools van FlowHunt en zie hoe de 12-factor methodologie jouw automatisering kan transformeren.