De AI Risk and Controls Guide van KPMG

KPMG’s AI Risk and Controls Guide geeft organisaties een gestructureerde, ethische aanpak voor het beheersen van AI-risico’s en ondersteunt verantwoord gebruik en naleving van wereldwijde standaarden.

Deze eerste statistiek is misschien van vorig jaar, maar is vandaag de dag niet minder relevant. Volgens de KPMG 2024 U.S. CEO Outlook ziet maar liefst 68% van de CEO’s AI als een topprioriteit voor investeringen. Zij rekenen erop dat AI de efficiëntie verhoogt, hun personeel nieuwe vaardigheden bijbrengt en innovatie stimuleert binnen hun organisaties.

Dat is een groot blijk van vertrouwen in AI — maar het roept ook een belangrijke vraag op: met zoveel op het spel, hoe zorgen organisaties ervoor dat ze AI verantwoord en ethisch inzetten?

Hier biedt de KPMG AI Risk and Controls Guide uitkomst. Deze gids biedt een helder, praktisch raamwerk om bedrijven te helpen het potentieel van AI te benutten, terwijl de reële risico’s worden beheerst. In het huidige landschap is het bouwen aan betrouwbare AI niet alleen goed beleid — het is een zakelijke noodzaak.

Kunstmatige intelligentie (AI) revolutioneert sectoren, ontsluit nieuwe niveaus van efficiëntie, innovatie en concurrentievermogen. Maar deze transformatie brengt ook specifieke risico’s en ethische uitdagingen met zich mee, die organisaties zorgvuldig moeten beheren om vertrouwen te behouden en verantwoord gebruik te waarborgen. De KPMG AI Risk and Controls Guide is ontwikkeld om organisaties te ondersteunen bij het navigeren door deze complexiteit en biedt een praktische, gestructureerde en waardengedreven aanpak voor AI-governance.

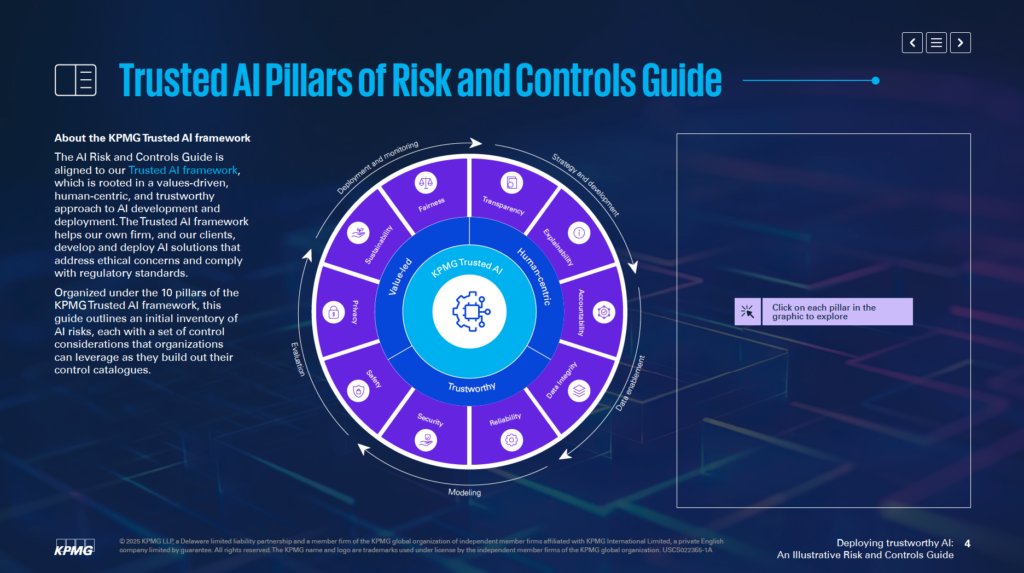

In lijn met KPMG’s Trusted AI Framework helpt deze gids bedrijven om AI-oplossingen te ontwikkelen en toe te passen die ethisch, mensgericht en in overeenstemming met internationale regelgeving zijn. De gids is opgebouwd rond 10 fundamentele pijlers, die elk een cruciaal aspect van AI-risicobeheer adresseren:

- Verantwoording: Duidelijke verantwoordelijkheid voor AI-uitkomsten.

- Eerlijkheid: Bias verminderen en eerlijke uitkomsten bevorderen.

- Transparantie: AI-processen begrijpelijk en zichtbaar maken.

- Verklaarbaarheid: Redenen geven achter AI-beslissingen.

- Dataintegriteit: Zorgen voor hoogwaardige, betrouwbare data.

- Betrouwbaarheid: Consequente en nauwkeurige prestaties leveren.

- Beveiliging: AI-systemen beschermen tegen bedreigingen en kwetsbaarheden.

- Veiligheid: Systemen ontwerpen om schade te voorkomen en risico’s te beperken.

- Privacy: Persoonlijke en gevoelige gegevens beschermen.

- Duurzaamheid: Milieubelasting van AI-systemen minimaliseren.

Door te focussen op deze pijlers kunnen organisaties ethische principes verankeren in elke fase van de AI-levenscyclus—van strategie en ontwikkeling tot implementatie en monitoring. Deze gids verbetert niet alleen de weerbaarheid tegen risico’s, maar stimuleert ook duurzame innovatie die betrouwbaar is en aansluit bij maatschappelijke verwachtingen.

Of je nu risicoprofessional, leidinggevende, data scientist of juridisch adviseur bent, deze gids biedt essentiële tools en inzichten om de kracht van AI verantwoord te benutten.

Doel van de Gids

Inspelen op de Unieke Uitdagingen van AI

De KPMG AI Risk and Controls Guide is een gespecialiseerde bron om organisaties te helpen de specifieke risico’s van kunstmatige intelligentie (AI) te beheersen. De gids erkent dat AI aanzienlijke kansen biedt, maar dat de complexiteit en ethische vraagstukken om een gerichte benadering van risicomanagement vragen. De gids biedt een gestructureerd raamwerk om deze uitdagingen op verantwoorde en effectieve wijze aan te pakken.

Integratie in Bestaande Raamwerken

De gids is niet bedoeld als vervanging van bestaande systemen, maar als aanvulling op de huidige risicomanagementprocessen. Het belangrijkste doel is AI-specifieke aandachtspunten te integreren in de governance-structuren van een organisatie, zodat deze goed aansluiten op de bestaande operationele praktijken. Zo kunnen organisaties hun risicobeheersing versterken zonder hun raamwerken volledig opnieuw te moeten inrichten.

Afstemming op Vertrouwde Standaarden

De gids is gebaseerd op KPMG’s Trusted AI Framework, dat een waardengedreven en mensgerichte aanpak van AI bevordert. Er zijn principes uit breed erkende standaarden in verwerkt, waaronder ISO 42001, het NIST AI Risk Management Framework en de EU AI Act. Zo is de gids zowel praktisch als afgestemd op internationale best practices en regelgeving voor AI-governance.

Een Toolkit voor Praktische Inzichten

De gids biedt toepasbare inzichten en praktische voorbeelden, toegespitst op AI-gerelateerde risico’s. Organisaties worden aangemoedigd deze voorbeelden aan te passen aan hun eigen situatie, afhankelijk van bijvoorbeeld in hoeverre AI-systemen in huis of door leveranciers zijn ontwikkeld, en het type data en technieken dat wordt gebruikt. Dankzij deze flexibiliteit blijft de gids relevant voor diverse sectoren en AI-toepassingen.

Ondersteunen van Ethische en Transparante AI-Implementatie

De gids richt zich op het mogelijk maken van veilige, ethische en transparante inzet van AI-technologieën. Door in te gaan op technische, operationele en ethische aspecten van AI-risico’s, helpt de gids organisaties vertrouwen te kweken bij belanghebbenden, terwijl ze tegelijkertijd profiteren van de transformerende kracht van AI.

De gids fungeert als hulpmiddel om ervoor te zorgen dat AI-systemen aansluiten bij bedrijfsdoelstellingen en tegelijkertijd potentiële risico’s worden beheerst. Zo wordt innovatie gestimuleerd met prioriteit voor verantwoordelijkheid en verantwoording.

Voor Wie Is Deze Gids?

Belangrijkste Stakeholders in AI-Governance

De KPMG AI Governance Guide is bedoeld voor professionals die AI-implementatie beheren en zorgen voor veilige, ethische en effectieve uitrol. De gids is toepasbaar voor teams in uiteenlopende delen van organisaties, waaronder:

- Risico- en Complianceafdelingen: Professionals in deze teams kunnen AI-governancepraktijken afstemmen op bestaande risicoraamwerken en regelgeving.

- Cybersecurityspecialisten: Door het toenemende risico op aanvallen op AI-systemen kunnen cybersecurityteams deze gids gebruiken om sterke beveiligingsmaatregelen te treffen.

- Data Privacy Teams: De gids geeft tools waarmee privacy officers gevoelige informatie verantwoord beheren en compliance-kwesties omtrent persoonsgegevens adresseren.

- Juridische en Regelgevende Teams: Juridisch professionals kunnen vertrouwen op de aansluiting van de gids bij wereldwijde raamwerken zoals AVG, ISO 42001 en de EU AI Act, zodat AI-systemen voldoen aan toepasselijke wetgeving.

- Interne Audit Professionals: Auditors kunnen de gids gebruiken om te beoordelen of AI-systemen ethische en operationele standaarden effectief naleven.

Leiderschap en Strategische Beslissers

C-level executives en senior leiders, zoals CEO’s, CIO’s en CTO’s, profiteren van deze gids bij het managen van AI als strategische prioriteit. Volgens de KPMG 2024 US CEO Outlook beschouwt 68% van de CEO’s AI als een belangrijk investeringsgebied. Met deze gids kan het leiderschap AI-strategieën afstemmen op organisatiedoelen en de bijbehorende risico’s beheersen.

AI-ontwikkelaars en Ingenieurs

Software engineers, data scientists en anderen die verantwoordelijk zijn voor het ontwikkelen en implementeren van AI-oplossingen kunnen de gids gebruiken om ethische principes en robuuste controles direct in hun systemen te integreren. De focus ligt op het aanpassen van risicomanagementpraktijken aan de specifieke architectuur en datastromen van AI-modellen.

Organisaties van Elke Omvang en Sector

De gids is geschikt voor bedrijven die AI-systemen in eigen huis ontwikkelen, inkopen bij leveranciers of werken met eigen datasets. De gids is vooral relevant voor sectoren als financiën, gezondheidszorg en technologie, waar geavanceerde AI-toepassingen en gevoelige data cruciaal zijn voor de operatie.

Waarom Deze Gids Belangrijk Is

AI inzetten zonder een duidelijk governance-raamwerk kan leiden tot financiële, regelgevende en reputatierisico’s. De KPMG-gids werkt samen met bestaande processen en biedt een gestructureerde, ethische aanpak voor AI-beheer. De gids stimuleert verantwoordelijkheid, transparantie en ethisch handelen, zodat organisaties AI verantwoord kunnen gebruiken en tegelijkertijd het volledige potentieel benutten.

Aan de Slag met de Gids

AI-risico’s Afstemmen op Bestaande Risicotaxonomie

Organisaties kunnen beginnen door AI-specifieke risico’s te koppelen aan hun bestaande risicotaxonomie. Een risicotaxonomie is een gestructureerd raamwerk om potentiële kwetsbaarheden te identificeren, ordenen en aanpakken. Omdat AI unieke uitdagingen introduceert, moeten traditionele taxonomieën worden uitgebreid met AI-specifieke factoren. Denk hierbij aan de nauwkeurigheid van datastromen, de achterliggende logica van algoritmen en de betrouwbaarheid van databronnen. Op deze manier worden AI-risico’s onderdeel van het bredere risicomanagement, in plaats van een apart traject.

De gids wijst op het belang van beoordeling van de volledige levenscyclus van AI-systemen. Belangrijke aandachtspunten zijn waar data vandaan komt, hoe deze door processen beweegt en de basislogica van het AI-model. Door deze brede benadering kun je beter bepalen waar kwetsbaarheden kunnen ontstaan tijdens de ontwikkeling en het gebruik van AI.

Controles Afstemmen op Organisatiebehoeften

AI-systemen verschillen qua doel, ontwikkelmethode en het type data dat wordt gebruikt. Of een model nu intern wordt ontwikkeld of extern wordt ingekocht, beïnvloedt de risico’s aanzienlijk. Ook het type data—eigen, openbaar of gevoelig—en de toegepaste technieken vereisen aangepaste strategieën voor risicobeheer.

De gids adviseert om controlemaatregelen aan te passen aan de specifieke behoeften van je AI-systemen. Maak je bijvoorbeeld gebruik van eigen data, dan zijn strengere toegangscontroles wellicht nodig. Gebruik je een AI-systeem van een externe partij, dan is een diepgaande beoordeling van derde partijen vereist. Door deze controles te personaliseren kun je de specifieke uitdagingen van jouw AI-systemen effectiever adresseren.

Risicobewustzijn Inbedden in de AI-levenscyclus

De gids raadt aan om risicomanagementpraktijken te integreren in elke fase van de AI-levenscyclus. Dit omvat risico’s identificeren in de ontwerpfase, sterke monitoringsystemen opzetten bij implementatie en regelmatig risicobeoordelingen actualiseren naarmate het AI-systeem evolueert. Door in elke stap aandacht aan risico’s te besteden, kun je kwetsbaarheden verkleinen en zorgen voor ethische en betrouwbare AI-systemen.

Door te starten met het afstemmen van AI-risico’s op je bestaande risicotaxonomie en controles aan te passen aan je behoeften, leg je een stevige basis voor betrouwbare AI. Zo kunnen organisaties risico’s systematisch identificeren, beoordelen en beheren en bouwen ze aan een robuust raamwerk voor AI-governance.

De 10 Pijlers van Vertrouwde AI

Het KPMG Trusted AI Framework rust op tien kernpijlers die inspelen op de ethische, technische en operationele uitdagingen van kunstmatige intelligentie. Deze pijlers begeleiden organisaties bij het verantwoord ontwerpen, ontwikkelen en implementeren van AI-systemen, zodat vertrouwen en verantwoording centraal staan in de hele AI-levenscyclus.

Verantwoording

Menselijk toezicht en verantwoordelijkheid moeten in elke fase van de AI-levenscyclus aanwezig zijn. Dit betekent vastleggen wie verantwoordelijk is voor het beheren van AI-risico’s, naleving van wet- en regelgeving en het vermogen behouden om AI-beslissingen indien nodig te corrigeren, overrulen of terug te draaien.

Eerlijkheid

AI-systemen moeten bias verminderen of elimineren die individuen, gemeenschappen of groepen negatief kan beïnvloeden. Dit vraagt om een zorgvuldige analyse van data om representativiteit te verzekeren, het toepassen van eerlijkheidsmaatregelen tijdens ontwikkeling en voortdurende monitoring van uitkomsten voor gelijke behandeling.

Transparantie

Transparantie vereist openheid over de werking van AI-systemen en de redenen achter specifieke beslissingen. Dit omvat documentatie van systeemlimieten, prestatiemetingen en testmethoden. Gebruikers moeten geïnformeerd worden wanneer hun gegevens worden verzameld, AI-gegenereerde content moet duidelijk als zodanig zijn gelabeld en gevoelige toepassingen zoals biometrische categorisatie vereisen heldere gebruikersmeldingen.

Verklaarbaarheid

AI-systemen moeten begrijpelijke redenen geven voor hun beslissingen. Dit vraagt om gedetailleerde documentatie van datasets, algoritmen en prestatie-indicatoren, zodat belanghebbenden resultaten kunnen analyseren en reproduceren.

Dataintegriteit

De kwaliteit en betrouwbaarheid van data gedurende de gehele levenscyclus—van verzameling, labeling, opslag tot analyse—is essentieel. Er moeten controles zijn om risico’s als datacorruptie of bias te beperken. Regelmatige kwaliteitscontroles en regressietests bij systeemupdates helpen de nauwkeurigheid en betrouwbaarheid van AI-systemen te waarborgen.

Privacy

AI-oplossingen moeten voldoen aan privacy- en databeschermingswetten. Organisaties dienen verzoeken van betrokkenen correct af te handelen, privacy-impactanalyses uit te voeren en geavanceerde methoden als differentiële privacy toe te passen om bruikbaarheid van data te balanceren met bescherming van privacy.

Betrouwbaarheid

AI-systemen moeten consistent presteren volgens hun beoogde doel en vereiste nauwkeurigheid. Dit vereist grondige tests, mechanismen voor het detecteren van afwijkingen en voortdurende feedbackloops om systeemoutput te valideren.

Veiligheid

Veiligheidsmaatregelen beschermen AI-systemen tegen schade aan individuen, bedrijven of eigendommen. Denk aan fail-safes, monitoring op issues als datavervuiling of prompt-injectie-aanvallen, en het zorgen dat systemen aansluiten bij ethische en operationele standaarden.

Beveiliging

Sterke beveiligingspraktijken zijn nodig om AI-systemen te beschermen tegen bedreigingen en kwaadwillende activiteiten. Organisaties moeten regelmatig audits uitvoeren, kwetsbaarheden beoordelen en encryptie inzetten ter bescherming van gevoelige data.

Duurzaamheid

AI-systemen moeten ontworpen zijn om energieverbruik te minimaliseren en milieu-ambities te ondersteunen. Duurzaamheidsoverwegingen horen vanaf het begin bij het ontwerpproces, met voortdurende monitoring van energieverbruik, efficiëntie en uitstoot tijdens de gehele AI-levenscyclus.

Door deze tien pijlers te volgen, kunnen organisaties AI-systemen creëren die ethisch, betrouwbaar en afgestemd zijn op maatschappelijke verwachtingen. Dit raamwerk biedt een heldere structuur voor het beheren van AI-uitdagingen en bevordert verantwoorde innovatie.

Belangrijkste Risico’s en Controles – Dataintegriteit

Dataintegriteit in AI-systemen

Dataintegriteit is cruciaal om AI-systemen accuraat, eerlijk en betrouwbaar te houden. Slecht databeheer kan leiden tot risico’s als bias, onnauwkeurigheid en onbetrouwbare resultaten. Zulke problemen ondermijnen het vertrouwen in AI-output en kunnen leiden tot grote operationele en reputatieschade. Het KPMG Trusted AI Framework benadrukt het belang van hoogwaardige data gedurende de volledige levenscyclus om AI-systemen effectief te laten functioneren en ethische standaarden te halen.

Belangrijkste Risico’s bij Dataintegriteit

Gebrek aan Datagovernance

Zonder goed databeheer kunnen AI-systemen foutieve resultaten opleveren. Problemen als onvolledige, onnauwkeurige of irrelevante data leiden tot bevooroordeelde of onbetrouwbare uitkomsten en vergroten de risico’s bij verschillende AI-toepassingen.

Datacorruptie Tijdens Overdracht

Data wordt vaak uitgewisseld tussen systemen voor bijvoorbeeld training, testen of operationeel gebruik. Als deze overdrachten niet goed verlopen, kan data corrupt, verloren of beschadigd raken, wat de prestaties van AI-systemen beïnvloedt.

Controlemaatregelen om Risico’s te Verlagen

Uitgebreid Datagovernancebeleid Ontwikkelen

Om datagovernance te verbeteren, kunnen organisaties:

- Beleidsmaatregelen opstellen en handhaven voor dataverzameling, opslag, labeling en analyse.

- Lifecycle managementprocessen implementeren om data accuraat, compleet en relevant te houden.

- Regelmatig kwaliteitscontroles uitvoeren om snel problemen te signaleren en te herstellen.

Bescherming bij Dataoverdrachten

Om risico’s bij dataoverdracht te minimaliseren, moeten organisaties:

- Veilige protocollen gebruiken om corruptie of verlies van data te voorkomen.

- Trainings- en testdatasets regelmatig herzien, vooral bij systeemupdates, om te waarborgen dat ze adequaat en relevant blijven. Dit omvat het toevoegen van nieuwe data indien nodig om de prestaties op peil te houden.

Voortdurende Monitoring en Validatie

Doorlopende monitoringsystemen helpen de dataintegriteit gedurende de AI-levenscyclus te behouden. Deze systemen kunnen problemen signaleren zoals onverwachte veranderingen in gegevenskwaliteit of inconsistenties in dataverwerking, waardoor snel corrigerende maatregelen kunnen worden getroffen.

Conclusie

Het behouden van dataintegriteit is essentieel voor betrouwbare AI-systemen. Organisaties kunnen risico’s verkleinen door sterke governance-raamwerken op te zetten, data-interacties te beschermen en continu validatieprocessen te onderhouden. Zo verbetert de betrouwbaarheid van AI-uitkomsten en worden ethische en operationele standaarden gehaald, wat bijdraagt aan vertrouwen in AI-technologie.

Belangrijkste Risico’s en Controles – Privacy

Privacy van Betrokkene bij Toegangsverzoeken

Het afhandelen van verzoeken van betrokkenen is een grote privacy-uitdaging bij AI. Organisaties moeten zorgen dat individuen hun rechten kunnen uitoefenen om persoonlijke informatie in te zien, te corrigeren of te verwijderen onder wetgeving als AVG en CCPA. Als deze verzoeken niet correct worden behandeld, kan dat leiden tot overtredingen, verlies van vertrouwen en reputatieschade.

Om dit risico te beperken, moeten bedrijven programma’s opzetten om individuen te informeren over hun gegevensrechten bij interactie met AI. Systemen moeten verzoeken snel en transparant kunnen verwerken. Organisaties dienen ook nauwkeurige registraties bij te houden van de afhandeling om tijdens audits naleving te bewijzen.

Privacyovertredingen door Datalekken

AI-systemen verwerken vaak gevoelige persoonsgegevens, wat ze aantrekkelijke doelwitten maakt voor cyberaanvallen. Een datalek kan leiden tot hoge boetes, reputatieschade en verlies van klantvertrouwen.

Daarom adviseert het KPMG Trusted AI Framework ethische beoordelingen uit te voeren voor AI-systemen die persoonsgegevens gebruiken, zodat ze aan privacyregelgeving voldoen. Regelmatige audits van gegevensbescherming en privacy-impactanalyses (PIA’s) zijn noodzakelijk, vooral bij gebruik van gevoelige data voor training van AI-modellen. Daarnaast kunnen technieken als differentiële privacy, waarbij statistische ruis aan data wordt toegevoegd, informatie anonimiseren terwijl analyse mogelijk blijft.

Geen Privacy by Design

AI-systemen zonder vanaf het begin ingebouwde privacymaatregelen kunnen serieuze problemen veroorzaken. Zonder privacy-by-design lopen organisaties het risico gevoelige data bloot te stellen of wettelijke eisen niet na te leven.

Bedrijven moeten privacymaatregelen direct in de ontwikkelfase van AI-systemen verwerken. Dit betekent privacywetgeving en databeschermingsregels volgen via sterk databeheer. Duidelijke documentatie over hoe data wordt verzameld, gebruikt en opgeslagen is cruciaal. Organisaties moeten ook expliciet toestemming vragen voor data-inzameling en verwerking, vooral bij gevoelige gegevens zoals biometrie.

Transparantie bij Gebruikersinteracties

Wanneer AI-systemen niet duidelijk maken hoe gebruikersdata wordt verwerkt, kan dit leiden tot wantrouwen en juridische toetsing. Gebruikers moeten weten wanneer hun gegevens worden verzameld en hoe deze worden gebruikt

Veelgestelde vragen

- Wat is de KPMG AI Risk and Controls Guide?

De KPMG AI Risk and Controls Guide is een praktisch raamwerk dat organisaties helpt de unieke risico’s van AI te beheren, zodat AI op een verantwoorde, ethische en conforme wijze wordt ingezet in diverse sectoren.

- Wat zijn de 10 pijlers van KPMG’s Trusted AI Framework?

De gids is opgebouwd rond tien belangrijke pijlers: Verantwoording, Eerlijkheid, Transparantie, Verklaarbaarheid, Dataintegriteit, Betrouwbaarheid, Beveiliging, Veiligheid, Privacy en Duurzaamheid—elk gericht op cruciale aspecten van AI-risicobeheer.

- Voor wie is de KPMG AI Risk and Controls Guide bedoeld?

De gids is bedoeld voor risicoprofessionals, compliance teams, cybersecurityspecialisten, juridisch adviseurs, leidinggevenden, AI-ontwikkelaars, ingenieurs en organisaties van elke omvang die AI verantwoord willen beheren.

- Hoe ondersteunt de gids naleving van regelgeving?

De gids sluit aan bij internationale standaarden zoals ISO 42001, het NIST AI Risk Management Framework en de EU AI Act, en helpt organisaties AI-specifieke controles te integreren in bestaande governanceprocessen en aan regelgeving te voldoen.

- Welke praktische controles beveelt de gids aan?

De gids stelt maatregelen voor als sterk databeheer, privacy by design, continue monitoring, transparantie in AI-beslissingen, anomaliedetectie, feedbackloops en duurzaamheidsdoelstellingen om AI-gerelateerde risico’s te verkleinen.

Beheer AI-risico’s Verantwoord

Ontdek hoe de AI Risk and Controls Guide van KPMG jouw organisatie kan helpen AI-innovatie te omarmen, terwijl ethische, veilige en conforme implementatie wordt gewaarborgd.