Wan 2.1: De Open-Source AI Video Generatie Revolutie

Wan 2.1 is een krachtig open-source AI video generatiemodel van Alibaba, dat studio-kwaliteit video’s levert vanuit tekst of afbeeldingen, gratis en lokaal te gebruiken voor iedereen.

Wat is Wan 2.1?

Wan 2.1 (ook wel WanX 2.1 genoemd) breekt nieuwe grond als een volledig open-source AI video generatiemodel ontwikkeld door Alibaba’s Tongyi Lab. In tegenstelling tot veel propriëtaire video generatiesystemen die dure abonnementen of API-toegang vereisen, levert Wan 2.1 vergelijkbare of superieure kwaliteit terwijl het volledig gratis en toegankelijk is voor ontwikkelaars, onderzoekers en creatieve professionals.

Wat Wan 2.1 echt bijzonder maakt is de combinatie van toegankelijkheid en prestaties. De kleinere T2V-1.3B-variant vereist slechts ~8,2 GB GPU-geheugen, waardoor deze compatibel is met de meeste moderne consumentengpu’s. Ondertussen levert de grotere 14B-parameter versie prestaties van topniveau, die zowel open-source alternatieven als veel commerciële modellen op standaardbenchmarks overtreffen.

Belangrijkste kenmerken die Wan 2.1 onderscheiden

Multi-Task Ondersteuning

Wan 2.1 is niet beperkt tot alleen tekst-naar-video generatie. De veelzijdige architectuur ondersteunt:

- Tekst-naar-video (T2V)

- Afbeelding-naar-video (I2V)

- Video-naar-video bewerking

- Tekst-naar-afbeelding generatie

- Video-naar-audio generatie

Deze flexibiliteit betekent dat je kunt starten met een tekstprompt, een stilstaande afbeelding of zelfs een bestaande video, en deze naar eigen creatieve inzicht kunt transformeren.

Meertalige Tekstgeneratie

Als het eerste videomodel dat leesbare Engelse en Chinese tekst kan weergeven in gegenereerde video’s, opent Wan 2.1 nieuwe mogelijkheden voor internationale contentmakers. Deze functie is vooral waardevol voor het maken van ondertiteling of scene-tekst in meertalige video’s.

Revolutionaire Video VAE (Wan-VAE)

De kern van Wan 2.1’s efficiëntie is de 3D causale Video Variational Autoencoder. Deze technologische doorbraak comprimeert ruimtelijk-temporele informatie efficiënt, waardoor het model:

- Video’s honderden keren kan verkleinen in grootte

- Bewegings- en detailgetrouwheid behoudt

- Hoge resolutie-uitvoer tot 1080p ondersteunt

Uitzonderlijke Efficiëntie en Toegankelijkheid

Het kleinere 1.3B-model vereist slechts 8,19 GB VRAM en kan een video van 5 seconden op 480p produceren in ongeveer 4 minuten op een RTX 4090. Ondanks deze efficiëntie is de kwaliteit vergelijkbaar met of beter dan die van veel grotere modellen, waardoor het een perfecte balans biedt tussen snelheid en visuele kwaliteit.

Toonaangevende Benchmarks & Kwaliteit

In publieke evaluaties behaalde Wan 14B de hoogste totaalscore in de Wan-Bench-tests en overtrof concurrenten op het gebied van:

- Bewegingskwaliteit

- Stabiliteit

- Nauwkeurigheid van prompt-opvolging

Hoe Wan 2.1 zich verhoudt tot andere video generatiemodellen

In tegenstelling tot gesloten systemen zoals OpenAI’s Sora of Runway’s Gen-2, is Wan 2.1 vrij beschikbaar om lokaal uit te voeren. Het overtreft doorgaans eerdere open-source modellen (zoals CogVideo, MAKE-A-VIDEO en Pika) en zelfs veel commerciële oplossingen wat betreft kwaliteitsbenchmarks.

Een recent brancheonderzoek merkte op dat “onder vele AI-videomodellen Wan 2.1 en Sora eruit springen” – Wan 2.1 vanwege openheid en efficiëntie, en Sora vanwege propriëtaire innovatie. In community-tests melden gebruikers dat de afbeelding-naar-video capaciteit van Wan 2.1 concurrenten overtreft qua helderheid en filmische uitstraling.

De Technologie Achter Wan 2.1

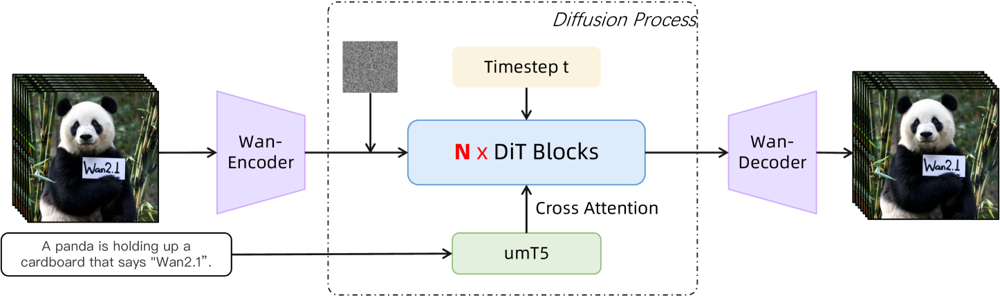

Wan 2.1 is gebouwd op een diffusion-transformer backbone met een nieuwe ruimtelijk-temporele VAE. Zo werkt het:

- Een input (tekst en/of afbeelding/video) wordt gecodeerd tot een latente video representatie door Wan-VAE

- Een diffusion transformer (gebaseerd op de DiT-architectuur) verwijdert iteratief ruis uit deze latente

- Het proces wordt geleid door de tekstencoder (een meertalige T5-variant genaamd umT5)

- Ten slotte reconstrueert de Wan-VAE decoder de uitvoervideoframes

Figuur: De high-level architectuur van Wan 2.1 (tekst-naar-video geval). Een video (of afbeelding) wordt eerst gecodeerd door de Wan-VAE encoder tot een latente. Deze latente wordt vervolgens door N diffusion transformer blocks gestuurd, die via cross-attention letten op de tekstembedding (van umT5). Uiteindelijk reconstrueert de Wan-VAE decoder de videoframes. Dit ontwerp – met een “3D causale VAE encoder/decoder rondom een diffusion transformer” (ar5iv.org) – maakt efficiënte compressie van ruimtelijk-temporele data mogelijk en ondersteunt video-uitvoer van hoge kwaliteit.

Deze innovatieve architectuur — met een “3D causale VAE encoder/decoder rondom een diffusion transformer” — maakt efficiënte compressie van ruimtelijk-temporele data mogelijk en ondersteunt video-uitvoer van hoge kwaliteit.

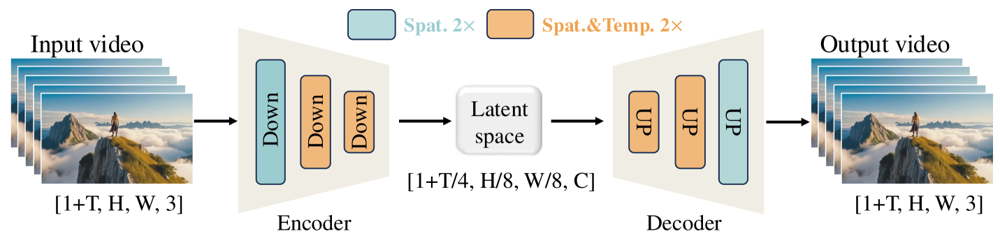

De Wan-VAE is speciaal ontworpen voor video’s. De input wordt indrukwekkend gecomprimeerd (tijdelijk 4× en ruimtelijk 8×) tot een compacte latente voordat deze weer naar volledige video wordt gedecodeerd. Door 3D-convoluties en causale (tijd-behoudende) lagen te gebruiken, wordt coherente beweging in de gegenereerde content gewaarborgd.

Figuur: Wan 2.1’s Wan-VAE framework (encoder-decoder). De Wan-VAE encoder (links) past een serie down-sampling lagen (“Down”) toe op de inputvideo (vorm [1+T, H, W, 3] frames) tot een compacte latente ([1+T/4, H/8, W/8, C]) wordt bereikt. De Wan-VAE decoder (rechts) upsamplet (“UP”) deze latente weer naar de oorspronkelijke videoframes. Blauwe blokken geven ruimtelijke compressie aan, oranje blokken gecombineerde ruimtelijke+tijdelijke compressie (ar5iv.org). Door de video met 256× (in ruimtelijk-temporeel volume) te comprimeren, maakt Wan-VAE hoge resolutie video modellering haalbaar voor het daaropvolgende diffusie model.

Hoe draai je Wan 2.1 op je eigen computer

Klaar om Wan 2.1 zelf te proberen? Zo ga je aan de slag:

Systeemeisen

- Python 3.8+

- PyTorch ≥2.4.0 met CUDA-ondersteuning

- NVIDIA GPU (8GB+ VRAM voor 1.3B-model, 16-24GB voor 14B-modellen)

- Extra libraries uit de repository

Installatiestappen

Clone de repository en installeer afhankelijkheden:

git clone https://github.com/Wan-Video/Wan2.1.git cd Wan2.1 pip install -r requirements.txtDownload modelgewichten:

pip install "huggingface_hub[cli]" huggingface-cli login huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14BGenereer je eerste video:

python generate.py --task t2v-14B --size 1280*720 \ --ckpt_dir ./Wan2.1-T2V-14B \ --prompt "Een futuristische stadsgezicht bij zonsondergang, met vliegende auto’s die bovenlangs zoemen."

Prestatietips

- Voor computers met beperkt GPU-geheugen, probeer het lichtere t2v-1.3B model

- Gebruik de vlaggen

--offload_model True --t5_cpuom delen van het model naar de CPU te verplaatsen - Beheer de beeldverhouding met de parameter

--size(bijv. 832*480 voor 16:9 480p) - Wan 2.1 biedt prompt-extensie en “inspiratiemodus” via extra opties

Ter referentie: een RTX 4090 kan een video van 5 seconden op 480p genereren in ongeveer 4 minuten. Multi-GPU setups en verschillende prestatie-optimalisaties (FSDP, kwantisatie, enz.) worden ondersteund voor grootschalig gebruik.

Waarom Wan 2.1 belangrijk is voor de toekomst van AI video

Als een open-source krachtpatser die de giganten in AI video generatie uitdaagt, vertegenwoordigt Wan 2.1 een grote verschuiving in toegankelijkheid. Door de gratis en open aard kan iedereen met een degelijke GPU geavanceerde video generatie verkennen zonder abonnementskosten of API-tarieven.

Voor ontwikkelaars maakt de open-source licentie maatwerk en verbetering van het model mogelijk. Onderzoekers kunnen de mogelijkheden uitbreiden, terwijl creatieve professionals snel en efficiënt videoproducties kunnen prototypen.

In een tijdperk waarin propriëtaire AI-modellen steeds vaker achter betaalmuren worden geplaatst, laat Wan 2.1 zien dat prestaties op topniveau gedemocratiseerd en gedeeld kunnen worden met de bredere gemeenschap.

Veelgestelde vragen

- Wat is Wan 2.1?

Wan 2.1 is een volledig open-source AI video generatiemodel ontwikkeld door Alibaba’s Tongyi Lab, in staat om hoogwaardige video’s te maken vanuit tekstprompts, afbeeldingen of bestaande video’s. Het is gratis te gebruiken, ondersteunt meerdere taken en draait efficiënt op consumentengpu’s.

- Welke functies maken Wan 2.1 uniek?

Wan 2.1 ondersteunt multi-task video generatie (tekst-naar-video, afbeelding-naar-video, video bewerken, enz.), meertalige tekstrendering in video’s, hoge efficiëntie door de 3D causale Video VAE en presteert beter dan veel commerciële en open-source modellen in benchmarks.

- Hoe kan ik Wan 2.1 op mijn eigen computer draaien?

Je hebt Python 3.8+, PyTorch 2.4.0+ met CUDA en een NVIDIA GPU nodig (8GB+ VRAM voor het kleine model, 16-24GB voor het grote model). Clone de GitHub-repo, installeer de afhankelijkheden, download de modelgewichten en gebruik de geleverde scripts om lokaal video’s te genereren.

- Waarom is Wan 2.1 belangrijk voor AI video generatie?

Wan 2.1 democratiseert toegang tot geavanceerde video generatie door open-source en gratis te zijn, waardoor ontwikkelaars, onderzoekers en creatieven kunnen experimenteren en innoveren zonder betaalmuren of eigendomsbeperkingen.

- Hoe verhoudt Wan 2.1 zich tot modellen als Sora of Runway Gen-2?

In tegenstelling tot gesloten alternatieven zoals Sora of Runway Gen-2 is Wan 2.1 volledig open-source en lokaal te draaien. Het overtreft doorgaans eerdere open-source modellen en evenaart of overtreft veel commerciële oplossingen op gebied van kwaliteit in benchmarks.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Probeer FlowHunt en Bouw AI Oplossingen

Begin met het bouwen van je eigen AI-tools en video generatieworkflows met FlowHunt of plan een demo om het platform in actie te zien.