Componentbeschrijving

Hoe de LLM Anthropic AI-component werkt

Verschillende taken vragen om verschillende modellen, en FlowHunt zet zich in om jou het beste van AI te bieden zonder dat je je hoeft aan te melden voor talloze abonnementen. In plaats daarvan krijg je tientallen tekst- en afbeeldingsgeneratoren in één dashboard. Het LLM-type componenten huisvest tekstgeneratie en hun diverse toepassingen in AI, contentcreatie en automatisering, gegroepeerd per aanbieder, waardoor je AI-modellen direct kunt wisselen.

Wat is de LLM Anthropic AI-component?

De LLM Anthropic AI-component verbindt de Claude-familie van modellen met je flow. Terwijl de Generators en Agents zorgen voor de daadwerkelijke magie, kun je met LLM-componenten bepalen welk model wordt gebruikt. Alle componenten zijn standaard uitgerust met ChatGPT-4. Je kunt deze component koppelen als je het model wilt wijzigen of meer controle wilt uitoefenen.

Onthoud dat het koppelen van een LLM-component optioneel is. Alle componenten die een LLM gebruiken, zijn standaard voorzien van ChatGPT-4o. Met de LLM-componenten kun je het model wijzigen en de modelinstellingen aanpassen.

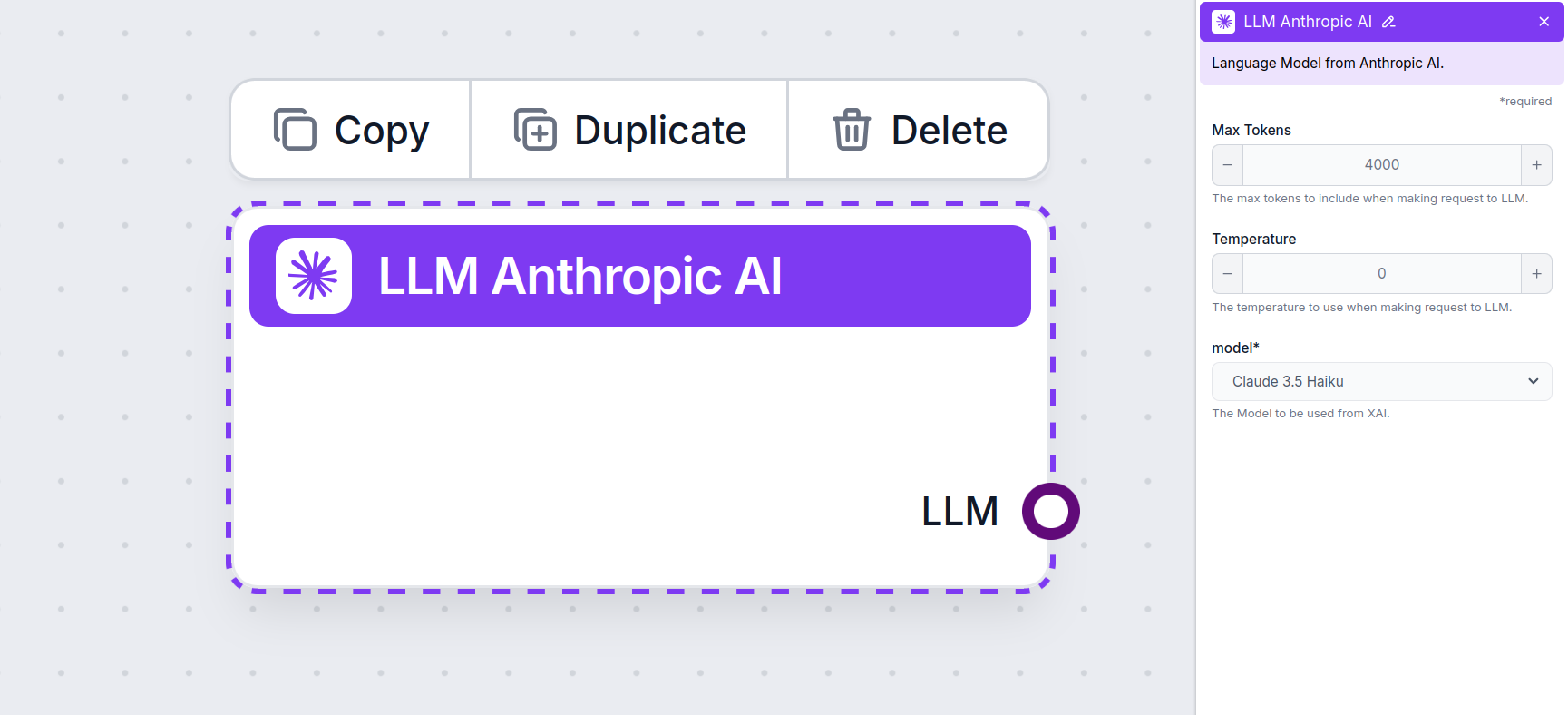

LLM Anthropic AI-componentinstellingen

Max Tokens

Tokens vertegenwoordigen de individuele eenheden tekst die het model verwerkt en genereert. Het tokengebruik verschilt per model, en een enkele token kan variëren van een woord of deel van een woord tot een enkel teken. Modellen worden meestal afgerekend per miljoen tokens.

De instelling voor maximale tokens beperkt het totale aantal tokens dat in één interactie of verzoek kan worden verwerkt, zodat de antwoorden binnen redelijke grenzen blijven. De standaardlimiet is 4.000 tokens, wat een optimale grootte is voor het samenvatten van documenten en meerdere bronnen om een antwoord te genereren.

Temperatuur

Temperatuur bepaalt de variatie in antwoorden, met een bereik van 0 tot 1.

- Een temperatuur van 0,1 zorgt voor zeer directe, maar mogelijk repetitieve en gebrekkige antwoorden.

- Een hoge temperatuur van 1 geeft maximale creativiteit in de antwoorden, maar brengt het risico van irrelevante of zelfs hallucinatoire reacties met zich mee.

Voor bijvoorbeeld een klantenservicebot wordt een temperatuur van tussen 0,2 en 0,5 aanbevolen. Dit niveau houdt de antwoorden relevant en volgens het script, terwijl het toch enige natuurlijke variatie toelaat.

Model

Dit is de modelkiezer. Hier vind je alle ondersteunde modellen van Anthropic. We ondersteunen momenteel alle nieuwste modellen uit de Claude-familie:

- Claude 3.5 Sonnet – De nieuwste versie van Claude’s mid-range model. Dit model combineert snelheid en kwaliteit, waardoor het geschikt is voor de meeste taken. Lees hier meer.

- Claude 3 Sonnet – Een oudere versie van het populaire mid-range model. Bekijk ons artikel om te zien hoe goed het zich verhoudt.

- Claude 3 Haiku – Licht en snel model, ideaal voor het uitvoeren van eenvoudige taken in bulk. Ondanks dat het het minst krachtig is, presteert het nog steeds goed bij complexere taken. Zie onze volledige test van het model.

- Claude 2 – Een sterk presterend, ouder model. Lees hier meer over hoe het denkt.

Hoe voeg je de LLM Anthropic AI toe aan je flow

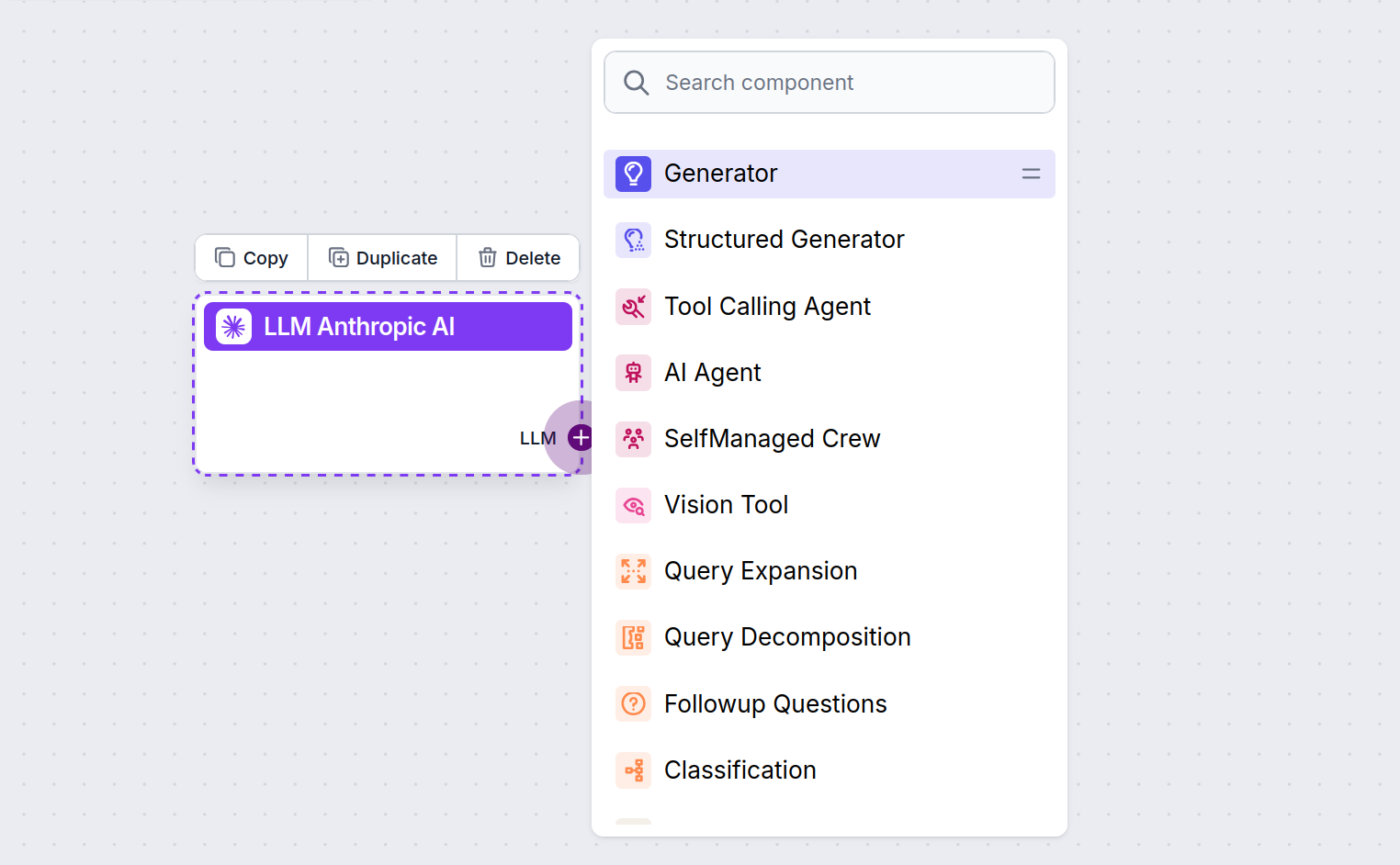

Je zult merken dat alle LLM-componenten alleen een output-handle hebben. Input gaat niet door de component, want deze vertegenwoordigt alleen het model, terwijl de daadwerkelijke generatie gebeurt in AI Agents en Generators.

De LLM-handle is altijd paars. De LLM-input-handle vind je op elke component die AI gebruikt om tekst te genereren of gegevens te verwerken. Je ziet de opties door op de handle te klikken:

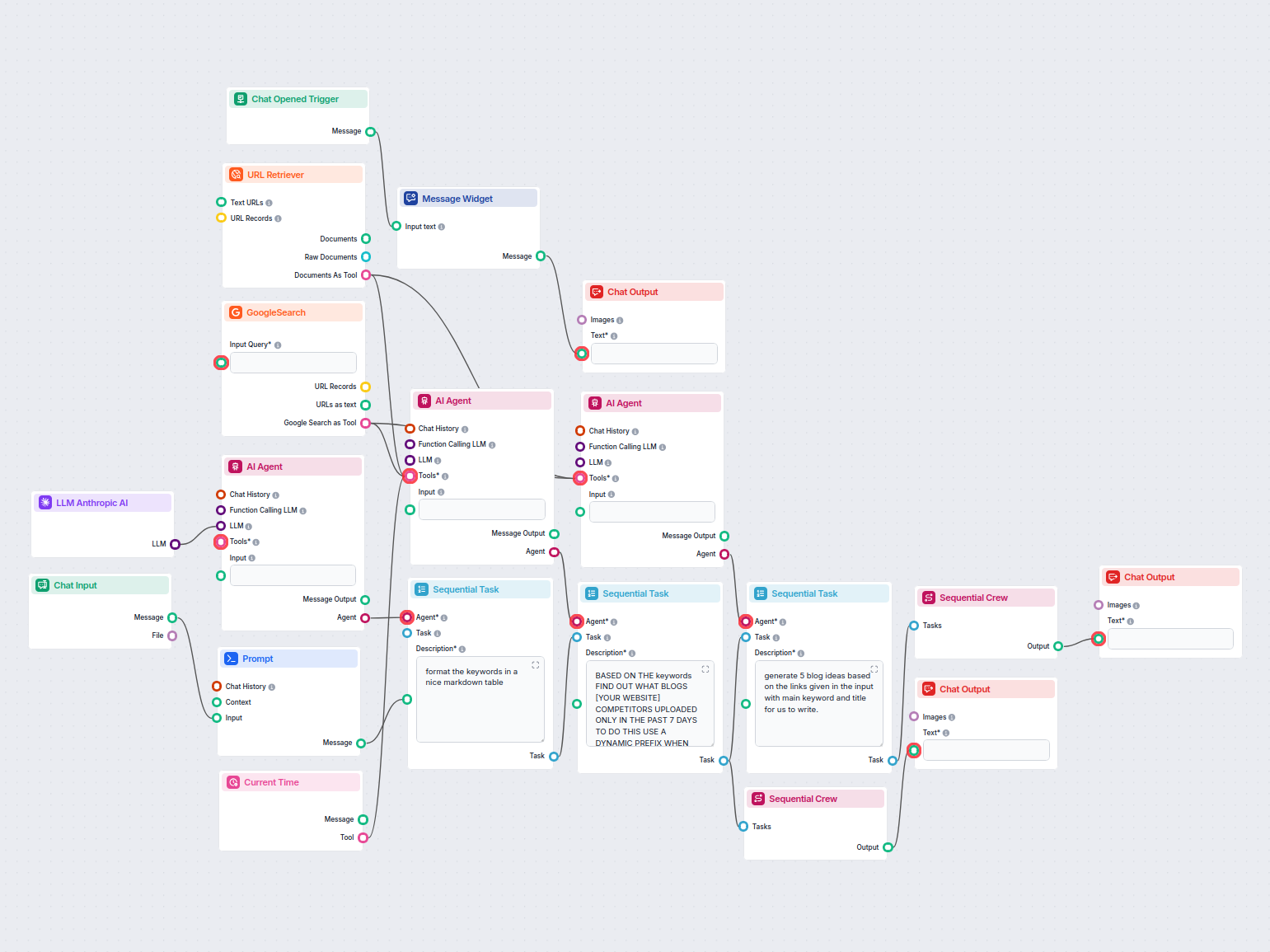

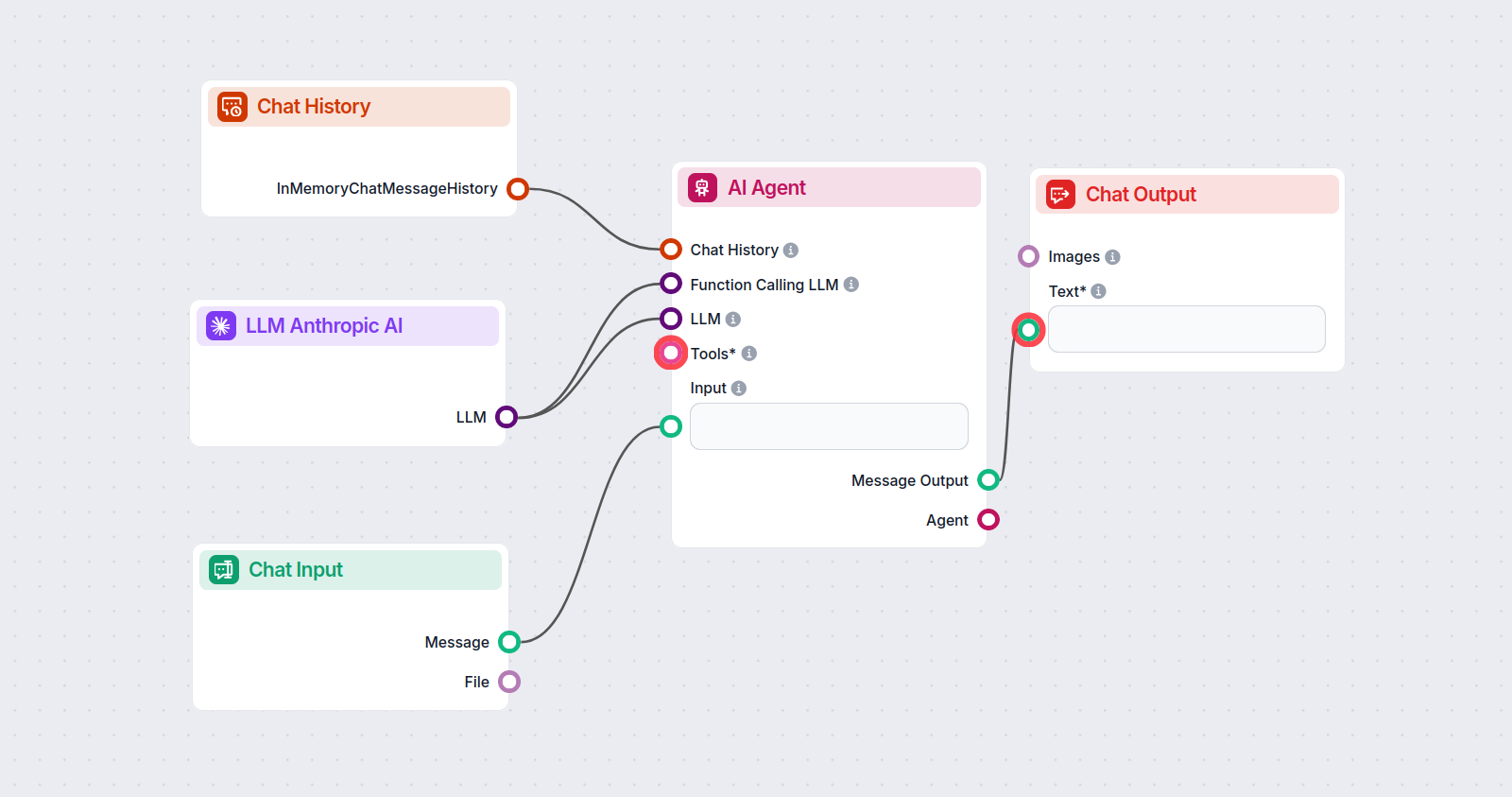

Hiermee kun je allerlei soorten tools bouwen. Laten we de component in actie zien. Hier is een eenvoudige AI Agent-chatbotflow die Anthropic’s Claude 3.5 Sonnet gebruikt om antwoorden te genereren. Je kunt het zien als een basis Anthropic-chatbot.

Deze eenvoudige Chatbot Flow bevat:

- Chat input: Vertegenwoordigt het bericht dat een gebruiker in de chat stuurt.

- Chatgeschiedenis: Zorgt ervoor dat de chatbot eerdere antwoorden kan onthouden en meenemen.

- Chat output: Vertegenwoordigt het uiteindelijke antwoord van de chatbot.

- AI Agent: Een autonome AI-agent die antwoorden genereert.

- LLM Anthropic AI: De koppeling met Anthropic’s tekstgeneratiemodellen.

Voorbeelden van flowsjablonen met LLM Anthropic AI-component

Om u snel op weg te helpen, hebben we verschillende voorbeeld-flowsjablonen voorbereid die laten zien hoe u de LLM Anthropic AI-component effectief kunt gebruiken. Deze sjablonen tonen verschillende gebruikscases en best practices, waardoor het voor u gemakkelijker wordt om de component te begrijpen en te implementeren in uw eigen projecten.

Veelgestelde vragen

- Wat is de LLM Anthropic AI-component in FlowHunt?

De LLM Anthropic AI-component verbindt Anthropic’s Claude-modellen met je FlowHunt-flows, waardoor je kunt bepalen welk model wordt gebruikt voor tekstgeneratie en instellingen zoals maximale tokens en temperatuur kunt aanpassen.

- Welke Claude-modellen worden ondersteund?

FlowHunt ondersteunt alle nieuwste modellen uit de Claude-familie, waaronder Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku en Claude 2.

- Waarvoor dienen max tokens en temperatuur?

Max tokens bepaalt de lengtelimiet voor elk antwoord, terwijl temperatuur de willekeurigheid regelt—lagere waarden zorgen voor gefocuste output, hogere waarden verhogen de creativiteit.

- Is het verplicht om een LLM Anthropic AI-component te koppelen?

Nee, het koppelen van de LLM Anthropic AI-component is optioneel. Standaard gebruiken componenten ChatGPT-4o, maar je kunt deze component toevoegen om over te schakelen naar Claude-modellen en instellingen te verfijnen.

Probeer FlowHunt’s LLM Anthropic AI

Begin met het bouwen van op maat gemaakte AI-tools en chatbots met behulp van Anthropic’s Claude-modellen, dankzij eenvoudige flow-integratie en krachtige configuratie.