LLM Meta AI

FlowHunt’s LLM Meta AI brengt Meta’s Llama-modellen en tientallen andere AI-modellen samen in één eenvoudig te bedienen dashboard voor flexibele tekst- en beeldgeneratie.

Componentbeschrijving

Hoe de LLM Meta AI-component werkt

Wat is de LLM Meta AI-component?

De LLM Meta AI-component verbindt de Claude-familie van modellen met je Flow. Terwijl de Generatoren en Agenten zorgen voor de daadwerkelijke magie, stellen LLM-componenten je in staat om het gebruikte model te beheren. Alle componenten worden standaard geleverd met ChatGPT-4. Je kunt dit component koppelen als je het model wilt wijzigen of er meer controle over wilt hebben.

Onthoud dat het verbinden van een LLM-component optioneel is. Alle componenten die een LLM gebruiken, zijn standaard uitgerust met ChatGPT-4o. Met de LLM-componenten kun je het model wijzigen en de modelinstellingen beheren.

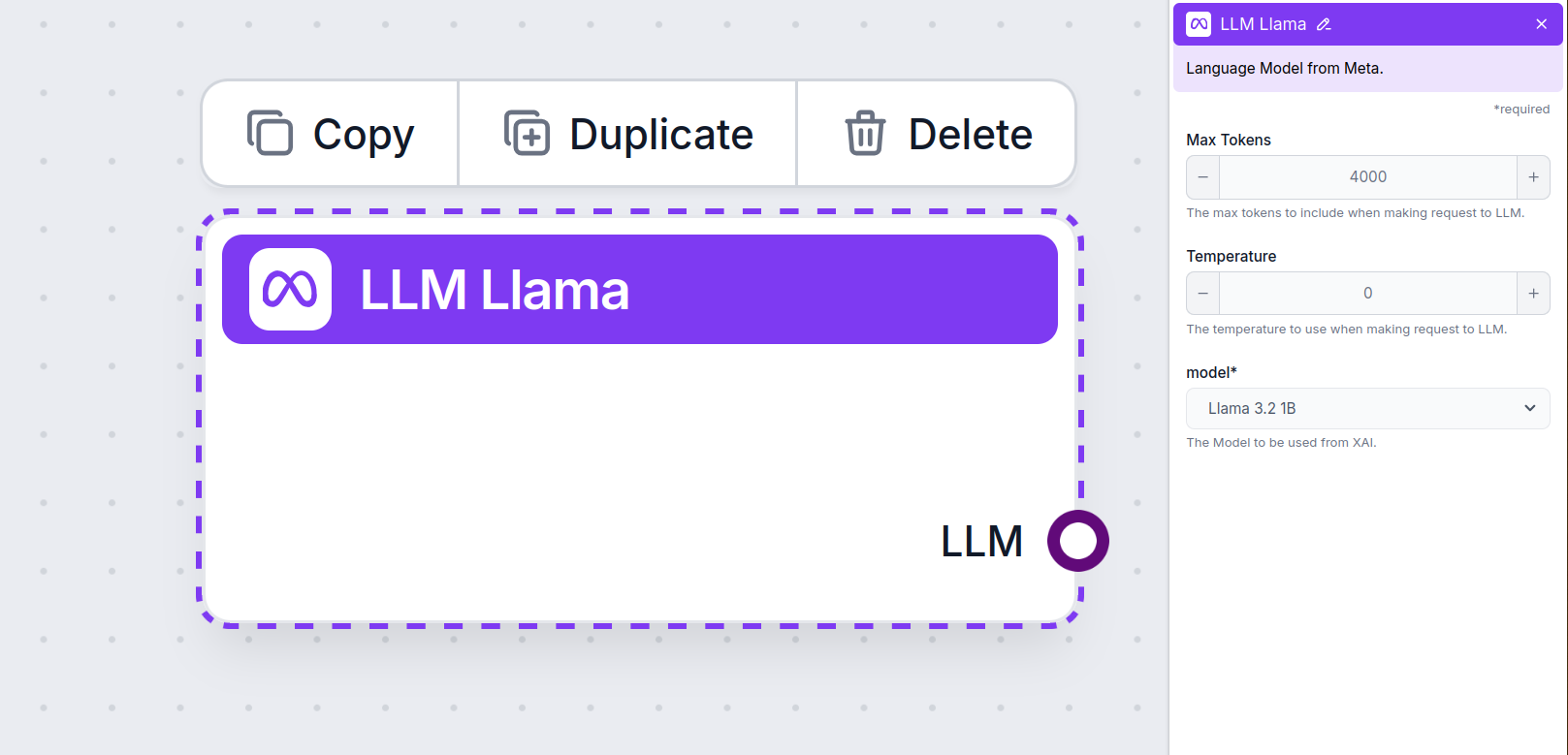

LLM Meta AI-componentinstellingen

Maximaal aantal tokens

Tokens vertegenwoordigen de individuele eenheden tekst die het model verwerkt en genereert. Het gebruik van tokens varieert per model, en een enkele token kan van alles zijn: van woorden of subwoorden tot één enkel teken. Modellen worden meestal geprijsd per miljoenen tokens.

De instelling voor maximaal aantal tokens beperkt het totale aantal tokens dat in één interactie of verzoek kan worden verwerkt, zodat de antwoorden binnen redelijke grenzen blijven. De standaardlimiet is 4.000 tokens, wat optimaal is voor het samenvatten van documenten en meerdere bronnen om een antwoord te genereren.

Temperatuur

Temperatuur bepaalt de variabiliteit van antwoorden, met een bereik van 0 tot 1.

Een temperatuur van 0,1 zorgt ervoor dat de antwoorden zeer to the point zijn, maar mogelijk herhalend en gebrekkig.

Een hoge temperatuur van 1 maakt maximale creativiteit mogelijk in antwoorden, maar verhoogt het risico op irrelevante of zelfs hallucinatoire reacties.

Voor bijvoorbeeld een klantenservicebot wordt een temperatuur tussen 0,2 en 0,5 aanbevolen. Dit niveau houdt de antwoorden relevant en volgens het script, terwijl het toch natuurlijke variatie in de reacties toelaat.

Model

Dit is de modelkiezer. Hier vind je alle ondersteunde modellen van Meta AI. We ondersteunen de open-source lichtgewicht Llama-modellen van Meta. Deze modellen zijn ontworpen voor efficiënte on-device en edge-implementaties:

- Llama 3.2 1B – Het 1B-model bevat ongeveer 1,23 miljard parameters, met een contextlengte tot 128.000 tokens. Het model is geoptimaliseerd voor taken zoals samenvatten, het opvolgen van instructies en herschrijven, waardoor ze geschikt zijn voor mobiele en embedded device-toepassingen. Lees meer over dit model en hoe het denkt in dit artikel.

- Llama 3.2. 3B – Het 3B-model heeft ongeveer 3,21 miljard parameters met een contextlengte tot 128.000 tokens. Lees meer over hoe dit model verschillende taken aanpakt.

Hoe voeg je de LLM Meta AI toe aan je Flow

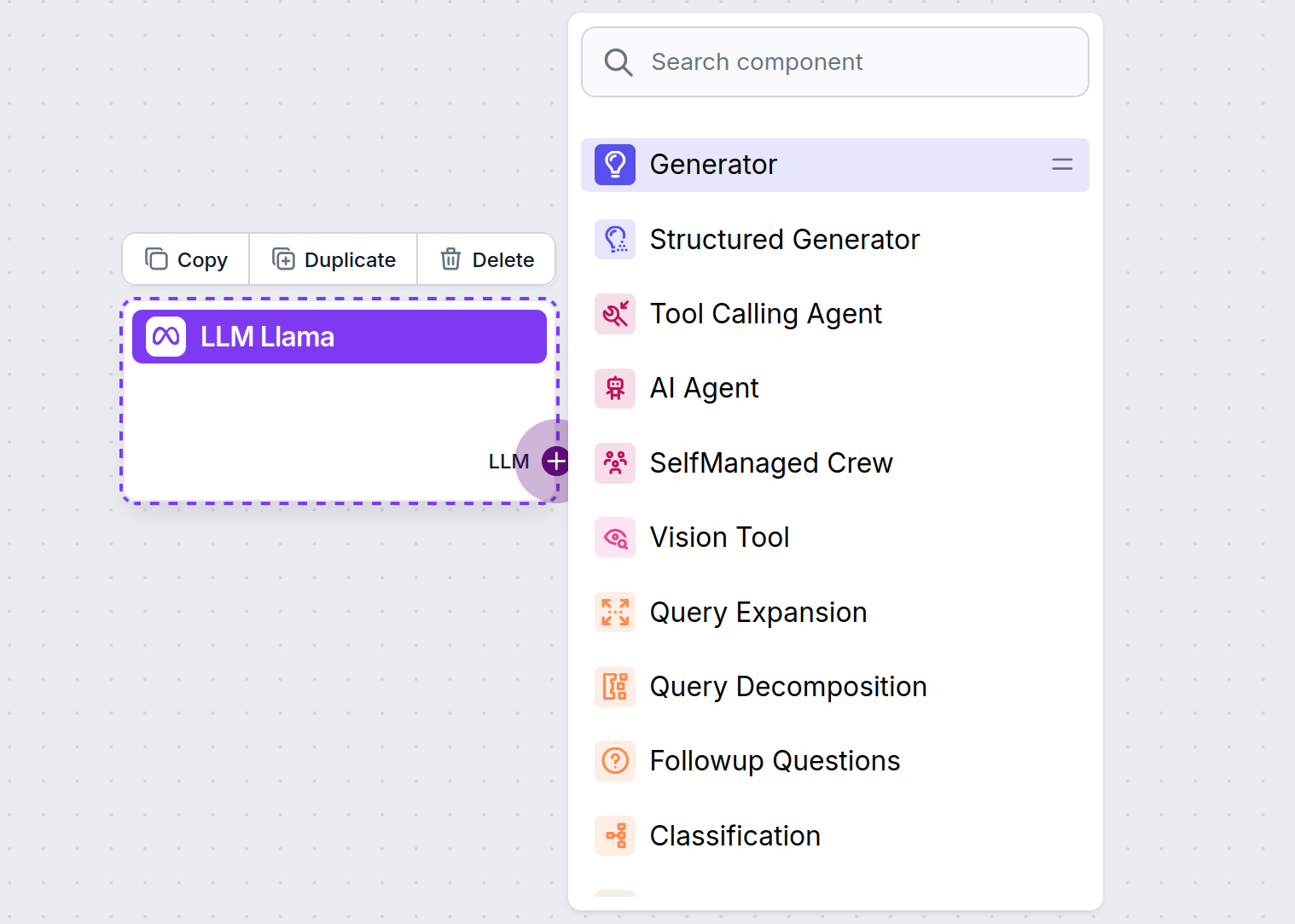

Je zult merken dat alle LLM-componenten alleen een output-handle hebben. Input gaat niet door het component heen, omdat het enkel het model vertegenwoordigt, terwijl de daadwerkelijke generatie plaatsvindt in AI-agenten en generatoren.

De LLM-handle is altijd paars. De LLM-input-handle vind je op elk component dat AI gebruikt om tekst te genereren of gegevens te verwerken. Je ziet de opties door op de handle te klikken:

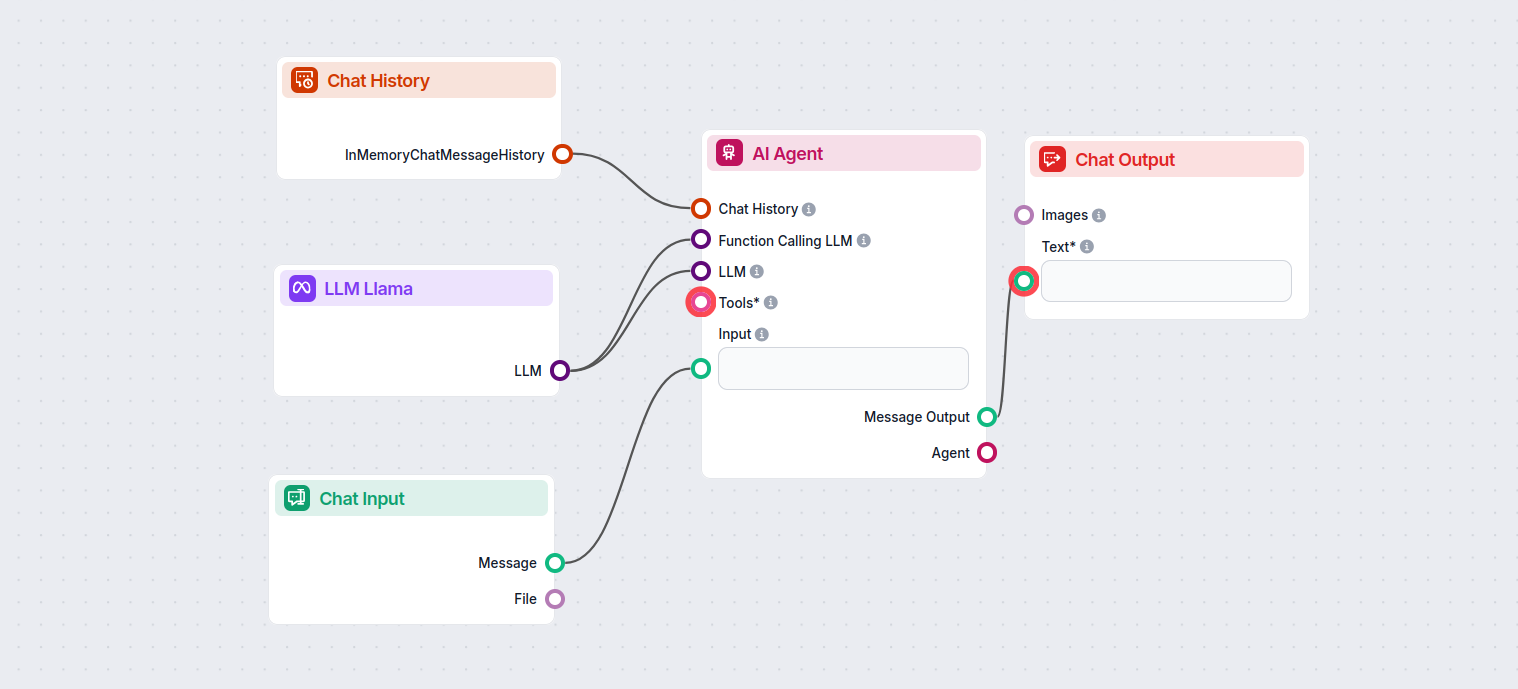

Dit stelt je in staat om allerlei soorten tools te maken. Laten we het component in actie zien. Hier is een eenvoudige AI Agent chatbot Flow die gebruikmaakt van Meta AI’s Llama 3.2 1B om antwoorden te genereren. Je kunt dit zien als een basis Llama-chatbot.

Deze eenvoudige Chatbot Flow bevat:

- Chat input: Vertegenwoordigt het bericht dat een gebruiker in de chat stuurt.

- Chatgeschiedenis: Zorgt ervoor dat de chatbot eerdere antwoorden kan onthouden en meenemen.

- Chat output: Vertegenwoordigt het uiteindelijke antwoord van de chatbot.

- AI Agent: Een autonome AI-agent die antwoorden genereert.

- LLM Meta AI: De verbinding met Meta’s tekstgeneratiemodellen.

Veelgestelde vragen

- Wat is de LLM Meta AI-component in FlowHunt?

De LLM Meta AI-component stelt je in staat om Meta’s Llama-modellen en andere tekst-/beeldgeneratoren te koppelen aan je flows, zodat je eenvoudig een model kunt selecteren en geavanceerde instellingen zoals maximaal aantal tokens en temperatuur kunt configureren.

- Welke Meta-modellen ondersteunt FlowHunt?

FlowHunt ondersteunt de open-source Llama-modellen van Meta, waaronder Llama 3.2 1B en 3B, geoptimaliseerd voor efficiëntie, samenvatting en on-device implementaties.

- Hoe configureer ik de LLM Meta AI-instellingen?

Je kunt instellingen aanpassen zoals maximaal aantal tokens (beperkt de lengte van het antwoord), temperatuur (bepaalt de creativiteit van het antwoord) en modelselectie rechtstreeks vanuit het FlowHunt-dashboard voor elk component.

- Is het noodzakelijk om de LLM Meta AI-component aan elke flow toe te voegen?

Nee, het toevoegen van de LLM Meta AI-component is optioneel. Standaard gebruiken componenten ChatGPT-4o, maar je kunt overschakelen naar Llama of andere modellen voor meer controle of specifieke use-cases.

Probeer FlowHunt’s LLM Meta AI

Begin met het bouwen van slimmere chatbots en AI-tools met Meta’s Llama-modellen en tientallen andere AI-generatoren, allemaal op één platform.