Componentbeschrijving

Hoe de LLM OpenAI-component werkt

Wat is de LLM OpenAI-component?

De LLM OpenAI-component verbindt ChatGPT-modellen met je flow. Terwijl de Generators en Agents de plek zijn waar de daadwerkelijke magie gebeurt, stellen LLM-componenten je in staat het gebruikte model te bepalen. Alle componenten worden standaard geleverd met ChatGPT-4. Je kunt deze component koppelen als je het model wilt wijzigen of er meer controle over wilt.

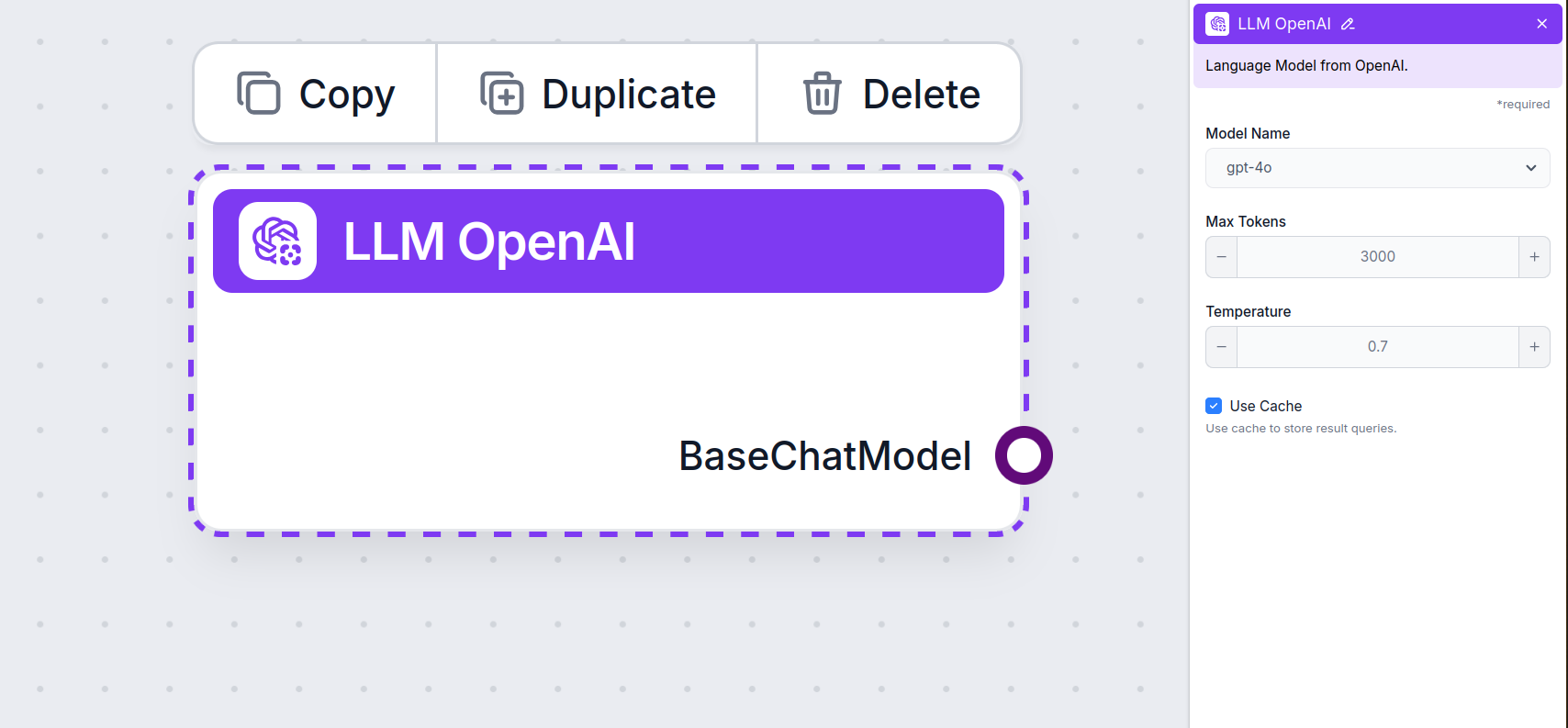

LLM OpenAI-componentinstellingen

Modelnaam

Dit is de modelkiezer. Hier vind je alle OpenAI-modellen die FlowHunt ondersteunt. ChatGPT biedt een volledige lijst van modellen met verschillende mogelijkheden en prijzen. Bijvoorbeeld: het gebruik van het minder geavanceerde en oudere GPT-3.5 kost minder dan de nieuwste 4o, maar de kwaliteit en snelheid van de uitvoer zijn lager.

OpenAI-modellen beschikbaar in FlowHunt:

- GPT-4o – Het nieuwste en populairste model van OpenAI. Een multimodaal model dat tekst, afbeeldingen en audio kan verwerken en het web kan doorzoeken. Lees hier meer.

- GPT-4o Mini – Een kleinere, kosteneffectieve versie van GPT-4o, die betere prestaties levert dan GPT-3.5 Turbo, met een contextvenster van 128K en meer dan 60% kostenreductie. Bekijk hoe dit model taken aanpakt.

- o1 Mini – Een gestroomlijnde versie van het o1-model, ontworpen voor complexe redeneertaken, met een goede balans tussen prestaties en efficiëntie. Zie hoe het presteerde in onze tests.

- o1 Preview – Een geavanceerd model met verbeterde redeneercapaciteiten, uitblinkend in complexe probleemoplossing, vooral op het gebied van coderen en wetenschappelijke redenatie, beschikbaar als preview. Bekijk hoe dit model denkt en taken afhandelt.

- gpt-4-vision-preview – Previewmodel dat zowel tekst- als afbeeldingsinvoer accepteert, met ondersteuning voor functies als JSON-modus en parallelle functie-aanroepen, waardoor multimodale interactie wordt verbeterd. Lees hier meer.

- GPT-3.5 Turbo – Een oudere versie van GPT, ideaal voor eenvoudige taken zonder hoge kosten. Bekijk onze AI Agent-test om deze te vergelijken met nieuwere modellen.

Kies het juiste model voor de taak op basis van de gewenste kwaliteit en snelheid. Oudere modellen zijn ideaal om geld te besparen bij eenvoudige bulk-taken en chatten. Als je content genereert of het web doorzoekt, raden we je aan een nieuwer en verfijnder model te kiezen.

Max Tokens

Tokens zijn de individuele tekst-eenheden die het model verwerkt en genereert. Het aantal gebruikte tokens verschilt per model; een token kan een woord, subwoord of zelfs een enkel teken zijn. Modellen worden meestal geprijsd per miljoen tokens.

Met de instelling ‘max tokens’ beperk je het totale aantal tokens dat in één interactie of verzoek kan worden verwerkt, zodat de antwoorden binnen redelijke grenzen blijven. De standaardlimiet is 4.000 tokens, wat optimaal is voor het samenvatten van documenten en verschillende bronnen om een antwoord te genereren.

Temperature

De temperatuur bepaalt de variatie in antwoorden, en loopt van 0 tot 1.

Een temperatuur van 0,1 zorgt voor zeer directe, maar mogelijk repetitieve en minderwaardige antwoorden.

Een hoge temperatuur van 1 geeft maximale creativiteit in de antwoorden, maar verhoogt het risico op irrelevante of zelfs hallucinatoire reacties.

Voor een klantenservicebot raden we een temperatuur aan tussen 0,2 en 0,5. Dit niveau houdt de antwoorden relevant en volgens het script, terwijl het toch een natuurlijke variatie in reacties toestaat.

Hoe voeg je de LLM OpenAI toe aan je flow

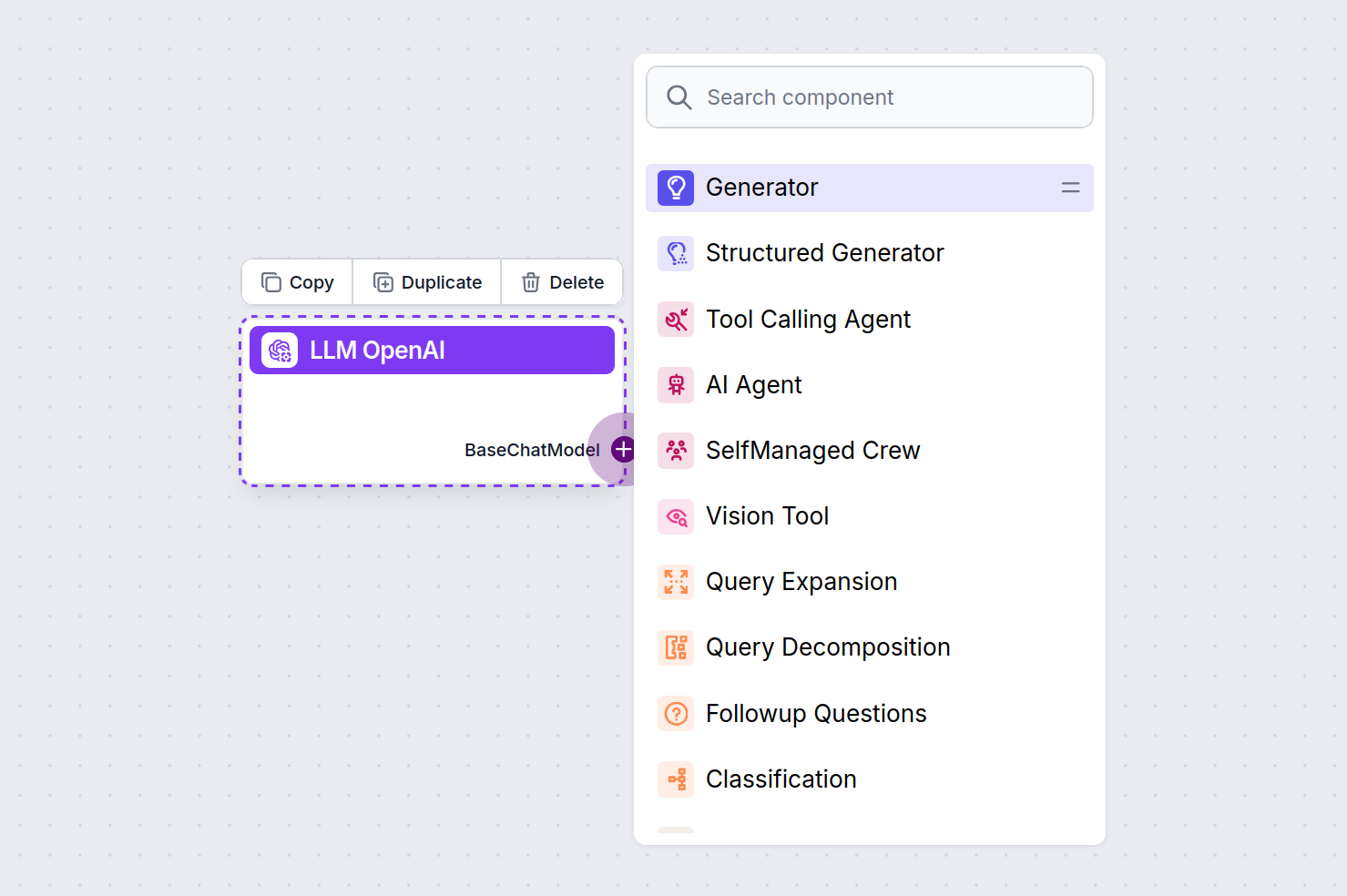

Je zult zien dat alle LLM-componenten alleen een output-handle hebben. Invoer gaat niet door de component, omdat deze alleen het model vertegenwoordigt, terwijl de daadwerkelijke generatie plaatsvindt in AI Agents en Generators.

De LLM-handle is altijd paars. De LLM-invoerhandle vind je op elke component die AI gebruikt om tekst te genereren of data te verwerken. Je ziet de opties door op de handle te klikken:

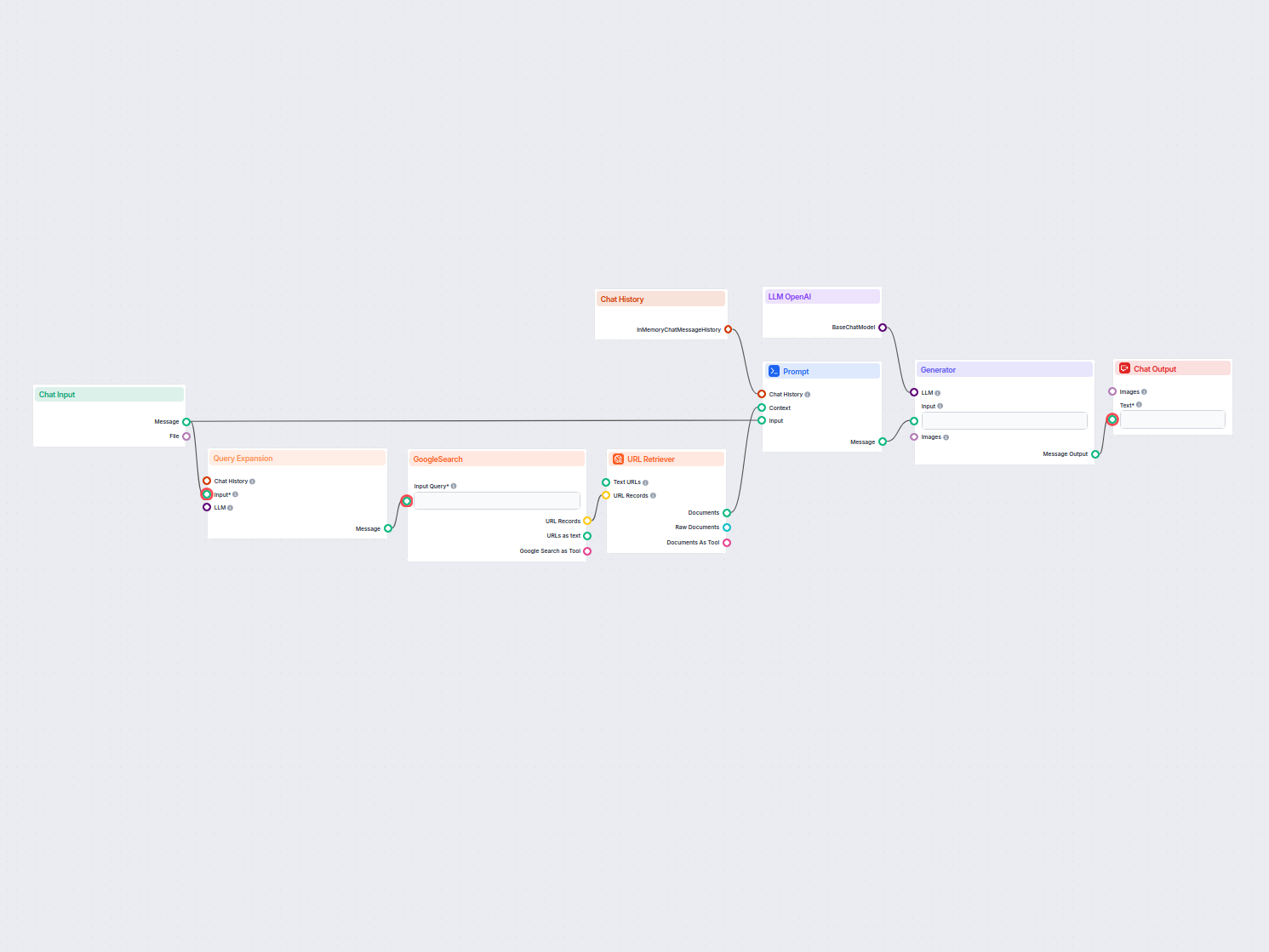

Hiermee kun je allerlei soorten tools maken. Laten we de component in actie zien. Hier zie je een eenvoudige, door Agent aangestuurde chatbot-flow die o1 Preview gebruikt om antwoorden te genereren. Je kunt het zien als een basis ChatGPT-chatbot.

Deze eenvoudige chatbot-flow bestaat uit:

- Chatinvoer: Vertegenwoordigt het bericht dat een gebruiker in de chat stuurt.

- Chatgeschiedenis: Zorgt ervoor dat de chatbot eerdere antwoorden kan onthouden en meenemen.

- Chatuitvoer: Vertegenwoordigt het uiteindelijke antwoord van de chatbot.

- AI Agent: Een autonome AI-agent die antwoorden genereert.

- LLM OpenAI: De koppeling met de tekstgeneratiemodellen van OpenAI.

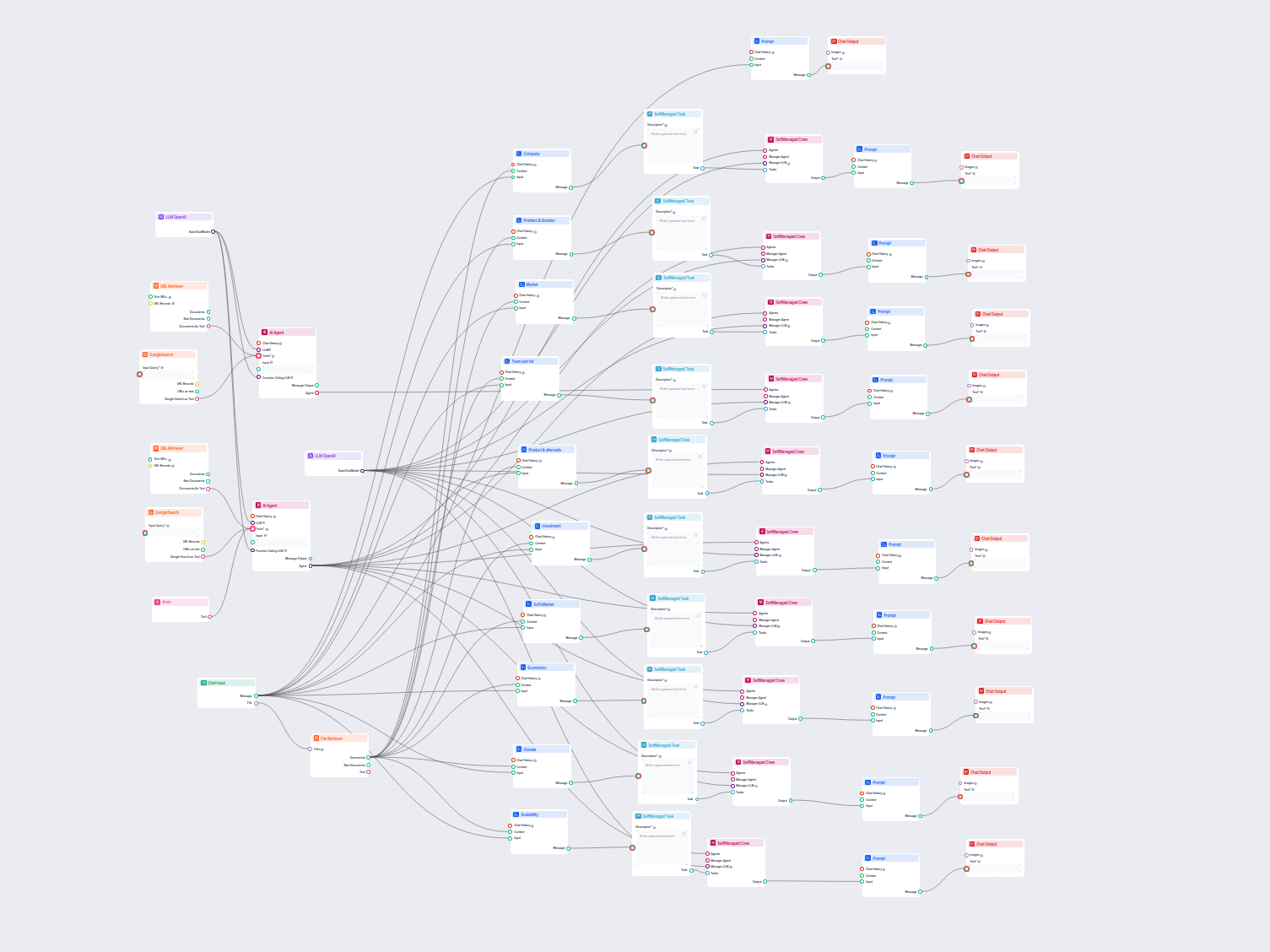

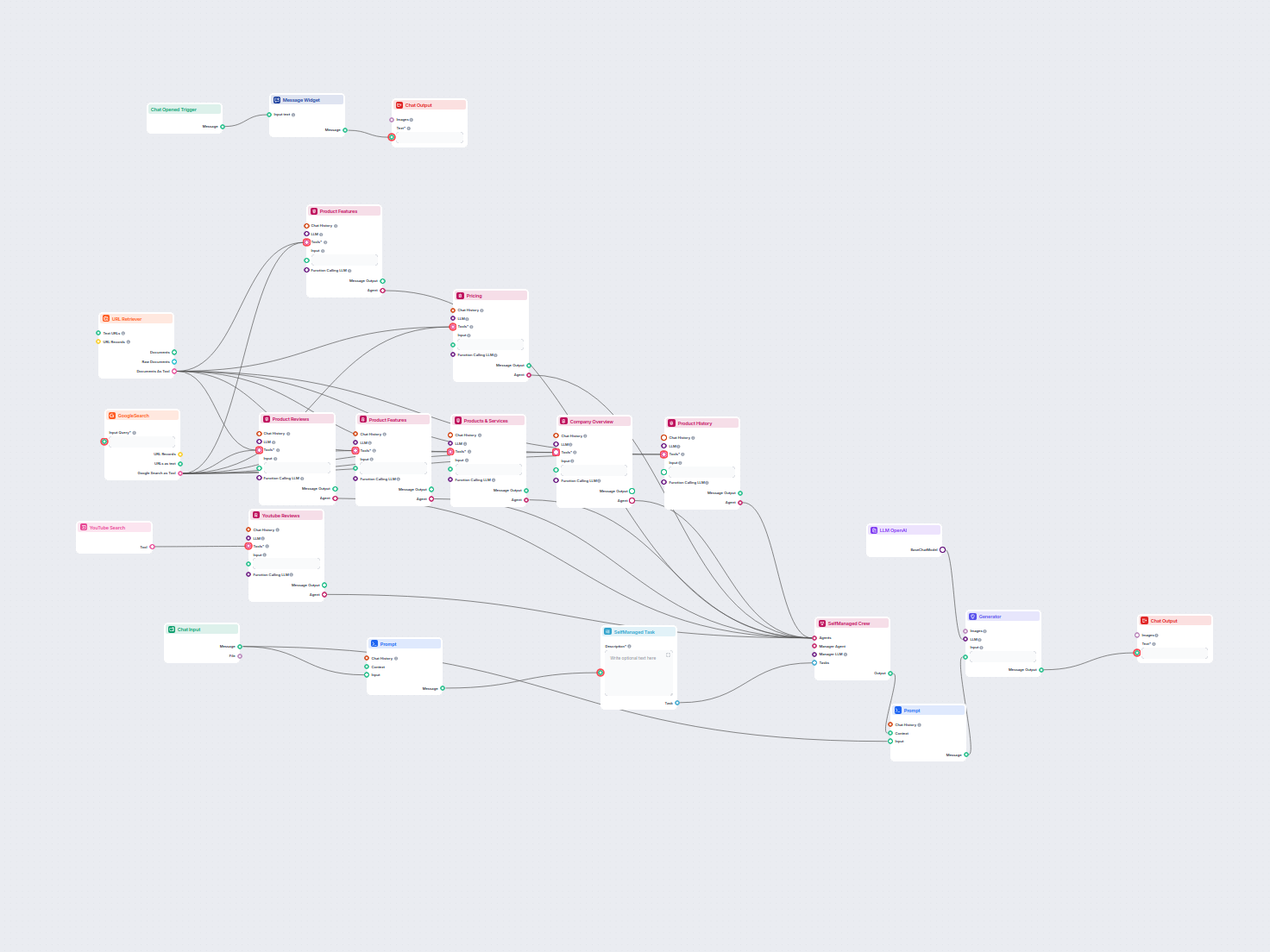

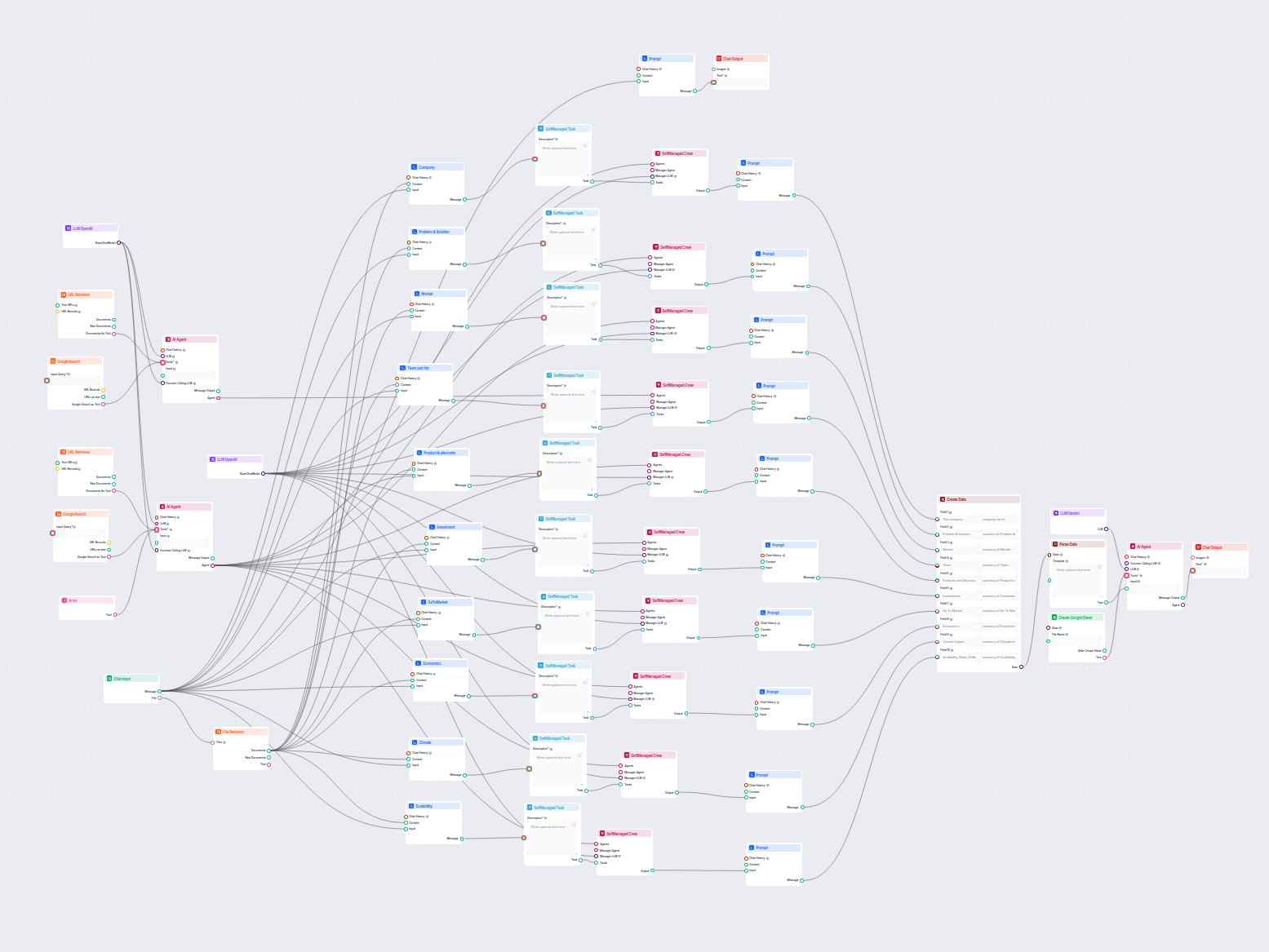

Voorbeelden van flowsjablonen met LLM OpenAI-component

Om u snel op weg te helpen, hebben we verschillende voorbeeld-flowsjablonen voorbereid die laten zien hoe u de LLM OpenAI-component effectief kunt gebruiken. Deze sjablonen tonen verschillende gebruikscases en best practices, waardoor het voor u gemakkelijker wordt om de component te begrijpen en te implementeren in uw eigen projecten.

Veelgestelde vragen

- Wat zijn LLM's?

Grote taalmodellen zijn typen AI die zijn getraind om menselijke tekst te verwerken, begrijpen en genereren. Een bekend voorbeeld is ChatGPT, dat uitgebreide antwoorden kan geven op bijna elke vraag.

- Kan ik een LLM direct verbinden met Chat Output?

Nee, de LLM-component is alleen een representatie van het AI-model. Het verandert het model dat de Generator gebruikt. Het standaard LLM-model in de Generator is ChatGPT-4o.

- Welke LLM's zijn beschikbaar in Flows?

Op dit moment is alleen de OpenAI-component beschikbaar. We zijn van plan om er in de toekomst meer toe te voegen.

- Moet ik een LLM toevoegen aan mijn flow?

Nee, Flows zijn een veelzijdige functie met veel toepassingen zonder dat een LLM nodig is. Je voegt een LLM toe als je een conversatie-chatbot wilt bouwen die vrij tekstantwoorden genereert.

- Genereert de LLM OpenAI-component het antwoord?

Niet echt. De component vertegenwoordigt alleen het model en stelt regels op die het moet volgen. Het is de generatorcomponent die het koppelt aan de invoer en de vraag via de LLM laat lopen om een uitvoer te creëren.

Klaar om je eigen AI te bouwen?

Slimme chatbots en AI-tools onder één dak. Verbind intuïtieve blokken om je ideeën om te zetten in geautomatiseerde Flows.