Componentbeschrijving

Hoe de LLM xAI-component werkt

Wat is de LLM xAI-component?

De LLM xAI-component koppelt het Grok-model aan je flow. Hoewel de Generators en Agents de echte magie uitvoeren, kun je met LLM-componenten bepalen welk model wordt gebruikt. Alle componenten worden standaard geleverd met ChatGPT-4. Je kunt deze component verbinden als je het model wilt wijzigen of er meer controle over wilt hebben.

Onthoud dat het verbinden van een LLM-component optioneel is. Alle componenten die een LLM gebruiken, worden standaard geleverd met ChatGPT-4o. De LLM-componenten laten je toe het model te wijzigen en modelinstellingen te beheren.

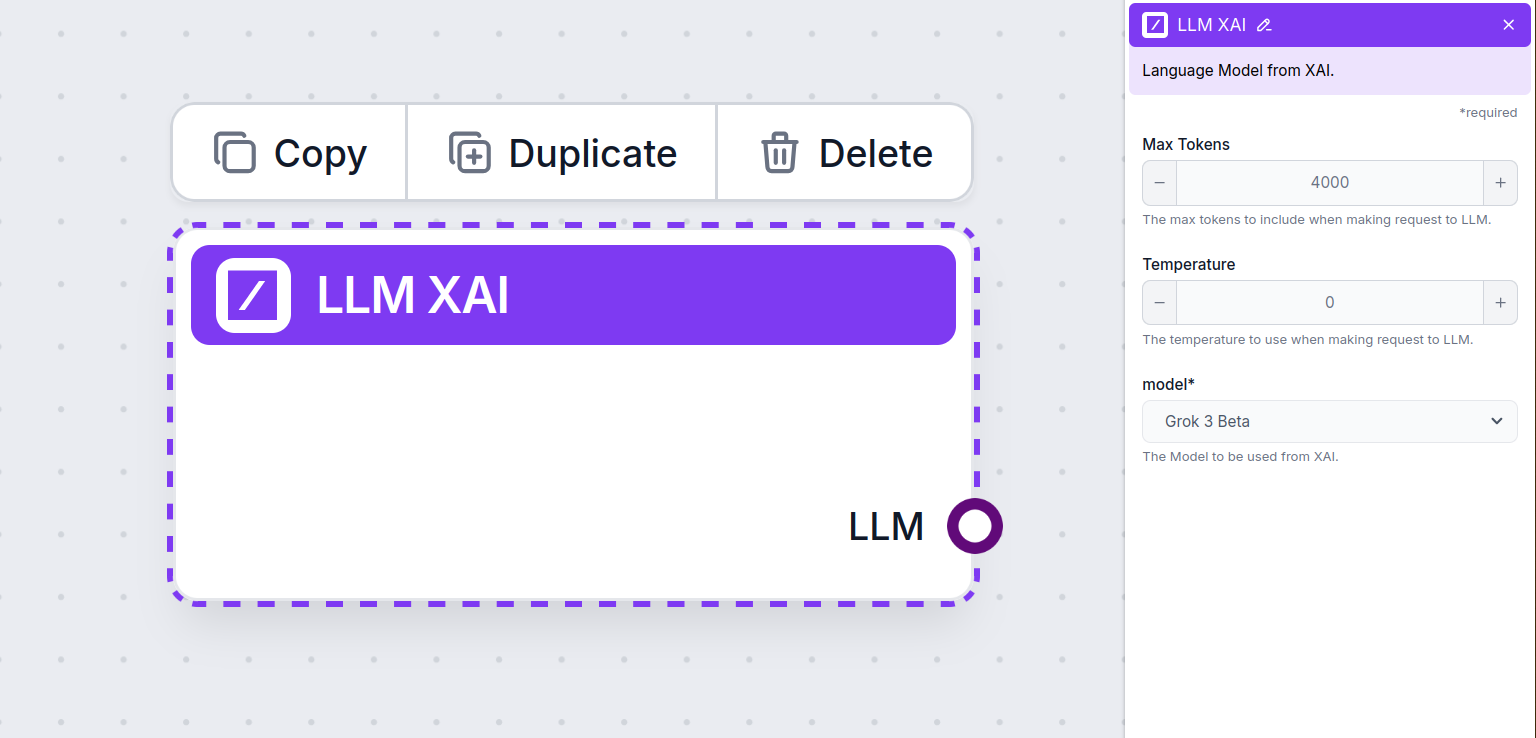

LLM xAI-componentinstellingen

Max tokens

Tokens zijn de individuele eenheden tekst die het model verwerkt en genereert. Het tokengebruik verschilt per model, en een enkele token kan alles zijn van een woord of subwoord tot een enkel teken. Modellen worden meestal afgerekend per miljoenen tokens.

De instelling max tokens beperkt het totale aantal tokens dat in één interactie of verzoek kan worden verwerkt, zodat de antwoorden binnen redelijke grenzen blijven. De standaardlimiet is 4.000 tokens, wat het optimale formaat is voor het samenvatten van documenten en meerdere bronnen om een antwoord te genereren.

Temperatuur

Temperatuur bepaalt de variatie in antwoorden, van 0 tot 1.

Een temperatuur van 0,1 zorgt ervoor dat antwoorden erg to the point zijn, maar mogelijk repetitief en tekortschietend.

Een hoge temperatuur van 1 zorgt voor maximale creativiteit in antwoorden, maar brengt het risico van irrelevante of zelfs hallucinatoire reacties met zich mee.

Voor bijvoorbeeld een klantenservicebot wordt een temperatuur van tussen 0,2 en 0,5 aanbevolen. Dit niveau houdt de antwoorden relevant en bij het script, terwijl het toch natuurlijke variatie toelaat.

Model

Dit is de modelkiezer. Hier vind je alle ondersteunde modellen van de xAI-provider. Het vlaggenschip tekstmodel van xAI heet Grok. Momenteel ondersteunen we alleen het grok-beta model, omdat dit het enige model is dat is vrijgegeven voor publieke API-gebruik.

Wil je meer weten over Grok-beta en zien hoe het zich verhoudt tot andere modellen? Bekijk dan dit artikel.

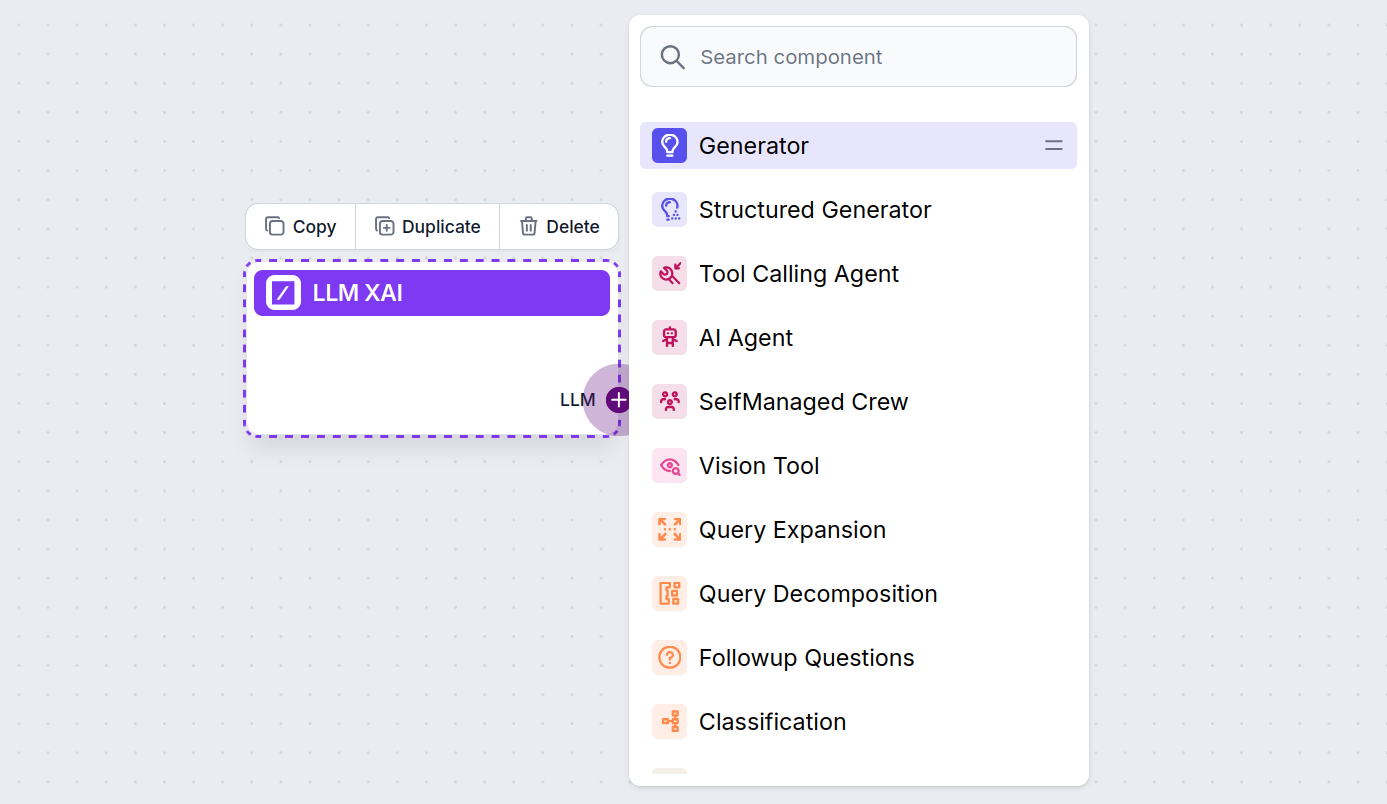

Hoe voeg je LLM xAI toe aan je flow

Je zult merken dat alle LLM-componenten slechts één output-handle hebben. Input gaat niet door het component heen, omdat het alleen het model vertegenwoordigt, terwijl de daadwerkelijke generatie plaatsvindt in AI Agents en Generators.

De LLM-handle is altijd paars. De LLM-input-handle vind je op elk component dat AI gebruikt om tekst te genereren of gegevens te verwerken. Je kunt de opties zien door op de handle te klikken:

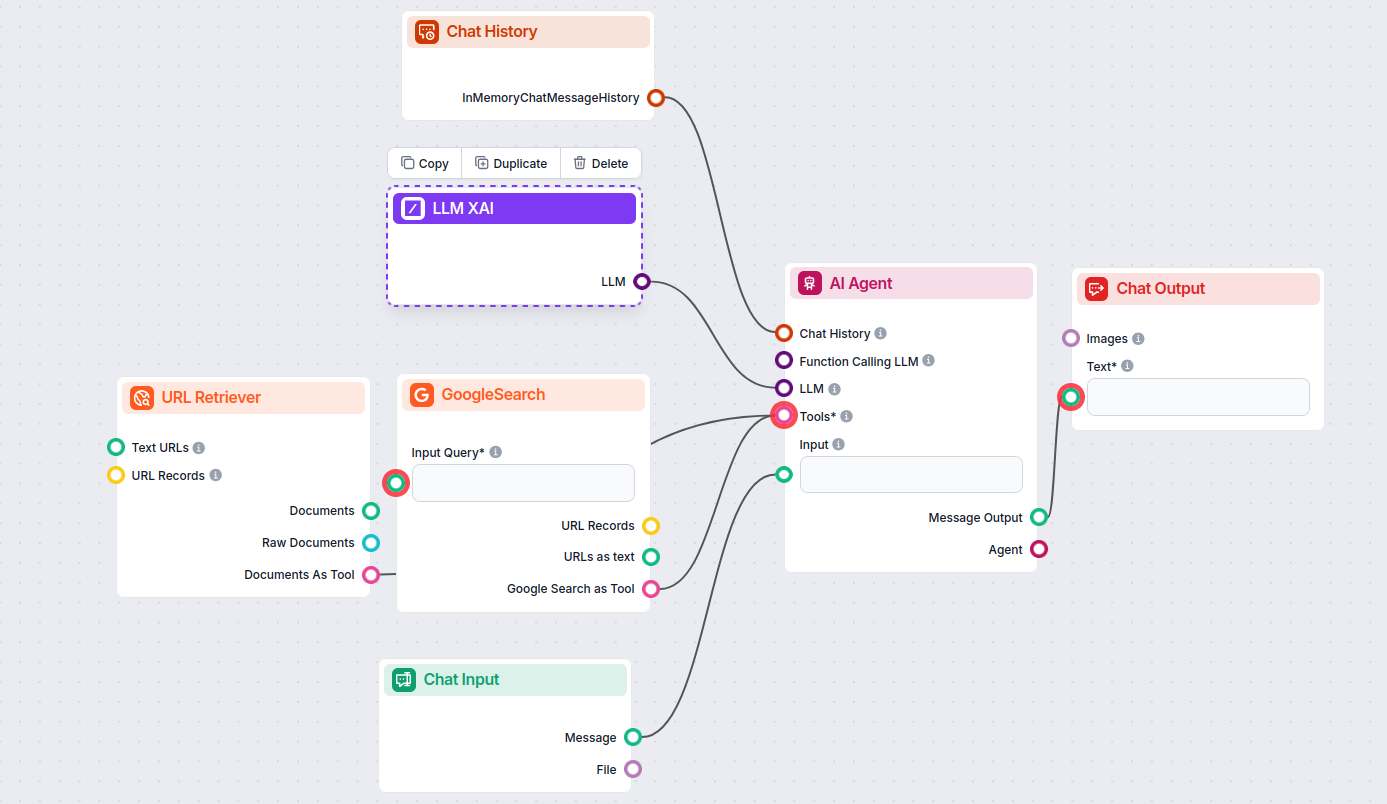

Dit geeft je de mogelijkheid om allerlei tools te bouwen. Laten we het component in actie zien. Hier is een eenvoudige AI Agent chatbot-flow die xAI’s grok-beta gebruikt om antwoorden te genereren. Je kunt het zien als een basis xAI-chatbot.

Deze eenvoudige Chatbot Flow bevat:

- Chatinvoer: Vertegenwoordigt het bericht dat een gebruiker in de chat stuurt.

- Chathistorie: Zorgt ervoor dat de chatbot zich eerdere antwoorden kan herinneren en meenemen.

- Chatoutput: Vertegenwoordigt het uiteindelijke antwoord van de chatbot.

- AI Agent: Een autonome AI-agent die antwoorden genereert.

- LLM xAI: De koppeling met xAI’s tekstgeneratiemodellen.

Veelgestelde vragen

- Wat is LLM xAI in FlowHunt?

LLM xAI is een FlowHunt-component waarmee je tekstgeneratiemodellen van xAI-providers, zoals Grok-beta, kunt koppelen en aansturen binnen je AI-flows en chatbots.

- Welke xAI-modellen ondersteunt FlowHunt?

Op dit moment ondersteunt FlowHunt het grok-beta model van xAI, met meer modellen die worden toegevoegd zodra ze beschikbaar zijn via de publieke API.

- Welke instellingen kan ik regelen met de LLM xAI-component?

Je kunt het maximaal aantal tokens, de temperatuur (antwoordvariabiliteit) aanpassen en kiezen uit beschikbare xAI-modellen om het gedrag van je chatbot of AI-tool aan te passen.

- Is het verbinden van de LLM xAI-component verplicht voor elke chatbot?

Nee, het is optioneel. Standaard gebruiken componenten ChatGPT-4o, maar je kunt LLM xAI koppelen om over te schakelen naar xAI-modellen of meer controle te krijgen.

- Hoe voeg ik de LLM xAI-component toe aan mijn FlowHunt-project?

Voeg eenvoudig de LLM-component toe aan je flow; deze fungeert als modelkiezer. De daadwerkelijke tekstgeneratie vindt plaats in AI Agents en Generators die erop aangesloten zijn.

Probeer FlowHunt’s LLM xAI vandaag nog

Begin met het bouwen van slimmere AI-chatbots en tools met FlowHunt. Verbind met top xAI-modellen zoals Grok-beta in een flexibel, no-code dashboard.