Activatiefuncties

Activatiefuncties introduceren non-lineariteit in neurale netwerken, waardoor ze complexe patronen kunnen leren die essentieel zijn voor AI- en deep learning-toepassingen.

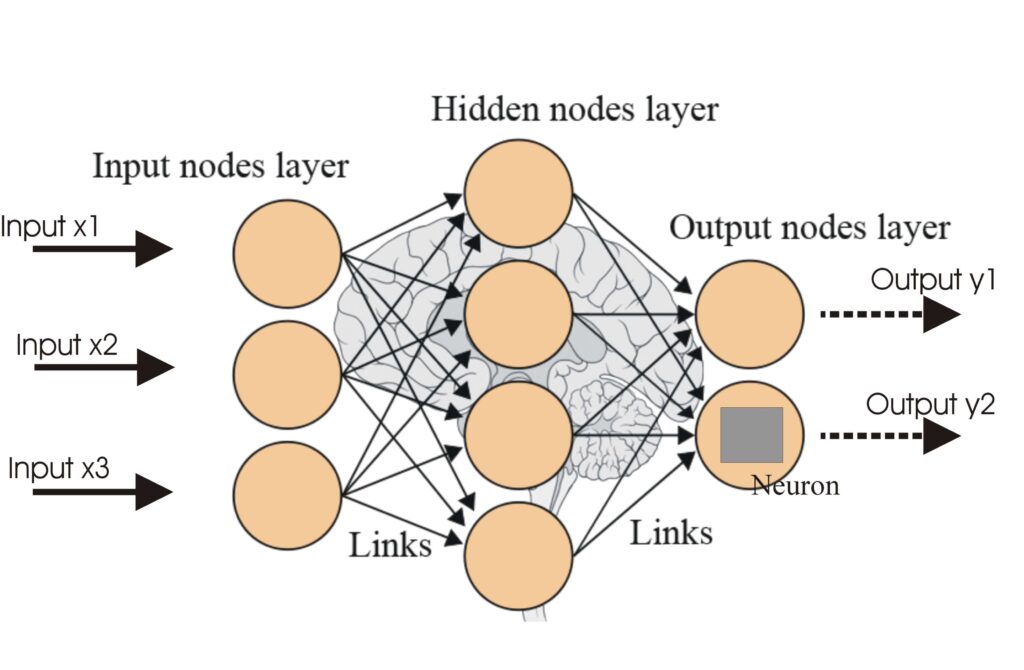

Activatiefuncties vormen de basis van de architectuur van kunstmatige neurale netwerken (ANN’s) en hebben een grote invloed op het vermogen van het netwerk om te leren en complexe taken uit te voeren. Dit woordenlijst-artikel verdiept zich in de complexiteit van activatiefuncties door hun doel, typen en toepassingen te bespreken, met name binnen AI, deep learning en neurale netwerken.

Wat is een activatiefunctie?

Een activatiefunctie in een neuraal netwerk is een wiskundige bewerking die wordt toegepast op de output van een neuron. De functie bepaalt of een neuron wel of niet geactiveerd wordt en introduceert non-lineariteit in het model, waardoor het netwerk complexe patronen kan leren. Zonder deze functies zou een neuraal netwerk zich gedragen als een lineair regressiemodel, ongeacht de diepte of het aantal lagen.

Doel van activatiefuncties

- Introductie van non-lineariteit: Activatiefuncties stellen neurale netwerken in staat om non-lineaire relaties in de data te vangen, wat essentieel is voor het oplossen van complexe taken.

- Beperkte output: Ze beperken de output van neuronen tot een specifiek bereik, waardoor extreme waarden die het leerproces kunnen belemmeren worden voorkomen.

- Gradiëntpropagatie: Tijdens backpropagation helpen activatiefuncties bij het berekenen van de gradiënten, die nodig zijn voor het bijwerken van gewichten en biases in het netwerk.

Typen activatiefuncties

Lineaire activatiefuncties

- Vergelijking: $f(x) = x$

- Kenmerken: Er wordt geen non-lineariteit geïntroduceerd; outputs zijn recht evenredig aan de inputs.

- Toepassing: Vaak gebruikt in de outputlaag voor regressietaken waarbij de outputwaarden niet tot een specifiek bereik zijn beperkt.

- Beperking: Alle lagen zouden samenvallen tot één laag, waardoor de diepte van het netwerk verloren gaat.

Niet-lineaire activatiefuncties

Sigmoidfunctie

- Vergelijking: $f(x) = \frac{1}{1 + e^{-x}}$

- Kenmerken: Outputs liggen tussen 0 en 1; S-vormige curve.

- Toepassing: Geschikt voor binaire classificatieproblemen.

- Beperking: Kan last hebben van het verdwijnende gradiëntprobleem, waardoor het leren in diepe netwerken vertraagt.

Tanh-functie

- Vergelijking: $f(x) = \tanh(x) = \frac{2}{1 + e^{-2x}} – 1$

- Kenmerken: Outputs liggen tussen -1 en 1; nul-gecentreerd.

- Toepassing: Wordt vaak gebruikt in verborgen lagen van neurale netwerken.

- Beperking: Ook gevoelig voor het verdwijnende gradiëntprobleem.

ReLU (Rectified Linear Unit)

- Vergelijking: $f(x) = \max(0, x)$

- Kenmerken: Geeft nul voor negatieve inputs en is lineair voor positieve inputs.

- Toepassing: Veelgebruikt in deep learning, met name in convolutionele neurale netwerken.

- Beperking: Kan last hebben van het “dying ReLU”-probleem waarbij neuronen stoppen met leren.

Leaky ReLU

- Vergelijking: $f(x) = \max(0.01x, x)$

- Kenmerken: Laat een kleine, niet-nulgradiënt toe wanneer de unit inactief is.

- Toepassing: Lost het dying ReLU-probleem op door een kleine helling voor negatieve waarden toe te staan.

Softmaxfunctie

- Vergelijking: $f(x_i) = \frac{e^{x_i}}{\sum_{j} e^{x_j}}$

- Kenmerken: Zet logits om in kansen die optellen tot 1.

- Toepassing: Gebruikt in de outputlaag van neurale netwerken voor multi-klasse classificatieproblemen.

Swish-functie

- Vergelijking: $f(x) = x \cdot \text{sigmoid}(x)$

- Kenmerken: Vloeiend en niet-monotoon, wat zorgt voor betere optimalisatie en convergentie.

- Toepassing: Wordt vaak gebruikt in state-of-the-art deep learning modellen voor betere prestaties ten opzichte van ReLU.

Toepassingen in AI en deep learning

Activatiefuncties zijn onmisbaar in diverse AI-toepassingen, waaronder:

- Beeldclassificatie: Functies als ReLU en Softmax zijn cruciaal in convolutionele neurale netwerken voor het verwerken en classificeren van afbeeldingen.

- Natural Language Processing: Activatiefuncties helpen bij het leren van complexe patronen in tekstuele data, waardoor taalmodellen menselijke tekst kunnen genereren.

- AI-automatisering: In robotica en geautomatiseerde systemen helpen activatiefuncties bij het nemen van beslissingen door sensordata te interpreteren.

- Chatbots: Ze maken het mogelijk voor conversatiemodellen om gebruikersvragen effectief te begrijpen en te beantwoorden door te leren van diverse inputpatronen.

Uitdagingen en aandachtspunten

- Verdwijnend gradiëntprobleem: Sigmoid- en Tanh-functies kunnen leiden tot verdwijnende gradiënten, waarbij gradiënten te klein worden en het leerproces belemmeren. Technieken zoals het gebruik van ReLU of varianten kunnen dit probleem verkleinen.

- Dying ReLU: Een belangrijk probleem waarbij neuronen tijdens training vastlopen en stoppen met leren. Leaky ReLU en andere aangepaste vormen kunnen dit probleem verminderen.

- Rekenintensiviteit: Sommige functies, zoals sigmoid en softmax, zijn rekenintensief en daardoor mogelijk minder geschikt voor realtime toepassingen.

Veelgestelde vragen

- Wat is een activatiefunctie in neurale netwerken?

Een activatiefunctie is een wiskundige bewerking die wordt toegepast op de output van een neuron. Hierdoor wordt non-lineariteit geïntroduceerd en kunnen neurale netwerken complexe patronen leren die verder gaan dan eenvoudige lineaire relaties.

- Waarom zijn activatiefuncties belangrijk in AI en deep learning?

Activatiefuncties stellen neurale netwerken in staat om complexe, non-lineaire problemen op te lossen door het mogelijk maken van het leren van ingewikkelde patronen. Dit maakt ze cruciaal voor taken zoals beeldclassificatie, taalverwerking en automatisering.

- Wat zijn de belangrijkste typen activatiefuncties?

Veelvoorkomende typen zijn Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax en Swish, elk met unieke kenmerken en toepassingsgebieden in verschillende lagen van neurale netwerken.

- Met welke uitdagingen zijn activatiefuncties verbonden?

Veelvoorkomende uitdagingen zijn het verdwijnende gradiëntprobleem (vooral bij Sigmoid en Tanh), dying ReLU en de rekentijd van functies zoals Softmax in realtime toepassingen.

Klaar om je eigen AI te bouwen?

Slimme Chatbots en AI-tools onder één dak. Verbind intuïtieve blokken om je ideeën om te zetten in geautomatiseerde Flows.