AI Bot Blokkeren

AI Bot Blokkeren gebruikt robots.txt om door AI aangestuurde bots te weren van websitegegevens, ter bescherming van content en privacy.

AI Bot Blokkeren verwijst naar de praktijk waarbij door AI aangestuurde bots worden verhinderd om toegang te krijgen tot en gegevens te extraheren van een website. Dit wordt doorgaans gerealiseerd door gebruik te maken van het robots.txt-bestand, dat webcrawlers instructies geeft over welke delen van een site zij wel en niet mogen bezoeken.

Waarom AI Bot Blokkeren Belangrijk Is

Het blokkeren van AI-bots is cruciaal voor het beschermen van gevoelige websitegegevens, het behouden van de originaliteit van content en het voorkomen van ongeoorloofd gebruik van content voor AI-trainingsdoeleinden. Het helpt de integriteit van de content van een website te waarborgen en kan beschermen tegen mogelijke privacyproblemen en misbruik van data.

Robots.txt

Wat is robots.txt?

Robots.txt is een tekstbestand dat door websites wordt gebruikt om te communiceren met webcrawlers en bots. Het geeft deze geautomatiseerde agenten instructies over welke delen van de site zij mogen crawlen en indexeren.

Functionaliteit:

- Webpaginafiltering: Beperkt de toegang van crawlers tot specifieke webpagina’s om de serverbelasting te beheren en gevoelige content te beschermen.

- Mediafiltering: Regelt de toegang tot afbeeldingen, video’s en audiobestanden, zodat deze niet in zoekresultaten verschijnen.

- Beheer van resourcebestanden: Beperkt toegang tot niet-essentiële bestanden zoals stylesheets en scripts om serverbronnen te optimaliseren en het gedrag van bots te sturen.

Implementatie:

Websites dienen het robots.txt-bestand in de hoofdmap te plaatsen, zodat het toegankelijk is via de URL:https://example.com/robots.txt

De bestandsindeling bestaat uit het specificeren van de user-agent, gevolgd door “Disallow” om toegang te blokkeren of “Allow” om toegang toe te staan.

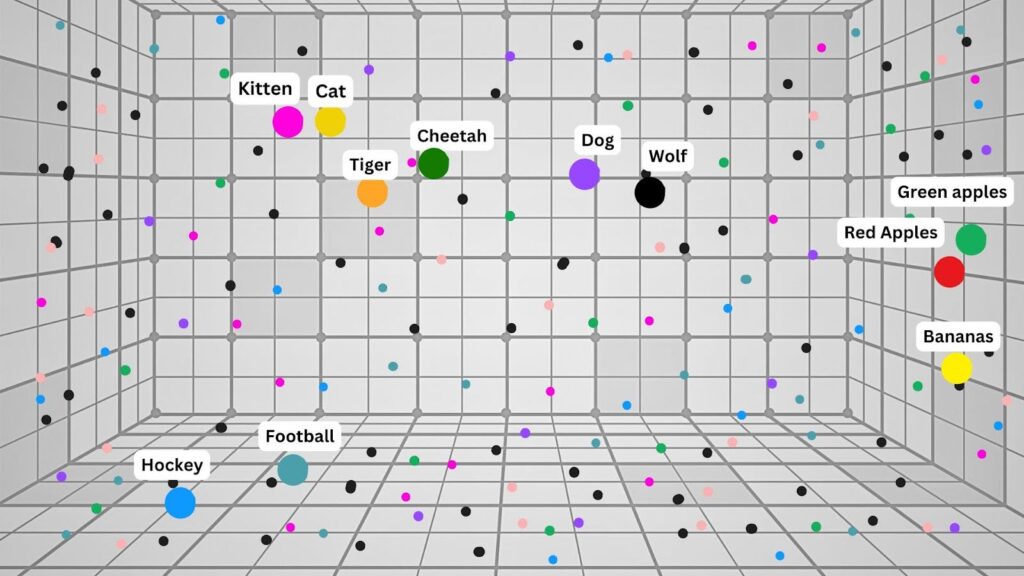

Soorten AI-bots

AI-assistenten

- Wat zijn dit?

AI-assistenten, zoals ChatGPT-User en Meta-ExternalFetcher, zijn bots die webgegevens gebruiken om intelligente antwoorden te geven op gebruikersvragen. - Doel:

Verbeteren van de gebruikersinteractie door relevante informatie en assistentie te bieden.

- Wat zijn dit?

AI-datascrapers

- Wat zijn dit?

AI-datascrapers, zoals Applebot-Extended en Bytespider, verzamelen grote hoeveelheden gegevens van het web voor het trainen van Large Language Models (LLM’s). - Doel:

Opbouwen van uitgebreide datasets voor AI-modeltraining en ontwikkeling.

- Wat zijn dit?

AI-zoekcrawlers

- Wat zijn dit?

AI-zoekcrawlers zoals Amazonbot en Google-Extended verzamelen informatie over webpagina’s om zoekmachine-indexering en AI-gegenereerde zoekresultaten te verbeteren. - Doel:

Verhogen van de nauwkeurigheid en relevantie van zoekmachines door webcontent te indexeren.

- Wat zijn dit?

Populaire AI-bots en Blokkeertechnieken

| Botnaam | Beschrijving | Blokkeermethode (robots.txt) |

|---|---|---|

| GPTBot | OpenAI’s bot voor dataverzameling | User-agent: GPTBot Disallow: / |

| Bytespider | ByteDance’s datascraper | User-agent: Bytespider Disallow: / |

| OAI-SearchBot | OpenAI’s zoekindexeringsbot | User-agent: OAI-SearchBot Disallow: / |

| Google-Extended | Google’s AI-trainingsdatabot | User-agent: Google-Extended Disallow: / |

Gevolgen van het Blokkeren van AI-bots

Contentbescherming:

Door bots te blokkeren wordt originele websitecontent beschermd tegen gebruik zonder toestemming in AI-trainingsdatasets, waardoor het intellectueel eigendom behouden blijft.Privacyzorgen:

Door de toegang van bots te beheren, kunnen websites risico’s op het gebied van gegevensprivacy en ongeoorloofde dataverzameling beperken.SEO-overwegingen:

Hoewel het blokkeren van bots content kan beschermen, kan het ook de zichtbaarheid van een site in door AI aangestuurde zoekmachines beïnvloeden, wat mogelijk leidt tot minder verkeer en vindbaarheid.Juridische en ethische aspecten:

Deze praktijk roept vragen op over data-eigendom en het eerlijke gebruik van webcontent door AI-bedrijven. Websites moeten de bescherming van hun content afwegen tegen de potentiële voordelen van door AI aangedreven zoektechnologieën.

Veelgestelde vragen

- Wat is AI Bot Blokkeren?

AI Bot Blokkeren verwijst naar het voorkomen dat door AI aangestuurde bots toegang krijgen tot en gegevens extraheren van een website, meestal via instructies in het robots.txt-bestand.

- Waarom zou ik AI-bots op mijn website blokkeren?

Het blokkeren van AI-bots helpt gevoelige gegevens te beschermen, originaliteit van content te behouden, ongeoorloofd gebruik voor AI-training te voorkomen en privacy en intellectueel eigendom te waarborgen.

- Hoe blokkeert robots.txt AI-bots?

Door een robots.txt-bestand in de hoofdmap van je site te plaatsen met specifieke user-agent- en disallow-instructies, beperk je de toegang van bots tot bepaalde pagina's of de hele site.

- Welke AI-bots kunnen worden geblokkeerd met robots.txt?

Populaire AI-bots zoals GPTBot, Bytespider, OAI-SearchBot en Google-Extended kunnen worden geblokkeerd met robots.txt-instructies die gericht zijn op hun user-agent-namen.

- Zijn er nadelen aan het blokkeren van AI-bots?

Het blokkeren van AI-bots kan de risico's op het gebied van gegevensprivacy verminderen, maar kan ook de zichtbaarheid van je site in door AI aangestuurde zoekmachines beïnvloeden, wat ten koste kan gaan van vindbaarheid en verkeer.

Bescherm je website tegen AI-bots

Leer hoe je AI-bots blokkeert en je content beschermt tegen ongeoorloofde toegang en data scraping. Begin met het bouwen van veilige AI-oplossingen met FlowHunt.