Documentherordening

Documentherordening verfijnt opgehaalde zoekresultaten door documenten die het meest relevant zijn voor de zoekopdracht van de gebruiker prioriteit te geven, waardoor de nauwkeurigheid van AI- en RAG-systemen wordt verbeterd.

Documentherordening

Documentherordening rangschikt opgehaalde documenten opnieuw op basis van relevantie voor de zoekopdracht, waardoor zoekresultaten verfijnd worden. Query-uitbreiding verbetert het zoeken door gerelateerde termen toe te voegen, waardoor de recall wordt verbeterd en ambiguïteit wordt aangepakt. Door deze technieken te combineren in RAG-systemen wordt de ophalingsnauwkeurigheid en de kwaliteit van antwoorden verhoogd.

Documentherordening is het proces waarbij opgehaalde documenten opnieuw gerangschikt worden op basis van hun relevantie voor de zoekopdracht van de gebruiker. Na een eerste ophalingsstap verfijnt herordening de resultaten door de relevantie van elk document nauwkeuriger te evalueren, zodat de meest relevante documenten prioriteit krijgen.

Wat is Retrieval-Augmented Generation (RAG)?

Retrieval-Augmented Generation (RAG) is een geavanceerd framework dat de mogelijkheden van grote taalmodellen (LLM’s) combineert met informatieophalingssystemen. In RAG, wanneer een gebruiker een zoekopdracht indient, haalt het systeem relevante documenten op uit een grote kennisbank en voert deze informatie in het LLM om geïnformeerde en contextueel nauwkeurige antwoorden te genereren. Deze aanpak verhoogt de nauwkeurigheid en relevantie van door AI gegenereerde content door deze te verankeren in feitelijke gegevens.

Query-uitbreiding begrijpen

Wat is query-uitbreiding?

Definitie

Query-uitbreiding is een techniek die wordt gebruikt in informatieophaling om de effectiviteit van zoekopdrachten te vergroten. Het houdt in dat de oorspronkelijke zoekopdracht wordt uitgebreid met extra termen of uitdrukkingen die semantisch gerelateerd zijn. Het hoofddoel is om de kloof te overbruggen tussen de intentie van de gebruiker en de taal die wordt gebruikt in relevante documenten, waardoor het ophalen van relevante informatie wordt verbeterd.

Hoe het werkt

In de praktijk kan query-uitbreiding op verschillende manieren worden bereikt:

- Synoniemuitbreiding: Synoniemen van zoektermen toevoegen om verschillende uitdrukkingen van hetzelfde concept te dekken.

- Gerelateerde termen: Termen toevoegen die contextueel gerelateerd zijn maar geen directe synoniemen zijn.

- LLM-gebaseerde uitbreiding: Grote taalmodellen gebruiken om uitgebreide zoekopdrachten te genereren door woorden of zinnen te voorspellen die relevant zijn voor de oorspronkelijke zoekopdracht.

Door de zoekopdracht uit te breiden kan het ophalingssysteem een breder net uitwerpen en documenten vastleggen die mogelijk gemist zouden zijn door variaties in terminologie of formulering.

Waarom is query-uitbreiding belangrijk in RAG-systemen?

Verbetering van recall

Recall verwijst naar het vermogen van het systeem om alle relevante documenten te vinden. Query-uitbreiding verhoogt de recall door:

- Documenten op te halen die andere termen gebruiken om hetzelfde concept te beschrijven.

- Documenten vast te leggen die gerelateerde subonderwerpen of bredere aspecten van de zoekopdracht behandelen.

Aanpakken van ambiguïteit in zoekopdrachten

Gebruikers dienen vaak korte of dubbelzinnige zoekopdrachten in. Query-uitbreiding helpt bij:

- Het verduidelijken van de intentie van de gebruiker door meerdere interpretaties te overwegen.

- Een meer uitgebreide zoekopdracht te bieden door verschillende aspecten van het onderwerp op te nemen.

Verbeteren van documentmatching

Door extra relevante termen toe te voegen, vergroot het systeem de kans dat de zoekopdracht overeenkomt met documenten waarin mogelijk een andere woordenschat wordt gebruikt, waardoor de algehele effectiviteit van het ophalingsproces verbetert.

Methoden van query-uitbreiding

1. Pseudo-Relevance Feedback (PRF)

Wat is PRF?

Pseudo-Relevance Feedback is een automatische query-uitbreidingsmethode waarbij het systeem aanneemt dat de hoogst gerangschikte documenten uit een eerste zoekopdracht relevant zijn. Het extraheert belangrijke termen uit deze documenten om de oorspronkelijke zoekopdracht te verfijnen.

Hoe PRF werkt

- Uitvoeren van de initiële zoekopdracht: De oorspronkelijke zoekopdracht van de gebruiker wordt uitgevoerd en de topdocumenten worden opgehaald.

- Termextractie: Belangrijke termen uit deze documenten worden geïdentificeerd op basis van frequentie of belangrijkheid.

- Zoekopdracht verfijnen: De oorspronkelijke zoekopdracht wordt uitgebreid met deze sleuteltermen.

- Tweede ophaling: De uitgebreide zoekopdracht wordt gebruikt om een nieuwe zoekopdracht uit te voeren, idealiter met relevantere documenten als resultaat.

Voordelen en nadelen

- Voordelen: Verbetert recall zonder tussenkomst van de gebruiker.

- Nadelen: Als de initiële resultaten irrelevante documenten bevatten, kan de uitbreiding misleidende termen omvatten, waardoor de precisie afneemt.

2. LLM-gebaseerde query-uitbreiding

Gebruikmaken van grote taalmodellen

Met de vooruitgang in AI kunnen LLM’s zoals GPT-3 en GPT-4 geavanceerde query-uitbreidingen genereren door context en semantiek te begrijpen.

Hoe LLM-gebaseerde uitbreiding werkt

- Genereren van hypothetisch antwoord: Het LLM genereert een hypothetisch antwoord op de oorspronkelijke zoekopdracht.

- Contextuele uitbreiding: Het antwoord biedt extra context en gerelateerde termen.

- Gecombineerde zoekopdracht: De oorspronkelijke zoekopdracht en de output van het LLM worden gecombineerd tot een uitgebreide zoekopdracht.

Voorbeeld

Oorspronkelijke zoekopdracht:

“Wat waren de belangrijkste factoren die bijdroegen aan de omzetstijging?”

LLM-gegenereerd antwoord:

“In het boekjaar droegen verschillende belangrijke factoren bij aan de aanzienlijke stijging van de omzet van het bedrijf, waaronder succesvolle marketingcampagnes, productdiversificatie, klanttevredenheidsinitiatieven, strategische prijsstelling en investeringen in technologie.”

Uitgebreide zoekopdracht:

“Oorspronkelijke zoekopdracht: Wat waren de belangrijkste factoren die bijdroegen aan de omzetstijging?

Hypothetisch antwoord: [LLM-gegenereerd antwoord]”

Voordelen

- Diep begrip: Legt genuanceerde relaties en concepten vast.

- Aanpassing: Past de uitbreiding aan op het specifieke domein of de context.

Uitdagingen

- Computational resources: Kan aanzienlijke verwerkingskracht vereisen.

- Over-uitbreiding: Risico op het toevoegen van irrelevante of te veel termen.

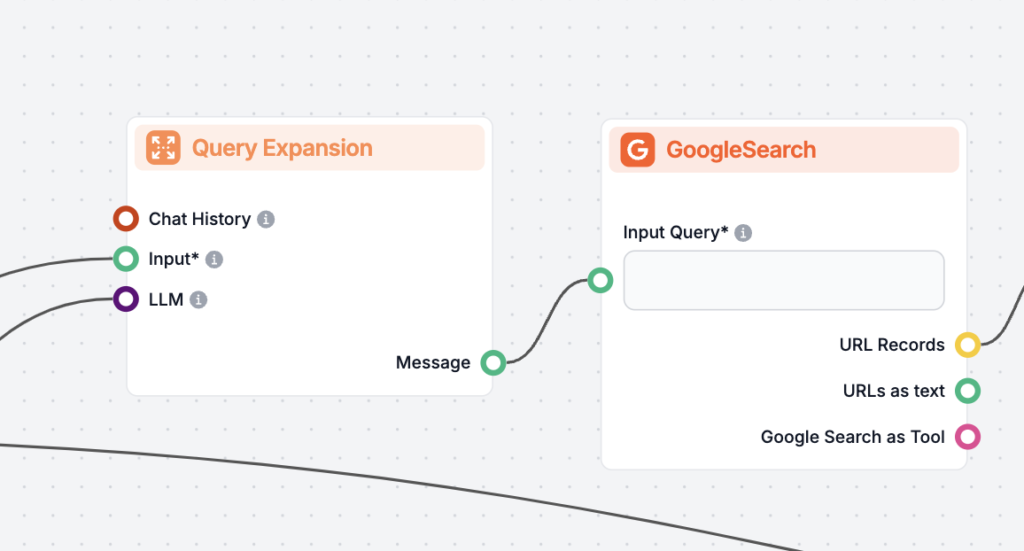

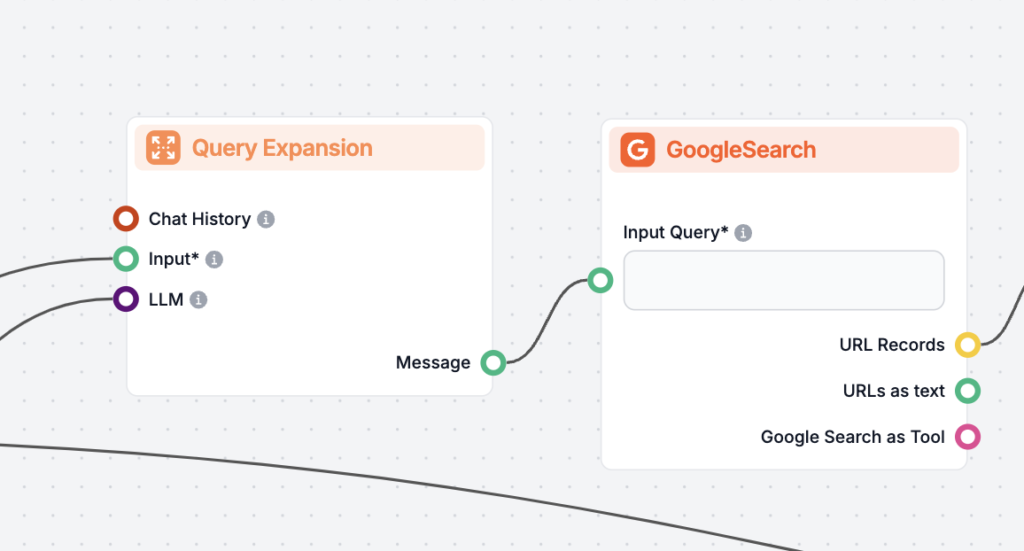

Query-uitbreiding implementeren in RAG-systemen

Stapsgewijs proces

- Zoekopdracht van gebruiker invoeren: Het systeem ontvangt de oorspronkelijke zoekopdracht van de gebruiker.

- LLM-gebaseerde uitbreiding:

- Het systeem vraagt het LLM om een hypothetisch antwoord of gerelateerde zoekopdrachten te genereren.

- Voorbeeldprompt:

“Geef een gedetailleerd antwoord of gerelateerde zoekopdrachten voor: [Zoekopdracht gebruiker]”

- Zoekopdrachten combineren:

- De oorspronkelijke zoekopdracht en de uitgebreide inhoud worden gecombineerd.

- Dit zorgt ervoor dat de uitgebreide zoekopdracht relevant blijft voor de intentie van de gebruiker.

- Gebruik bij ophalen:

- De uitgebreide zoekopdracht wordt gebruikt om documenten uit de kennisbank op te halen.

- Dit kan via keyword search, semantisch zoeken of een combinatie daarvan.

Voordelen in RAG-systemen

- Verbeterde ophaling: Relevantere documenten worden opgehaald, wat zorgt voor betere context voor het LLM.

- Betere gebruikerservaring: Gebruikers krijgen nauwkeurigere en meer informatieve antwoorden.

Documentherordening begrijpen

Waarom herordening nodig is

- Beperkingen van initiële ophaling: Initiële ophalingsmethoden vertrouwen mogelijk op brede gelijkenismaatregelen, die niet altijd genuanceerde relevantie vangen.

- Ruis verminderen: Query-uitbreiding kan minder relevante documenten meenemen; herordening filtert deze eruit.

- Optimaliseren van context voor LLM’s: Het bieden van de meest relevante documenten verhoogt de kwaliteit van de gegenereerde antwoorden door het LLM.

Methoden voor documentherordening

1. Cross-Encoder modellen

Overzicht

Cross-encoders zijn neurale netwerkmodellen die een paar invoerwaarden nemen (de zoekopdracht en een document) en een relevantiescore teruggeven. In tegenstelling tot bi-encoders, die zoekopdracht en document afzonderlijk coderen, verwerken cross-encoders ze gezamenlijk, waardoor rijkere interactie mogelijk is.

Hoe cross-encoders werken

- Documenten koppelen aan zoekopdracht: Elk document wordt gekoppeld aan de zoekopdracht.

- Gezamenlijke codering: Het model codeert het paar samen en legt interacties vast.

- Scoren: Geeft een relevantiescore voor elk document.

- Rangschikken: Documenten worden gesorteerd op basis van deze scores.

Voordelen

- Hoge precisie: Biedt nauwkeurigere relevantiebeoordelingen.

- Contextueel begrip: Legt complexe relaties tussen zoekopdracht en document vast.

Uitdagingen

- Computationally intensive: Vereist aanzienlijke verwerkingskracht, vooral bij grote documentensets.

2. ColBERT (Late Interaction modellen)

Wat is ColBERT?

ColBERT (Contextualized Late Interaction over BERT) is een retrievalmodel dat efficiëntie en effectiviteit in balans brengt. Het gebruikt een late-interactiemechanisme waarmee gedetailleerde vergelijking tussen zoekopdracht- en documenttokens mogelijk is zonder zware rekenlast.

Hoe ColBERT werkt

- Token-niveau codering: Codeert zoekopdracht- en documenttokens afzonderlijk met BERT.

- Late interactie: Vergelijkt tokens van zoekopdracht en document tijdens scoring met behulp van gelijkenismaatregelen.

- Efficiëntie: Maakt voorafgaande berekening van documentembeddings mogelijk.

Voordelen

- Efficiënte scoring: Sneller dan volledige cross-encoders.

- Effectieve ophaling: Behoudt hoge ophalingskwaliteit.

Toepassingen

- Geschikt voor grootschalige ophaling wanneer rekenkracht beperkt is.

3. FlashRank

Overzicht

FlashRank is een lichte en snelle herordeningbibliotheek die gebruikmaakt van de nieuwste cross-encoders. Het is ontworpen om eenvoudig te integreren in bestaande pipelines en de prestaties van herordening te verbeteren met minimale overhead.

Kenmerken

- Gebruiksgemak: Eenvoudige API voor snelle integratie.

- Snelheid: Geoptimaliseerd voor snelle herordening.

- Nauwkeurigheid: Gebruikt effectieve modellen voor hoogwaardige herordening.

Voorbeeldgebruik

from flashrank import Ranker, RerankRequest

query = 'Wat waren de belangrijkste factoren die bijdroegen aan de omzetstijging?'

ranker = Ranker(model_name="ms-marco-MiniLM-L-12-v2")

rerank_request = RerankRequest(query=query, passages=documents)

results = ranker.rerank(rerank_request)

Voordelen

- Vereenvoudigt herordening: Abstraheert de complexiteit van modelgebruik.

- Optimaliseert prestaties: Brengt snelheid en nauwkeurigheid effectief in balans.

Documentherordening implementeren in RAG-systemen

Proces

- Initiële ophaling: Gebruik de uitgebreide zoekopdracht om een set kandidaatdocumenten op te halen.

- Herordening: Pas een herordeningsmodel toe (bijv. Cross-Encoder, ColBERT) om de relevantie van elk document te beoordelen.

- Selectie: Selecteer de hoogst gerangschikte documenten om als context voor het LLM te gebruiken.

Overwegingen

- Computational resources: Herordening kan veel middelen vergen; er is een balans nodig tussen prestaties en kosten.

- Modelselectie: Kies modellen die geschikt zijn voor de vereisten van de toepassing qua nauwkeurigheid en efficiëntie.

- Integratie: Zorg ervoor dat herordening naadloos past in de bestaande pipeline.

Query-uitbreiding en documentherordening combineren in RAG

Synergie tussen query-uitbreiding en herordening

Complementaire technieken

- Query-uitbreiding vergroot de zoekscope en haalt meer documenten op.

- Documentherordening verfijnt deze resultaten en richt zich op de meest relevante.

Voordelen van combineren

- Verbeterde recall en precisie: Samen verbeteren ze zowel de kwantiteit als de kwaliteit van opgehaalde documenten.

- Robuuste ophaling: Pakt de beperkingen van elke methode afzonderlijk aan.

- Betere output van LLM: Biedt betere context, wat leidt tot nauwkeurigere en informatieve antwoorden.

Hoe ze samenwerken

- Zoekopdracht van gebruiker invoeren: De oorspronkelijke zoekopdracht wordt ontvangen.

- Query-uitbreiding: De zoekopdracht wordt uitgebreid via bijvoorbeeld LLM-gebaseerde uitbreiding, resulterend in een uitgebreidere zoekopdracht.

- Initiële ophaling: De uitgebreide zoekopdracht wordt gebruikt om een brede set documenten op te halen.

- Documentherordening: Herordeningsmodellen evalueren en rangschikken de documenten op relevantie voor de oorspronkelijke zoekopdracht.

- Context aanbieden: De hoogst gerangschikte documenten worden aangeboden aan het LLM als context.

- Antwoordgeneratie: Het LLM genereert een antwoord op basis van de meest relevante documenten.

Praktische implementatiestappen

Voorbeeldworkflow

Query-uitbreiding met LLM:

def expand_query(query): prompt = f"Provide additional related queries for: '{query}'" expanded_queries = llm.generate(prompt) expanded_query = ' '.join([query] + expanded_queries) return expanded_queryInitiële ophaling:

documents = vector_db.retrieve_documents(expanded_query)Documentherordening:

from sentence_transformers import CrossEncoder cross_encoder = CrossEncoder('cross-encoder/ms-marco-MiniLM-L-6-v2') pairs = [[query, doc.text] for doc in documents] scores = cross_encoder.predict(pairs) ranked_docs = [doc for _, doc in sorted(zip(scores, documents), reverse=True)]Selecteren van topdocumenten:

top_documents = ranked_docs[:top_k]Antwoord genereren met LLM:

context = '\n'.join([doc.text for doc in top_documents]) prompt = f"Answer the following question using the context provided:\n\nQuestion: {query}\n\nContext:\n{context}" response = llm.generate(prompt)

Monitoring en optimalisatie

- Prestatie-indicatoren: Meet regelmatig de effectiviteit van ophaling met behulp van metrics zoals precisie, recall en relevantiescores.

- Feedbackloops: Neem gebruikersfeedback op om query-uitbreiding en herordeningsstrategieën te verbeteren.

- Resource management: Optimaliseer rekenbronnen, bijvoorbeeld door resultaten te cachen of het aantal te herordenen documenten te beperken.

Toepassingen en voorbeelden

Voorbeeld 1: AI-chatbots voor klantenservice verbeteren

Scenario

Een bedrijf gebruikt een AI-chatbot om klantvragen over hun producten en diensten af te handelen. Klanten stellen vaak vragen op verschillende manieren, met verschillende terminologieën of uitdrukkingen.

Uitdagingen

- Variërend taalgebruik en terminologie van klanten.

- Noodzaak voor nauwkeurige en snelle antwoorden om klanttevredenheid te behouden.

Implementatie

- Query-uitbreiding: De chatbot breidt klantvragen uit met synoniemen en gerelateerde termen.

Bijvoorbeeld, als een klant vraagt: “Hoe kan ik mijn apparaat repareren?”, wordt de zoekopdracht uitgebreid met termen als “reparatie apparaat”, “storing oplossen”, enzovoorts. - Documentherordening: Opgehaalde helpartikelen en FAQ’s worden herordend om de meest relevante oplossingen prioriteit te geven. Cross-encoders beoordelen de relevantie van elk document voor het specifieke probleem van de klant.

Voordelen

- Verbeterde nauwkeurigheid en relevantie van antwoorden.

- Verhoogde klanttevredenheid en kortere afhandeltijden.

Voorbeeld 2: AI-gestuurde onderzoekstools optimaliseren

Scenario

Onderzoekers gebruiken een AI-assistent om relevante academische artikelen, gegevens en inzichten te vinden voor hun werk.

Uitdagingen

- Complexe zoekopdrachten met gespecialiseerde terminologie.

- Grote hoeveelheden academische literatuur om door te nemen.

Implementatie

- Query-uitbreiding: De assistent gebruikt LLM’s om zoekopdrachten uit te breiden met gerelateerde concepten en synoniemen.

Een zoekopdracht als “toepassingen van quantumverstrengeling” wordt uitgebreid met “gebruik van quantumverstrengeling”, “quantum computing verstrengeling”, enzovoorts. - Documentherordening: Academische artikelen worden herordend op basis van relevantie voor de verfijnde

Veelgestelde vragen

- Wat is documentherordening?

Documentherordening is het proces waarbij opgehaalde documenten na een eerste zoekopdracht opnieuw gerangschikt worden op basis van hun relevantie voor de zoekopdracht van een gebruiker. Het zorgt ervoor dat de meest relevante en bruikbare documenten prioriteit krijgen, waardoor de kwaliteit van door AI aangedreven zoekopdrachten en chatbots wordt verbeterd.

- Hoe werkt documentherordening in RAG-systemen?

In RAG-systemen gebruikt documentherordening modellen zoals cross-encoders of ColBERT om de relevantie van elk document voor de zoekopdracht van de gebruiker te beoordelen, na een eerste ophaling. Deze stap helpt het aantal documenten dat aan grote taalmodellen wordt geleverd te verfijnen en te optimaliseren voor het genereren van nauwkeurige antwoorden.

- Wat is query-uitbreiding en waarom is het belangrijk?

Query-uitbreiding is een techniek in informatieophaling waarbij de oorspronkelijke zoekopdracht van de gebruiker wordt uitgebreid met gerelateerde termen of uitdrukkingen, waardoor de recall toeneemt en ambiguïteit wordt aangepakt. In RAG-systemen helpt het om meer relevante documenten op te halen die mogelijk andere terminologie gebruiken.

- Wat zijn de belangrijkste methoden voor documentherordening?

Belangrijke methoden zijn onder andere cross-encoder neurale modellen (die zoekopdracht en document gezamenlijk coderen voor een hoge precisie van scoring), ColBERT (dat late interactie gebruikt voor efficiënte scoring), en bibliotheken zoals FlashRank voor snelle, nauwkeurige herordening.

- Hoe werken query-uitbreiding en documentherordening samen?

Query-uitbreiding verbreedt de zoekopdracht om meer potentieel relevante documenten op te halen, terwijl documentherordening deze resultaten filtert en verfijnt om ervoor te zorgen dat alleen de meest relevante documenten aan de AI worden doorgegeven voor antwoordgeneratie, waardoor zowel recall als precisie wordt gemaximaliseerd.

Verbeter AI-Ophalen met Documentherordening

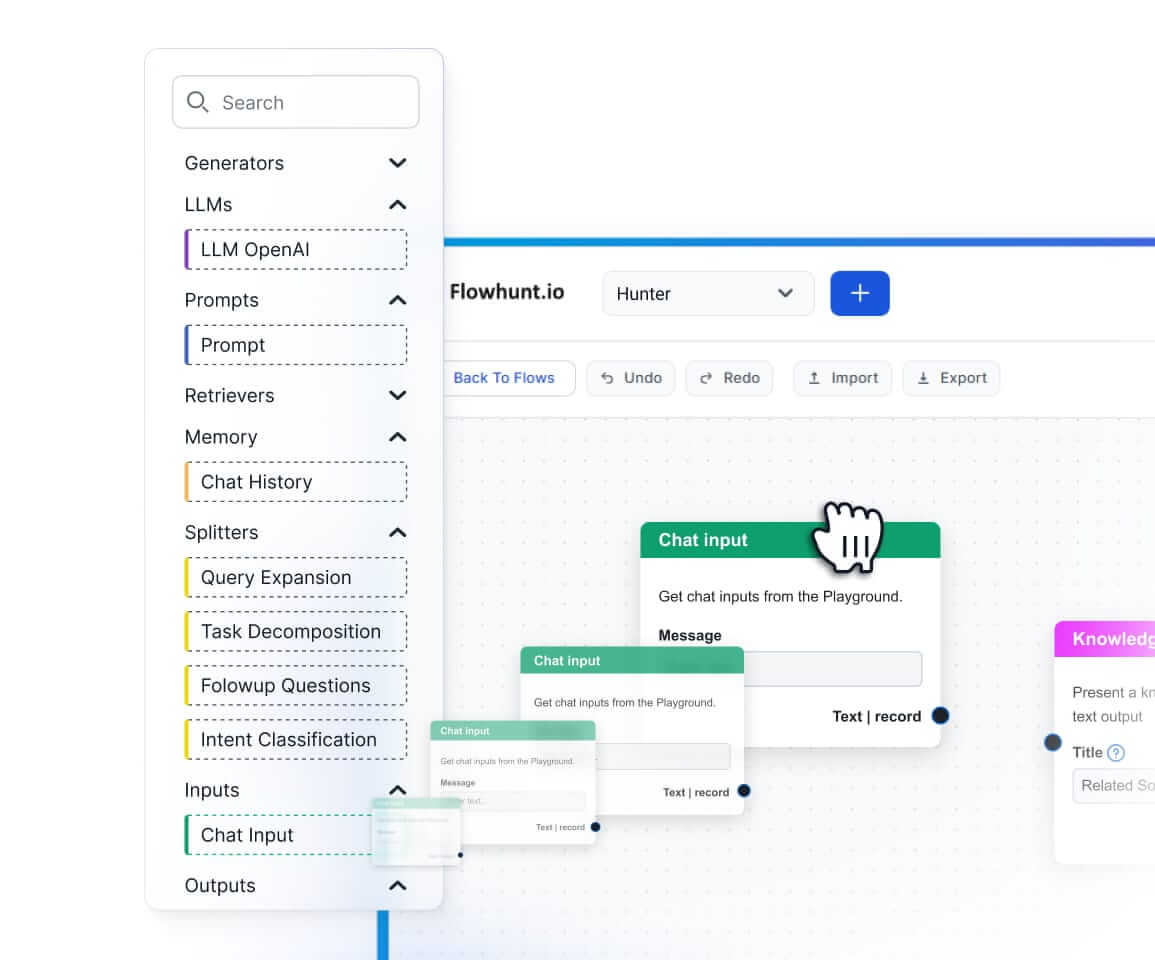

Ontdek hoe documentherordening en query-uitbreiding de nauwkeurigheid en relevantie van je AI-chatbots en automatiseringsflows kunnen verbeteren. Bouw slimmere AI met FlowHunt.