Generaliseringsfout

Generaliseringsfout is een belangrijke maatstaf in machine learning, die het vermogen van een model kwantificeert om uitkomsten voor onbekende data te voorspellen en zorgt voor robuuste prestaties in de praktijk.

Generaliseringsfout, vaak ook out-of-sample error of risico genoemd, is een fundamenteel begrip binnen machine learning en statistische leertechniek. Het drukt uit hoe goed een model of algoritme uitkomsten kan voorspellen voor onbekende data, gebaseerd op training op een eindige dataset. Het belangrijkste doel van het beoordelen van de generaliseringsfout is om het vermogen van een model te begrijpen om goed te presteren op nieuwe, nog niet eerder geziene data, in plaats van alleen op de data waarop het getraind is. Dit concept is essentieel voor het ontwikkelen van modellen die zowel accuraat als robuust zijn in praktische toepassingen.

Inzicht in generaliseringsfout

De kern van generaliseringsfout is het verschil tussen de voorspellingen van een model en de werkelijke uitkomsten op nieuwe data. Deze fout ontstaat uit meerdere bronnen, waaronder modelonnauwkeurigheden, steekproeffouten en inherente ruis in de data. Sommige van deze fouten kunnen worden geminimaliseerd door technieken zoals modelselectie en het afstellen van parameters, terwijl andere, zoals ruis, onvermijdelijk zijn.

Belang in machine learning

In contexten van supervised learning dient generaliseringsfout als een cruciale maatstaf voor het beoordelen van de prestaties van algoritmen. Het zorgt ervoor dat een model niet alleen goed aansluit op de data waarop het getraind is, maar ook effectief kan worden toegepast bij het maken van voorspellingen in reële situaties. Dit is van groot belang voor toepassingen variërend van data science tot AI-gedreven automatisering in chatbots en andere AI-systemen.

Overfitting en underfitting

Generaliseringsfout hangt nauw samen met de concepten overfitting en underfitting:

- Overfitting treedt op wanneer een model de trainingsdata te goed leert, inclusief de ruis, wat leidt tot slechte prestaties op onbekende data.

- Underfitting gebeurt als een model te simplistisch is en de onderliggende patronen in de data niet kan vastleggen, wat resulteert in slechte prestaties op zowel trainingsdata als onbekende data.

Wiskundige definitie

Wiskundig wordt de generaliseringsfout ( I[f] ) van een functie ( f ) gedefinieerd als de verwachtingswaarde van een verliesfunctie ( V ) over de gezamenlijke kansverdeling van input-outputparen ( (x, y) ):

[ I[f] = \int_{X \times Y} V(f(\vec{x}), y) \rho(\vec{x}, y) d\vec{x} dy ]

Hierbij is ( \rho(\vec{x}, y) ) de gezamenlijke kansverdeling van de inputs en outputs, die in de praktijk meestal onbekend is. In plaats daarvan berekenen we de empirische fout (of empirisch risico) op basis van de steekproefdata:

[ I_n[f] = \frac{1}{n} \sum_{i=1}^{n} V(f(\vec{x}_i), y_i) ]

Een algoritme generaliseert goed als het verschil tussen de generaliseringsfout en de empirische fout naar nul neigt wanneer de steekproefgrootte ( n ) naar oneindig gaat.

Bias-variantie-afweging

De bias-variantie-afweging is een belangrijk principe bij het begrijpen van generaliseringsfout. Het beschrijft de afweging tussen twee soorten fouten:

- Bias: Fout als gevolg van te simpele aannames in het model, waardoor het onderliggende trends in de data niet kan vastleggen.

- Variantie: Fout door overmatige gevoeligheid voor kleine fluctuaties in de trainingsdata, wat vaak leidt tot overfitting.

Het doel is een balans te vinden waarbij zowel bias als variantie geminimaliseerd worden, zodat de generaliseringsfout laag is. Deze balans is essentieel voor het ontwikkelen van modellen die zowel nauwkeurig als robuust zijn.

Technieken om generaliseringsfout te minimaliseren

Er worden verschillende technieken toegepast om de generaliseringsfout te minimaliseren:

- Cross-validatie: Technieken zoals k-fold cross-validatie helpen bij het beoordelen van de prestaties van een model op onbekende data door de data meerdere keren op te splitsen in trainings- en validatiesets.

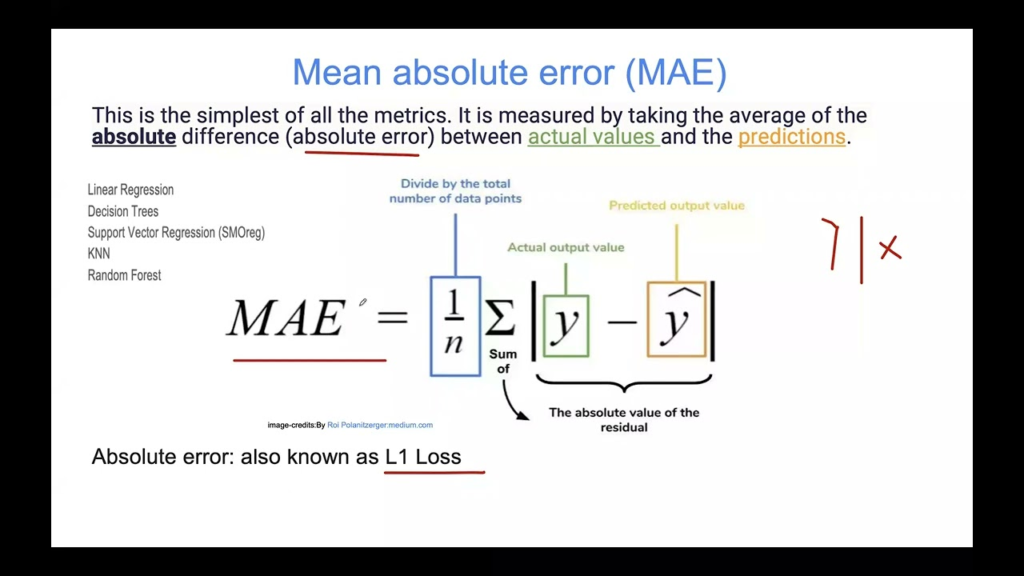

- Regularisatie: Methoden zoals L1 (lasso) en L2 (ridge) regularisatie voegen een boete toe voor grotere coëfficiënten, waardoor te complexe modellen die mogelijk overfitten worden ontmoedigd.

- Modelselectie: Het kiezen van de juiste modelcomplexiteit op basis van het probleem en de dataset helpt effectief bij het beheren van de bias-variantie-afweging.

- Ensemble-methoden: Technieken zoals bagging en boosting combineren meerdere modellen om de generalisatie te verbeteren door variantie en bias te verminderen.

Gebruikstoepassingen en voorbeelden

AI- en machine learning-toepassingen

In AI-toepassingen, zoals chatbots, is het cruciaal om een lage generaliseringsfout te waarborgen zodat de bot accuraat kan reageren op een breed scala aan gebruikersvragen. Als een chatbot-model overfit is op de trainingsdata, presteert het mogelijk alleen goed op vooraf gedefinieerde vragen maar faalt het bij nieuwe gebruikersinvoer.

Data science-projecten

In data science zijn modellen met een lage generaliseringsfout essentieel om voorspellingen te maken die goed generaliseren over verschillende datasets. Bijvoorbeeld: in voorspellende analyses moet een model dat is getraind op historische data toekomstige trends accuraat kunnen voorspellen.

Supervised learning

Bij supervised learning is het doel een functie te ontwikkelen die outputwaarden voor elke input kan voorspellen. De generaliseringsfout geeft inzicht in hoe goed deze functie zal presteren op nieuwe data die niet in de trainingsset aanwezig waren.

Evaluatie van leeralgoritmen

Generaliseringsfout wordt gebruikt om de prestaties van leeralgoritmen te evalueren. Door leercurves te analyseren, waarop de trainings- en validatiefouten in de tijd worden uitgezet, kan men beoordelen of een model waarschijnlijk zal overfitten of underfitten.

Statistische leertechniek

In de statistische leertechniek is het begrenzen van het verschil tussen generaliseringsfout en empirische fout een centraal aandachtspunt. Diverse stabiliteitsvoorwaarden, zoals leave-one-out cross-validation stabiliteit, worden gebruikt om te bewijzen dat een algoritme goed zal generaliseren.

Generaliseringsfout in machine learning

Generaliseringsfout is een cruciaal begrip in machine learning en staat voor het verschil tussen het foutenpercentage van een model op trainingsdata en op onbekende data. Het weerspiegelt hoe goed een model uitkomsten kan voorspellen voor nieuwe, niet eerder geziene voorbeelden.

Referenties:

Some observations concerning Off Training Set (OTS) error door Jonathan Baxter, gepubliceerd op 18 november 2019, bespreekt een vorm van generaliseringsfout die bekend staat als de Off Training Set (OTS) error. Het artikel behandelt een stelling die aangeeft dat een kleine trainingsfout niet noodzakelijk een kleine OTS-fout betekent, tenzij bepaalde aannames worden gedaan over de doelfunctie. De auteur betoogt echter dat de toepasbaarheid van de stelling beperkt is tot modellen waarbij de verdeling van de trainingsdata niet overlapt met die van de testdata, wat in de praktijk bij machine learning meestal niet het geval is. Lees meer

Stopping Criterion for Active Learning Based on Error Stability door Hideaki Ishibashi en Hideitsu Hino, gepubliceerd op 9 april 2021, introduceert een stopcriterium voor actief leren op basis van foutstabiliteit. Dit criterium zorgt ervoor dat de verandering in generaliseringsfout bij het toevoegen van nieuwe steekproeven wordt begrensd door de annotatiekosten, waardoor het toepasbaar is op elk Bayesiaans actief leerframework. De studie toont aan dat het voorgestelde criterium effectief het optimale stopmoment voor actief leren bepaalt bij verschillende modellen en datasets. Lees meer

Veelgestelde vragen

- Wat is generaliseringsfout in machine learning?

Generaliseringsfout verwijst naar het verschil tussen de prestaties van een model op trainingsdata en zijn vermogen om uitkomsten te voorspellen voor onbekende data. Het is een cruciale maatstaf om te beoordelen hoe goed een model zal presteren in praktijksituaties.

- Hoe kan de generaliseringsfout geminimaliseerd worden?

Technieken zoals cross-validatie, regularisatie, zorgvuldige modelselectie en ensemble-methoden helpen de generaliseringsfout te minimaliseren door bias en variantie in balans te brengen, waardoor de voorspellende prestaties van een model op nieuwe data worden verbeterd.

- Waarom is generaliseringsfout belangrijk?

Het begrijpen en minimaliseren van de generaliseringsfout zorgt ervoor dat AI- en machine learning-modellen betrouwbaar presteren op nieuwe, echte data, en niet alleen op de voorbeelden waarop ze zijn getraind.

- Wat is de bias-variantie-afweging?

De bias-variantie-afweging beschrijft het evenwicht tussen fouten door te simpele modelaannames (bias) en fouten door overgevoeligheid voor trainingsdata (variantie). Het juiste evenwicht helpt de generaliseringsfout te minimaliseren.

Klaar om je eigen AI te bouwen?

Begin met het bouwen van robuuste AI-modellen met FlowHunt. Ontdek intuïtieve tools om de generaliseringsfout te minimaliseren en de nauwkeurigheid in de praktijk te maximaliseren.