Query-uitbreiding

Query-uitbreiding verrijkt gebruikersvragen met extra context of termen, wat de nauwkeurigheid van het ophalen en de kwaliteit van antwoorden in AI-systemen zoals RAG en chatbots verbetert.

Query-uitbreiding

Query-uitbreiding verrijkt gebruikersvragen door termen of context toe te voegen, zodat documenten beter worden opgehaald voor nauwkeurige antwoorden. In RAG-systemen verhoogt het de recall en relevantie, waardoor chatbots en AI precieze antwoorden kunnen geven door vage of synonieme vragen effectief te verwerken.

Query-uitbreiding verwijst naar het proces waarbij de oorspronkelijke zoekopdracht van een gebruiker wordt verrijkt met extra termen of context voordat deze naar het opvraagmechanisme wordt gestuurd. Door deze aanvulling kunnen relevantere documenten of stukken informatie worden opgehaald, die vervolgens worden gebruikt om een nauwkeuriger en contextueel passend antwoord te genereren. Als documenten worden opgehaald met alternatieve zoekopdrachten en daarna opnieuw worden gerangschikt, levert het RAG-proces veel preciezere documentresultaten op in het contextvenster van de prompt.

Wat is Retrieval-Augmented Generation (RAG)?

Retrieval-Augmented Generation (RAG) is een AI-architectuur die opvraagmechanismen combineert met generatieve modellen om nauwkeurigere en contextueel relevantere antwoorden te produceren. In RAG-systemen haalt een retrieval-component relevante documenten of gegevensfragmenten uit een kennisbank op basis van een gebruikersvraag. Vervolgens gebruikt een generatief model (vaak een Large Language Model of LLM) deze opgehaalde informatie om een samenhangend en informatief antwoord te genereren.

De rol van query-uitbreiding in RAG-systemen

Verbeteren van de retrieval-prestaties

In RAG-systemen hangt de kwaliteit van het gegenereerde antwoord sterk af van de relevantie van de opgehaalde documenten. Als het opvraagonderdeel er niet in slaagt de meest relevante informatie te vinden, kan het generatieve model suboptimale of irrelevante antwoorden produceren. Query-uitbreiding pakt deze uitdaging aan door de oorspronkelijke zoekopdracht te verbeteren, waardoor de kans groter wordt dat alle relevante documenten worden opgehaald.

Verhogen van recall

Door de oorspronkelijke vraag uit te breiden met verwante termen, synoniemen of parafrases, wordt de zoekruimte groter gemaakt. Dit verhoogt de recall van het opvragsysteem, wat betekent dat een groter deel van de relevante documenten uit de kennisbank wordt opgehaald. Een hogere recall zorgt voor meer context voor het generatieve model, wat de algehele kwaliteit van de output van het RAG-systeem verbetert.

Hoe wordt query-uitbreiding gebruikt in RAG-systemen?

Stappen in het query-uitbreidingsproces

- Ontvang gebruikersvraag: Het proces begint met de oorspronkelijke vraag van de gebruiker, die onvolledig, vaag of specifieke terminologie kan bevatten die niet overeenkomt met documenten in de kennisbank.

- Genereer uitgebreide vragen: Het systeem genereert extra vragen die semantisch lijken op de oorspronkelijke. Dit kan met verschillende technieken, waaronder het gebruik van Large Language Models (LLM’s).

- Haal documenten op: Elke uitgebreide vraag wordt gebruikt om documenten uit de kennisbank op te halen. Dit leidt tot een grotere en meer diverse verzameling mogelijk relevante documenten.

- Resultaten aggregeren: De opgehaalde documenten worden samengevoegd, waarbij duplicaten worden verwijderd en gerangschikt op relevantie.

- Genereer antwoord: Het generatieve model gebruikt de verzamelde documenten om een definitief antwoord te formuleren op de gebruikersvraag.

Technieken voor query-uitbreiding

1. Gebruik van Large Language Models (LLM’s)

LLM’s zoals GPT-4 kunnen semantisch vergelijkbare vragen of parafrases van de oorspronkelijke vraag genereren. Door het begrijpen van context en nuances in taal, kunnen LLM’s hoogwaardige uitbreidingen produceren die verschillende formuleringen van dezelfde vraag dekken.

Voorbeeld:

- Oorspronkelijke vraag: “Effecten van klimaatverandering”

- Uitgebreide vragen gegenereerd door LLM:

- “Impact van opwarming van de aarde”

- “Gevolgen van milieuwijzigingen”

- “Klimaatvariabiliteit en de effecten daarvan”

2. Hypothetische antwoordgeneratie

Bij deze benadering genereert het systeem een hypothetisch antwoord op de gebruikersvraag met behulp van een LLM. Het hypothetische antwoord wordt toegevoegd aan de oorspronkelijke vraag om meer context te bieden voor het ophalen.

Proces:

- Genereer een hypothetisch antwoord op de vraag.

- Combineer de oorspronkelijke vraag en het hypothetische antwoord.

- Gebruik de gecombineerde tekst als zoekopdracht voor het retrieval.

Voorbeeld:

- Oorspronkelijke vraag: “Welke factoren droegen bij aan de omzetstijging?”

- Gegenereerd hypothetisch antwoord:

- “De omzet van het bedrijf steeg dankzij succesvolle marketingcampagnes, productdiversificatie en uitbreiding naar nieuwe markten.”

- Gecombineerde zoekopdracht:

- “Welke factoren droegen bij aan de omzetstijging? De omzet van het bedrijf steeg dankzij succesvolle marketingcampagnes, productdiversificatie en uitbreiding naar nieuwe markten.”

3. Multi-query aanpak

Bij deze methode worden meerdere alternatieve vragen gegenereerd, die verschillende formuleringen of aspecten van de oorspronkelijke vraag omvatten. Elke vraag wordt onafhankelijk gebruikt om documenten op te halen.

Proces:

- Genereer meerdere vergelijkbare vragen met een LLM.

- Haal voor elke vraag afzonderlijk documenten op.

- Combineer en rangschik de opgehaalde documenten.

Voorbeeld:

- Oorspronkelijke vraag: “Belangrijkste drijfveren van bedrijfsontwikkeling”

- Uitgebreide vragen:

- “Hoofdfactoren voor bedrijfsgroei”

- “Wat leidde tot de toename van de bedrijfsresultaten?”

- “Belangrijke bijdragers aan organisatiegroei”

Voorbeelden en use-cases

Casestudy: Verbetering van RAG voor analyse van jaarverslagen

Scenario:

Een AI-systeem is ontworpen om vragen te beantwoorden op basis van het jaarverslag van een bedrijf. Een gebruiker vraagt: “Was er veel verloop in het managementteam?”

Implementatie:

- Hypothetische antwoordgeneratie:

- Het systeem genereert een hypothetisch antwoord: “Er was weinig verloop in het managementteam, wat zorgde voor stabiliteit en continuïteit in strategische initiatieven.”

- Query-uitbreiding:

- Het hypothetische antwoord wordt gecombineerd met de oorspronkelijke vraag tot een uitgebreide zoekopdracht.

- Retrieval:

- De uitgebreide zoekopdracht wordt gebruikt om relevantere delen van het jaarverslag te vinden die gaan over veranderingen in het managementteam.

- Generatie:

- De AI genereert een precies antwoord op basis van de opgehaalde informatie.

Voordeel:

Door meer context te bieden met het hypothetische antwoord, haalt het systeem relevante informatie op die mogelijk gemist zou zijn met alleen de oorspronkelijke vraag.

Casestudy: Verbetering van zoekfunctionaliteit in klantenservice-chatbots

Scenario:

Een klantenservice-chatbot helpt gebruikers met het oplossen van problemen. Een gebruiker typt: “Mijn internet is traag.”

Implementatie:

- Query-uitbreiding met LLM:

- Genereer uitgebreide vragen:

- “Ervaar lagere internetsnelheid”

- “Trage breedbandverbinding”

- “Internet latentieproblemen”

- Genereer uitgebreide vragen:

- Retrieval:

- Elke vraag haalt help-artikelen en stappen voor probleemoplossing op die betrekking hebben op trage internetsnelheden.

- Antwoordgeneratie:

- De chatbot verzamelt de opgehaalde informatie en begeleidt de gebruiker door mogelijke oplossingen.

Voordeel:

De chatbot dekt een breder scala aan mogelijke problemen en oplossingen, waardoor de kans groter is dat het probleem van de gebruiker efficiënt wordt opgelost.

Casestudy: Ondersteuning bij academisch onderzoek

Scenario:

Een student gebruikt een AI-assistent om bronnen te vinden over het onderwerp: “Effecten van slaaptekort op cognitieve functies.”

Implementatie:

- Multi-query generatie:

- Genereer soortgelijke vragen:

- “Hoe beïnvloedt gebrek aan slaap het denkvermogen?”

- “Cognitieve beperkingen door slaapverlies”

- “Slaaptekort en mentale prestaties”

- Genereer soortgelijke vragen:

- Retrieval:

- Haal onderzoeksartikelen en papers op voor elke vraag.

- Aggregatie en ranking:

- Combineer de resultaten en geef prioriteit aan de meest relevante en recente studies.

- Antwoordgeneratie:

- De AI geeft een samenvatting van de bevindingen en suggereert belangrijke artikelen om te raadplegen.

Voordeel:

De student ontvangt uitgebreide informatie die verschillende aspecten van het onderwerp dekt, wat helpt bij grondiger onderzoek.

Voordelen van query-uitbreiding in RAG-systemen

- Verbeterde recall: Door meer relevante documenten op te halen, biedt het systeem betere context voor het genereren van nauwkeurige antwoorden.

- Omgaan met vage vragen: Pakt het probleem van korte of onduidelijke vragen aan door extra context toe te voegen.

- Herkenning van synoniemen: Vindt documenten met synoniemen of verwante termen die niet in de oorspronkelijke vraag staan.

- Verbeterde gebruikerservaring: Gebruikers krijgen meer accurate en informatieve antwoorden zonder hun vraag handmatig te hoeven verfijnen.

Uitdagingen en aandachtspunten

Over-uitbreiding

Te veel uitgebreide vragen kunnen irrelevante documenten opleveren, waardoor de precisie van het ophalen afneemt.

Oplossing:

- Gecontroleerde generatie: Beperk het aantal uitgebreide vragen.

- Relevantie-filtering: Gebruik scores om de meest relevante uitbreidingen te prioriteren.

Ambiguïteit en polysemie

Woorden met meerdere betekenissen kunnen leiden tot irrelevante uitbreidingen.

Oplossing:

- Contextafhankelijke uitbreiding: Gebruik LLM’s die rekening houden met de context van de vraag.

- Disambiguatietechnieken: Implementeer algoritmen om verschillende betekenissen te onderscheiden op basis van de context van de vraag.

Computationele middelen

Het genereren en verwerken van meerdere uitgebreide vragen kan veel rekenkracht vereisen.

Oplossing:

- Efficiënte modellen: Gebruik geoptimaliseerde LLM’s en retrieval-systemen.

- Caching-mechanismen: Cache veelvoorkomende vragen en uitbreidingen om rekenwerk te verminderen.

Integratie met retrieval-systemen

Zorg ervoor dat de uitgebreide vragen effectief samenwerken met de bestaande retrieval-algoritmen.

Oplossing:

- Score-aanpassingen: Pas retrieval-scores aan om rekening te houden met uitgebreide vragen.

- Hybride benaderingen: Combineer keyword-based en semantische retrieval-methoden.

Technieken voor effectieve query-uitbreiding

Termweging

Termen in de uitgebreide vragen gewichten toekennen op basis van hun belangrijkheid.

- TF-IDF (Term Frequency-Inverse Document Frequency): Meet hoe belangrijk een term is in een document ten opzichte van een hele collectie.

- BM25-score: Een rankingfunctie die door zoekmachines wordt gebruikt om de relevantie van documenten te schatten.

- Aangepaste gewichten: Pas gewichten aan op basis van de relevantie van de uitgebreide termen.

Her-rangschikken van opgehaalde documenten

Na het ophalen de documenten opnieuw rangschikken om relevantie te prioriteren.

- Cross-Encoders: Gebruik modellen die de relevantie van query-documentparen beoordelen.

- Her-rangschikmodellen (zoals ColBERT, FlashRank): Gespecialiseerde modellen die efficiënt en nauwkeurig her-rangschikken.

Voorbeeld:

Gebruik een Cross-Encoder na het ophalen om documenten te scoren en opnieuw te rangschikken op basis van hun relevantie voor de oorspronkelijke vraag.

Gebruik van gebruikersfeedback

Gebruikersinteracties inzetten om query-uitbreiding te verbeteren.

- Impliciete feedback: Analyseer gebruikersgedrag, zoals klikken en tijd besteed aan documenten.

- Expliciete feedback: Laat gebruikers zoekopdrachten verfijnen of voorkeursresultaten selecteren.

Verbinding met AI, AI-automatisering en chatbots

AI-gestuurde query-uitbreiding

Door AI en LLM’s te gebruiken voor query-uitbreiding wordt geavanceerd taalbegrip ingezet om retrieval te verbeteren. Dit stelt AI-systemen, waaronder chatbots en virtuele assistenten, in staat om meer nauwkeurige en contextueel passende antwoorden te geven.

Automatisering in informatieopvraging

Door het proces van query-uitbreiding te automatiseren, hoeven gebruikers zelf geen precieze zoekopdrachten op te stellen. AI-automatisering handelt de complexiteit af op de achtergrond, wat de efficiëntie van informatieopvraagsystemen verhoogt.

Verbetering van chatbot-interacties

Chatbots profiteren van query-uitbreiding door gebruikersintenties beter te begrijpen, vooral als gebruikers informele taal of onvolledige zinnen gebruiken. Dit leidt tot bevredigendere interacties en effectievere probleemoplossing.

Voorbeeld:

Een chatbot die technische ondersteuning biedt, kan een vage vraag van een gebruiker zoals “Mijn app werkt niet” uitbreiden met “applicatie crasht”, “software reageert niet” en “app-foutmeldingen”, wat leidt tot een snellere oplossing.

Onderzoek naar query-uitbreiding voor RAG

Verbetering van retrieval voor RAG-gebaseerde vraagbeantwoording op financiële documenten

Dit artikel onderzoekt de effectiviteit van Large Language Models (LLM’s) die worden ondersteund door Retrieval-Augmented Generation (RAG), met name in de context van financiële documenten. Er wordt vastgesteld dat onnauwkeurigheden in LLM-uitvoer vaak ontstaan door suboptimale tekstfragment-ophaling in plaats van door de LLM’s zelf. De studie stelt verbeteringen voor in RAG-processen, waaronder geavanceerde chunking-technieken en query-uitbreiding, samen met metadata-annotaties en her-rangschikalgoritmen. Deze methodologieën zijn bedoeld om teksten beter op te halen en zo de prestaties van LLM’s bij het genereren van nauwkeurige antwoorden te verbeteren. Lees meerVerbeteren van retrieval en beheer: een vier-modulesynergie voor verbeterde kwaliteit en efficiëntie in RAG-systemen

Dit artikel introduceert een modulaire aanpak om RAG-systemen te verbeteren, met de nadruk op de Query Rewriter-module, die zoekvriendelijke queries creëert om kennisopvraging te verbeteren. Het behandelt problemen zoals Information Plateaus en ambiguïteit in vragen door meerdere queries te genereren. Daarnaast worden de Knowledge Filter en Memory Knowledge Reservoir voorgesteld om irrelevante kennis te beheren en retrieval-middelen te optimaliseren. Deze ontwikkelingen zijn bedoeld om de kwaliteit en efficiëntie van antwoorden in RAG-systemen te verbeteren, gevalideerd door experimenten op QA-datasets. Bekijk de code en meer details.MultiHop-RAG: Benchmarking Retrieval-Augmented Generation voor multi-hop-vragen

Dit onderzoek belicht uitdagingen bij bestaande RAG-systemen als het gaat om multi-hop-vragen, die redeneren over meerdere bewijselementen vereisen. Het introduceert een nieuwe dataset die specifiek is ontworpen om RAG-systemen te benchmarken op multi-hop-vragen, met als doel de grenzen van huidige RAG-capaciteiten te verleggen. Het artikel bespreekt noodzakelijke verbeteringen voor RAG-methoden om complexe vraagstructuren effectief te verwerken en de adoptie van LLM’s voor praktische toepassingen te bevorderen.

Veelgestelde vragen

- Wat is query-uitbreiding?

Query-uitbreiding is het proces waarin de oorspronkelijke zoekopdracht van een gebruiker wordt aangevuld met verwante termen, synoniemen of context, waardoor opvraagmechanismen relevantere documenten kunnen ophalen en nauwkeurigere antwoorden kunnen genereren, vooral in AI-gestuurde toepassingen.

- Hoe verbetert query-uitbreiding RAG-systemen?

In RAG-systemen (Retrieval-Augmented Generation) vergroot query-uitbreiding de recall van het opvraagonderdeel door de zoekruimte te verbreden, zodat meer relevante documenten worden overwogen voor het genereren van precieze antwoorden.

- Welke technieken worden gebruikt voor query-uitbreiding?

Technieken zijn onder andere het gebruik van Large Language Models voor het genereren van geparafraseerde vragen, hypothetische antwoordgeneratie, multi-query benaderingen, termweging en het benutten van gebruikersfeedback voor continue verbetering.

- Wat zijn de voordelen van query-uitbreiding?

Query-uitbreiding verbetert de recall, behandelt vage of dubbelzinnige zoekopdrachten, herkent synoniemen en verhoogt de gebruikerservaring door meer accurate en informatieve antwoorden te geven zonder handmatige aanpassing van de vraag.

- Zijn er uitdagingen bij query-uitbreiding?

Ja, uitdagingen zijn onder meer over-uitbreiding (waardoor irrelevante documenten worden geïntroduceerd), ambiguïteit in termen, eisen aan rekenkracht en het waarborgen van compatibiliteit met opvraagalgoritmen. Deze kunnen worden verminderd met gecontroleerde generatie, relevantiefiltering en efficiënte modellen.

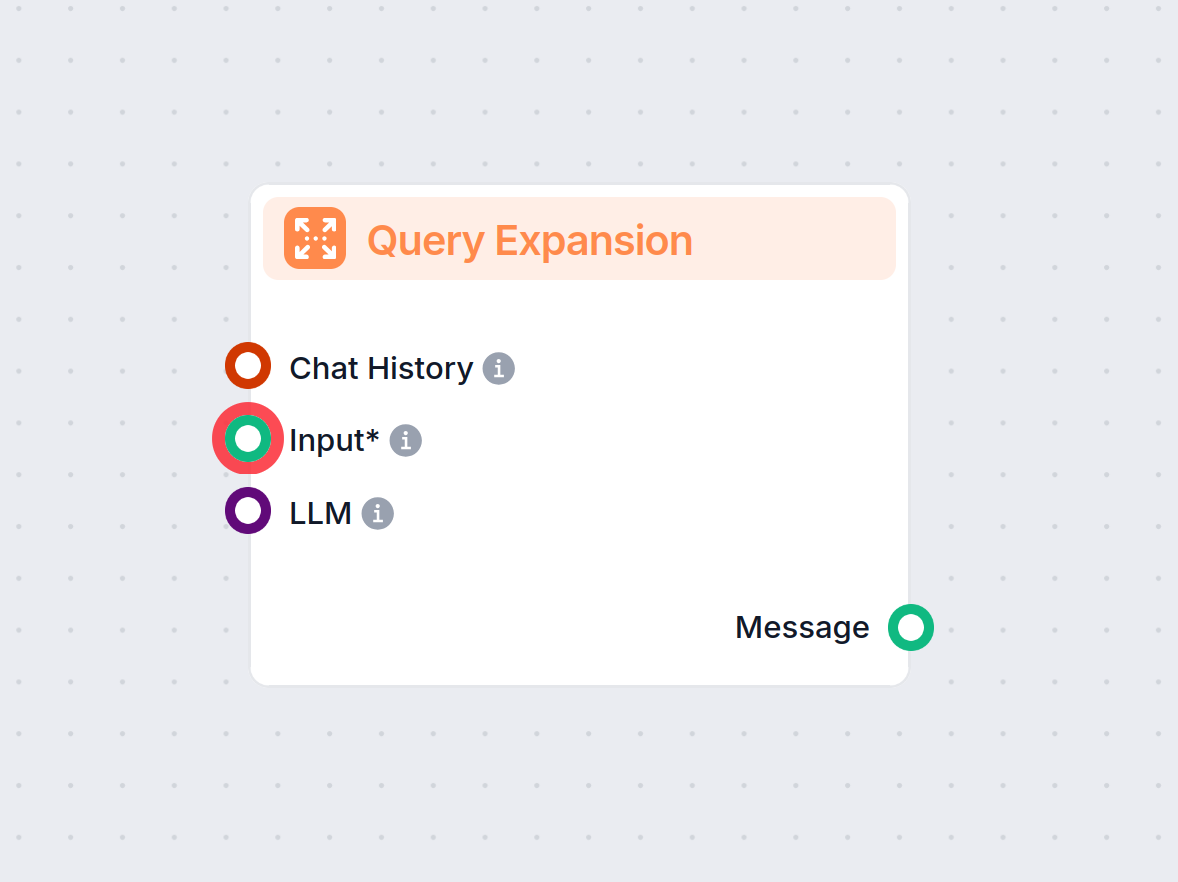

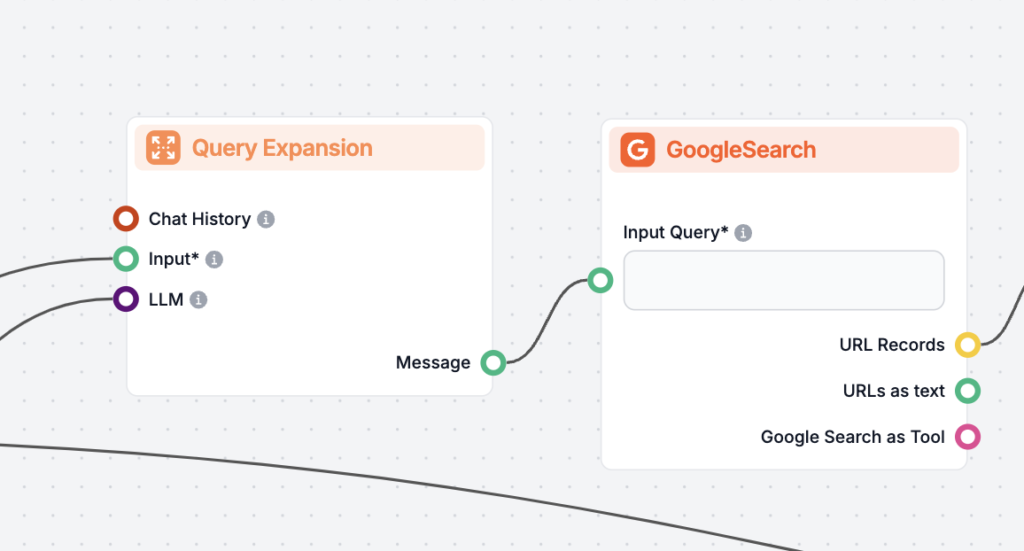

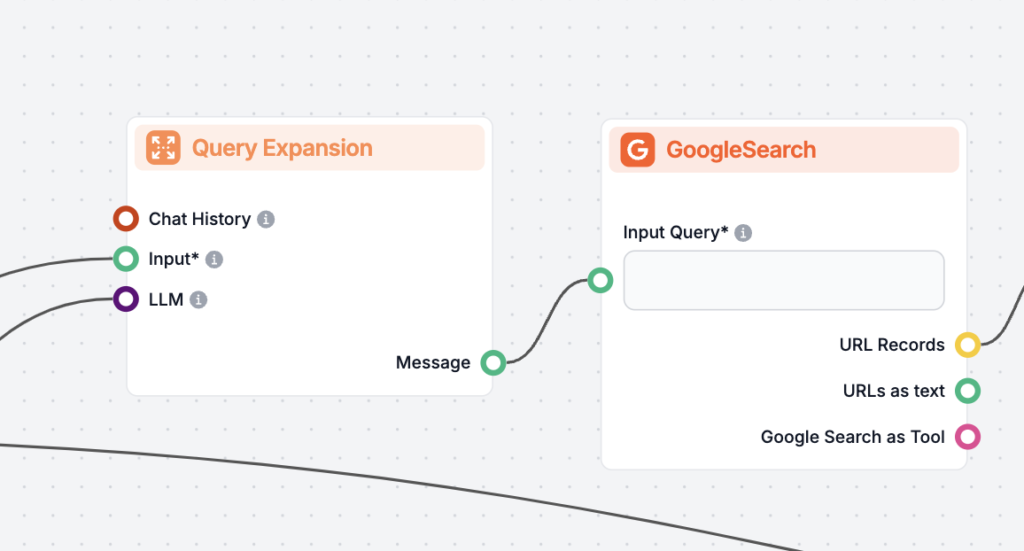

Ontdek Query-uitbreiding met FlowHunt

Bekijk hoe Query-uitbreiding de nauwkeurigheid van je AI-chatbot kan verbeteren en het ophalen van informatie optimaliseert. Ontdek de oplossingen van FlowHunt voor efficiënte, geautomatiseerde query-afhandeling.