Deepseek R1 MCP Server

Integreer DeepSeek’s contextrijke, redeneer-geoptimaliseerde modellen in je AI-workflows met de Deepseek R1 MCP Server voor geavanceerde taalopdrachten en automatisering.

Wat doet de “Deepseek R1” MCP Server?

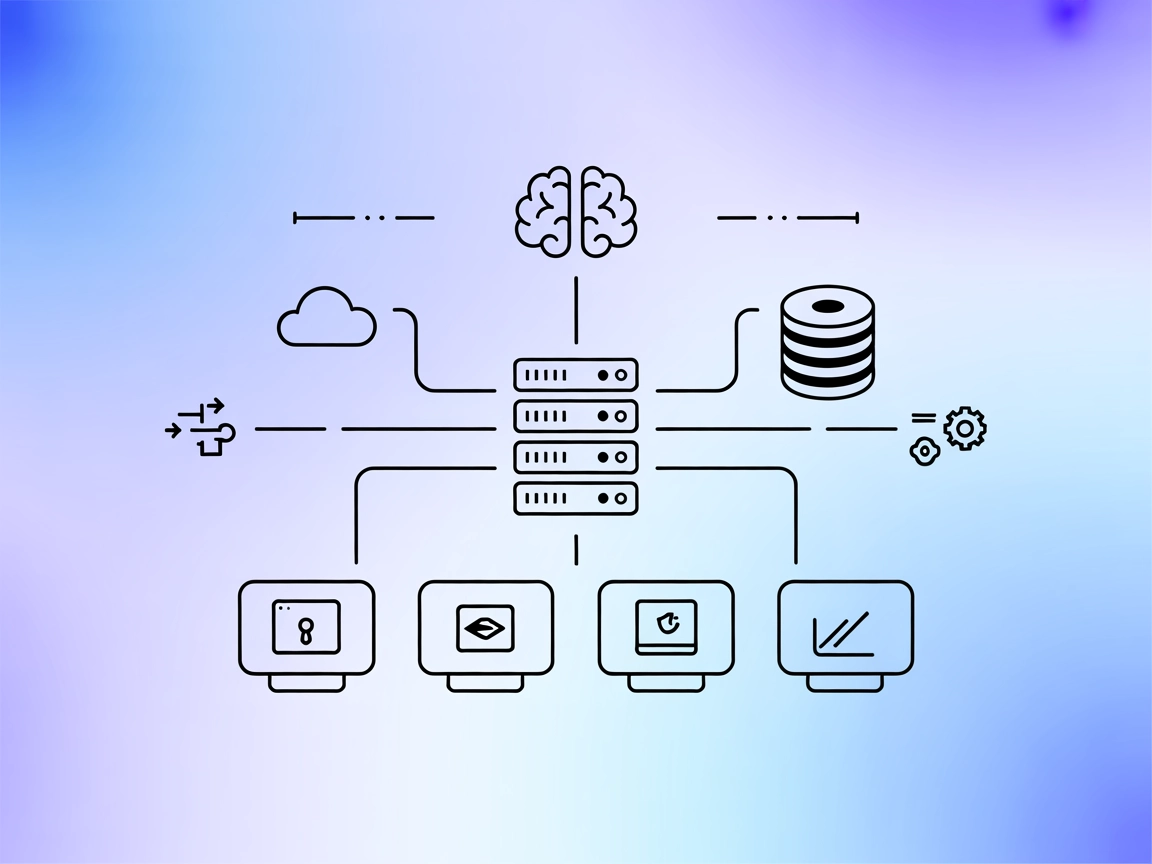

De Deepseek R1 MCP Server is een Model Context Protocol (MCP) serverimplementatie die is ontworpen om Claude Desktop te verbinden met DeepSeek’s geavanceerde taalmodellen, zoals Deepseek R1 en DeepSeek V3. Door als brug te fungeren tussen AI-assistenten en DeepSeek’s krachtige, redeneer-geoptimaliseerde modellen (met een contextvenster van 8192 tokens), stelt deze server AI-agenten in staat verbeterde natuurlijke taalbegrip- en generatieopdrachten uit te voeren. Ontwikkelaars kunnen de Deepseek R1 MCP Server inzetten om deze modellen naadloos te integreren in hun workflows, waardoor geavanceerde tekstgeneratie, redeneren en interactie met externe databronnen of API’s binnen ondersteunde platforms mogelijk worden. De implementatie is gericht op het bieden van een stabiele, betrouwbare en efficiënte integratie met behulp van Node.js/TypeScript voor optimale compatibiliteit en typeveiligheid.

Lijst van Prompts

Er zijn geen prompt templates gedocumenteerd in de repository.

Lijst van Resources

Er zijn geen expliciete MCP-resources gedocumenteerd in de repository.

Lijst van Tools

- Geavanceerde tekstgeneratie-tool

- Maakt het mogelijk voor LLM’s om tekst te genereren met Deepseek R1 (of V3), waarbij gebruik wordt gemaakt van het grote contextvenster en de redeneercapaciteiten van het model.

Toepassingen van deze MCP Server

- Geavanceerde Tekstgeneratie

Profiteer van DeepSeek R1’s grote contextvenster (8192 tokens) om lange en complexe uitkomsten te genereren voor documentatie, storytelling of technisch schrijven. - Verbeterde Redeneertaken

Maak gebruik van de geoptimaliseerde mogelijkheden van het Deepseek R1-model voor redeneerintensieve of meerstapsredenering, ideaal voor probleemoplossing en analyse. - Naadloze Claude Desktop-integratie

Integreer state-of-the-art taalmodellen direct in Claude Desktop-omgevingen, waardoor de mogelijkheden van de AI-assistent voor dagelijkse workflows worden uitgebreid. - Flexibele Modelselectie

Wissel tussen Deepseek R1 en DeepSeek V3 modellen door de configuratie aan te passen, zodat je kunt inspelen op verschillende projectvereisten. - API-gebaseerde automatisering

Maak AI-gedreven automatisering mogelijk in omgevingen waar DeepSeek’s API beschikbaar is, waardoor contentcreatie of kennisbeheer wordt gestroomlijnd.

Hoe stel je het in

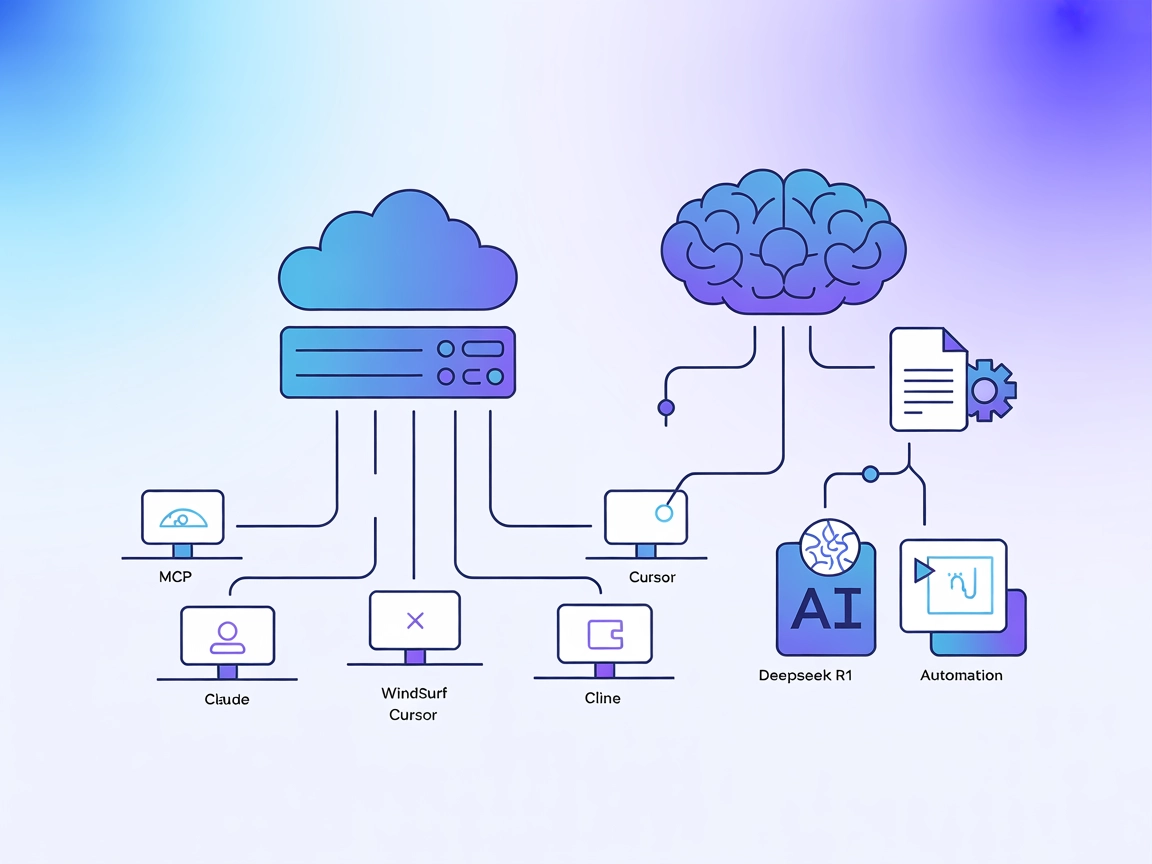

Windsurf

- Zorg dat Node.js (v18+) en npm geïnstalleerd zijn.

- Clone de repository en installeer afhankelijkheden:

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git cd deepseek-r1-mcp npm install - Kopieer

.env.exemplenaar.enven stel je DeepSeek API-sleutel in. - Bewerk de configuratie van Windsurf om de MCP-server toe te voegen:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Sla op, herstart Windsurf en controleer of de server draait.

Claude

- Installeer Node.js (v18+) en npm.

- Clone en stel de Deepseek R1 MCP Server in zoals hierboven.

- Voeg in de configuratie van Claude toe:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Herstart Claude en verifieer de beschikbaarheid van de MCP-server.

Cursor

- Installeer vereisten (Node.js, npm).

- Stel de server en omgevingsvariabelen in.

- Voeg de server toe aan de configuratie van Cursor:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Sla op, herstart Cursor en test de serverintegratie.

Cline

- Zorg dat Node.js en npm geïnstalleerd zijn.

- Clone en bouw de Deepseek R1 MCP Server.

- Voeg de server toe aan de configuratie van Cline:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Herstart Cline en bevestig dat de MCP-server is verbonden.

API-sleutels beveiligen

Gebruik omgevingsvariabelen in je configuratie om API-sleutels veilig te houden:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Hoe gebruik je deze MCP in flows

MCP gebruiken in FlowHunt

Om MCP-servers in je FlowHunt-workflow te integreren, voeg je het MCP-component toe aan je flow en verbind je deze met je AI-agent:

Klik op het MCP-component om het configuratievenster te openen. Voeg in de systeem-MCP-configuratie je MCP-servergegevens in met dit JSON-formaat:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu als tool gebruiken met toegang tot alle functies en mogelijkheden. Vergeet niet “deepseek_r1” te wijzigen naar de daadwerkelijke naam van je MCP-server en de URL te vervangen door je eigen MCP-server URL.

Overzicht

| Sectie | Beschikbaarheid | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | |

| Lijst van Prompts | ⛔ | Geen prompt templates gedocumenteerd |

| Lijst van Resources | ⛔ | Geen expliciete MCP-resources gedocumenteerd |

| Lijst van Tools | ✅ | Geavanceerde tekstgeneratie-tool |

| API-sleutels beveiligen | ✅ | Gebruik env-variabelen in configuratie |

| Sampling-ondersteuning (minder belangrijk) | ⛔ | Niet gedocumenteerd |

| Ondersteunt Roots | ⛔ | Niet gedocumenteerd |

Op basis van de beschikbare documentatie biedt de Deepseek R1 MCP Server een schone, gerichte implementatie die eenvoudig te configureren en te gebruiken is, maar ontbreekt het aan documentatie voor prompts, resources of geavanceerde MCP-functies zoals roots en sampling. Dit maakt hem zeer praktisch voor tekstgeneratie, maar minder rijk aan features voor complexe workflows.

MCP Score

| Heeft een LICENSE | ✅ (MIT) |

|---|---|

| Heeft minstens één tool | ✅ |

| Aantal Forks | 12 |

| Aantal Stars | 58 |

Veelgestelde vragen

- Wat is de Deepseek R1 MCP Server?

Het is een Model Context Protocol (MCP) server die fungeert als brug tussen Claude Desktop (of andere platforms) en DeepSeek’s geavanceerde taalmodellen (R1, V3), waarmee verbeterde tekstgeneratie, redeneren en automatisering in je AI-workflows mogelijk worden.

- Welke modellen worden ondersteund?

De server ondersteunt Deepseek R1 en DeepSeek V3—beide modellen zijn geoptimaliseerd voor grote contextvensters en complexe redeneertaken.

- Wat zijn de belangrijkste toepassingen?

Toepassingen zijn onder andere geavanceerde tekstgeneratie (langvormig, technisch of creatief), redeneerintensieve taken, naadloze AI-assistent-verbetering in Claude Desktop en het automatiseren van contentcreatie of kennisbeheer via API.

- Hoe beveilig ik mijn API-sleutels?

Gebruik altijd omgevingsvariabelen in je MCP-serverconfiguratie om onbedoelde blootstelling van je DeepSeek API-sleutel te voorkomen.

- Worden prompt templates of resources ondersteund?

Er zijn geen prompt templates of expliciete MCP-resources gedocumenteerd in de repository; de server is gericht op directe modeltoegang en integratie.

- Wat is de grootte van het contextvenster?

DeepSeek R1 biedt een contextvenster van 8192 tokens, waarmee lange en complexe taken kunnen worden verwerkt.

- Is het project open source?

Ja, het is MIT-gelicentieerd en beschikbaar op GitHub.

Geef je AI een boost met Deepseek R1

Ontgrendel geavanceerde tekstgeneratie en redeneren door FlowHunt of Claude Desktop te verbinden met DeepSeek R1’s krachtige modellen. Begin vandaag nog met het bouwen van slimmere workflows.