Deepseek Thinker MCP Server

Breng Deepseek’s transparante redenering en chain-of-thought AI-uitvoer naar je MCP-geschikte assistenten met ondersteuning voor zowel cloud- als lokale implementaties.

Wat doet de “Deepseek Thinker” MCP Server?

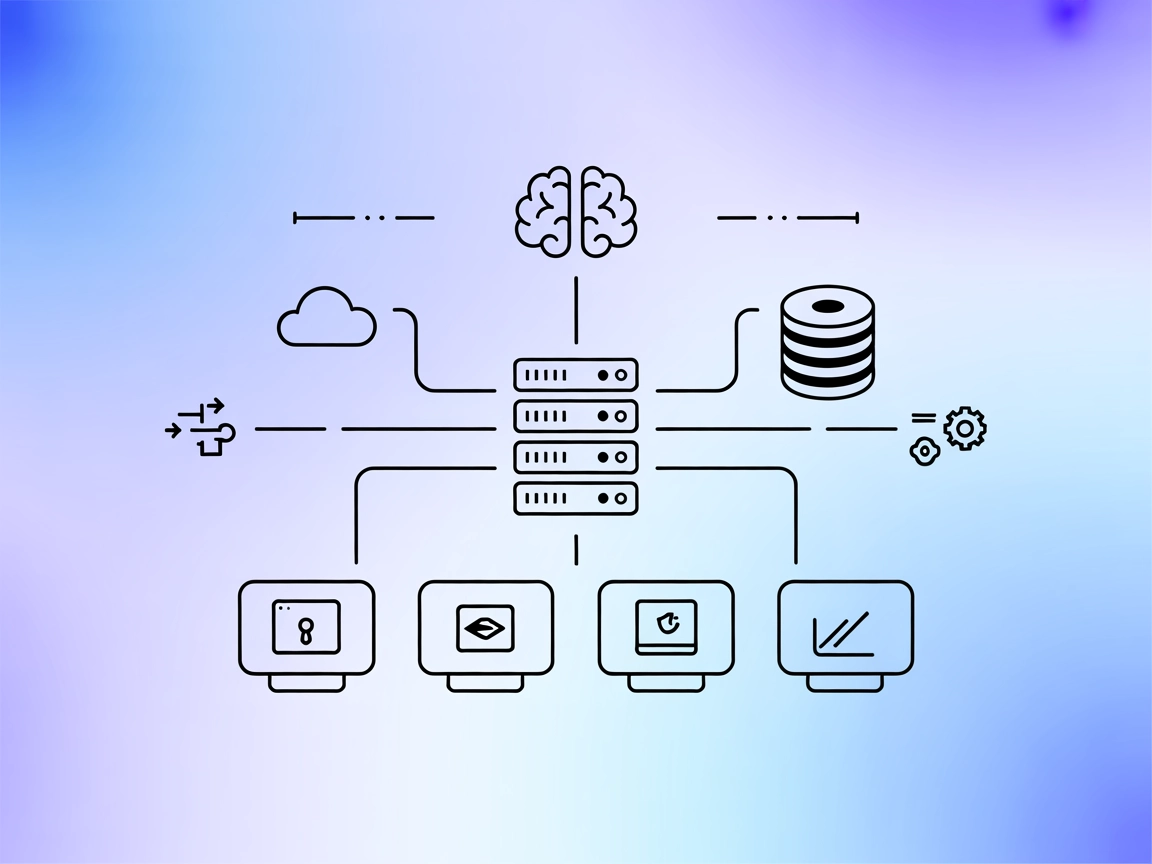

Deepseek Thinker MCP Server fungeert als een Model Context Protocol (MCP) provider en levert Deepseek-modelredenering aan MCP-geschikte AI-clients, zoals Claude Desktop. Het stelt AI-assistenten in staat toegang te krijgen tot Deepseek’s denkprocessen en redeneringsuitvoer, hetzij via de Deepseek API-dienst of vanaf een lokale Ollama-server. Door integratie met deze server kunnen ontwikkelaars hun AI-workflows verbeteren met gerichte redenering, waarbij gebruik kan worden gemaakt van zowel cloud- als lokale inferentiemogelijkheden. Deze server is vooral nuttig in scenario’s waarin gedetailleerde redeneringsketens of chain-of-thought (CoT)-uitvoer nodig zijn om downstream AI-taken te informeren, waardoor het waardevol is voor geavanceerde ontwikkeling, debugging en AI-agent verrijking.

Lijst van Prompts

Er worden geen expliciete prompt-templates vermeld in de repository of documentatie.

Lijst van Resources

Er worden geen expliciete MCP-resources beschreven in de documentatie of codebase.

Lijst van Tools

- get-deepseek-thinker

- Beschrijving: Voert redenering uit met behulp van het Deepseek-model.

- Inputparameter:

originPrompt(string) — De originele prompt van de gebruiker. - Retourneert: Gestructureerde tekstuitvoer met het redeneringsproces.

Gebruikstoepassingen van deze MCP Server

- AI Redenering Verbetering

- Maak gebruik van Deepseek’s gedetailleerde chain-of-thought-uitvoer om AI-clientantwoorden te verrijken en transparante redeneringsstappen te bieden.

- Integratie met Claude Desktop

- Naadloze aansluiting op Claude Desktop of vergelijkbare AI-platformen voor geavanceerde redeneringsmogelijkheden via MCP.

- Dubbele Inferentie Modi

- Kies tussen cloudgebaseerde (OpenAI API) of lokale (Ollama) modelinference, afhankelijk van privacy-, kosten- of latentievereisten.

- Ontwikkelaarsdebugging & Analyse

- Gebruik de server om modeldenken te onthullen en te analyseren voor onderzoek, debugging en interpretabiliteitsstudies.

- Flexibele Implementatie

- Gebruik de server lokaal of in cloudomgevingen, afgestemd op diverse workflowvereisten.

Hoe stel je het in

Windsurf

- Vereisten: Zorg dat Node.js en npx op je systeem geïnstalleerd zijn.

- Configuratiebestand: Zoek je Windsurf-configuratiebestand (bijv.

windsurf_config.json). - Voeg Deepseek Thinker MCP Server toe: Plaats het volgende JSON-fragment in het

mcpServers-object:{ "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } - Opslaan en herstarten: Sla de wijzigingen op en herstart Windsurf.

- Verifiëren: Controleer de MCP-serverintegratie in de Windsurf-client.

Claude

- Vereisten: Node.js en npx geïnstalleerd.

- Bewerk configuratie: Open

claude_desktop_config.json. - Voeg MCP Server toe:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Configuratie opslaan: Schrijf de wijzigingen weg en herstart Claude Desktop.

- Verifiëren: Bevestig dat Deepseek Thinker beschikbaar is in je MCP-tool lijst.

Cursor

- Controleer vereisten: Node.js en npx moeten geïnstalleerd zijn.

- Zoek Cursor-configuratie: Open je Cursor MCP-configuratiebestand.

- Voeg MCP Server-gegevens toe:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Opslaan & herstarten: Pas de wijzigingen toe en herstart Cursor.

- Controleer integratie: Valideer dat Deepseek Thinker operationeel is.

Cline

- Vereisten: Zorg ervoor dat Node.js en npx gereed zijn.

- Bewerk Cline-configuratie: Open het Cline-configuratiebestand.

- Voeg MCP Server-blok toe:

{ "mcpServers": { "deepseek-thinker": { "command": "npx", "args": [ "-y", "deepseek-thinker-mcp" ], "env": { "API_KEY": "<Your API Key>", "BASE_URL": "<Your Base URL>" } } } } - Opslaan en herstarten: Sla de configuratie op en herstart Cline.

- Verifieer functionaliteit: Controleer of de server vermeld staat en toegankelijk is.

Opmerking: API-sleutels beveiligen

Voor alle platforms moeten API-sleutels en gevoelige configuratiewaarden worden opgegeven met omgevingsvariabelen in de env-sectie. Bijvoorbeeld:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Voor lokale Ollama-modus, stel USE_OLLAMA in op "true" in het env-object:

"env": {

"USE_OLLAMA": "true"

}

Hoe gebruik je deze MCP in flows

MCP gebruiken in FlowHunt

Om MCP-servers in je FlowHunt-workflow te integreren, voeg je het MCP-component toe aan je flow en verbind je het met je AI-agent:

Klik op het MCP-component om het configuratiepaneel te openen. In de systeem-MCP-configuratiesectie voeg je je MCP-servergegevens toe in dit JSON-formaat:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu als tool gebruiken met toegang tot alle functies en mogelijkheden. Vergeet niet “deepseek-thinker” te wijzigen in de naam van jouw MCP-server en de juiste URL in te stellen.

Overzicht

| Sectie | Beschikbaarheid | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | |

| Lijst van Prompts | ⛔ | Geen prompt-templates gedocumenteerd |

| Lijst van Resources | ⛔ | Geen expliciete MCP-resources gevonden |

| Lijst van Tools | ✅ | get-deepseek-thinker tool |

| API-sleutels beveiligen | ✅ | Omgevingsvariabelen in configuratie |

| Sampling Support (minder belangrijk bij beoordeling) | ⛔ | Niet vermeld |

Op basis van de onderstaande twee tabellen biedt Deepseek Thinker MCP Server een gerichte tool voor redeneringsintegratie, is eenvoudig op te zetten, maar mist gedetailleerde prompt-templates en expliciete resource-definities. Het project is open source, heeft een bescheiden aanhang en ondersteunt veilige credential-afhandeling. Het scoort een 6/10 voor algehele volledigheid en bruikbaarheid als MCP-server.

MCP Score

| Heeft een LICENSE | ⛔ (Geen LICENSE-bestand gedetecteerd) |

|---|---|

| Heeft minimaal één tool | ✅ |

| Aantal Forks | 12 |

| Aantal Sterren | 51 |

Veelgestelde vragen

- Wat is Deepseek Thinker MCP Server?

Het is een Model Context Protocol-server die Deepseek-modelredenering naar MCP-geschikte AI-clients brengt, en chain-of-thought-uitvoer en transparant modeldenken biedt voor geavanceerde AI-workflows en debugging.

- Welke tools biedt Deepseek Thinker MCP Server?

Het biedt de 'get-deepseek-thinker' tool om redeneringen uit te voeren met het Deepseek-model en gestructureerde redeneringsuitvoer te retourneren.

- Kan ik Deepseek Thinker gebruiken met lokale AI-modellen?

Ja, Deepseek Thinker ondersteunt zowel cloudgebaseerde als lokale (Ollama) inferentie. Stel de 'USE_OLLAMA' omgevingsvariabele in op 'true' voor lokale modus.

- Hoe lever ik API-sleutels veilig aan?

API-sleutels en gevoelige waarden moeten worden opgeslagen in de 'env'-sectie van je MCP-serverconfiguratie als omgevingsvariabelen, en niet hardcoded in bronbestanden.

- Wat gebeurt er als ik mijn geheugen- of tokenlimieten overschrijd?

Limieten worden bepaald door het onderliggende Deepseek-model of de API; overschrijding kan leiden tot afgekorte antwoorden of fouten, pas daarom je configuratie en invoer dienovereenkomstig aan.

- Zijn er prompt-templates of extra MCP-resources?

Er worden geen expliciete prompt-templates of extra MCP-resources meegeleverd als onderdeel van de huidige Deepseek Thinker MCP Server-documentatie.

Versterk je AI met Deepseek-redenering

Integreer Deepseek Thinker MCP Server om je AI-agenten gedetailleerde redeneringsmogelijkheden te geven en ontwikkelingsworkflows te versnellen.