Langflow-DOC-QA-SERVER MCP Server

Langflow-DOC-QA-SERVER brengt krachtige document-Q&A naar je AI-stack, waardoor naadloze integratie van zoekopdrachten, ondersteuningsautomatisering en kennisextractie mogelijk wordt voor verhoogde productiviteit.

Wat doet de “Langflow-DOC-QA-SERVER” MCP Server?

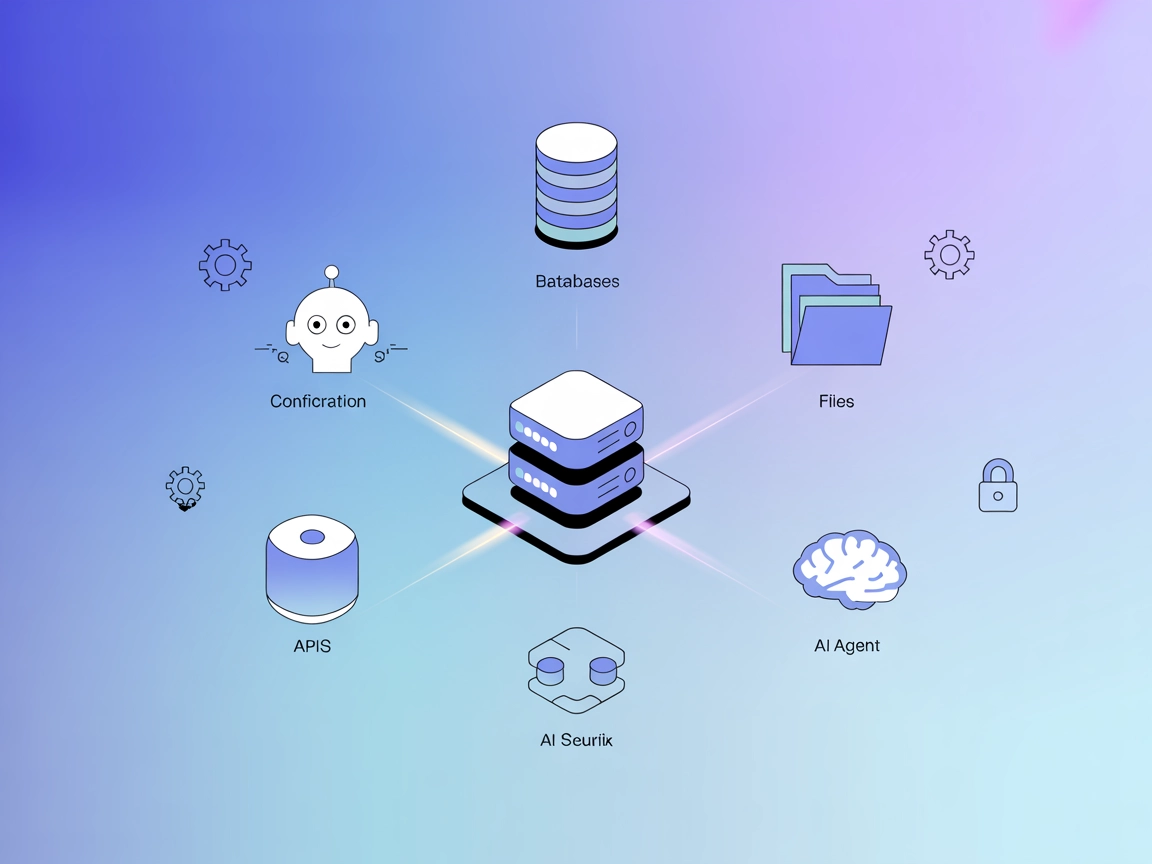

Langflow-DOC-QA-SERVER is een Model Context Protocol (MCP) server ontworpen voor documentvraag-en-antwoord (Q&A)-taken, aangedreven door Langflow. Het fungeert als brug tussen AI-assistenten en een Langflow-backend, waardoor gebruikers documenten op een gestroomlijnde manier kunnen bevragen. Door gebruik te maken van MCP stelt deze server document-Q&A-mogelijkheden beschikbaar als tools en resources die toegankelijk zijn voor AI-clients, waardoor geavanceerde ontwikkelworkflows mogelijk worden. Ontwikkelaars kunnen documentopvraging, vraagbeantwoording en interactie met grote taalmodellen (LLM’s) integreren in hun applicaties, waardoor het eenvoudiger wordt om de productiviteit te verhogen bij taken zoals documentatiezoekopdrachten, ondersteuningsautomatisering en informatie-extractie.

Lijst van prompts

Er worden geen prompttemplates gedocumenteerd in de repository of README.

Lijst van resources

Er worden geen specifieke resources gedocumenteerd of vermeld in de repository of README.

Lijst van tools

Er worden geen expliciete tools vermeld in een server.py of een gelijkwaardig serverbestand in de beschikbare documentatie of bestandslijst.

Toepassingsgebieden van deze MCP-server

- Documentzoekopdracht en Q&A

Integreer zoeken in natuurlijke taal over documenten voor directe antwoorden en verbeterde toegang tot organisatiekennis. - Geautomatiseerde supportbots

Gebruik de server als backend voor bots die gebruikersvragen beantwoorden op basis van geüploade of geïndexeerde documentatie. - Kennisbeheer

Maak het voor teams mogelijk om informatie uit grote collecties documenten te halen en de productiviteit te verhogen. - Workflowautomatisering

Automatiseer repetitieve onderzoeks- of informatieopvragingstaken door document-Q&A-mogelijkheden in workflows te embedden.

Hoe stel je het in

Windsurf

- Zorg dat vereisten geïnstalleerd zijn (bijv. Node.js, Langflow-backend).

- Open je Windsurf-configuratiebestand.

- Voeg de Langflow-DOC-QA-SERVER MCP-server toe met het volgende JSON-fragment:

{ "mcpServers": { "langflow-doc-qa": { "command": "npx", "args": ["@GongRzhe/Langflow-DOC-QA-SERVER@latest"] } } } - Sla de configuratie op en herstart Windsurf.

- Controleer of de server draait en toegankelijk is.

API-sleutels beveiligen

Gebruik omgevingsvariabelen om API-sleutels te beveiligen:

{

"mcpServers": {

"langflow-doc-qa": {

"command": "npx",

"args": ["@GongRzhe/Langflow-DOC-QA-SERVER@latest"],

"env": {

"API_KEY": "${API_KEY}"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

Claude

- Installeer de vereiste afhankelijkheden.

- Zoek het Claude-configuratiebestand.

- Voeg de MCP-serverconfiguratie toe zoals hierboven getoond.

- Herstart Claude.

- Bevestig de connectiviteit met de Langflow-DOC-QA-SERVER.

Cursor

- Bereid de Langflow-backend voor en installeer Node.js indien nodig.

- Bewerk de Cursor-configuratie.

- Voeg de MCP-serverconfiguratie in JSON toe.

- Sla wijzigingen op en herstart Cursor.

- Test de serverintegratie.

Cline

- Zorg dat alle vereisten zijn vervuld.

- Werk het Cline-configuratiebestand bij.

- Voeg de MCP-server JSON-configuratie toe.

- Herstart Cline om de wijzigingen toe te passen.

- Valideer de integratie.

Hoe gebruik je deze MCP in flows

MCP gebruiken in FlowHunt

Om MCP-servers in je FlowHunt-workflow te integreren, begin je met het toevoegen van het MCP-component aan je flow en deze te verbinden met je AI-agent:

Klik op het MCP-component om het configuratiescherm te openen. Voeg in de systeem-MCP-configuratiesectie je MCP-servergegevens toe met dit JSON-formaat:

{

"langflow-doc-qa": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu gebruiken als tool met toegang tot al zijn functies en mogelijkheden. Vergeet niet “langflow-doc-qa” te vervangen door de daadwerkelijke naam van je MCP-server en de URL door je eigen MCP-server-URL.

Overzicht

| Sectie | Beschikbaarheid | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | Aanwezig in README |

| Lijst van prompts | ⛔ | Niet gedocumenteerd |

| Lijst van resources | ⛔ | Niet gedocumenteerd |

| Lijst van tools | ⛔ | Niet gedocumenteerd |

| API-sleutels beveiligen | ✅ | Te zien in setupexample |

| Steun voor sampling (minder belangrijk) | ⛔ | Niet gedocumenteerd |

Onze mening

De Langflow-DOC-QA-SERVER MCP is een minimale, demonstratiegerichte server die duidelijk zijn doel en installatie uitlegt maar geen documentatie heeft over prompttemplates, resources en tools. De installatie-instructies zijn generiek en gebaseerd op standaard MCP-conventies. Dit beperkt het gebruiksgemak direct uit de doos, maar maakt het wel een helder voorbeeld voor basisintegratie.

MCP-score

| Heeft een LICENSE | ✅ (MIT) |

|---|---|

| Minstens één tool | ⛔ |

| Aantal forks | 7 |

| Aantal sterren | 11 |

Beoordeling: 4/10 — Het project is goed afgebakend en open source, maar mist rijke documentatie en details over MCP-specifieke functies, resources en tools.

Veelgestelde vragen

- Wat is Langflow-DOC-QA-SERVER?

Langflow-DOC-QA-SERVER is een Model Context Protocol (MCP) server ontworpen voor documentvraag-en-antwoord-taken en fungeert als brug tussen AI-assistenten en een Langflow-backend voor geavanceerde documentquery's.

- Wat zijn de belangrijkste toepassingsgebieden voor deze MCP-server?

Het maakt documentzoekopdrachten en Q&A mogelijk, voedt geautomatiseerde supportbots, ondersteunt kennisbeheer voor teams en maakt workflowautomatisering mogelijk door document-Q&A in bedrijfsprocessen te integreren.

- Hoe stel ik Langflow-DOC-QA-SERVER in met FlowHunt?

Voeg de MCP-serverconfiguratie toe aan je workflow zoals beschreven in de installatie-instructies, zorg dat vereiste afhankelijkheden (zoals Node.js en een Langflow-backend) aanwezig zijn. Beveilig API-sleutels met behulp van omgevingsvariabelen.

- Bevat Langflow-DOC-QA-SERVER prompttemplates, resources of tools?

Nee. De server is gericht op demonstratie en documenteert momenteel geen specifieke prompttemplates, resources of tools.

- Is Langflow-DOC-QA-SERVER open source?

Ja, het is open source onder de MIT-licentie.

Aan de slag met Langflow-DOC-QA-SERVER

Integreer Langflow-DOC-QA-SERVER in je FlowHunt-workflows voor geavanceerde document-Q&A en kennisbeheer. Ontgrendel directe toegang tot organisatiekennis en automatiseer support.