Langfuse MCP Server-integratie

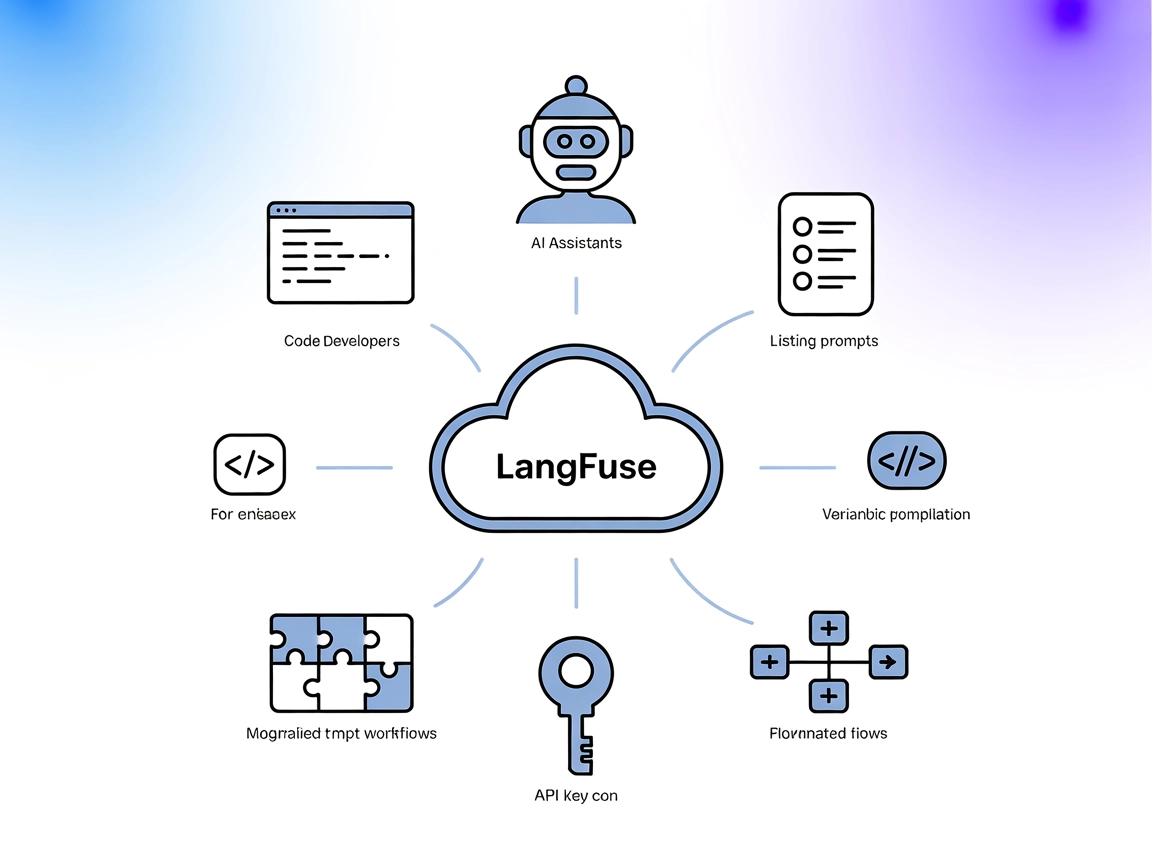

Integreer de Langfuse MCP Server met FlowHunt om AI-prompts centraal te beheren, op te halen en te compileren vanuit Langfuse, en zo dynamische en gestandaardiseerde LLM-workflows te ondersteunen.

Wat doet de “Langfuse” MCP Server?

De Langfuse MCP Server is een Model Context Protocol (MCP) server, ontworpen voor Langfuse Prompt Management. Hiermee kunnen AI-assistenten en ontwikkelaars prompts die in Langfuse zijn opgeslagen benaderen en beheren via de gestandaardiseerde MCP-interface. Door AI-clients via MCP aan externe promptrepositories te koppelen, wordt het ophalen, weergeven en compileren van prompts gestroomlijnd, wat de ontwikkelworkflow voor large language models (LLM’s) verbetert. De Langfuse MCP Server ondersteunt promptontdekking, -ophaling en -compilatie, waardoor taken mogelijk zijn zoals dynamische promptselectie en variabelvervanging. Door deze integratie wordt promptbeheer vereenvoudigd en worden interacties tussen LLM’s en promptdatabases gestandaardiseerd, wat vooral nuttig is in omgevingen waar consistente promptgebruik en -deling vereist zijn tussen teams of platformen.

Overzicht van Prompts

prompts/list: Toont alle beschikbare prompts in de Langfuse-repository. Ondersteunt optionele cursor-gebaseerde paginering en levert promptnamen met hun benodigde argumenten. Alle argumenten worden als optioneel beschouwd.prompts/get: Haalt een specifieke prompt op naam op en compileert deze met opgegeven variabelen. Ondersteunt zowel tekst- als chatprompts en zet ze om in MCP-promptobjecten.

Overzicht van Resources

- Langfuse Prompts Resource: Laat alle prompts met het label

productionin Langfuse zien voor ontdekking en ophaling door AI-clients. - Promptargumenten Resource: Geeft informatie over promptvariabelen terug (alle optioneel; geen gedetailleerde beschrijvingen vanwege beperkingen in de Langfuse-specificatie).

- Gepagineerde Prompts Resource: Ondersteunt het tonen van prompts met paginering voor efficiënte toegang in grote repositories.

Overzicht van Tools

get-prompts: Toont beschikbare prompts met hun argumenten. Ondersteunt optionelecursor-parameter voor paginering en geeft een lijst met promptnamen en argumenten terug.get-prompt: Haalt en compileert een specifieke prompt op. Vereist eenname-parameter en optioneel een JSON-object met variabelen voor het invullen van de prompt.

Use-cases van deze MCP Server

- Gecentraliseerd Promptbeheer: Versnel promptupdates en -deling tussen teams door alle prompts in Langfuse te beheren en ze via MCP aan diverse AI-clients aan te bieden.

- Gestandaardiseerde Promptophaling: Zorg voor consistent promptgebruik in LLM-workflows door met MCP gevalideerde, productieklare prompts op afroep op te halen.

- Dynamische Promptcompilatie: Sta LLM’s of AI-agents toe prompts te compileren met runtime-variabelen, voor flexibele en dynamische interacties.

- Promptontdekking in Apps: Maak promptselectie-interfaces mogelijk in ontwikkeltools of AI-assistenten door beschikbare prompts en hun parameters te tonen.

- Integratie met LLMOps-workflows: Koppel Langfuse promptrepositories aan LLMOps-platforms en agentframeworks via het MCP-protocol voor beter promptbeheer en auditing.

Hoe stel je het in

Windsurf

Geen specifieke instructies voor Windsurf gevonden in de repository.

Claude

- Zorg ervoor dat Node.js en npm geïnstalleerd zijn.

- Bouw de server met:

npm install npm run build - Bewerk je

claude_desktop_config.jsonom de MCP-server toe te voegen:{ "mcpServers": { "langfuse": { "command": "node", "args": ["<absolute-path>/build/index.js"], "env": { "LANGFUSE_PUBLIC_KEY": "jouw-public-key", "LANGFUSE_SECRET_KEY": "jouw-secret-key", "LANGFUSE_BASEURL": "https://cloud.langfuse.com" } } } } - Vervang de omgevingsvariabelen door je eigen Langfuse API-sleutels.

- Sla de configuratie op en herstart Claude Desktop.

- Controleer of de server zichtbaar is in de Claude Desktop MCP-interface.

Cursor

- Zorg ervoor dat Node.js en npm geïnstalleerd zijn.

- Bouw de server:

npm install npm run build - Voeg in Cursor een nieuwe MCP-server toe met:

- Naam: Langfuse Prompts

- Type: command

- Commando:

LANGFUSE_PUBLIC_KEY="jouw-public-key" LANGFUSE_SECRET_KEY="jouw-secret-key" LANGFUSE_BASEURL="https://cloud.langfuse.com" node absolute-path/build/index.js

- Vervang de omgevingsvariabelen door je eigen Langfuse API-sleutels.

- Sla op en controleer de serververbinding.

Cline

Geen specifieke instructies voor Cline gevonden in de repository.

API-sleutels beveiligen

Het wordt aanbevolen je API-sleutels te beveiligen met omgevingsvariabelen. Hier is een voorbeeld van een JSON-fragment voor MCP-serverconfiguratie:

{

"mcpServers": {

"langfuse": {

"command": "node",

"args": ["<absolute-path>/build/index.js"],

"env": {

"LANGFUSE_PUBLIC_KEY": "jouw-public-key",

"LANGFUSE_SECRET_KEY": "jouw-secret-key",

"LANGFUSE_BASEURL": "https://cloud.langfuse.com"

}

}

}

}

Vervang de waarden door je eigen API-gegevens.

Hoe gebruik je deze MCP in flows

MCP gebruiken in FlowHunt

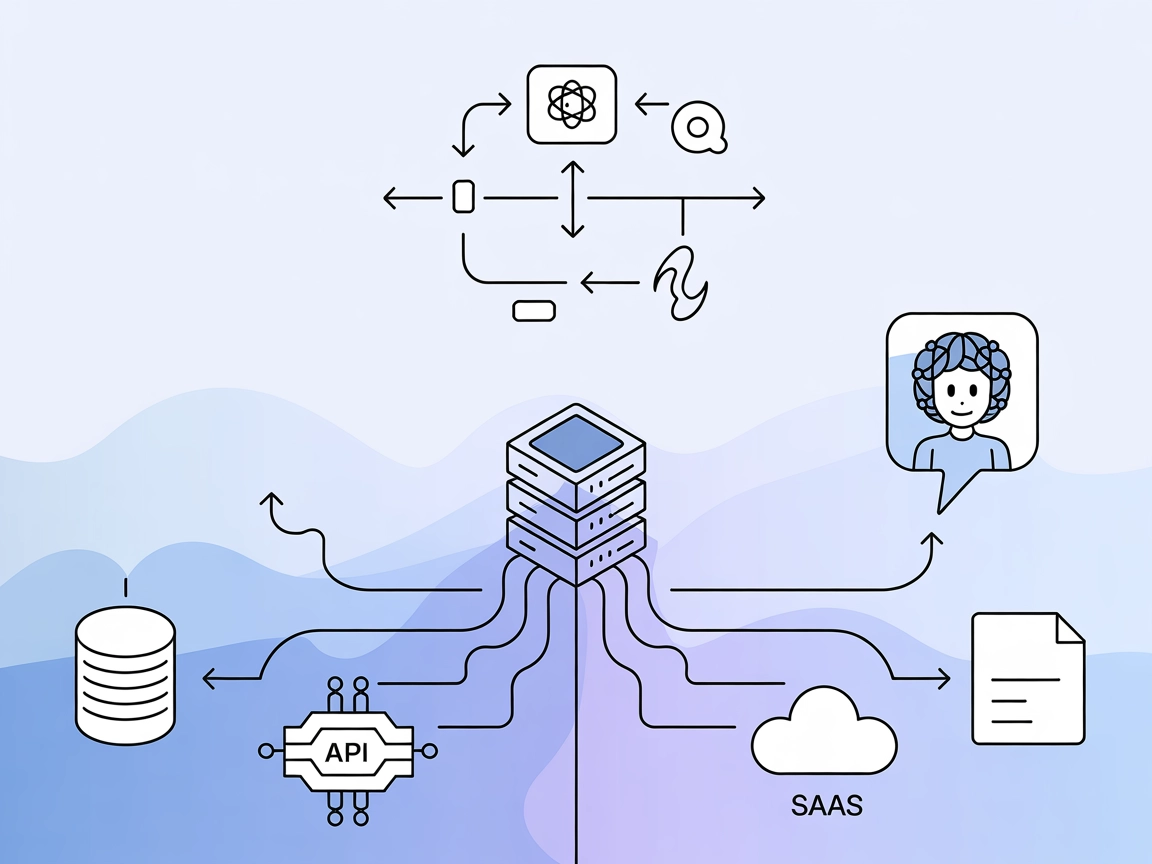

Om MCP-servers te integreren in je FlowHunt-workflow, voeg je het MCP-component toe aan je flow en verbind je deze met je AI-agent:

Klik op het MCP-component om het configuratievenster te openen. In het systeem-MCP-configuratiegedeelte voeg je de details van je MCP-server in met dit JSON-formaat:

{

"langfuse": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu als tool gebruiken met toegang tot alle functies en mogelijkheden. Vergeet niet "langfuse" te vervangen door de daadwerkelijke naam van je MCP-server en de URL aan te passen naar je eigen MCP-server-URL.

Overzicht

| Sectie | Beschikbaar | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | Langfuse MCP voor promptbeheer |

| Overzicht van Prompts | ✅ | prompts/list, prompts/get |

| Overzicht van Resources | ✅ | Promptlijst, promptvariabelen, gepagineerde resources |

| Overzicht van Tools | ✅ | get-prompts, get-prompt |

| API-sleutels beveiligen | ✅ | Via omgevingsvariabelen in MCP-configuratie |

| Sampling-ondersteuning (minder belangrijk) | ⛔ | Niet genoemd |

Op basis van de beschikbare secties en functies is de Langfuse MCP Server goed gedocumenteerd en dekt het de meeste essentiële MCP-capaciteiten, vooral op het gebied van promptbeheer. Het ontbreken van expliciete sampling- of roots-ondersteuning beperkt de uitbreidbaarheid enigszins. Over het algemeen is het een sterke implementatie voor het focusgebied.

MCP-score

| Heeft een LICENSE | ✅ (MIT) |

|---|---|

| Heeft minimaal één tool | ✅ |

| Aantal forks | 22 |

| Aantal sterren | 98 |

Veelgestelde vragen

- Wat is de Langfuse MCP Server?

De Langfuse MCP Server is een Model Context Protocol-server die AI-clients zoals FlowHunt verbindt met het Langfuse promptbeheerplatform. Het maakt promptontdekking, -ophaling en dynamische compilatie mogelijk, waardoor promptworkflows voor LLM's en agents worden gestroomlijnd.

- Welke functies ondersteunt de Langfuse MCP Server?

Het ondersteunt het opvragen van alle beschikbare prompts, ophalen en compileren van prompts met variabelen, gepagineerde promptontdekking en het tonen van promptargumenten. Alle argumenten worden als optioneel beschouwd en de server is ontworpen voor productiepromptbeheer in LLMOps-scenario's.

- Hoe beveilig ik mijn Langfuse API-sleutels?

Je dient API-sleutels als omgevingsvariabelen op te slaan in je MCP-serverconfiguratie om ze veilig te houden. Zie de meegeleverde configuratievoorbeelden voor details over het instellen van omgevingsvariabelen.

- Kan ik de Langfuse MCP Server gebruiken in FlowHunt-workflows?

Ja! Voeg het MCP-component toe in je FlowHunt-flow, configureer deze naar je Langfuse MCP-server, en je agents kunnen dynamisch prompts uit Langfuse ophalen, ontdekken en compileren.

- Wat zijn veelvoorkomende use-cases voor deze integratie?

Gecentraliseerd promptbeheer, gestandaardiseerde ophaling voor LLM-workflows, dynamische promptcompilatie met runtime-variabelen, het aandrijven van promptselectie-interfaces en integratie met LLMOps-tools voor betere governance en auditing.

Verbind FlowHunt met Langfuse Promptbeheer

Centraliseer en standaardiseer je AI-promptworkflows door de Langfuse MCP Server te integreren met FlowHunt. Ontgrendel efficiënte promptontdekking, -ophaling en dynamische compilatie voor geavanceerde LLM-operaties.