Pinecone MCP Server-integratie

Verbind FlowHunt met Pinecone voor geavanceerd semantisch zoeken, vectorgegevensbeheer en RAG-aangedreven AI-toepassingen.

Wat doet de “Pinecone” MCP Server?

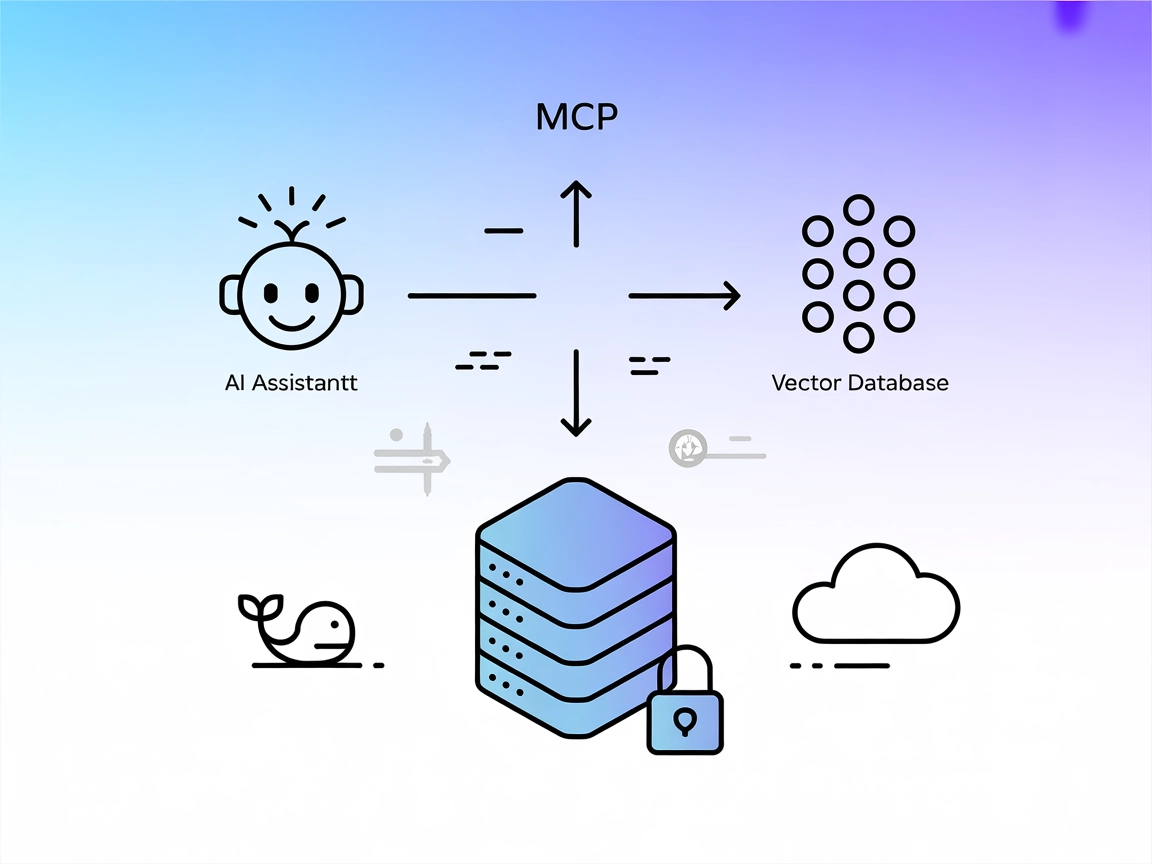

De Pinecone MCP (Model Context Protocol) Server is een gespecialiseerd hulpmiddel dat AI-assistenten verbindt met Pinecone vector-databases, waardoor naadloos lezen en schrijven van data mogelijk is voor verbeterde ontwikkelworkflows. Door als tussenpersoon te fungeren, stelt de Pinecone MCP Server AI-clients in staat taken uit te voeren zoals semantisch zoeken, documenten ophalen en databasebeheer binnen een Pinecone-index. Hij ondersteunt bewerkingen zoals het zoeken naar vergelijkbare records, het beheren van documenten en het upserten van nieuwe embeddings. Deze mogelijkheid is vooral waardevol voor toepassingen met Retrieval-Augmented Generation (RAG), omdat het de integratie van contextuele data in AI-workflows stroomlijnt en complexe data-interacties automatiseert.

Lijst van Prompts

Geen expliciete prompt-sjablonen worden genoemd in de repository.

Lijst van Resources

- Pinecone Index: De primaire resource, waarmee je data kunt lezen en schrijven.

- Document-resource: Vertegenwoordigt documenten die in de Pinecone-index zijn opgeslagen en gelezen of opgesomd kunnen worden.

- Record-resource: Individuele records binnen de Pinecone-index die doorzocht of geüpsert kunnen worden.

- Pinecone Stats-resource: Stelt statistieken van de Pinecone-index bloot, zoals het aantal records, dimensies en namespaces.

Lijst van Tools

- semantic-search: Zoekt naar records in de Pinecone-index met behulp van semantische overeenkomst.

- read-document: Leest een specifiek document uit de Pinecone-index.

- list-documents: Geeft een overzicht van alle documenten die momenteel in de Pinecone-index zijn opgeslagen.

- pinecone-stats: Haalt statistieken op over de Pinecone-index, waaronder het aantal records, hun dimensies en namespaces.

- process-document: Verwerkt een document in stukken, genereert embeddings en upsert deze in de Pinecone-index.

Gebruikssituaties van deze MCP Server

- Databasebeheer: Efficiënt lezen, schrijven en beheren van vectordata binnen een Pinecone-index, ter ondersteuning van grootschalige AI-toepassingen.

- Semantisch zoeken: AI-assistenten laten zoeken naar relevante matches in opgeslagen documenten op basis van vectorovereenkomst.

- Retrieval-Augmented Generation (RAG): Externe kennis integreren in LLM-workflows door relevante context uit de Pinecone-index te halen voor AI-antwoorden.

- Document chunking en embedding: Documenten automatisch opdelen, embeddings genereren en deze toevoegen aan Pinecone, waardoor het zoek- en retrievalproces wordt gestroomlijnd.

- Index monitoring en statistieken: Real-time inzicht krijgen in de status en prestaties van de Pinecone-index, wat helpt bij optimalisatie en troubleshooting.

Hoe stel je het in

Windsurf

- Zorg dat je Python en Node.js hebt geïnstalleerd.

- Zoek je Windsurf-configuratiebestand op.

- Voeg de Pinecone MCP Server toe met het volgende JSON-fragment:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Sla het configuratiebestand op en herstart Windsurf.

- Controleer of de Pinecone MCP Server-tools zichtbaar zijn in de interface.

API-sleutels beveiligen met omgevingsvariabelen:

{

"mcpServers": {

"pinecone-mcp": {

"command": "mcp-pinecone",

"env": {

"PINECONE_API_KEY": "your_api_key"

},

"inputs": {

"index_name": "your_index"

}

}

}

}

Claude

- Installeer de Pinecone MCP Server met Python (bijv.

pip install mcp-pinecone). - Bewerk je Claude-configuratie om de server toe te voegen:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Sla de configuratie op en herstart Claude.

- Bevestig dat de server draait en toegankelijk is als tool.

Cursor

- Zorg ervoor dat Python en mcp-pinecone geïnstalleerd zijn.

- Ga naar je Cursor-configuratiebestand.

- Voeg de volgende MCP-server toe:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Sla de wijzigingen op en herstart Cursor.

- Controleer in de tool-lijst op Pinecone-operaties.

Cline

- Controleer of Python en mcp-pinecone zijn geïnstalleerd.

- Open het configuratiebestand van Cline.

- Voeg de Pinecone MCP Server toe met:

{ "mcpServers": { "pinecone-mcp": { "command": "mcp-pinecone", "args": [] } } } - Sla op en herstart Cline.

- Controleer of je toegang hebt tot Pinecone-tools.

Let op: Beveilig altijd API-sleutels en gevoelige waarden met omgevingsvariabelen zoals hierboven getoond.

Hoe gebruik je deze MCP binnen flows

MCP gebruiken in FlowHunt

Om MCP-servers te integreren in je FlowHunt-workflow, voeg je het MCP-component toe aan je flow en verbind je deze met je AI-agent:

Klik op het MCP-component om het configuratiepaneel te openen. Voeg in de systeem MCP-configuratiesectie de gegevens van je MCP-server toe met dit JSON-formaat:

{

"pinecone-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu gebruiken als tool met toegang tot alle functies en mogelijkheden. Vergeet niet “pinecone-mcp” aan te passen naar de daadwerkelijke naam van jouw MCP-server en de URL te vervangen door jouw eigen MCP-server-URL.

Overzicht

| Sectie | Beschikbaarheid | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | Beschrijft Pinecone MCP’s integratie met vector-DB |

| Lijst van Prompts | ⛔ | Geen expliciete prompt-sjablonen gevonden |

| Lijst van Resources | ✅ | Pinecone-index, documenten, records, statistieken |

| Lijst van Tools | ✅ | semantic-search, read-document, list-documents, pinecone-stats, process-document |

| API-sleutels beveiligen | ✅ | Voorbeeld gegeven met omgevingsvariabelen in configuratie |

| Sampling Support (minder belangrijk bij evaluatie) | ⛔ | Geen vermelding of bewijs gevonden |

Onze mening

De Pinecone MCP Server is goed gedocumenteerd, biedt duidelijke resources en tools, en bevat solide instructies voor integratie en API-sleutelbeveiliging. Er ontbreken echter expliciete prompt-sjablonen en documentatie over sampling of roots-ondersteuning. Over het algemeen is het een praktische en waardevolle server voor RAG- en Pinecone-workflows, al zou het verbeteren met meer workflowvoorbeelden en geavanceerde functies.

Beoordeling: 8/10

MCP Score

| Heeft een LICENSE | ✅ (MIT) |

|---|---|

| Heeft minstens één tool | ✅ |

| Aantal Forks | 25 |

| Aantal Sterren | 124 |

Veelgestelde vragen

- Wat is de Pinecone MCP Server?

De Pinecone MCP Server verbindt AI-assistenten met Pinecone vector-databases, waardoor semantisch zoeken, documentbeheer en embedding-workflows mogelijk worden binnen AI-toepassingen zoals FlowHunt.

- Welke tools biedt de Pinecone MCP Server?

Het biedt tools voor semantisch zoeken, het lezen en opsommen van documenten, het ophalen van indexstatistieken en het verwerken van documenten naar embeddings om deze in de Pinecone-index te plaatsen.

- Hoe ondersteunt Pinecone MCP Retrieval-Augmented Generation (RAG)?

De server stelt AI-agents in staat relevante context op te halen uit Pinecone, waardoor LLM's antwoorden kunnen genereren die gebaseerd zijn op externe kennisbronnen.

- Hoe maak ik veilig verbinding met een Pinecone-index?

Bewaar je Pinecone API-sleutel en indexnaam als omgevingsvariabelen in je configuratiebestand, zoals uitgelegd in de integratie-instructies, om je gegevens veilig te houden.

- Wat zijn typische use cases voor de Pinecone MCP Server?

Veelvoorkomende toepassingen zijn semantisch zoeken in grote documentcollecties, RAG-pijplijnen, geautomatiseerde document-chunking en embedding, en het monitoren van Pinecone-indexstatistieken.

Geef je AI-workflows een boost met Pinecone

Schakel semantisch zoeken en Retrieval-Augmented Generation in FlowHunt in door je AI-agents te verbinden met Pinecone vector-databases.