Opis komponentu

Jak działa komponent LLM Anthropic AI

Różne zadania wymagają różnych modeli, a FlowHunt zobowiązuje się dostarczać Ci to, co najlepsze w AI, bez konieczności wykupywania wielu subskrypcji. Zamiast tego otrzymujesz dziesiątki modeli generujących tekst oraz obrazy na jednym panelu. Komponenty typu LLM grupują modele generujące tekst według dostawcy, pozwalając na szybką zamianę modeli AI w dowolnym momencie — idealne do zastosowań w AI, tworzeniu treści i automatyzacji.

Czym jest komponent LLM Anthropic AI?

Komponent LLM Anthropic AI łączy rodzinę modeli Claude z Twoim przepływem. Chociaż to Generatory i Agenci są miejscem, gdzie dzieje się cała magia, komponenty LLM pozwalają wybrać, jaki model będzie użyty. Wszystkie komponenty domyślnie korzystają z ChatGPT-4. Możesz podłączyć ten komponent, jeśli chcesz zmienić model lub uzyskać większą kontrolę nad jego działaniem.

Pamiętaj, że podłączenie komponentu LLM jest opcjonalne. Wszystkie komponenty używające LLM mają domyślnie ChatGPT-4o. Komponenty LLM umożliwiają zmianę modelu i kontrolę ustawień modelu.

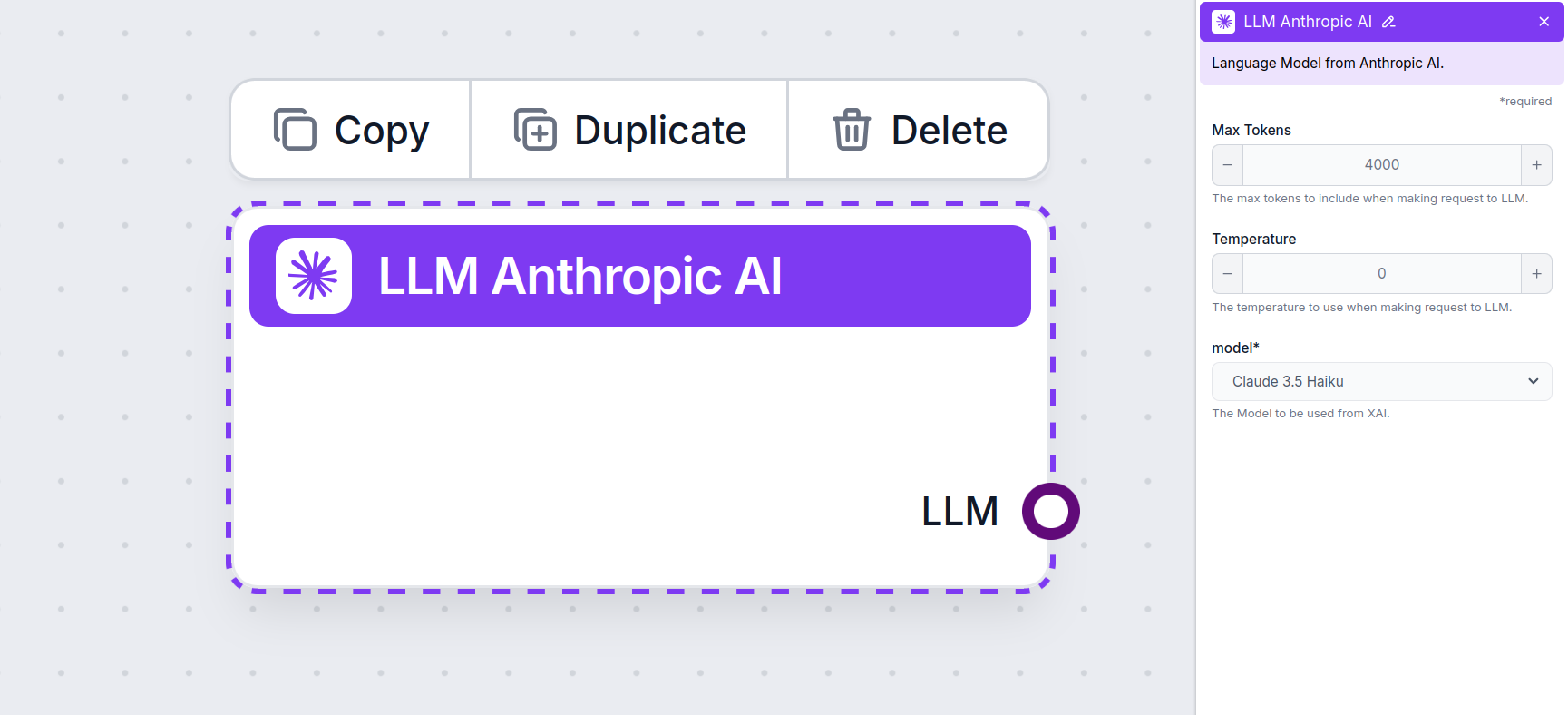

Ustawienia komponentu LLM Anthropic AI

Maksymalna liczba tokenów

Tokeny to pojedyncze jednostki tekstu, które model przetwarza i generuje. Liczba zużywanych tokenów zależy od modelu, a jeden token może oznaczać słowo, fragment słowa lub pojedynczy znak. Modele są zazwyczaj wyceniane w milionach tokenów.

Ustawienie maksymalnej liczby tokenów ogranicza łączną liczbę tokenów, które mogą być przetworzone w jednej interakcji lub żądaniu, zapewniając generowanie odpowiedzi w rozsądnych granicach. Domyślny limit to 4000 tokenów — to optymalna wielkość do streszczania dokumentów i kilku źródeł w celu wygenerowania odpowiedzi.

Temperatura

Temperatura kontroluje różnorodność odpowiedzi, w zakresie od 0 do 1.

- Temperatura 0,1 sprawia, że odpowiedzi są bardzo konkretne, ale mogą być powtarzalne i mało treściwe.

- Wysoka temperatura 1 pozwala na maksymalną kreatywność odpowiedzi, ale zwiększa ryzyko nieistotnych lub wręcz “halucynacyjnych” treści.

Na przykład zalecana temperatura dla chatbota obsługi klienta to między 0,2 a 0,5. Taki poziom zapewni rzeczowe, zgodne ze scenariuszem odpowiedzi, pozwalając jednak na naturalną różnorodność.

Model

To selektor modelu. Znajdziesz tu wszystkie wspierane modele firmy Anthropic. Aktualnie obsługujemy wszystkie najnowsze modele z rodziny Claude:

- Claude 3.5 Sonnet – Najnowsza wersja średniego modelu Claude. Łączy szybkość z wysoką jakością, sprawdzając się w większości zadań. Dowiedz się więcej tutaj.

- Claude 3 Sonnet – Starsza wersja popularnego modelu średniego. Sprawdź nasz artykuł, by zobaczyć, jak wypada porównanie.

- Claude 3 Haiku – Lekki i szybki model, idealny do masowego wykonywania prostych zadań. Mimo mniejszej mocy, dobrze radzi sobie również z bardziej złożonymi zadaniami. Sprawdź nasz pełny test modelu.

- Claude 2 – Wydajny model starszej generacji. Dowiedz się więcej o jego sposobie działania tutaj.

Jak dodać LLM Anthropic AI do swojego przepływu

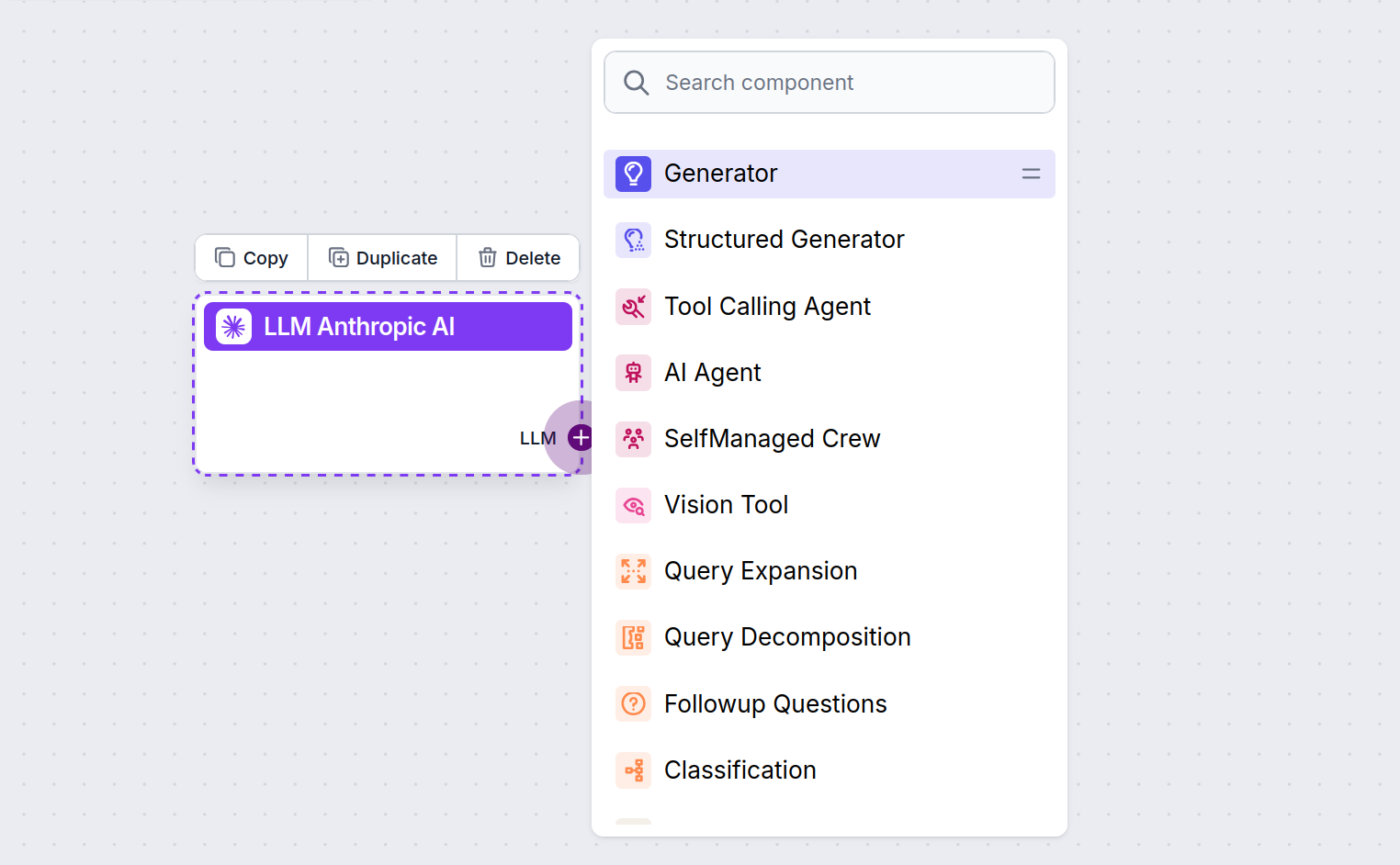

Zauważysz, że wszystkie komponenty LLM mają tylko wyjście (output). Wejście nie przechodzi przez ten komponent, ponieważ reprezentuje on wyłącznie model, podczas gdy samo generowanie zachodzi w Agentach AI i Generatorach.

Uchwyt LLM jest zawsze fioletowy. Wejście LLM znajduje się w każdym komponencie, który używa AI do generowania tekstu lub przetwarzania danych. Opcje zobaczysz po kliknięciu uchwytu:

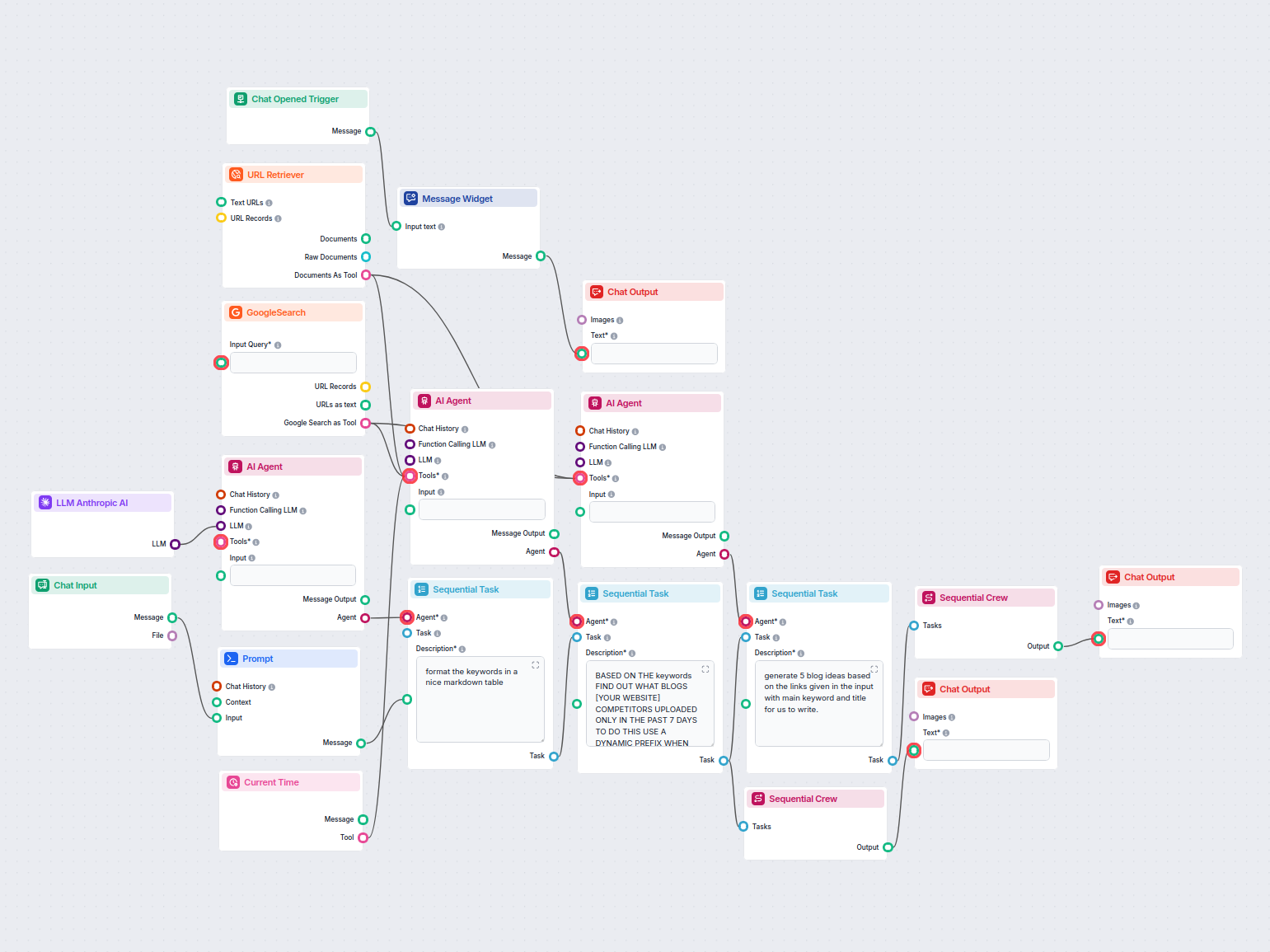

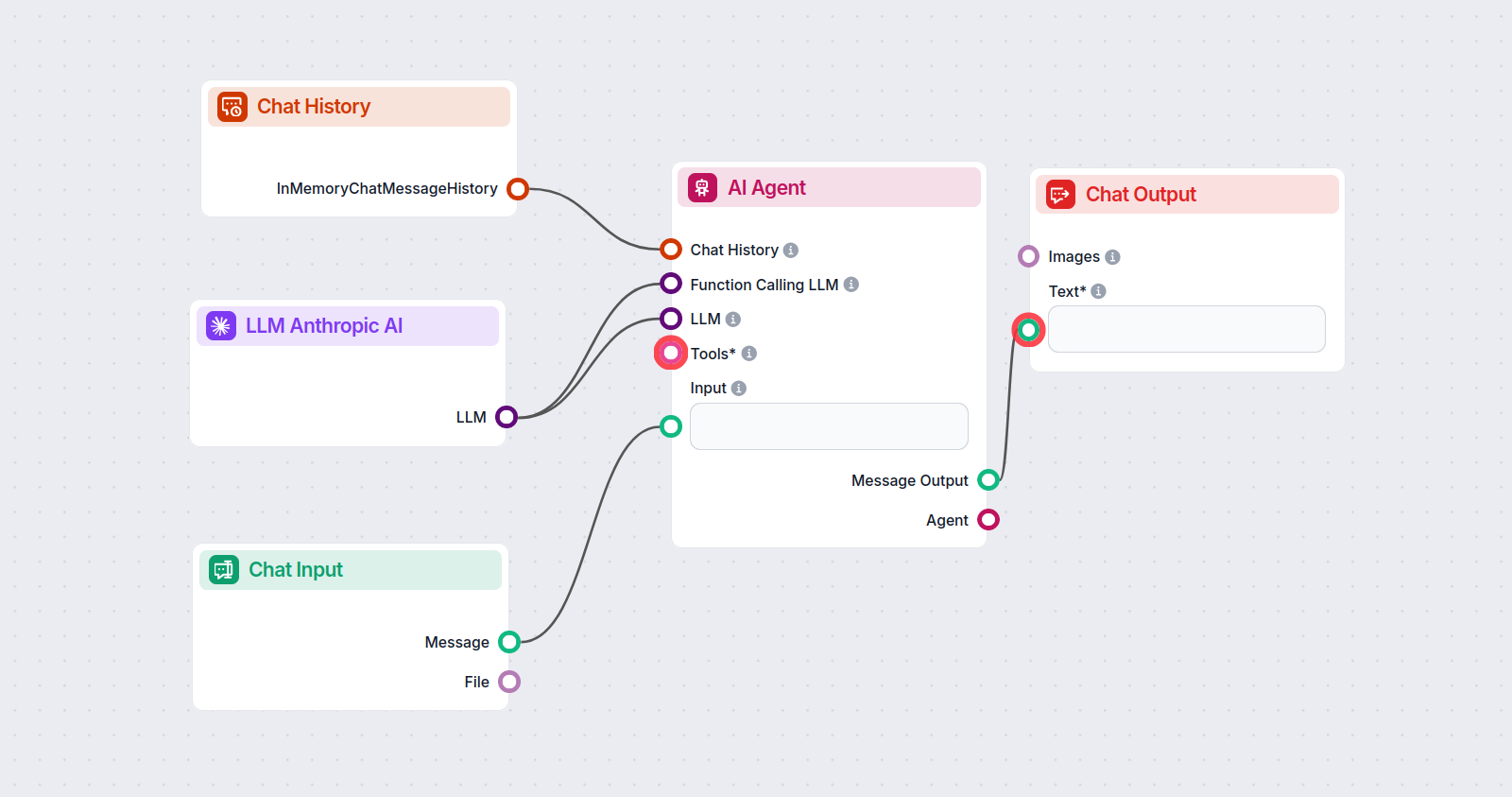

Pozwala to na tworzenie wszelkiego rodzaju narzędzi. Zobaczmy komponent w akcji. Oto prosty przepływ chatbota AI Agenta, który korzysta z Claude 3.5 Sonnet od Anthropic do generowania odpowiedzi. Możesz potraktować go jako podstawowego chatbota Anthropic.

Ten prosty przepływ chatbota obejmuje:

- Wejście czatu: Reprezentuje wiadomość wysyłaną przez użytkownika.

- Historia czatu: Pozwala chatbotowi pamiętać i uwzględniać wcześniejsze odpowiedzi.

- Wyjście czatu: Odpowiedź końcowa chatbota.

- Agent AI: Autonomiczny agent AI generujący odpowiedzi.

- LLM Anthropic AI: Połączenie z modelami generowania tekstu Anthropic.

Przykłady szablonów przepływu wykorzystujących komponent LLM Anthropic AI

Aby pomóc Ci szybko zacząć, przygotowaliśmy kilka przykładowych szablonów przepływu, które pokazują, jak efektywnie używać komponentu LLM Anthropic AI. Te szablony prezentują różne przypadki użycia i najlepsze praktyki, ułatwiając zrozumienie i implementację komponentu w Twoich własnych projektach.

Najczęściej zadawane pytania

- Czym jest komponent LLM Anthropic AI w FlowHunt?

Komponent LLM Anthropic AI łączy modele Claude firmy Anthropic z Twoimi przepływami w FlowHunt, pozwalając decydować, który model będzie używany do generowania tekstu oraz kontrolować takie ustawienia jak maksymalna liczba tokenów i temperatura.

- Które modele Claude są obsługiwane?

FlowHunt obsługuje wszystkie najnowsze modele z rodziny Claude, w tym Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku oraz Claude 2.

- Co kontrolują maksymalne tokeny i temperatura?

Maksymalna liczba tokenów ustala ograniczenie długości każdej odpowiedzi, natomiast temperatura kontroluje losowość — niższe wartości sprawiają, że odpowiedzi są bardziej konkretne, wyższe zwiększają kreatywność.

- Czy podłączenie komponentu LLM Anthropic AI jest wymagane?

Nie, podłączenie komponentu LLM Anthropic AI jest opcjonalne. Domyślnie komponenty używają ChatGPT-4o, ale możesz dodać ten komponent, aby przełączyć się na modele Claude i dostosować ustawienia.

Wypróbuj LLM Anthropic AI w FlowHunt

Zacznij budować własne narzędzia AI i chatboty, korzystając z modeli Claude firmy Anthropic dzięki łatwej integracji w przepływach i zaawansowanej konfiguracji.