Opis komponentu

Jak działa komponent LLM DeepSeek

Czym jest komponent LLM DeepSeek?

Komponent LLM DeepSeek łączy modele DeepSeek z Twoim Flow. Choć to w Generatorach i Agentach dzieje się cała magia, komponenty LLM pozwalają na podmianę i kontrolę używanego modelu.

Pamiętaj, że podłączenie komponentu LLM jest opcjonalne. Wszystkie komponenty korzystające z LLM mają domyślnie ChatGPT-4o. Komponenty LLM pozwalają zmienić model i kontrolować jego ustawienia.

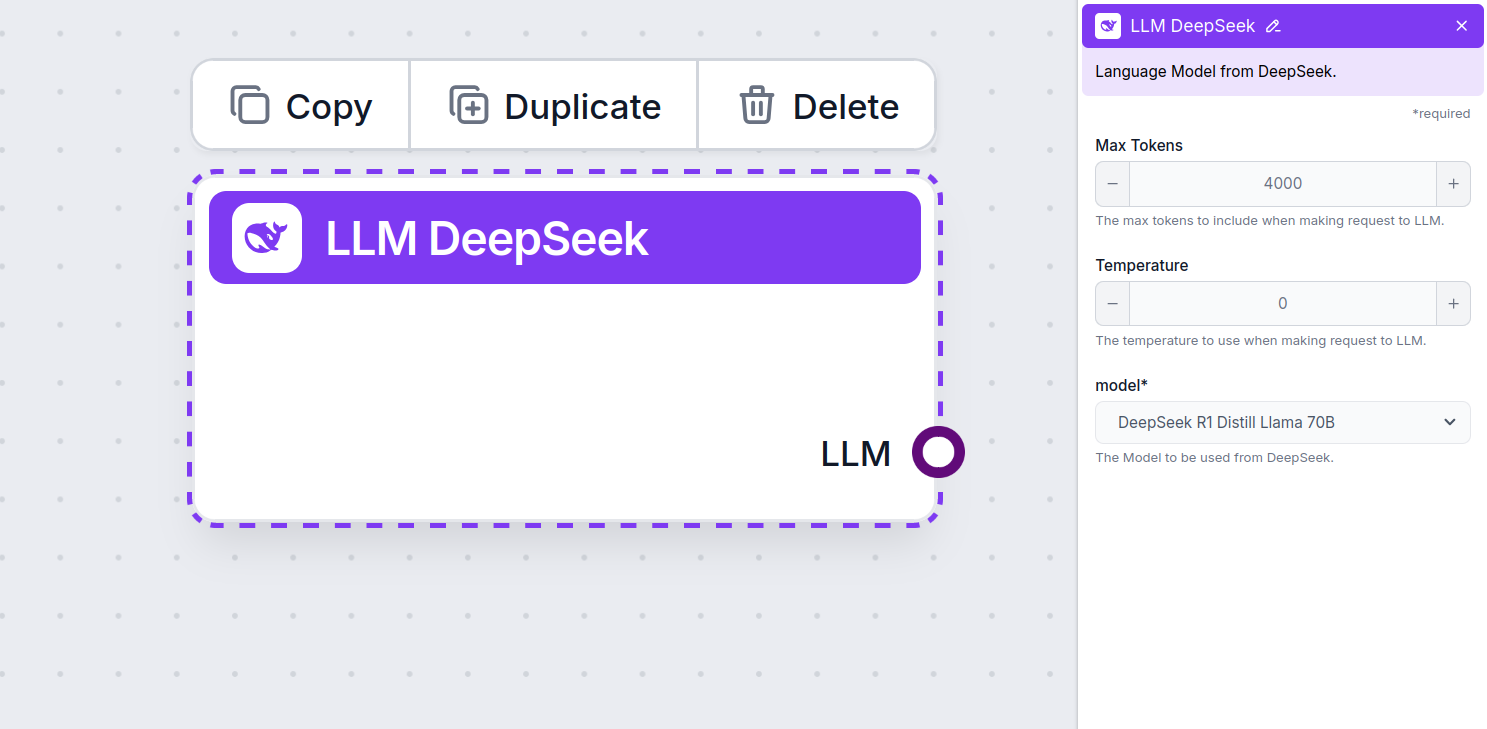

Ustawienia komponentu LLM Gemini

Max Tokens

Tokeny to pojedyncze jednostki tekstu, które model przetwarza i generuje. Zużycie tokenów zależy od modelu, a pojedynczy token może oznaczać słowo, fragment słowa lub pojedynczy znak. Modele są zwykle wyceniane w milionach tokenów.

Ustawienie max tokens ogranicza łączną liczbę tokenów, które mogą być przetworzone w jednej interakcji lub żądaniu, zapewniając, że odpowiedzi mieszczą się w rozsądnych granicach. Domyślny limit to 4000 tokenów — to optymalny rozmiar do streszczania dokumentów i kilku źródeł, by wygenerować odpowiedź.

Temperature

Temperature kontroluje zmienność odpowiedzi, w zakresie od 0 do 1.

Temperatura 0,1 sprawi, że odpowiedzi będą bardzo konkretne, ale mogą być powtarzalne i mało rozbudowane.

Wysoka temperatura 1 pozwala na maksymalną kreatywność odpowiedzi, lecz zwiększa ryzyko pojawiania się nieistotnych lub nawet “halucynacyjnych” treści.

Na przykład, zalecana temperatura dla chatbota obsługi klienta to między 0,2 a 0,5. Ten poziom pozwoli utrzymać odpowiedzi na temat i zgodne ze skryptem, a jednocześnie umożliwi naturalną różnorodność reakcji.

Model

To jest wybór modelu. Tutaj znajdziesz wszystkie obsługiwane modele DeepSeek. Obsługujemy wszystkie najnowsze modele Gemini:

- DeepSeek R1: Chiński, lekki model open source, który podbił świat na początku 2025 roku. To obecnie najszybszy i najlepszy model DeepSeek, który bez problemu przewyższa model o1 od OpenAI.

Jak dodać LLM DeepSeek do swojego Flow

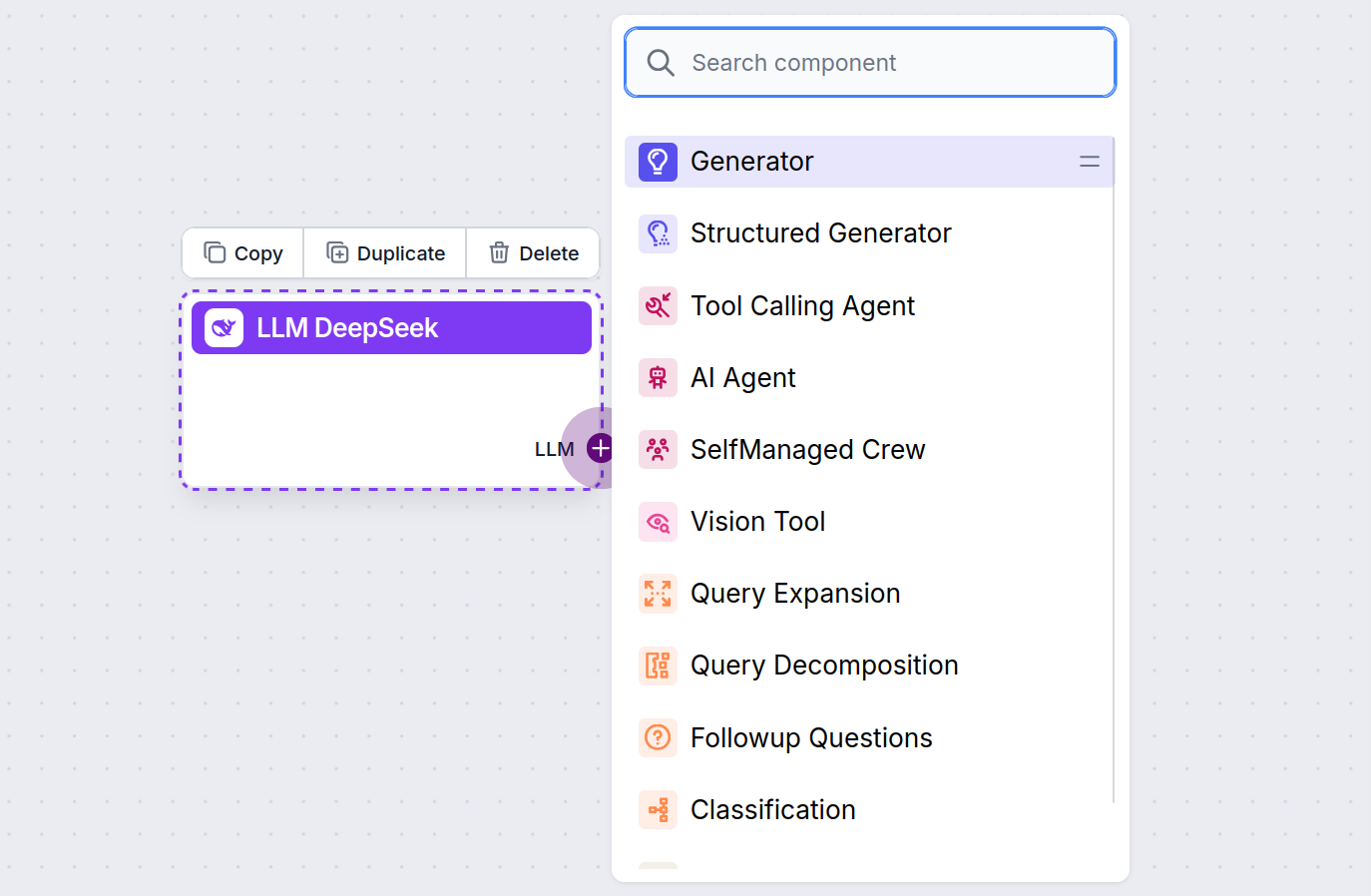

Zauważysz, że wszystkie komponenty LLM mają tylko wyjściowy uchwyt. Dane wejściowe nie przechodzą przez komponent, ponieważ reprezentuje on tylko model — faktyczne generowanie odbywa się w AI Agentach i Generatorach.

Uchwyt LLM jest zawsze fioletowy. Uchwyt wejściowy LLM znajduje się w każdym komponencie, który używa AI do generowania tekstu lub przetwarzania danych. Opcje zobaczysz po kliknięciu uchwytu:

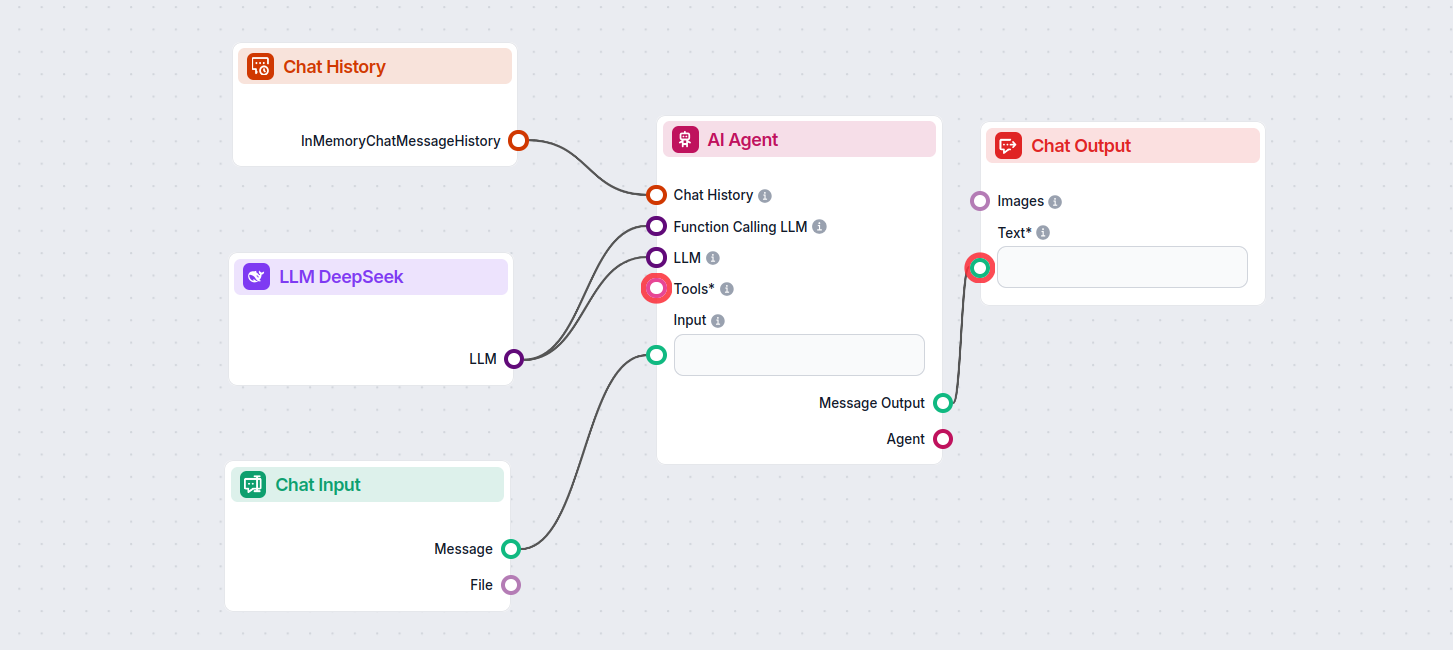

To pozwala tworzyć wszelkiego rodzaju narzędzia. Zobaczmy komponent w akcji. Oto przykładowy Flow chatbota AI, który wykorzystuje DeepSeek R1 do generowania odpowiedzi. Możesz go traktować jak podstawowego chatbota DeepSeek.

Ten prosty Chatbot Flow obejmuje:

- Chat input: Reprezentuje wiadomość, którą użytkownik wysyła na czacie.

- Chat history: Zapewnia, że chatbot pamięta i uwzględnia wcześniejsze odpowiedzi.

- Chat output: Reprezentuje końcową odpowiedź chatbota.

- AI Agent: Autonomiczny agent AI generujący odpowiedzi.

- LLM DeepSeek: Połączenie z modelami generującymi DeepSeek.

Najczęściej zadawane pytania

- Czym jest LLM DeepSeek w FlowHunt?

LLM DeepSeek to komponent w FlowHunt, który pozwala łączyć i kontrolować modele AI DeepSeek do generowania tekstu i obrazów, umożliwiając tworzenie zaawansowanych chatbotów i zautomatyzowanych flow.

- Które modele DeepSeek są obsługiwane?

FlowHunt obsługuje wszystkie najnowsze modele DeepSeek, w tym DeepSeek R1, znany z szybkości i wydajności, zwłaszcza w porównaniu do innych wiodących modeli AI.

- Jak mogę dostosować ustawienia LLM DeepSeek?

Możesz dostosować maksymalną liczbę tokenów (długość odpowiedzi) i temperaturę (kreatywność odpowiedzi), a także przełączać się między dostępnymi modelami DeepSeek bezpośrednio z pulpitu FlowHunt.

- Czy podłączenie komponentu LLM DeepSeek jest wymagane?

Nie, podłączenie komponentu LLM jest opcjonalne. Domyślnie FlowHunt używa ChatGPT-4o, ale dodanie LLM DeepSeek pozwala przełączać i kontrolować, który model AI zasila Twoje flow.

Wypróbuj FlowHunt z DeepSeek

Zacznij budować inteligentniejsze chatboty AI i narzędzia automatyzujące, korzystając z zaawansowanych modeli DeepSeek — wszystko bez skomplikowanej konfiguracji czy wielu subskrypcji.