Opis komponentu

Jak działa komponent LLM OpenAI

Czym jest komponent LLM OpenAI?

Komponent LLM OpenAI łączy modele ChatGPT z Twoim flow. Chociaż to Generatory i Agenci są miejscem, gdzie dzieje się właściwa magia, komponenty LLM pozwalają kontrolować, jaki model jest używany. Wszystkie komponenty domyślnie korzystają z ChatGPT-4. Możesz podłączyć ten komponent, jeśli chcesz zmienić model lub mieć nad nim większą kontrolę.

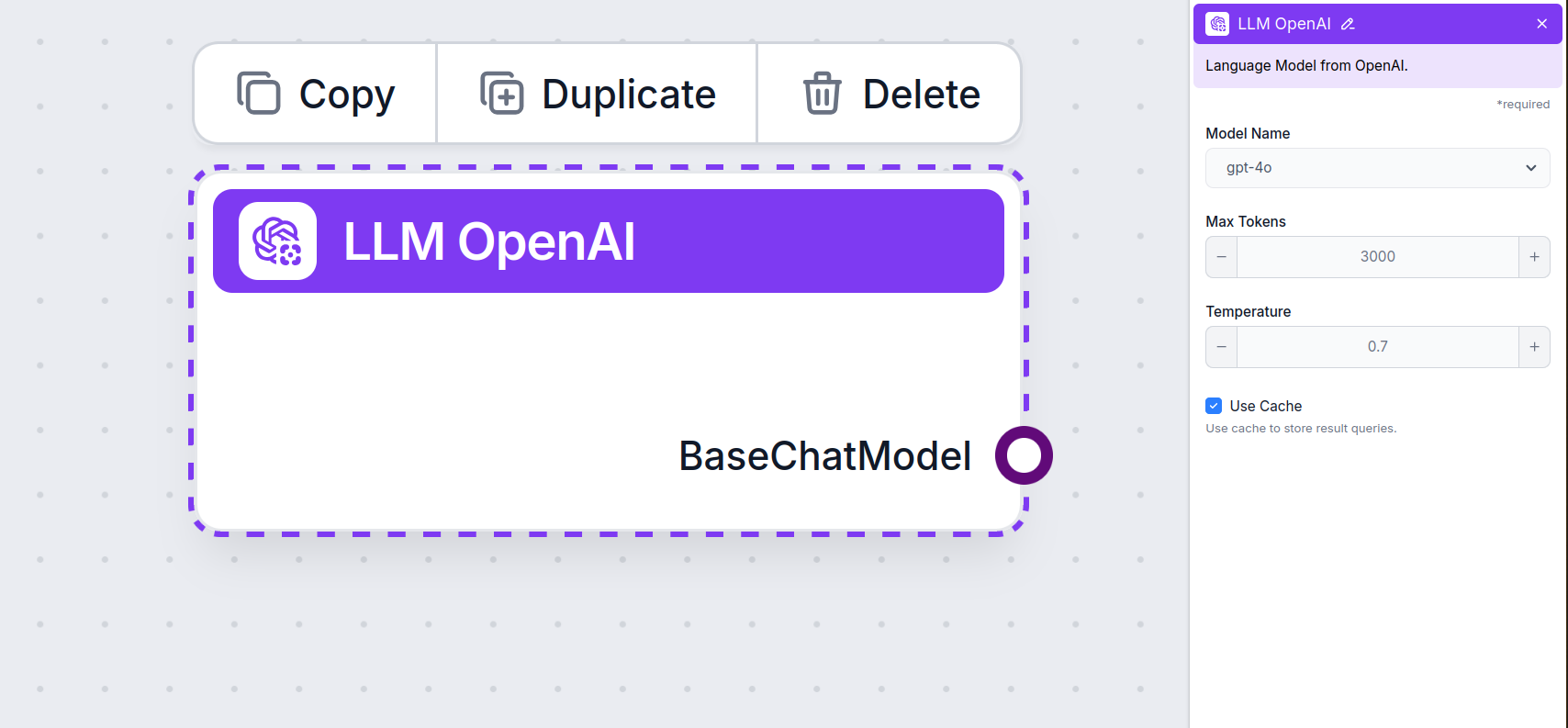

Ustawienia komponentu LLM OpenAI

Nazwa modelu

To jest selektor modelu. Tutaj znajdziesz wszystkie modele OpenAI obsługiwane przez FlowHunt. ChatGPT oferuje pełną listę modeli o różnych możliwościach i cenach. Na przykład, używanie mniej zaawansowanego i starszego GPT-3.5 będzie kosztować mniej niż najnowszego 4o, ale jakość i szybkość wyników będą niższe.

Modele OpenAI dostępne w FlowHunt:

- GPT-4o – Najnowszy i najpopularniejszy model OpenAI. Model multimodalny zdolny do przetwarzania tekstu, obrazów, dźwięku oraz przeszukiwania internetu. Dowiedz się więcej tutaj.

- GPT-4o Mini – Mniejsza, tańsza wersja GPT-4o, oferująca lepszą wydajność niż GPT-3.5 Turbo, z oknem kontekstowym 128K i ponad 60% redukcją kosztów. Zobacz, jak radzi sobie z zadaniami.

- o1 Mini – Odchudzona wersja modelu o1, zaprojektowana do złożonych zadań wymagających rozumowania, oferuje równowagę między wydajnością a efektywnością. Sprawdź, jak wypadł w naszych testach.

- o1 Preview – Zaawansowany model o ulepszonych możliwościach rozumowania, doskonały w rozwiązywaniu złożonych problemów, szczególnie w kodowaniu i rozumowaniu naukowym, dostępny jako wersja preview. Zobacz, jak myśli i radzi sobie z zadaniami.

- gpt-4-vision-preview – Model preview akceptujący wejście tekstowe i obrazowe, obsługujący tryb JSON i równoległe wywoływanie funkcji, co zwiększa możliwości multimodalnej interakcji. Dowiedz się więcej tutaj.

- GPT-3.5 Turbo – Starsza wersja GPT, świetna do prostych zadań przy niskim koszcie. Zobacz nasze testy agenta AI i porównaj ją z nowszymi modelami.

Wybierając właściwy model do zadania, weź pod uwagę wymaganą jakość i szybkość. Starsze modele świetnie sprawdzają się przy prostych, masowych zadaniach i czacie, pozwalając zaoszczędzić. Jeśli generujesz treści lub przeszukujesz internet, sugerujemy wybrać nowszy, bardziej dopracowany model.

Maksymalna liczba tokenów

Tokeny to pojedyncze jednostki tekstu, które model przetwarza i generuje. Zużycie tokenów zależy od modelu, a pojedynczy token może być słowem, pod-słowem lub pojedynczym znakiem. Modele są zazwyczaj wyceniane za miliony tokenów.

Ustawienie maksymalnej liczby tokenów ogranicza całkowitą liczbę tokenów, które mogą być przetworzone w jednej interakcji lub zapytaniu, zapewniając, że odpowiedzi mieszczą się w rozsądnych granicach. Domyślny limit to 4000 tokenów, co jest optymalną wielkością do podsumowywania dokumentów i wielu źródeł, aby wygenerować odpowiedź.

Temperatura

Temperatura kontroluje zmienność odpowiedzi, w zakresie od 0 do 1.

Temperatura 0,1 sprawi, że odpowiedzi będą bardzo rzeczowe, ale mogą być powtarzalne i mało rozbudowane.

Wysoka temperatura 1 pozwala na maksymalną kreatywność odpowiedzi, ale niesie ryzyko odpowiedzi nie na temat lub nawet “halucynacji”.

Na przykład zalecana temperatura dla chatbota obsługującego klientów to między 0,2 a 0,5. Ten poziom utrzymuje odpowiedzi zgodne z tematem i scenariuszem, ale pozwala na naturalną zmienność.

Jak dodać LLM OpenAI do swojego flow

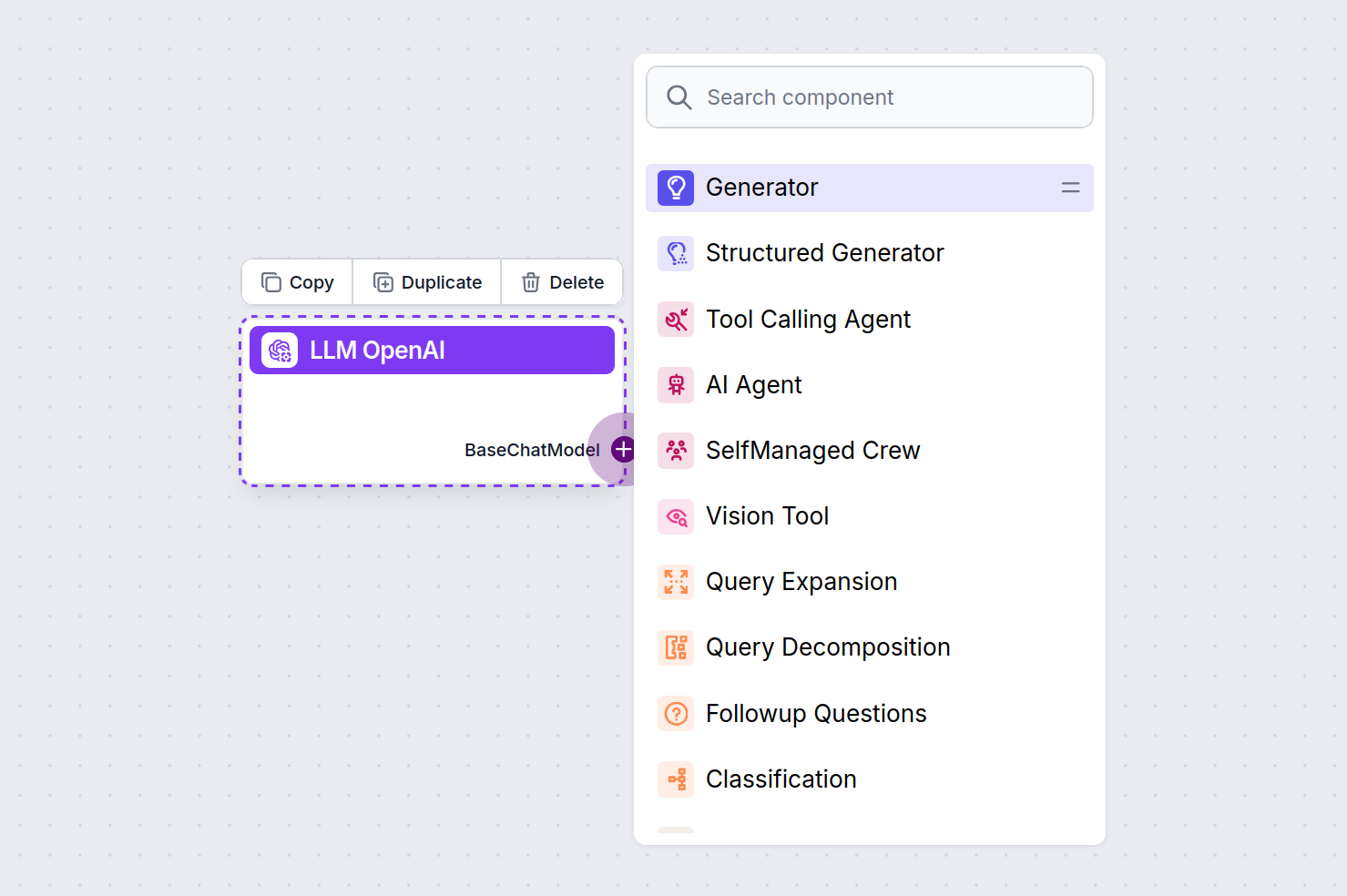

Zauważysz, że wszystkie komponenty LLM mają tylko uchwyt wyjściowy. Wejście nie przechodzi przez komponent, ponieważ reprezentuje on tylko model, a faktyczna generacja zachodzi w Agentach AI i Generatorach.

Uchwyt LLM jest zawsze fioletowy. Uchwyt wejściowy LLM znajdziesz na każdym komponencie, który używa AI do generowania tekstu lub przetwarzania danych. Opcje zobaczysz po kliknięciu uchwytu:

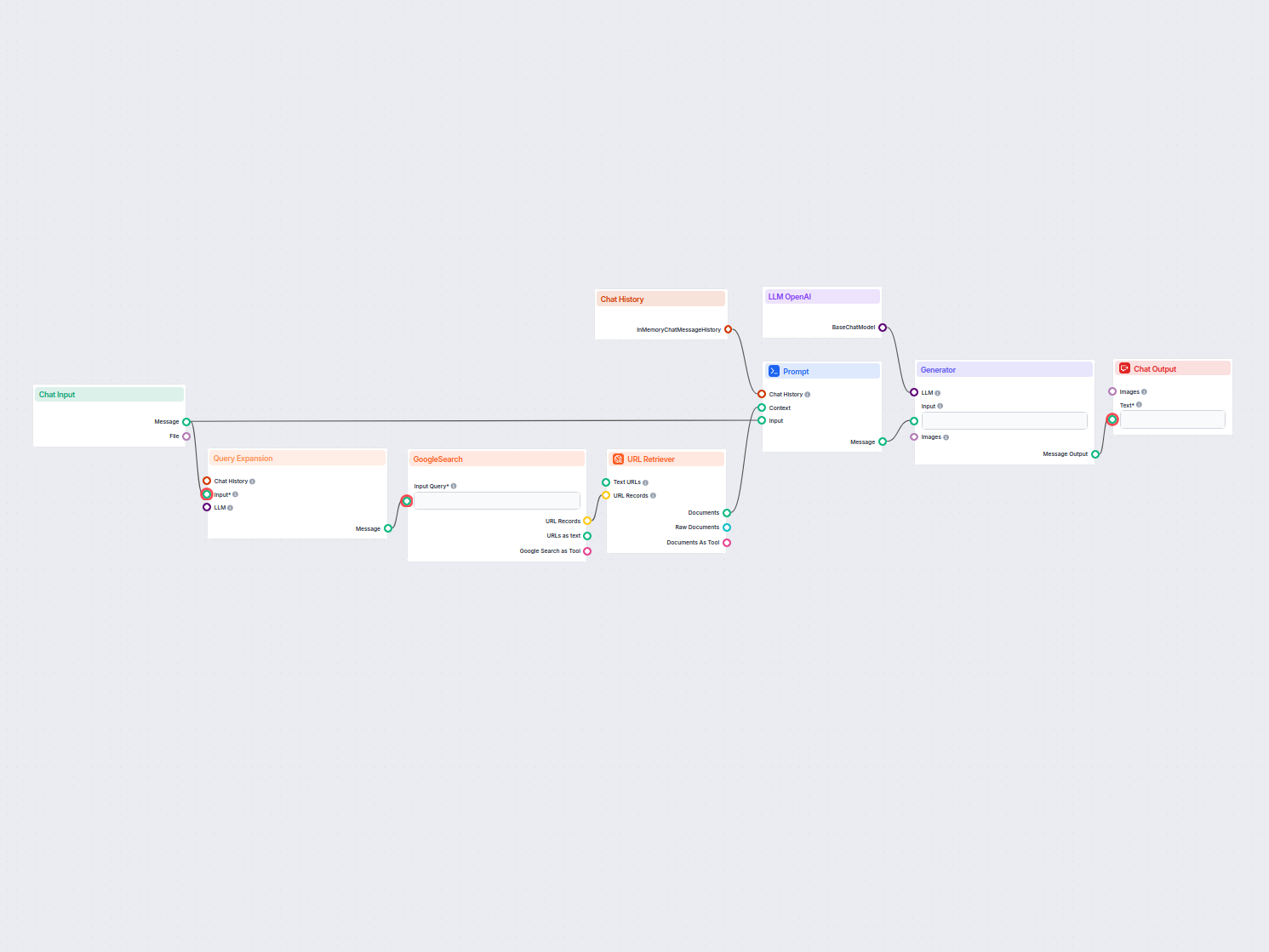

To pozwala tworzyć różne narzędzia. Zobaczmy komponent w akcji. Oto prosty flow chatbota napędzanego Agentem z użyciem o1 Preview do generowania odpowiedzi. Możesz potraktować to jako podstawowego chatbota ChatGPT.

Ten prosty flow chatbota obejmuje:

- Wejście z czatu: Reprezentuje wiadomość wysłaną przez użytkownika.

- Historia czatu: Zapewnia, że chatbot pamięta i uwzględnia wcześniejsze odpowiedzi.

- Wyjście z czatu: Reprezentuje ostateczną odpowiedź chatbota.

- AI Agent: Autonomiczny agent AI, który generuje odpowiedzi.

- LLM OpenAI: Połączenie z modelami generowania tekstu OpenAI.

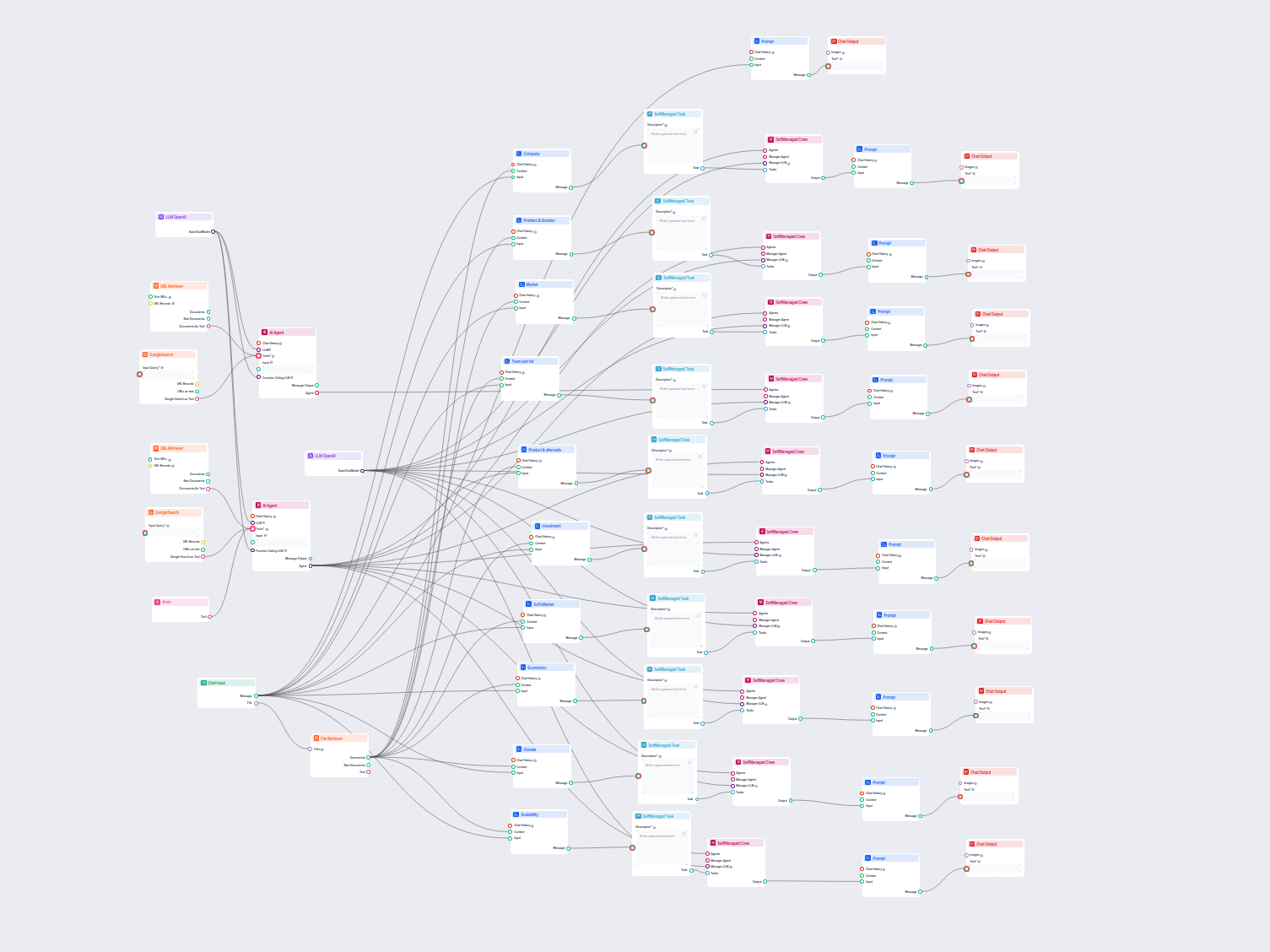

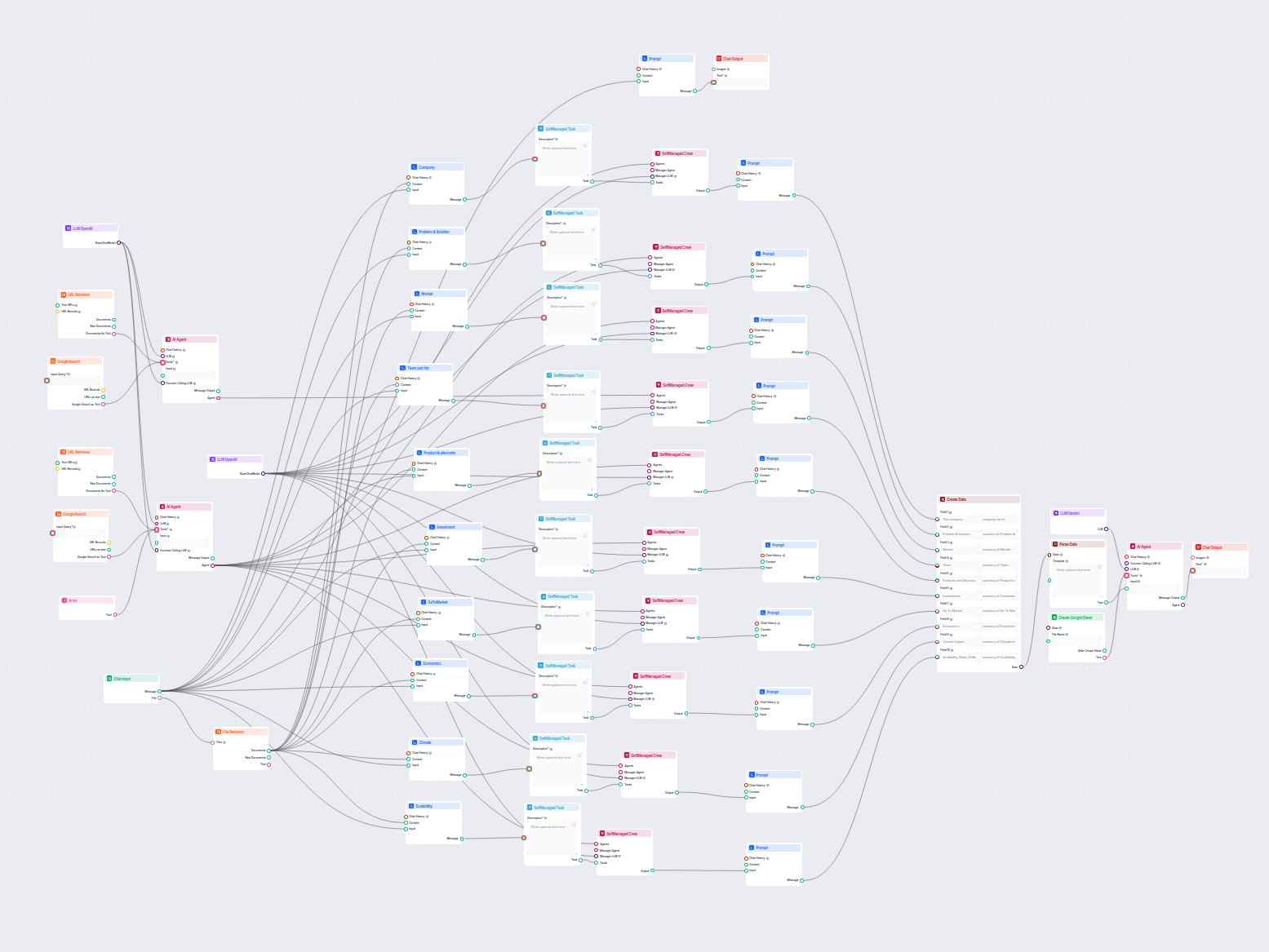

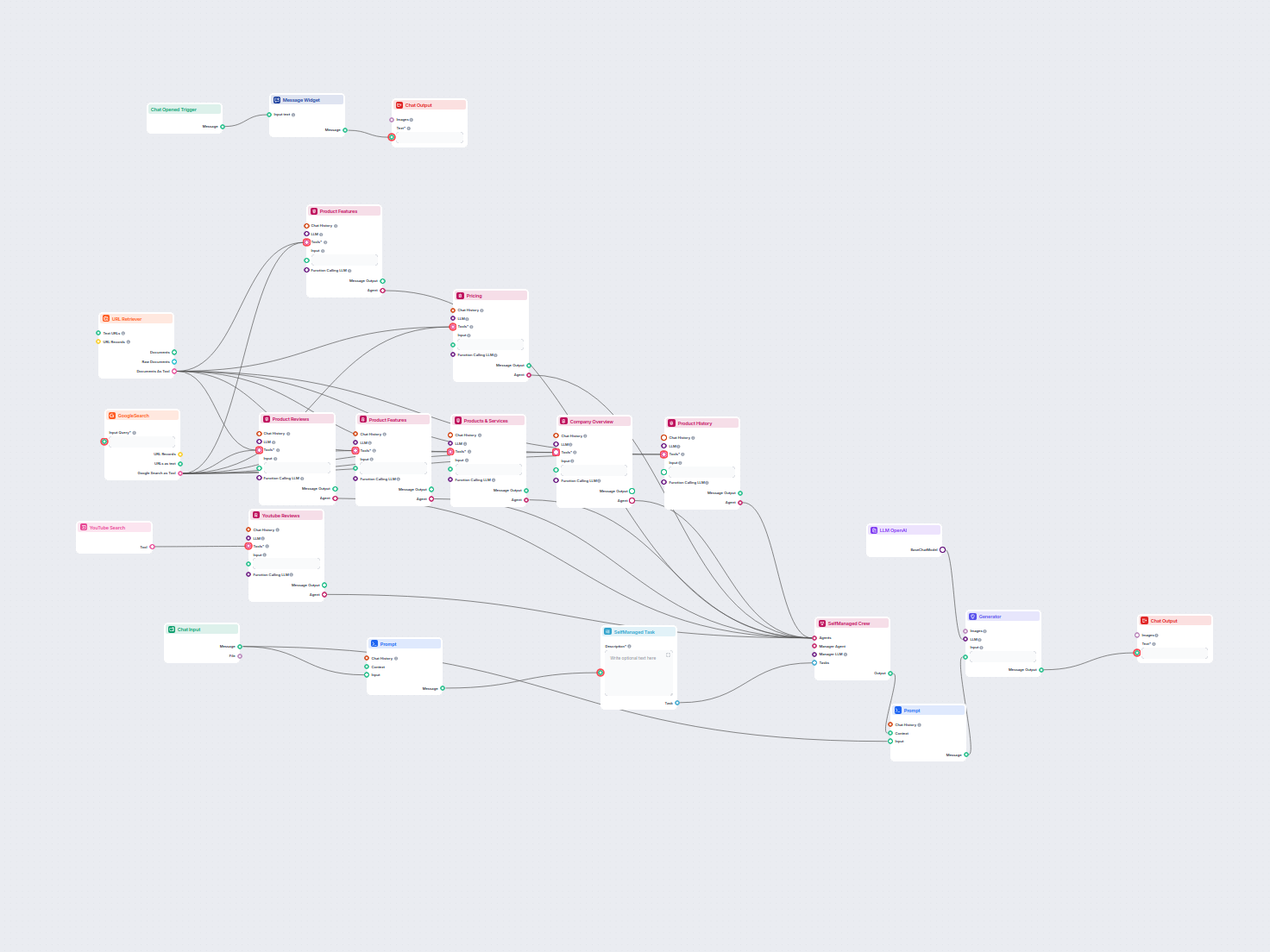

Przykłady szablonów przepływu wykorzystujących komponent LLM OpenAI

Aby pomóc Ci szybko zacząć, przygotowaliśmy kilka przykładowych szablonów przepływu, które pokazują, jak efektywnie używać komponentu LLM OpenAI. Te szablony prezentują różne przypadki użycia i najlepsze praktyki, ułatwiając zrozumienie i implementację komponentu w Twoich własnych projektach.

Najczęściej zadawane pytania

- Czym są LLM-y?

Duże modele językowe to rodzaje AI, które zostały wytrenowane do przetwarzania, rozumienia i generowania tekstu przypominającego ludzki. Przykładem jest ChatGPT, który potrafi udzielać rozbudowanych odpowiedzi na niemal każde pytanie.

- Czy mogę podłączyć LLM bezpośrednio do Chat Output?

Nie, komponent LLM jest jedynie reprezentacją modelu AI. Zmienia model, którego użyje Generator. Domyślnym LLM w Generatorze jest ChatGPT-4o.

- Jakie LLM-y są dostępne w Flows?

Obecnie dostępny jest tylko komponent OpenAI. Planujemy dodać więcej w przyszłości.

- Czy muszę dodać LLM do mojego flow?

Nie, Flows to wszechstronna funkcja z wieloma zastosowaniami bez konieczności użycia LLM. Dodajesz LLM, jeśli chcesz zbudować konwersacyjnego chatbota, który swobodnie generuje odpowiedzi tekstowe.

- Czy komponent LLM OpenAI generuje odpowiedź?

Nie do końca. Komponent jedynie reprezentuje model i tworzy dla niego zasady działania. To komponent generatora łączy go z wejściem i przesyła zapytanie przez LLM, aby wygenerować odpowiedź.

Gotowy, aby zbudować własną AI?

Sprytne chatboty i narzędzia AI pod jednym dachem. Połącz intuicyjne bloki, aby zamienić swoje pomysły w zautomatyzowane Flows.