Funkcje aktywacji

Funkcje aktywacji wprowadzają nieliniowość do sieci neuronowych, umożliwiając im naukę złożonych wzorców niezbędnych w zastosowaniach AI i deep learningu.

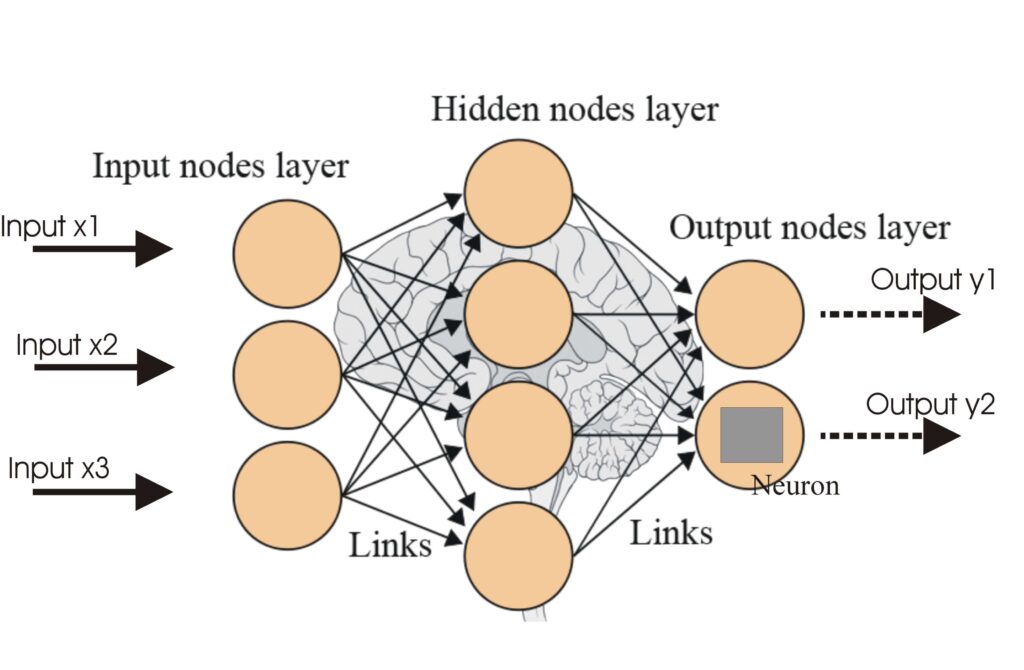

Funkcje aktywacji są podstawą architektury sztucznych sieci neuronowych (ANN), znacząco wpływając na zdolność sieci do nauki i realizacji złożonych zadań. Ten artykuł słownikowy zagłębia się w zawiłości funkcji aktywacji, analizując ich cel, rodzaje i zastosowania – szczególnie w kontekście AI, deep learningu i sieci neuronowych.

Czym jest funkcja aktywacji?

Funkcja aktywacji w sieci neuronowej to operacja matematyczna stosowana do wyjścia neuronu. Określa, czy neuron powinien zostać aktywowany, wprowadzając do modelu nieliniowość, która pozwala sieci uczyć się złożonych wzorców. Bez tych funkcji sieć neuronowa działałaby zasadniczo jak model regresji liniowej, niezależnie od swojej głębokości czy liczby warstw.

Cel funkcji aktywacji

- Wprowadzenie nieliniowości: Funkcje aktywacji pozwalają sieciom neuronowym wychwytywać nieliniowe zależności w danych, co jest niezbędne do rozwiązywania złożonych zadań.

- Ograniczenie wyjścia: Ograniczają wyjście neuronów do określonego zakresu, zapobiegając ekstremalnym wartościom, które mogą utrudniać proces uczenia.

- Propagacja gradientu: Podczas wstecznej propagacji funkcje aktywacji pomagają w obliczaniu gradientów, niezbędnych do aktualizacji wag i biasów w sieci.

Rodzaje funkcji aktywacji

Liniowe funkcje aktywacji

- Równanie: $f(x) = x$

- Charakterystyka: Nie wprowadza nieliniowości; wyjście jest proporcjonalne do wejścia.

- Zastosowanie: Często używana w warstwie wyjściowej w zadaniach regresji, gdzie wartości nie są ograniczone do konkretnego zakresu.

- Ograniczenie: Wszystkie warstwy “zlewają się” w jedną, tracąc głębię sieci.

Nieliniowe funkcje aktywacji

Funkcja Sigmoid

- Równanie: $f(x) = \frac{1}{1 + e^{-x}}$

- Charakterystyka: Wyjście w zakresie od 0 do 1; krzywa w kształcie “S”.

- Zastosowanie: Odpowiednia przy problemach klasyfikacji binarnej.

- Ograniczenie: Może napotykać problem zanikającego gradientu, spowalniając naukę w głębokich sieciach.

Funkcja Tanh

- Równanie: $f(x) = \tanh(x) = \frac{2}{1 + e^{-2x}} – 1$

- Charakterystyka: Wyjście w zakresie od -1 do 1; wycentrowana w zerze.

- Zastosowanie: Często używana w ukrytych warstwach sieci neuronowych.

- Ograniczenie: Również podatna na problem zanikającego gradientu.

ReLU (Rectified Linear Unit)

- Równanie: $f(x) = \max(0, x)$

- Charakterystyka: Wyjście to zero dla wartości ujemnych i liniowe dla dodatnich.

- Zastosowanie: Powszechnie stosowana w deep learningu, zwłaszcza w konwolucyjnych sieciach neuronowych.

- Ograniczenie: Może wystąpić problem “zanikającego ReLU”, gdzie neurony przestają się uczyć.

Leaky ReLU

- Równanie: $f(x) = \max(0.01x, x)$

- Charakterystyka: Pozwala na niewielki, niezerowy gradient, gdy jednostka jest nieaktywna.

- Zastosowanie: Rozwiązuje problem zanikającego ReLU, pozwalając na niewielkie nachylenie dla wartości ujemnych.

Funkcja Softmax

- Równanie: $f(x_i) = \frac{e^{x_i}}{\sum_{j} e^{x_j}}$

- Charakterystyka: Przekształca logity w prawdopodobieństwa sumujące się do 1.

- Zastosowanie: Używana w warstwie wyjściowej sieci neuronowych dla klasyfikacji wieloklasowej.

Funkcja Swish

- Równanie: $f(x) = x \cdot \text{sigmoid}(x)$

- Charakterystyka: Gładka i nieniemonotoniczna, umożliwia lepszą optymalizację i zbieżność.

- Zastosowanie: Często stosowana w nowoczesnych modelach deep learningu dla lepszej wydajności względem ReLU.

Zastosowania w AI i deep learningu

Funkcje aktywacji są nieodzowne w różnych zastosowaniach AI, takich jak:

- Klasyfikacja obrazów: Funkcje takie jak ReLU i Softmax są kluczowe w konwolucyjnych sieciach neuronowych do przetwarzania i klasyfikacji obrazów.

- Przetwarzanie języka naturalnego: Funkcje aktywacji pomagają w nauce złożonych wzorców w danych tekstowych, umożliwiając modelom językowym generowanie tekstu zbliżonego do ludzkiego.

- Automatyzacja AI: W robotyce i systemach zautomatyzowanych funkcje aktywacji wspierają procesy decyzyjne poprzez interpretację danych wejściowych z sensorów.

- Chatboty: Umożliwiają modelom konwersacyjnym skuteczne rozumienie i odpowiadanie na zapytania użytkowników dzięki nauce różnorodnych wzorców wejściowych.

Wyzwania i kwestie do rozważenia

- Problem zanikającego gradientu: Funkcje Sigmoid i Tanh mogą prowadzić do zanikających gradientów, przez co proces uczenia jest utrudniony. Stosowanie ReLU lub jej odmian może temu zaradzić.

- Zanikające ReLU: Istotny problem, gdy neurony podczas uczenia się zatrzymują i przestają się uczyć. Leaky ReLU oraz inne zmodyfikowane wersje mogą temu przeciwdziałać.

- Koszt obliczeniowy: Niektóre funkcje, jak sigmoid i softmax, są wymagające obliczeniowo, przez co mogą być nieodpowiednie w aplikacjach czasu rzeczywistego.

Najczęściej zadawane pytania

- Czym jest funkcja aktywacji w sieciach neuronowych?

Funkcja aktywacji to operacja matematyczna stosowana do wyjścia neuronu, wprowadzająca nieliniowość i umożliwiająca sieciom neuronowym naukę złożonych wzorców wykraczających poza proste relacje liniowe.

- Dlaczego funkcje aktywacji są ważne w AI i deep learningu?

Funkcje aktywacji pozwalają sieciom neuronowym rozwiązywać złożone, nieliniowe problemy dzięki możliwości uczenia się skomplikowanych wzorców, co czyni je kluczowymi do takich zadań jak klasyfikacja obrazów, przetwarzanie języka czy automatyzacja.

- Jakie są główne typy funkcji aktywacji?

Do najpopularniejszych należą Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax oraz Swish – każda z nich posiada unikalne cechy i zastosowania w różnych warstwach sieci neuronowych.

- Jakie wyzwania wiążą się z funkcjami aktywacji?

Typowe wyzwania to problem zanikającego gradientu (szczególnie przy Sigmoid i Tanh), zanikające ReLU, a także koszt obliczeniowy niektórych funkcji, jak Softmax, w aplikacjach czasu rzeczywistego.

Gotowy, by stworzyć własną AI?

Inteligentne chatboty i narzędzia AI w jednym miejscu. Połącz intuicyjne bloki, by zamienić swoje pomysły w zautomatyzowane Flows.