Dokładność modeli AI i stabilność modeli AI

Dokładność modelu AI mierzy poprawność przewidywań, a stabilność zapewnia spójność działania na różnych zbiorach danych—obie są kluczowe dla solidnych, niezawodnych rozwiązań AI.

Dokładność modelu AI

Czym jest dokładność modelu AI?

Dokładność modelu AI to kluczowa metryka w dziedzinie uczenia maszynowego, określająca stosunek poprawnych przewidywań modelu do ogólnej liczby przewidywań. Metryka ta jest szczególnie ważna w zadaniach klasyfikacyjnych, gdzie celem jest prawidłowa kategoryzacja przypadków. Formalny sposób obliczania dokładności to:

Dokładność = (Liczba poprawnych przewidywań) / (Łączna liczba przewidywań)

Wskaźnik ten daje prostą miarę skuteczności modelu w przewidywaniu prawidłowych wyników, jednak należy pamiętać, że sama dokładność nie zawsze daje pełny obraz, szczególnie w przypadku niezbalansowanych zbiorów danych.

Znaczenie w uczeniu maszynowym

W uczeniu maszynowym dokładność jest podstawowym wskaźnikiem efektywności modelu. Wysoka dokładność sugeruje, że model dobrze radzi sobie z zadaniem, np. wykrywaniem oszustw w systemie detekcji nieprawidłowych transakcji kartą kredytową. Znaczenie dokładności wykracza jednak poza zadania klasyfikacyjne; jest ona kluczowa w modelach wykorzystywanych w różnych zastosowaniach, gdzie decyzje w dużym stopniu opierają się na przewidywaniach modelu.

Przykłady zastosowań

- Diagnostyka medyczna: W opiece zdrowotnej wysoka dokładność diagnostyki jest kluczowa, ponieważ błędne przewidywania mogą prowadzić do poważnych konsekwencji, takich jak błędna diagnoza czy nieodpowiednie leczenie.

- Pojazdy autonomiczne: W przypadku samochodów autonomicznych dokładność w rozpoznawaniu i interpretacji znaków drogowych oraz przeszkód ma kluczowe znaczenie dla bezpieczeństwa i zapobiegania wypadkom.

Kluczowe metryki powiązane z dokładnością

- Precyzja: Mierzy stosunek liczby prawdziwie pozytywnych obserwacji do sumy prawdziwych i fałszywych pozytywnych obserwacji. Jest istotna tam, gdzie fałszywe alarmy niosą poważne konsekwencje.

- Czułość (Recall): Określa stosunek liczby prawdziwie pozytywnych obserwacji do sumy prawdziwie pozytywnych i fałszywie negatywnych. Jest kluczowa, by model wychwycił jak najwięcej prawdziwych przypadków.

Wyzwania

Choć dokładność jest wartościową metryką, może być myląca, zwłaszcza przy niezbalansowanych zbiorach danych, gdzie jedna klasa zdecydowanie dominuje. W takich przypadkach dokładność nie zawsze odzwierciedla rzeczywistą wydajność modelu, a metryki takie jak F1-score czy pole pod krzywą ROC mogą dać pełniejszy obraz.

Stabilność modelu AI

Czym jest stabilność modelu AI?

Stabilność modelu AI odnosi się do spójności działania modelu w czasie oraz na różnych zbiorach danych lub w różnych środowiskach. Stabilny model dostarcza zbliżone wyniki mimo drobnych zmian w danych wejściowych lub środowisku obliczeniowym, co zapewnia niezawodność i odporność przewidywań.

Znaczenie w uczeniu maszynowym

Stabilność jest kluczowa dla modeli wdrożonych w środowisku produkcyjnym, gdzie spotykają się z rozkładami danych innymi niż w zbiorze treningowym. Stabilny model gwarantuje niezawodne działanie i spójność przewidywań w czasie, niezależnie od zmian zewnętrznych.

Przykłady zastosowań

- Prognozowanie finansowe: Stabilność jest niezbędna w modelach finansowych przewidujących trendy na rynku akcji, ponieważ muszą one adaptować się do zmieniających się warunków rynkowych bez utraty wydajności.

- Zarządzanie łańcuchem dostaw: Modele AI zarządzające łańcuchem dostaw wymagają stabilności, by radzić sobie ze zmianami sezonowymi i wahaniami popytu bez pogorszenia wyników.

Kluczowe czynniki wpływające na stabilność

- Dryf danych: Zmiany w rozkładzie danych wejściowych w czasie mogą wpływać na stabilność modelu. Do rozwiązania tego problemu konieczne jest regularne monitorowanie i ponowne trenowanie.

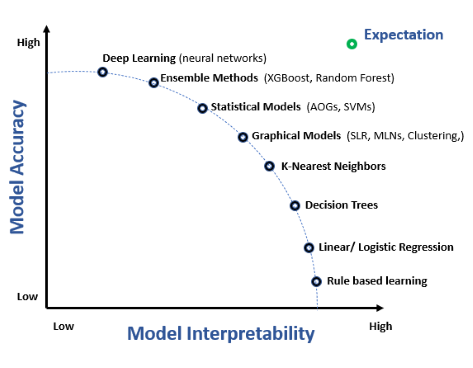

- Złożoność modelu: Bardziej złożone modele, takie jak głębokie sieci neuronowe, mogą cechować się mniejszą stabilnością ze względu na większą wrażliwość na zmiany w danych wejściowych.

Techniki zwiększania stabilności

- Monitorowanie modelu: Ciągłe śledzenie metryk działania modelu, by wcześnie wykrywać i rozwiązywać spadki wydajności.

- Regularne ponowne trenowanie: Aktualizowanie modelu o nowe dane, by zapewnić zgodność z aktualnymi wzorcami w danych.

Wyzwania

Utrzymanie stabilności jest wyzwaniem w szybko zmieniających się środowiskach. Osiągnięcie równowagi między elastycznością a spójnością często wymaga zaawansowanych strategii, takich jak transfer learning czy online learning, by model mógł adaptować się do nowych danych bez utraty wydajności.

Powiązania z automatyzacją AI i chatbotami

W automatyzacji AI i chatbotach zarówno dokładność, jak i stabilność mają kluczowe znaczenie. Chatbot musi precyzyjnie interpretować zapytania użytkownika (dokładność) i konsekwentnie udzielać niezawodnych odpowiedzi w różnych kontekstach i dla różnych użytkowników (stabilność). W obsłudze klienta niestabilny chatbot może skutkować niespójnymi odpowiedziami i niezadowoleniem użytkowników.

Czym są rankingi modeli AI?

Rankingi modeli AI to platformy lub narzędzia służące do klasyfikowania modeli uczenia maszynowego na podstawie ich wydajności w różnych metrykach i zadaniach. Rankingi te zapewniają ustandaryzowane i porównawcze ramy oceny, które są niezbędne dla badaczy, deweloperów i praktyków do wyboru najlepszych modeli do konkretnych zastosowań. Dostarczają wglądu w możliwości i ograniczenia modeli, co jest nieocenione dla zrozumienia krajobrazu technologii AI.

Struktura rankingów modeli AI

- Ewaluacje zadaniowe: Ocena modeli w określonych domenach, takich jak przetwarzanie języka naturalnego, widzenie komputerowe czy uczenie ze wzmocnieniem, przy użyciu konkretnych zbiorów danych i benchmarków.

- Różnorodne metryki: Stosowanie szerokiego zakresu metryk, takich jak dokładność, precyzja, czułość, F1-score i inne, do oceny wydajności modeli.

- Ciągłe aktualizacje: Regularna aktualizacja rankingów o najnowsze modele i wyniki, dzięki czemu odzwierciedlają one najnowsze osiągnięcia.

Wpływ rankingów modeli AI

- Benchmarking: Stanowią punkt odniesienia do mierzenia postępów AI w czasie, umożliwiając porównania względem wspólnych standardów i identyfikację modeli o najwyższej wydajności.

- Innowacja: Stymulują innowacje, zachęcając do opracowywania nowych podejść i rozwiązań w drodze rywalizacji.

- Transparentność: Zapewniają przejrzyste metody oceny wydajności modeli, co jest kluczowe dla budowania zaufania do technologii AI.

- Zaangażowanie społeczności: Sprzyjają współpracy i wymianie wiedzy wśród praktyków AI, przyczyniając się do rozwoju całej branży.

Przykładowe rankingi modeli AI

| Nazwa rankingu | Opis |

|---|---|

| Hugging Face Open LLM Leaderboard | Ocena otwartych dużych modeli językowych za pomocą zunifikowanych kryteriów, takich jak wiedza, rozumowanie i rozwiązywanie problemów. |

| Artificial Analysis LLM Performance Leaderboard | Skupia się na ocenie modeli pod względem jakości, ceny, szybkości i innych metryk, szczególnie dla bezserwerowych API LLM. |

| LMSYS Chatbot Arena Leaderboard | Ocena chatbotów na podstawie głosów użytkowników i rankingu Elo podczas interakcji z niestandardowymi promptami i scenariuszami. |

Wyzwania związane z rankingami modeli AI

- Nadmiar dopasowania: Modele mogą być przesadnie dopasowane do konkretnych zbiorów rankingowych, co skutkuje słabą generalizacją na nowych danych.

- Obchodzenie systemu: Uczestnicy mogą wykorzystywać luki w procesie oceny, by uzyskać wyższe pozycje bez rzeczywistej poprawy wydajności.

- Ograniczenia ewaluacji: Rankingi mogą nie uwzględniać wszystkich aspektów działania modeli, takich jak kwestie etyczne czy zastosowanie w rzeczywistych warunkach.

Metryki wykorzystywane w rankingach modeli AI

Przegląd metryk

Metryki to ilościowe kryteria służące do oceny wydajności modeli AI w rankingach. Umożliwiają one standaryzowane porównywanie skuteczności modeli w realizacji określonych zadań.

Najczęściej stosowane metryki

- Dokładność: Stosunek poprawnych przewidywań do wszystkich przypadków; miara ogólnej poprawności modelu.

- Precyzja: Stosunek liczby prawdziwie pozytywnych przewidywań do wszystkich przewidywanych pozytywnych; wskazuje jakość pozytywnych przewidywań.

- Czułość: Stosunek liczby prawdziwie pozytywnych przewidywań do wszystkich rzeczywistych pozytywnych; odzwierciedla zdolność modelu do wykrywania istotnych przypadków.

- F1-Score: Średnia harmoniczna precyzji i czułości; przydatna w ocenie modeli na niezbalansowanych zbiorach danych.

- Pole pod krzywą ROC (AUC): Ocena wydajności modelu przy wszystkich progach klasyfikacyjnych.

- Mean Reciprocal Rank (MRR): Istotna w systemach wyszukiwania i rekomendacji, mierzy skuteczność rangowania wyników.

Zastosowanie metryk w rankingach

- Metryki są niezbędne do obiektywnego porównywania wydajności modeli, co napędza ulepszenia i innowacje w algorytmach AI.

- Pomagają identyfikować modele wyróżniające się w określonych zadaniach lub warunkach, wspierając wybór najlepszego rozwiązania do danego zastosowania.

Wyzwania związane z metrykami

- Stronniczość: Niektóre metryki mogą faworyzować określone modele lub zadania, prowadząc do nieobiektywnych ocen.

- Złożoność: Zrozumienie i interpretacja złożonych metryk może być trudna dla osób bez specjalistycznej wiedzy.

Przypadki użycia i zastosowania

Przykłady zastosowań rankingów modeli AI

- Wybór modelu: Deweloperzy korzystają z rankingów, aby wybrać najlepszy model do swoich potrzeb, np. chatbotów, wirtualnych asystentów czy narzędzi analizy danych.

- Monitorowanie wydajności: Organizacje śledzą wyniki systemów AI w czasie, wykorzystując rankingi do identyfikacji obszarów wymagających ulepszeń.

- Badania i rozwój: Naukowcy wykorzystują rankingi do testowania i walidacji nowych modeli AI, przyczyniając się do postępu naukowego.

Zastosowania metryk

- Ocena jakości: Metryki pozwalają ocenić i porównać jakość różnych modeli AI, zapewniając spełnienie wymagań dla konkretnych zastosowań.

- Optymalizacja: Analizując wyniki metryk, deweloperzy mogą optymalizować modele pod kątem lepszej wydajności w określonych zadaniach, zwiększając efektywność i skuteczność.

- Innowacja: Metryki napędzają innowacje, wskazując obszary, w których modele osiągają najlepsze lub najsłabsze wyniki, co zachęca do rozwoju nowych technik i podejść.

Najczęściej zadawane pytania

- Czym jest dokładność modelu AI?

Dokładność modelu AI to metryka określająca stosunek poprawnych przewidywań modelu do łącznej liczby wszystkich przewidywań, szczególnie istotna w zadaniach klasyfikacyjnych.

- Dlaczego stabilność modeli AI jest ważna?

Stabilność zapewnia, że model AI dostarcza spójne wyniki w czasie i na różnych zbiorach danych, co czyni go niezawodnym w realnych zastosowaniach.

- Jakie są typowe wyzwania związane z używaniem dokładności jako metryki?

Dokładność może być myląca w przypadku niezbalansowanych zbiorów danych i nie zawsze odzwierciedla prawdziwą wydajność modelu. Często stosuje się metryki takie jak F1-score, precyzja i czułość, aby uzyskać pełniejszą ocenę.

- Jak poprawić stabilność modeli AI?

Stabilność modelu można zwiększyć poprzez regularne monitorowanie, ponowne trenowanie na nowych danych, zarządzanie dryfem danych oraz stosowanie technik takich jak transfer learning lub online learning.

- Czym są rankingi modeli AI?

Rankingi modeli AI to zestawienia klasyfikujące modele uczenia maszynowego na podstawie ich wydajności w różnych metrykach i zadaniach, zapewniając ustandaryzowane ramy oceny porównawczej i stymulując innowacje.

Zacznij budować niezawodne rozwiązania AI

Dowiedz się, jak FlowHunt pomaga tworzyć dokładne i stabilne modele AI do automatyzacji, chatbotów i nie tylko. Zwiększ niezawodność i wydajność już dziś.