Błąd uogólnienia

Błąd uogólnienia to kluczowa miara w uczeniu maszynowym, określająca zdolność modelu do przewidywania wyników dla nieznanych danych i zapewniająca solidną wydajność w rzeczywistych warunkach.

Błąd uogólnienia, często nazywany błędem poza próbką lub ryzykiem, to podstawowe pojęcie w uczeniu maszynowym i teorii uczenia statystycznego. Określa, jak dobrze model lub algorytm potrafi przewidywać wyniki dla nieznanych danych na podstawie nauki z ograniczonego zbioru treningowego. Głównym celem oceny błędu uogólnienia jest zrozumienie zdolności modelu do uzyskiwania dobrych wyników na nowych, wcześniej nieobserwowanych danych, a nie tylko na tych, na których był uczony. To kluczowe dla tworzenia modeli dokładnych i odpornych w rzeczywistych zastosowaniach.

Zrozumienie błędu uogólnienia

W swojej istocie błąd uogólnienia to rozbieżność między przewidywaniami modelu a rzeczywistymi wynikami na nowych danych. Błąd ten wynika z wielu źródeł, w tym niedokładności modelu, błędów próbkowania oraz nieodłącznego szumu w danych. Podczas gdy niektóre z tych błędów można zminimalizować poprzez wybór modelu i dostrajanie parametrów, inne, takie jak szum, są nieusuwalne.

Znaczenie w uczeniu maszynowym

W kontekście uczenia nadzorowanego błąd uogólnienia stanowi kluczową miarę oceny wydajności algorytmów. Zapewnia, że model nie tylko dopasowuje się do danych treningowych, ale również skutecznie przewiduje wyniki w rzeczywistych przypadkach. Ma to fundamentalne znaczenie dla zastosowań od data science po automatyzację opartą na AI w chatbotach i innych systemach sztucznej inteligencji.

Przeuczenie i niedouczenie

Błąd uogólnienia jest ściśle powiązany z pojęciami przeuczenia (overfitting) i niedouczenia (underfitting):

- Przeuczenie (overfitting) występuje, gdy model zbyt dobrze uczy się danych treningowych, łącznie z szumem, przez co słabo radzi sobie na nieznanych danych.

- Niedouczenie (underfitting) ma miejsce, gdy model jest zbyt prosty, by uchwycić ukryte wzorce w danych, co skutkuje słabymi wynikami zarówno na danych treningowych, jak i nieznanych.

Definicja matematyczna

Matematycznie błąd uogólnienia ( I[f] ) funkcji ( f ) definiuje się jako wartość oczekiwaną funkcji straty ( V ) względem wspólnego rozkładu prawdopodobieństwa par wejście-wyjście ( (x, y) ):

[ I[f] = \int_{X \times Y} V(f(\vec{x}), y) \rho(\vec{x}, y) d\vec{x} dy ]

Gdzie ( \rho(\vec{x}, y) ) jest wspólnym rozkładem prawdopodobieństwa wejść i wyjść, który w praktyce jest zazwyczaj nieznany. Zamiast tego obliczamy błąd empiryczny (lub ryzyko empiryczne) na podstawie danych próbki:

[ I_n[f] = \frac{1}{n} \sum_{i=1}^{n} V(f(\vec{x}_i), y_i) ]

Mówimy, że algorytm dobrze uogólnia, jeśli różnica między błędem uogólnienia a błędem empirycznym dąży do zera wraz ze wzrostem rozmiaru próbki ( n ) do nieskończoności.

Kompromis bias-variance

Kompromis bias-variance to kluczowa zasada w rozumieniu błędu uogólnienia. Opisuje kompromis między dwoma typami błędów:

- Bias (obciążenie): Błąd wynikający z nadmiernie uproszczonych założeń modelu, przez co nie potrafi on uchwycić ukrytych trendów w danych.

- Variance (wariancja): Błąd wynikający z nadmiernej wrażliwości na drobne fluktuacje w danych treningowych, co często prowadzi do przeuczenia.

Celem jest znalezienie równowagi, w której zarówno bias, jak i variance są minimalizowane, uzyskując niski błąd uogólnienia. Ta równowaga jest kluczowa dla tworzenia modeli dokładnych i odpornych.

Techniki minimalizacji błędu uogólnienia

W celu minimalizacji błędu uogólnienia stosuje się szereg technik:

- Walidacja krzyżowa: Techniki takie jak k-krotna walidacja krzyżowa pomagają ocenić wydajność modelu na nieznanych danych poprzez wielokrotne podziały danych na zbiory treningowe i walidacyjne.

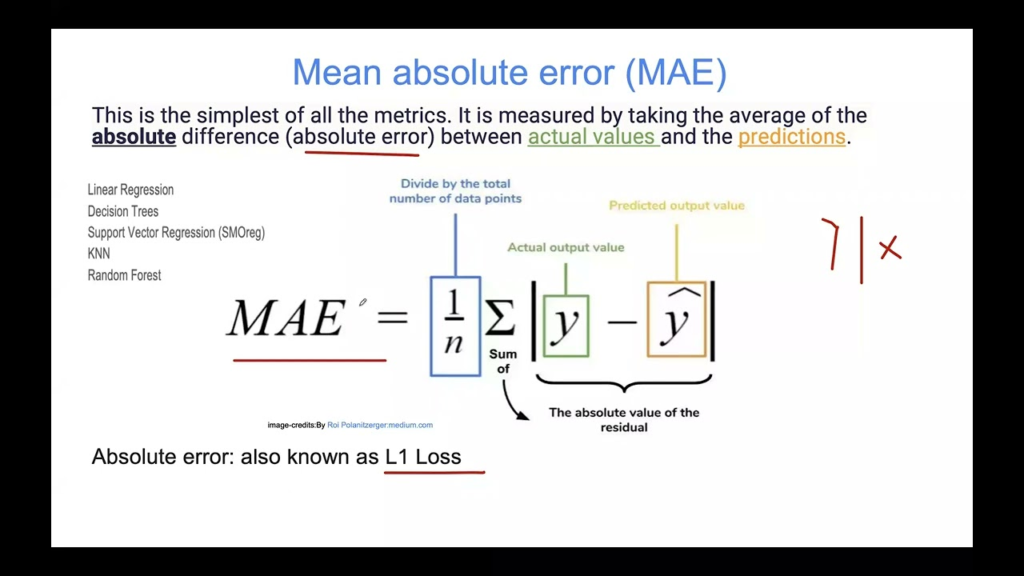

- Regularyzacja: Metody takie jak regularyzacja L1 (lasso) i L2 (ridge) nakładają karę na większe współczynniki, zniechęcając do tworzenia zbyt złożonych modeli mogących przeuczać dane treningowe.

- Dobór modelu: Wybór odpowiedniej złożoności modelu w zależności od problemu i zbioru danych pomaga skutecznie zarządzać kompromisem bias-variance.

- Metody zespołowe: Techniki takie jak bagging i boosting łączą wiele modeli, by poprawić uogólnienie poprzez redukcję wariancji i biasu.

Przykłady zastosowań

Zastosowania AI i uczenia maszynowego

W zastosowaniach AI, takich jak chatboty, niski błąd uogólnienia jest kluczowy, aby bot odpowiadał trafnie na szeroki zakres zapytań użytkowników. Jeśli model chatbota przeuczy się na danych treningowych, może radzić sobie dobrze tylko z predefiniowanymi pytaniami, ale nie poradzi sobie z nowymi zapytaniami użytkowników.

Projekty data science

W data science modele o niskim błędzie uogólnienia są niezbędne do przewidywania, które dobrze uogólniają się na różne zbiory danych. Przykładowo w analizie predykcyjnej model trenowany na danych historycznych powinien trafnie przewidywać przyszłe trendy.

Uczenie nadzorowane

W uczeniu nadzorowanym celem jest opracowanie funkcji przewidującej wartości wyjściowe dla każdego wejścia. Błąd uogólnienia dostarcza informacji o tym, jak dobrze ta funkcja poradzi sobie z nowymi danymi, które nie były obecne w zbiorze treningowym.

Ocena algorytmów uczenia

Błąd uogólnienia służy do oceny wydajności algorytmów uczenia. Analizując krzywe uczenia, które przedstawiają błędy na zbiorze treningowym i walidacyjnym w czasie, można ocenić, czy model ma tendencję do przeuczenia lub niedouczenia.

Teoria uczenia statystycznego

W teorii uczenia statystycznego ograniczenie różnicy między błędem uogólnienia a błędem empirycznym jest głównym zagadnieniem. Wykorzystuje się różne warunki stabilności, takie jak leave-one-out stability, aby udowodnić, że algorytm będzie dobrze uogólniał.

Błąd uogólnienia w uczeniu maszynowym

Błąd uogólnienia to kluczowe pojęcie w uczeniu maszynowym, oznaczające różnicę między wskaźnikiem błędu modelu na danych treningowych a nieznanych danych. Odzwierciedla, jak dobrze model potrafi przewidywać wyniki dla nowych, nieobserwowanych przypadków.

Źródła:

Some observations concerning Off Training Set (OTS) error Jonathana Baxtera, opublikowane 18 listopada 2019 r., omawia formę błędu uogólnienia znaną jako błąd Off Training Set (OTS). Artykuł przedstawia twierdzenie wskazujące, że niski błąd na zbiorze treningowym nie musi oznaczać niskiego błędu OTS, o ile nie są spełnione pewne założenia dotyczące funkcji docelowej. Autor argumentuje jednak, że zastosowanie tego twierdzenia jest ograniczone do modeli, w których rozkład danych treningowych nie pokrywa się z rozkładem danych testowych, co rzadko ma miejsce w praktycznych zastosowaniach uczenia maszynowego. Czytaj więcej

Stopping Criterion for Active Learning Based on Error Stability Hideakiego Ishibashiego i Hideitsu Hino, opublikowane 9 kwietnia 2021 r., wprowadza kryterium zatrzymania aktywnego uczenia oparte na stabilności błędu. Kryterium to zapewnia, że zmiana błędu uogólnienia przy dodaniu nowych próbek jest ograniczona przez koszt adnotacji, dzięki czemu można je zastosować w dowolnych bayesowskich ramach aktywnego uczenia. Badanie pokazuje, że zaproponowane kryterium skutecznie wyznacza optymalny moment zatrzymania aktywnego uczenia dla różnych modeli i zbiorów danych. Czytaj więcej

Najczęściej zadawane pytania

- Czym jest błąd uogólnienia w uczeniu maszynowym?

Błąd uogólnienia odnosi się do różnicy pomiędzy wydajnością modelu na danych treningowych a jego zdolnością do przewidywania wyników dla nieznanych danych. To kluczowa miara oceny, jak dobrze model sprawdzi się w rzeczywistych zastosowaniach.

- Jak można zminimalizować błąd uogólnienia?

Techniki takie jak walidacja krzyżowa, regularyzacja, staranny dobór modelu oraz metody zespołowe pomagają minimalizować błąd uogólnienia poprzez równoważenie biasu i wariancji, poprawiając tym samym zdolność modelu do przewidywania nowych danych.

- Dlaczego błąd uogólnienia jest ważny?

Zrozumienie i minimalizacja błędu uogólnienia zapewnia, że modele AI i uczenia maszynowego działają niezawodnie na nowych, rzeczywistych danych, a nie tylko na tych, na których były trenowane.

- Czym jest kompromis bias-variance?

Kompromis bias-variance opisuje równowagę między błędami wynikającymi z nadmiernie uproszczonych założeń modelu (bias) a błędami wynikającymi z nadmiernej wrażliwości na dane treningowe (wariancja). Osiągnięcie odpowiedniej równowagi pomaga minimalizować błąd uogólnienia.

Gotowy, aby zbudować własną AI?

Rozpocznij budowę solidnych modeli AI z FlowHunt. Odkryj intuicyjne narzędzia do minimalizacji błędu uogólnienia i maksymalizowania dokładności w rzeczywistych zastosowaniach.