MCP: Protokół Kontekstu Modelu

MCP standaryzuje bezpieczny dostęp LLM do zewnętrznych danych, narzędzi i wtyczek, umożliwiając elastyczną, zaawansowaną integrację AI i interoperacyjność.

Definicja

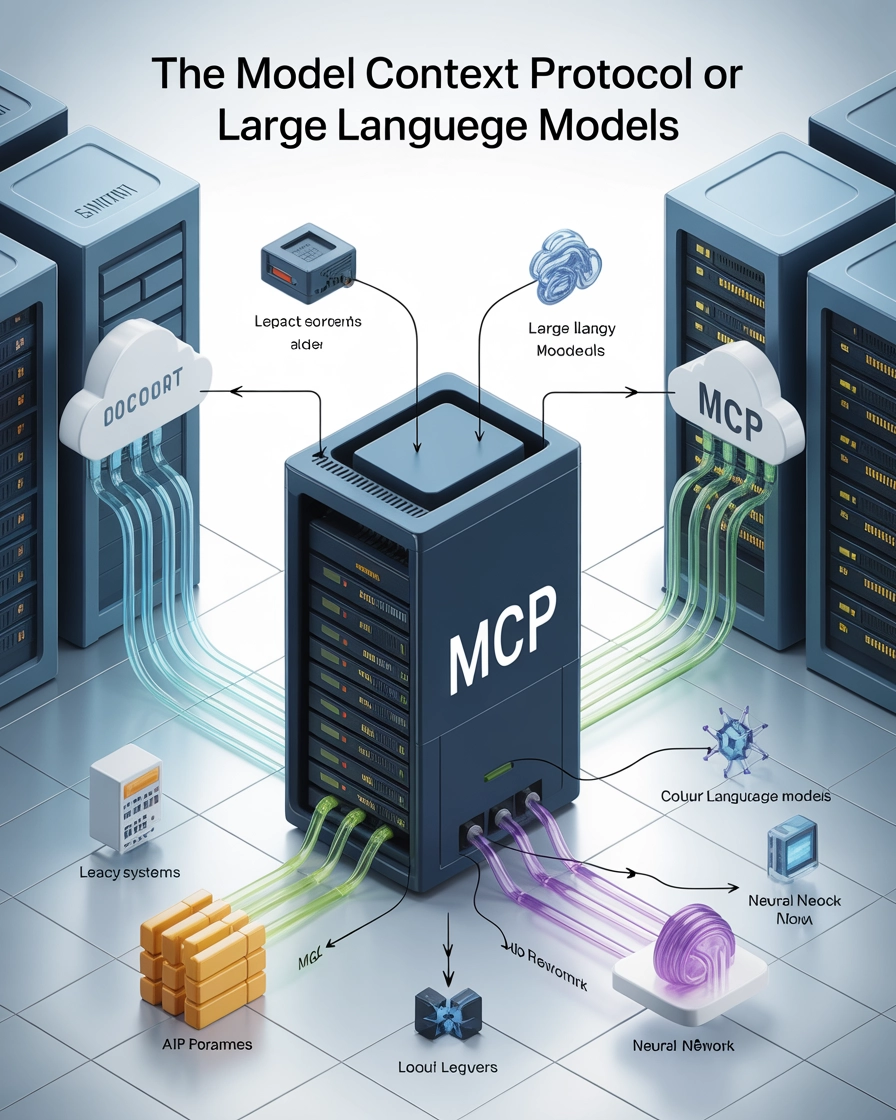

Model Context Protocol (MCP) to otwarty standard interfejsu, który umożliwia dużym modelom językowym (LLM) bezpieczny i spójny dostęp do zewnętrznych źródeł danych, narzędzi oraz dodatkowych funkcjonalności. MCP ustanawia standaryzowaną warstwę komunikacji pomiędzy aplikacjami AI a różnymi dostawcami kontekstu, pełniąc rolę „USB-C” dla systemów sztucznej inteligencji.

Kluczowe komponenty

Architektura

MCP opiera się na architekturze klient-serwer:

- Hosty MCP: Aplikacje, w których użytkownicy lub systemy AI dokonują interakcji (np. Claude Desktop, wtyczki IDE)

- Klienci MCP: Komponenty w aplikacjach-hostach, które obsługują komunikację z serwerami

- Serwery MCP: Lekkie programy udostępniające określone funkcjonalności (dostęp do plików, połączenia z bazami danych, dostęp do API) poprzez standaryzowany interfejs MCP

- Źródła danych: Lokalne lub zdalne repozytoria informacji, do których serwery MCP mogą bezpiecznie uzyskać dostęp

Podstawowe prymitywy

MCP definiuje trzy fundamentalne prymitywy, które stanowią podstawę protokołu:

1. Zasoby

Zasoby reprezentują dane i treści, które serwery MCP udostępniają dużym modelom językowym.

- Charakterystyka: Kontrolowane przez aplikację, identyfikowane za pomocą unikalnych URI

- Typy danych: Tekst (w kodowaniu UTF-8) lub binarne (w kodowaniu Base64)

- Metody odkrywania: Bezpośrednie listowanie lub szablony umożliwiające dynamiczne żądania zasobów

- Operacje: Odczyt treści, odbieranie aktualizacji

Przykład użycia: Serwer MCP udostępniający plik logów jako zasób o URI file:///logs/app.log

2. Prompt’y

Prompt’y to zdefiniowane wcześniej szablony lub przepływy pracy, które serwery oferują w celu prowadzenia interakcji z LLM.

- Charakterystyka: Uruchamiane przez użytkownika, często jako komendy typu „slash”

- Struktura: Unikalna nazwa, opis, opcjonalne argumenty

- Możliwości: Przyjmowanie argumentów personalizujących, uwzględnianie kontekstu zasobów, definiowanie wieloetapowych interakcji

- Operacje: Odkrywanie przez listowanie, wykonanie na żądanie

Przykład użycia: Prompt generatora wiadomości do commitów git, przyjmujący zmiany w kodzie jako wejście

3. Narzędzia

Narzędzia udostępniają funkcje wykonawcze, które LLM mogą wywoływać (zazwyczaj za zgodą użytkownika) w celu wykonania akcji.

- Charakterystyka: Kontrolowane przez model, wymagają dobrze zdefiniowanych schematów wejścia

- Adnotacje: Zawierają wskazówki o zachowaniu (tylko do odczytu, destrukcyjne, idempotentne, open-world)

- Funkcje bezpieczeństwa: Walidacja wejścia, kontrola dostępu, czytelne ostrzeżenia dla użytkownika

- Operacje: Odkrywanie przez listowanie, wykonanie przez wywołanie z parametrami

Przykład użycia: Narzędzie kalkulatora wykonujące działania matematyczne na wejściu dostarczonym przez model

Znaczenie i korzyści

Dla programistów

- Standaryzowana integracja: Możliwość łączenia aplikacji AI z różnorodnymi źródłami danych bez konieczności pisania dedykowanego kodu dla każdego z nich

- Najlepsze praktyki bezpieczeństwa: Wbudowane wytyczne dotyczące bezpiecznego udostępniania wrażliwych informacji

- Uproszczona architektura: Jasny podział pomiędzy modele AI a ich źródła kontekstu

Dla użytkowników i organizacji

- Elastyczność: Łatwiejsze przełączanie się pomiędzy różnymi dostawcami LLM lub aplikacjami-hostami

- Interoperacyjność: Ograniczenie uzależnienia od jednego dostawcy dzięki standaryzowanym interfejsom

- Rozszerzone możliwości: Systemy AI zyskują dostęp do bardziej zróżnicowanych informacji i funkcjonalności

Przykłady wdrożenia

Serwer zasobów plikowych

// Serwer udostępniający pojedynczy plik logów jako zasób

const server = new Server({ /* config */ }, { capabilities: { resources: {} } });

// Listowanie dostępnych zasobów

server.setRequestHandler(ListResourcesRequestSchema, async () => {

return {

resources: [

{

uri: "file:///logs/app.log",

name: "Logi aplikacji",

mimeType: "text/plain"

}

]

};

});

// Udostępnianie zawartości zasobu

server.setRequestHandler(ReadResourceRequestSchema, async (request) => {

if (request.params.uri === "file:///logs/app.log") {

const logContents = await readLogFile();

return {

contents: [{

uri: request.params.uri,

mimeType: "text/plain",

text: logContents

}]

};

}

throw new Error("Zasób nie znaleziony");

});

Serwer narzędzi kalkulatora

const server = new Server({ /* config */ }, { capabilities: { tools: {} } });

// Listowanie dostępnych narzędzi

server.setRequestHandler(ListToolsRequestSchema, async () => {

return {

tools: [{

name: "calculate_sum",

description: "Dodaj do siebie dwie liczby",

inputSchema: {

type: "object",

properties: {

a: { type: "number", description: "Pierwsza liczba" },

b: { type: "number", description: "Druga liczba" }

},

required: ["a", "b"]

},

annotations: {

title: "Oblicz sumę",

readOnlyHint: true,

openWorldHint: false

}

}]

};

});

// Obsługa wykonania narzędzia

server.setRequestHandler(CallToolRequestSchema, async (request) => {

if (request.params.name === "calculate_sum") {

try {

const { a, b } = request.params.arguments;

if (typeof a !== 'number' || typeof b !== 'number') {

throw new Error("Nieprawidłowe dane wejściowe: 'a' i 'b' muszą być liczbami.");

}

const sum = a + b;

return {

content: [{ type: "text", text: String(sum) }]

};

} catch (error: any) {

return {

isError: true,

content: [{ type: "text", text: `Błąd podczas obliczania sumy: ${error.message}` }]

};

}

}

throw new Error("Narzędzie nie znalezione");

});

Powiązane pojęcia

- Wywoływanie funkcji przez LLM: Model Context Protocol zapewnia standaryzowane podejście do koncepcji wywoływania funkcji przez LLM

- Agenci AI: MCP oferuje ustrukturyzowany sposób dostępu agentowych systemów AI do narzędzi i informacji

- Wtyczki AI: Podobnie jak rozszerzenia przeglądarki, serwery MCP można traktować jako „wtyczki” rozszerzające możliwości AI

Kierunki rozwoju

- Integracja AI w przedsiębiorstwie: Łączenie korporacyjnych baz wiedzy, narzędzi i przepływów pracy

- AI multimodalna: Standaryzacja dostępu do różnorodnych typów danych, nie tylko tekstu

- Współpracujące systemy AI: Umożliwienie współpracy asystentów AI dzięki wspólnym protokołom

Najczęściej zadawane pytania

- Czym jest Model Context Protocol (MCP)?

MCP to otwarty standard interfejsu, który pozwala LLM-om na bezpieczny i spójny dostęp do zewnętrznych źródeł danych, narzędzi i funkcjonalności, tworząc ustandaryzowaną warstwę komunikacji pomiędzy aplikacjami AI a dostawcami kontekstu.

- Jakie są kluczowe komponenty MCP?

MCP składa się z hostów, klientów, serwerów i źródeł danych. Wykorzystuje podstawowe prymitywy – zasoby, prompt’y i narzędzia – aby umożliwić elastyczne i bezpieczne interakcje pomiędzy LLM a systemami zewnętrznymi.

- Jakie korzyści MCP zapewnia programistom i organizacjom?

MCP upraszcza integrację AI, zwiększa bezpieczeństwo, ogranicza uzależnienie od jednego dostawcy i umożliwia łatwy dostęp do różnorodnych informacji i narzędzi zarówno programistom, jak i organizacjom.

- Jak MCP jest wdrażany w rzeczywistych aplikacjach?

MCP może być wdrożony poprzez serwery udostępniające zasoby lub narzędzia (np. dostęp do plików logów, narzędzia kalkulatora) poprzez ustandaryzowany interfejs, upraszczając połączenia z modelami AI.

- Jak MCP odnosi się do wywołań funkcji LLM i wtyczek AI?

MCP standaryzuje proces wywoływania przez LLM zewnętrznych funkcji lub narzędzi, podobnie jak wtyczki rozszerzają możliwości przeglądarek lub oprogramowania.

Wypróbuj FlowHunt i zbuduj własne rozwiązania AI

Zacznij budować zaawansowane systemy AI dzięki standaryzowanym integracjom, bezpiecznemu dostępowi do danych i elastycznemu połączeniu narzędzi z FlowHunt.