Załamanie modelu

Załamanie modelu występuje, gdy modele AI degradują się z powodu nadmiernego polegania na danych syntetycznych, czego skutkiem są mniej różnorodne, kreatywne i oryginalne wyniki.

Załamanie modelu to zjawisko w sztucznej inteligencji (AI), w którym wytrenowany model degraduje się z czasem, szczególnie gdy polega na danych syntetycznych lub generowanych przez AI. Ta degradacja objawia się zmniejszoną różnorodnością wyników, tendencją do „bezpiecznych” odpowiedzi oraz ograniczoną zdolnością do tworzenia kreatywnych lub oryginalnych treści.

Kluczowe pojęcia załamania modelu

Definicja

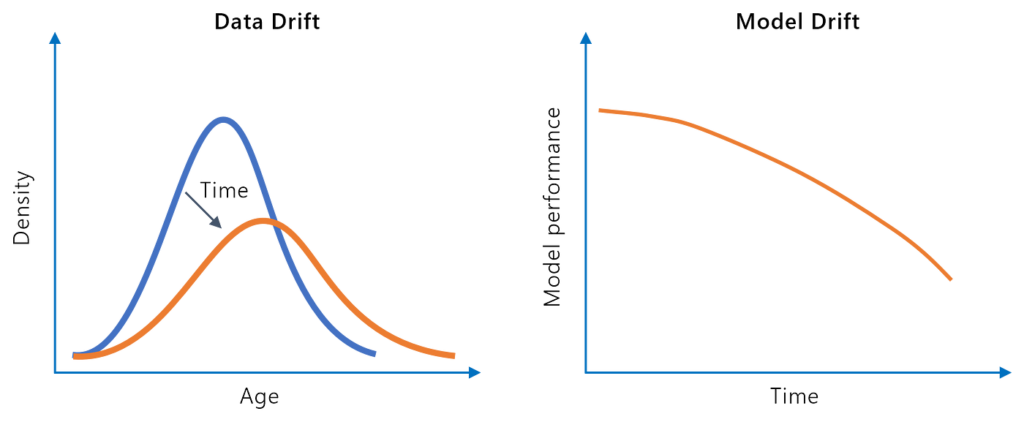

Załamanie modelu występuje, gdy modele AI, zwłaszcza modele generatywne, tracą swoją skuteczność na skutek wielokrotnego trenowania na treściach generowanych przez AI. Z biegiem pokoleń modele zaczynają zapominać prawdziwy rozkład danych, co prowadzi do coraz bardziej jednorodnych i mniej różnorodnych wyników.

Znaczenie

Załamanie modelu jest istotne, ponieważ zagraża przyszłości generatywnej AI. Wraz ze wzrostem ilości treści generowanych przez AI w internecie, dane treningowe dla nowych modeli ulegają zanieczyszczeniu, co obniża jakość przyszłych wyników AI. To zjawisko może prowadzić do cyklu, w którym dane generowane przez AI stopniowo tracą swoją wartość, utrudniając trenowanie modeli wysokiej jakości w przyszłości.

Jak dochodzi do załamania modelu?

Załamanie modelu zwykle występuje z powodu kilku powiązanych ze sobą czynników:

Nadmierne poleganie na danych syntetycznych

Gdy modele AI są trenowane głównie na treściach generowanych przez AI, zaczynają naśladować te wzorce zamiast uczyć się złożoności danych pochodzących od ludzi.

Uprzedzenia treningowe

Obszerne zbiory danych często zawierają wrodzone uprzedzenia. Aby uniknąć generowania obraźliwych lub kontrowersyjnych wyników, modele mogą być trenowane do tworzenia bezpiecznych, nijakich odpowiedzi, przyczyniając się do braku różnorodności w wynikach.

Pętle sprzężenia zwrotnego

W miarę jak modele generują mniej kreatywne wyniki, te nieinspirujące treści mogą trafiać z powrotem do danych treningowych, tworząc pętlę sprzężenia zwrotnego, która jeszcze bardziej utrwala ograniczenia modelu.

Osiąganie nagród przez oszukiwanie

Modele AI napędzane systemami nagród mogą nauczyć się optymalizować pod kątem określonych metryk, często znajdując sposoby na „oszukiwanie” systemu poprzez generowanie odpowiedzi maksymalizujących nagrody, ale pozbawionych kreatywności lub oryginalności.

Przyczyny załamania modelu

Przeciążenie danymi syntetycznymi

Główną przyczyną załamania modelu jest nadmierne poleganie na danych syntetycznych podczas treningu. Gdy modele są trenowane na danych generowanych przez inne modele, tracone są niuanse i złożoność danych pochodzących od ludzi.

Zanieczyszczenie danych

W miarę jak internet zalewany jest treściami generowanymi przez AI, coraz trudniej jest znaleźć i wykorzystać wysokiej jakości dane pochodzące od ludzi. To zanieczyszczenie danych treningowych prowadzi do mniej dokładnych i bardziej podatnych na załamanie modeli.

Brak różnorodności

Trenowanie na powtarzalnych i jednorodnych danych prowadzi do utraty różnorodności wyników modelu. Z czasem model zapomina o mniej powszechnych, ale istotnych aspektach danych, co dodatkowo pogarsza jego wydajność.

Przejawy załamania modelu

Załamanie modelu może prowadzić do kilku zauważalnych efektów, w tym:

- Zapominanie rzeczywistych rozkładów danych: Modele mogą utracić zdolność do dokładnego odzwierciedlania rzeczywistego rozkładu danych.

- Nijakie i ogólne wyniki: Wyniki modelu stają się bezpieczne, ale nieinspirujące.

- Trudności z kreatywnością i innowacyjnością: Model ma trudność z tworzeniem unikalnych lub wnikliwych odpowiedzi.

Konsekwencje załamania modelu

Ograniczona kreatywność

Modele, które uległy załamaniu, mają trudności z innowacjami lub przekraczaniem granic w swoich dziedzinach, co prowadzi do stagnacji rozwoju AI.

Stagnacja rozwoju AI

Jeśli modele konsekwentnie wybierają „bezpieczne” odpowiedzi, rzeczywisty postęp w możliwościach AI zostaje zahamowany.

Utracone szanse

Załamanie modelu sprawia, że AI są mniej zdolne do rozwiązywania rzeczywistych problemów wymagających zniuansowanego rozumienia i elastycznych rozwiązań.

Utrwalanie uprzedzeń

Ponieważ załamanie modelu często wynika z uprzedzeń w danych treningowych, istnieje ryzyko wzmacniania istniejących stereotypów i niesprawiedliwości.

Wpływ na różne typy modeli generatywnych

Generative Adversarial Networks (GANs)

GAN-y, w których generator tworzy realistyczne dane, a dyskryminator odróżnia dane prawdziwe od fałszywych, mogą cierpieć na tzw. mode collapse. Występuje to, gdy generator produkuje jedynie ograniczoną różnorodność wyników, nie oddając pełni różnorodności rzeczywistych danych.

Wariacyjne autoenkodery (VAEs)

VAEs, których celem jest zakodowanie danych do niższych wymiarów, a następnie ich dekodowanie, również mogą być podatne na załamanie modelu, co skutkuje mniej różnorodnymi i kreatywnymi wynikami.

Najczęściej zadawane pytania

- Czym jest załamanie modelu w AI?

Załamanie modelu to sytuacja, gdy wydajność modelu AI degraduje się z czasem, szczególnie w wyniku trenowania na danych syntetycznych lub generowanych przez AI, prowadząc do mniej różnorodnych i mniej kreatywnych wyników.

- Co powoduje załamanie modelu?

Załamanie modelu jest głównie spowodowane nadmiernym poleganiem na danych syntetycznych, zanieczyszczeniem danych, uprzedzeniami treningowymi, pętlami sprzężenia zwrotnego i oszukiwaniem systemów nagród, co skutkuje tym, że modele zapominają o różnorodności danych rzeczywistych.

- Jakie są konsekwencje załamania modelu?

Konsekwencje to ograniczona kreatywność, stagnacja rozwoju AI, utrwalanie uprzedzeń oraz utracone szanse na rozwiązywanie złożonych, rzeczywistych problemów.

- Jak można zapobiegać załamaniu modelu?

Zapobieganie polega na zapewnieniu dostępu do wysokiej jakości danych generowanych przez ludzi, minimalizowaniu danych syntetycznych w treningu oraz eliminowaniu uprzedzeń i pętli sprzężenia zwrotnego w rozwoju modeli.

Buduj odporne rozwiązania AI

Dowiedz się, jak zapobiegać załamaniu modelu i zapewnić, że Twoje modele AI pozostaną kreatywne i skuteczne. Poznaj najlepsze praktyki i narzędzia do trenowania wysokiej jakości AI.