Rozszerzanie zapytań

Rozszerzanie zapytań wzbogaca zapytania użytkowników o dodatkowy kontekst lub terminy, zwiększając precyzję wyszukiwania oraz jakość odpowiedzi w systemach AI, takich jak RAG i chatboty.

Rozszerzanie zapytań

Rozszerzanie zapytań wzbogaca zapytania użytkownika o dodatkowe terminy lub kontekst, poprawiając wyszukiwanie dokumentów i precyzję odpowiedzi. W systemach RAG zwiększa recall i trafność, pomagając chatbotom i AI w udzielaniu precyzyjnych odpowiedzi, skutecznie radząc sobie z nieprecyzyjnymi lub synonimicznymi zapytaniami.

Rozszerzanie zapytań to proces ulepszania pierwotnego zapytania użytkownika poprzez dodanie dodatkowych terminów lub kontekstu przed przekazaniem go do mechanizmu wyszukiwania. Takie rozszerzenie pozwala pozyskać bardziej trafne dokumenty lub informacje, które następnie wykorzystywane są do wygenerowania dokładniejszej i bardziej kontekstowej odpowiedzi. Jeśli dokumenty są wyszukiwane z użyciem alternatywnych zapytań, a następnie ponownie sortowane, cały proces RAG zapewnia znacznie bardziej precyzyjne wyniki dokumentów w kontekstowym oknie promptu.

Czym jest Retrieval-Augmented Generation (RAG)?

Retrieval-Augmented Generation (RAG) to architektura AI, która łączy mechanizmy wyszukiwania z modelami generatywnymi, aby tworzyć dokładniejsze i bardziej kontekstowe odpowiedzi. W systemach RAG komponent wyszukiwania pobiera trafne dokumenty lub fragmenty danych z bazy wiedzy na podstawie zapytania użytkownika. Następnie model generatywny (często Duży Model Językowy – LLM) wykorzystuje te informacje do wygenerowania spójnej i informacyjnej odpowiedzi.

Rola Rozszerzania zapytań w systemach RAG

Ulepszanie efektywności wyszukiwania

W systemach RAG jakość wygenerowanej odpowiedzi w dużej mierze zależy od trafności wyszukanych dokumentów. Jeśli komponent retrieval nie pobierze najbardziej istotnych informacji, model generatywny może wygenerować nieoptymalne lub nietrafne odpowiedzi. Rozszerzanie zapytań rozwiązuje ten problem poprzez udoskonalenie początkowego zapytania, zwiększając szansę na pobranie wszystkich istotnych dokumentów.

Zwiększanie recall

Rozszerzając pierwotne zapytanie o powiązane terminy, synonimy lub parafrazy, Rozszerzanie zapytań poszerza przestrzeń wyszukiwania. To zwiększa recall systemu retrieval, czyli pozwala pobrać większy odsetek istotnych dokumentów z bazy wiedzy. Wyższy recall oznacza bardziej kompletny kontekst dla modelu generatywnego, co przekłada się na lepszą jakość odpowiedzi systemu RAG.

Jak stosuje się Rozszerzanie zapytań w systemach RAG?

Etapy procesu Rozszerzania zapytań

- Otrzymanie zapytania użytkownika: Proces rozpoczyna się oryginalnym zapytaniem użytkownika, które może być niekompletne, nieprecyzyjne lub używać terminologii niezgodnej z dokumentami w bazie wiedzy.

- Generowanie rozszerzonych zapytań: System generuje dodatkowe zapytania, semantycznie podobne do oryginału. Można to zrobić różnymi technikami, w tym z użyciem dużych modeli językowych (LLM).

- Wyszukiwanie dokumentów: Każde rozszerzone zapytanie służy do pobrania dokumentów z bazy wiedzy. W efekcie otrzymujemy większy i bardziej zróżnicowany zbiór potencjalnie istotnych dokumentów.

- Agregacja wyników: Pozyskane dokumenty są agregowane, duplikaty usuwane, a całość sortowana według trafności.

- Generowanie odpowiedzi: Model generatywny wykorzystuje zebrane dokumenty do wygenerowania finalnej odpowiedzi na zapytanie użytkownika.

Techniki Rozszerzania zapytań

1. Wykorzystanie dużych modeli językowych (LLM)

LLM-y, takie jak GPT-4, mogą generować semantycznie podobne zapytania lub parafrazy pierwotnego zapytania. Dzięki rozumieniu kontekstu i niuansów językowych, modele te potrafią tworzyć wysokiej jakości rozszerzenia, obejmujące różne sposoby zadania tego samego pytania.

Przykład:

- Oryginalne zapytanie: „Skutki zmian klimatu”

- Rozszerzone zapytania generowane przez LLM:

- „Wpływ globalnego ocieplenia”

- „Konsekwencje zmian środowiskowych”

- „Zmiany klimatyczne i ich skutki”

2. Generowanie hipotetycznej odpowiedzi

W tym podejściu system generuje hipotetyczną odpowiedź na zapytanie użytkownika wykorzystując LLM. Hipotetyczna odpowiedź zostaje następnie dodana do oryginalnego zapytania, aby dostarczyć więcej kontekstu podczas wyszukiwania.

Proces:

- Wygeneruj hipotetyczną odpowiedź na zapytanie.

- Połącz oryginalne zapytanie z hipotetyczną odpowiedzią.

- Użyj połączonego tekstu jako zapytania do wyszukiwania.

Przykład:

- Oryginalne zapytanie: „Jakie czynniki przyczyniły się do wzrostu przychodów?”

- Hipotetyczna odpowiedź:

- „Przychody firmy wzrosły dzięki udanym kampaniom marketingowym, dywersyfikacji produktu i ekspansji na nowe rynki.”

- Połączone zapytanie:

- „Jakie czynniki przyczyniły się do wzrostu przychodów? Przychody firmy wzrosły dzięki udanym kampaniom marketingowym, dywersyfikacji produktu i ekspansji na nowe rynki.”

3. Podejście multi-query

Ta metoda polega na generowaniu wielu alternatywnych zapytań, obejmujących różne sformułowania lub aspekty oryginalnego pytania. Każde zapytanie wykorzystywane jest osobno do pobierania dokumentów.

Proces:

- Wygeneruj kilka podobnych zapytań przy użyciu LLM.

- Pobierz dokumenty dla każdego z nich niezależnie.

- Połącz i posortuj pobrane dokumenty.

Przykład:

- Oryginalne zapytanie: „Kluczowe czynniki wzrostu firmy”

- Rozszerzone zapytania:

- „Główne czynniki ekspansji biznesowej”

- „Co przyczyniło się do wzrostu wyników firmy?”

- „Najważniejsze elementy rozwoju organizacji”

Przykłady i zastosowania

Studium przypadku: Usprawnienie RAG przy analizie raportu rocznego

Scenariusz:

System AI odpowiada na pytania w oparciu o raport roczny firmy. Użytkownik pyta: „Czy doszło do znaczącej rotacji w kadrze zarządzającej?”

Implementacja:

- Generowanie hipotetycznej odpowiedzi:

- System generuje hipotetyczną odpowiedź: „Rotacja w kadrze zarządzającej była minimalna, co zapewniło stabilność i ciągłość realizacji strategii.”

- Rozszerzanie zapytania:

- Hipotetyczna odpowiedź zostaje połączona z oryginalnym zapytaniem, tworząc rozszerzone zapytanie.

- Wyszukiwanie:

- Rozszerzone zapytanie służy do pobrania bardziej trafnych fragmentów raportu dotyczących zmian w kadrze zarządzającej.

- Generowanie:

- AI generuje precyzyjną odpowiedź na podstawie pobranych informacji.

Korzyść:

Dzięki wzbogaceniu kontekstu przez hipotetyczną odpowiedź system pobiera istotne informacje, które mogłyby zostać pominięte przy oryginalnym zapytaniu.

Studium przypadku: Ulepszanie wyszukiwania w chatbotach wsparcia technicznego

Scenariusz:

Chatbot wsparcia klienta pomaga użytkownikom rozwiązywać problemy. Użytkownik wpisuje: „Mój internet jest wolny.”

Implementacja:

- Rozszerzanie zapytania z wykorzystaniem LLM:

- Generowanie rozszerzonych zapytań:

- „Doświadczam spowolnienia internetu”

- „Wolne łącze szerokopasmowe”

- „Problemy z opóźnieniami internetu”

- Generowanie rozszerzonych zapytań:

- Wyszukiwanie:

- Każde zapytanie pobiera artykuły pomocy i instrukcje rozwiązywania problemów związanych z wolnym internetem.

- Generowanie odpowiedzi:

- Chatbot kompiluje pobrane informacje i prowadzi użytkownika przez możliwe rozwiązania.

Korzyść:

Chatbot obejmuje szerszy zakres potencjalnych problemów i rozwiązań, zwiększając szansę na skuteczne rozwiązanie zgłoszenia.

Studium przypadku: Wsparcie w badaniach naukowych

Scenariusz:

Student korzysta z asystenta AI, by znaleźć materiały na temat: „Wpływ deprywacji snu na funkcje poznawcze.”

Implementacja:

- Generowanie wielu zapytań:

- Generowanie podobnych zapytań:

- „Jak brak snu wpływa na zdolności myślenia?”

- „Zaburzenia poznawcze wynikające z niedoboru snu”

- „Deprywacja snu a sprawność umysłowa”

- Generowanie podobnych zapytań:

- Wyszukiwanie:

- Pobranie artykułów naukowych i publikacji dla każdego zapytania.

- Agregacja i ranking:

- Połączenie wyników, priorytetyzacja najtrafniejszych i najnowszych badań.

- Generowanie odpowiedzi:

- AI przedstawia podsumowanie ustaleń i sugeruje kluczowe publikacje do przejrzenia.

Korzyść:

Student otrzymuje kompleksowe informacje obejmujące różne aspekty tematu, co ułatwia dokładniejsze badania.

Korzyści z Rozszerzania zapytań w systemach RAG

- Zwiększony recall: Pobranie większej liczby trafnych dokumentów zapewnia lepszy kontekst dla generowania dokładnych odpowiedzi.

- Radzenie sobie z nieprecyzyjnymi zapytaniami: Rozwiązuje problem krótkich lub niejasnych zapytań poprzez dodanie kontekstu.

- Rozpoznawanie synonimów: Obejmuje dokumenty zawierające synonimy lub powiązane terminy nieobecne w oryginalnym zapytaniu.

- Lepsze doświadczenie użytkownika: Użytkownik otrzymuje bardziej precyzyjne i informacyjne odpowiedzi bez konieczności ręcznego doprecyzowania zapytania.

Wyzwania i kwestie do rozważenia

Nadmierne rozszerzanie

Dodanie zbyt wielu rozszerzonych zapytań może wprowadzić nieistotne dokumenty, co obniża precyzję wyszukiwania.

Rozwiązanie:

- Kontrolowane generowanie: Ogranicz liczbę rozszerzonych zapytań.

- Filtrowanie trafności: Wykorzystaj mechanizmy oceniania, by priorytetyzować najbardziej trafne rozszerzenia.

Wieloznaczność i polisemiczność

Słowa o wielu znaczeniach mogą prowadzić do nieistotnych rozszerzeń.

Rozwiązanie:

- Rozszerzanie kontekstowe: Wykorzystaj LLM uwzględniające kontekst zapytania.

- Techniki rozróżniania znaczeń: Wprowadź algorytmy odróżniające znaczenia na podstawie kontekstu zapytania.

Zasoby obliczeniowe

Generowanie i przetwarzanie wielu rozszerzonych zapytań może być kosztowne obliczeniowo.

Rozwiązanie:

- Wydajne modele: Użyj zoptymalizowanych LLM i systemów retrieval.

- Mechanizmy cache’owania: Buforuj często występujące zapytania i rozszerzenia, aby ograniczyć obciążenie.

Integracja z systemami retrieval

Zapewnienie skutecznego działania rozszerzonych zapytań z istniejącymi algorytmami wyszukiwania.

Rozwiązanie:

- Dostosowanie scoringu: Modyfikuj scoring retrieval, uwzględniając rozszerzone zapytania.

- Podejścia hybrydowe: Łącz metody oparte na słowach kluczowych i wyszukiwanie semantyczne.

Techniki skutecznego Rozszerzania zapytań

Ważenie terminów

Przypisywanie wag terminom w rozszerzonych zapytaniach, aby odzwierciedlić ich znaczenie.

- TF-IDF (Term Frequency-Inverse Document Frequency): Mierzy istotność terminu w dokumencie względem całego korpusu.

- BM25: Funkcja rankingowa stosowana przez wyszukiwarki do szacowania trafności dokumentów.

- Wagi niestandardowe: Dostosowanie wag w zależności od trafności rozszerzonych terminów.

Ponowne rankingowanie pobranych dokumentów

Po pobraniu dokumentów, ponownie sortowanie ich według trafności.

- Cross-Encoders: Modele oceniające trafność par zapytanie-dokument.

- Modele re-rankingowe (np. ColBERT, FlashRank): Wyspecjalizowane modele zapewniające wydajne i precyzyjne rankingowanie.

Przykład:

Użycie Cross-Encodera po retrieval do oceniania i ponownego sortowania dokumentów pod kątem ich trafności względem oryginalnego zapytania.

Wykorzystanie opinii użytkowników

Uwzględnianie interakcji użytkowników do ulepszania rozszerzania zapytań.

- Feedback niejawny: Analiza zachowań użytkowników, np. kliknięć i czasu spędzonego na dokumentach.

- Feedback jawny: Pozwolenie użytkownikom na doprecyzowanie zapytań lub wybór preferowanych wyników.

Powiązania z AI, automatyzacją AI i chatbotami

Rozszerzanie zapytań oparte na AI

Wykorzystanie AI i LLM do rozszerzania zapytań pozwala na zaawansowane rozumienie języka, poprawiając retrieval. Dzięki temu systemy AI, w tym chatboty i wirtualni asystenci, mogą udzielać trafniejszych i bardziej kontekstowych odpowiedzi.

Automatyzacja wyszukiwania informacji

Automatyzacja procesu rozszerzania zapytań odciąża użytkowników z konieczności formułowania precyzyjnych pytań. Automatyzacja AI zajmuje się złożonością „pod maską”, zwiększając wydajność systemów wyszukiwania informacji.

Ulepszanie interakcji z chatbotami

Chatboty korzystają z Rozszerzania zapytań, lepiej rozumiejąc intencje użytkownika, zwłaszcza gdy używane są kolokwializmy lub niepełne frazy. Prowadzi to do bardziej satysfakcjonujących interakcji i efektywnego rozwiązywania problemów.

Przykład:

Chatbot wspierający obsługę techniczną może zinterpretować nieprecyzyjne zapytanie użytkownika, np. „Aplikacja mi nie działa”, poprzez rozszerzenie go o „awarie aplikacji”, „oprogramowanie nie odpowiada” i „komunikaty o błędach aplikacji”, co przyspiesza rozwiązanie problemu.

Badania nad Rozszerzaniem zapytań dla RAG

Improving Retrieval for RAG based Question Answering in question answering, enhancing accuracy with real-time data. Discover more!") Models on Financial Documents

Artykuł analizuje skuteczność dużych modeli językowych (LLM) wspieranych przez RAG, szczególnie na dokumentach finansowych. Wskazuje, że niedokładności wyników LLM często wynikają z nieoptymalnego pobierania fragmentów tekstu, a nie z samych modeli. Praca proponuje usprawnienia procesów RAG, w tym zaawansowane techniki chunkowania i rozszerzania zapytań, a także wykorzystanie adnotacji metadanych i algorytmów re-rankingowych. Celem tych działań jest ulepszenie pobierania tekstu, co zwiększa precyzję generowanych odpowiedzi przez LLM. Przeczytaj więcejEnhancing Retrieval and Managing Retrieval: A Four-Module Synergy for Improved Quality and Efficiency in RAG Systems

Artykuł przedstawia modularne podejście do usprawnienia systemów RAG, koncentrując się na module Query Rewriter, który tworzy zapytania przyjazne wyszukiwaniu. Rozwiązuje problemy z Information Plateaus i wieloznacznością zapytań poprzez generowanie wielu zapytań. Dodatkowo Knowledge Filter i Memory Knowledge Reservoir zarządzają nieistotną wiedzą i optymalizują zasoby retrieval. Te usprawnienia mają poprawić jakość odpowiedzi i efektywność systemów RAG, co potwierdzono eksperymentami na zbiorach QA. Dostęp do kodu i szczegółów.MultiHop-RAG: Benchmarking Retrieval-Augmented Generation for Multi-Hop Queries

Badanie to wskazuje wyzwania, przed którymi stają obecne systemy RAG przy obsłudze zapytań multi-hop, wymagających wnioskowania na podstawie wielu fragmentów wiedzy. Wprowadza nowy zbiór danych benchmarkowych do oceny systemów RAG przy tego typu zapytaniach, mając na celu rozwój metod RAG w kierunku skutecznej obsługi złożonych struktur zapytań i poprawy wdrożenia LLM w zastosowaniach praktycznych.

Najczęściej zadawane pytania

- Czym jest Rozszerzanie zapytań?

Rozszerzanie zapytań to proces uzupełniania pierwotnego zapytania użytkownika o powiązane terminy, synonimy lub kontekst, co pomaga systemom wyszukiwania pobierać bardziej trafne dokumenty i generować dokładniejsze odpowiedzi, szczególnie w aplikacjach opartych na AI.

- Jak Rozszerzanie zapytań usprawnia systemy RAG?

W systemach RAG (Retrieval-Augmented Generation) Rozszerzanie zapytań zwiększa recall komponentu wyszukiwania poprzez poszerzenie przestrzeni poszukiwań, dzięki czemu więcej trafnych dokumentów jest branych pod uwagę przy generowaniu precyzyjnych odpowiedzi.

- Jakie techniki stosuje się do Rozszerzania zapytań?

Techniki obejmują wykorzystanie dużych modeli językowych do generowania parafrazowanych zapytań, tworzenia hipotetycznych odpowiedzi, podejść multi-query, ważenia terminów oraz wykorzystania opinii użytkowników do ciągłego doskonalenia.

- Jakie są korzyści z Rozszerzania zapytań?

Rozszerzanie zapytań zwiększa recall, radzi sobie z nieprecyzyjnymi lub wieloznacznymi zapytaniami, rozpoznaje synonimy i poprawia doświadczenie użytkownika, dostarczając trafniejsze i bardziej informacyjne odpowiedzi bez konieczności ręcznego doprecyzowania zapytania.

- Czy wiążą się z tym jakieś wyzwania?

Tak, wyzwania to m.in. nadmierne rozszerzanie (prowadzące do pobierania nieistotnych dokumentów), wieloznaczność terminów, duże zapotrzebowanie na zasoby obliczeniowe oraz zapewnienie kompatybilności z algorytmami wyszukiwania. Można je ograniczyć przez kontrolowane generowanie, filtrowanie trafności oraz wydajne modele.

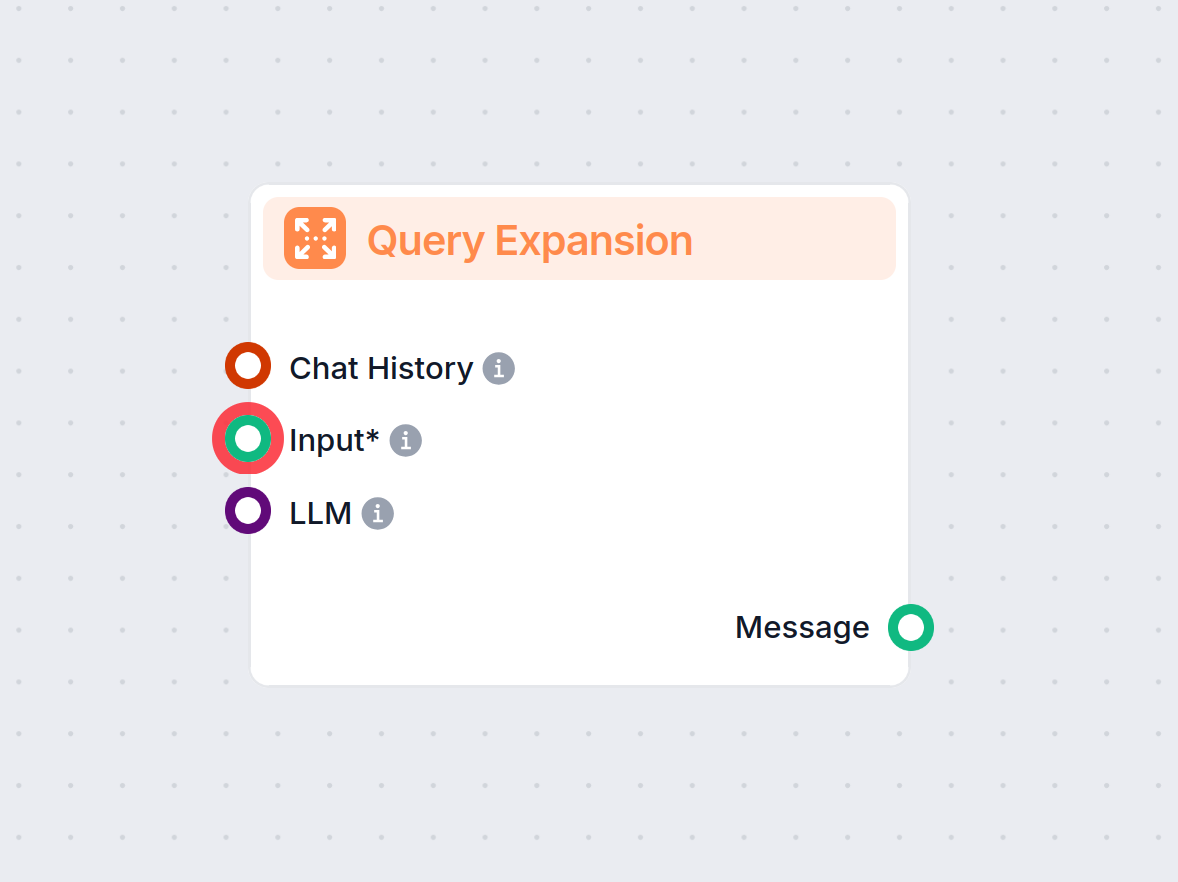

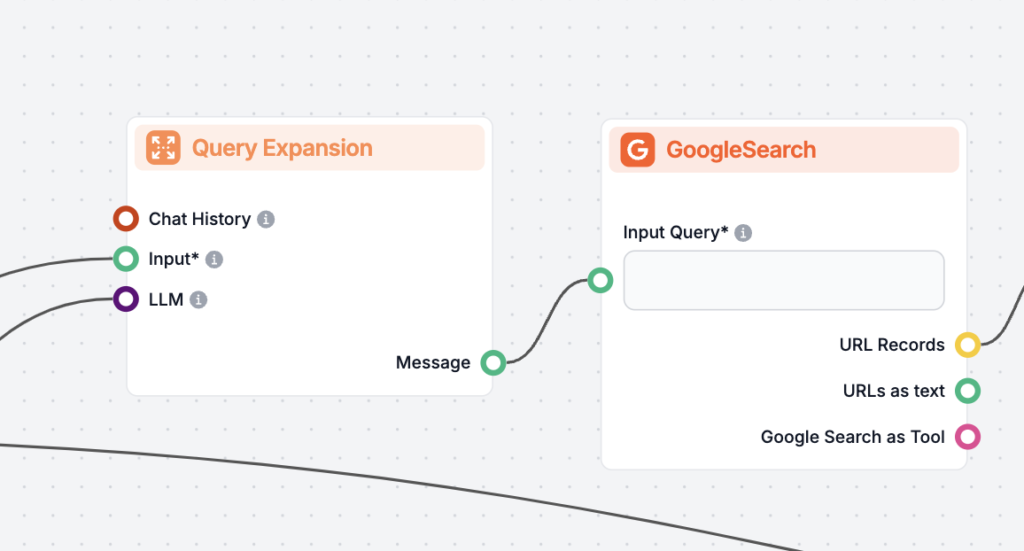

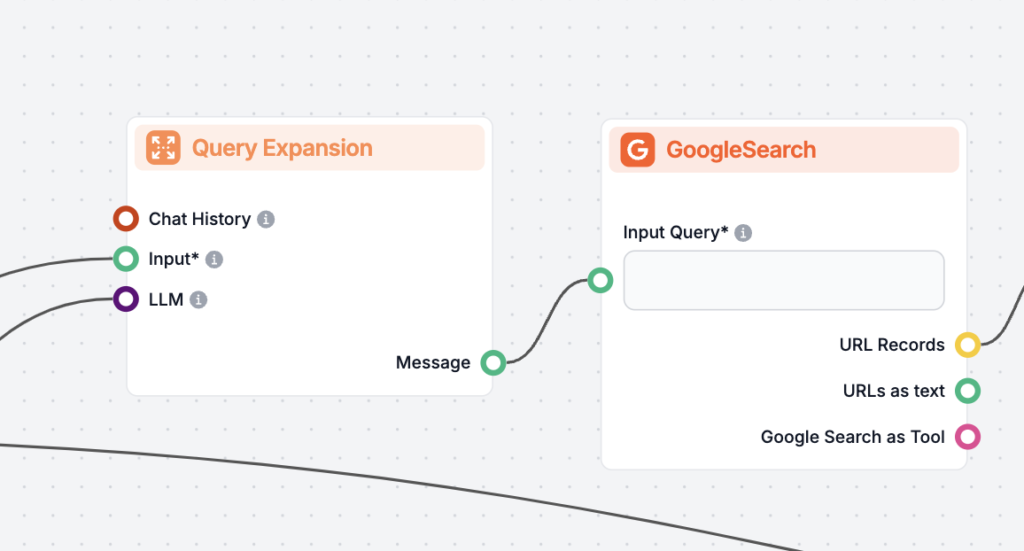

Poznaj Rozszerzanie zapytań z FlowHunt

Zobacz, jak Rozszerzanie zapytań może zwiększyć precyzję Twojego chatbota AI i poprawić wyszukiwanie informacji. Odkryj rozwiązania FlowHunt dla efektywnej, zautomatyzowanej obsługi zapytań.