Deepseek R1 MCP Server

Zintegruj modele DeepSeek zoptymalizowane pod kątem kontekstu i wnioskowania z Twoimi workflow AI dzięki Deepseek R1 MCP Server do zaawansowanych zadań językowych i automatyzacji.

Co robi serwer MCP „Deepseek R1”?

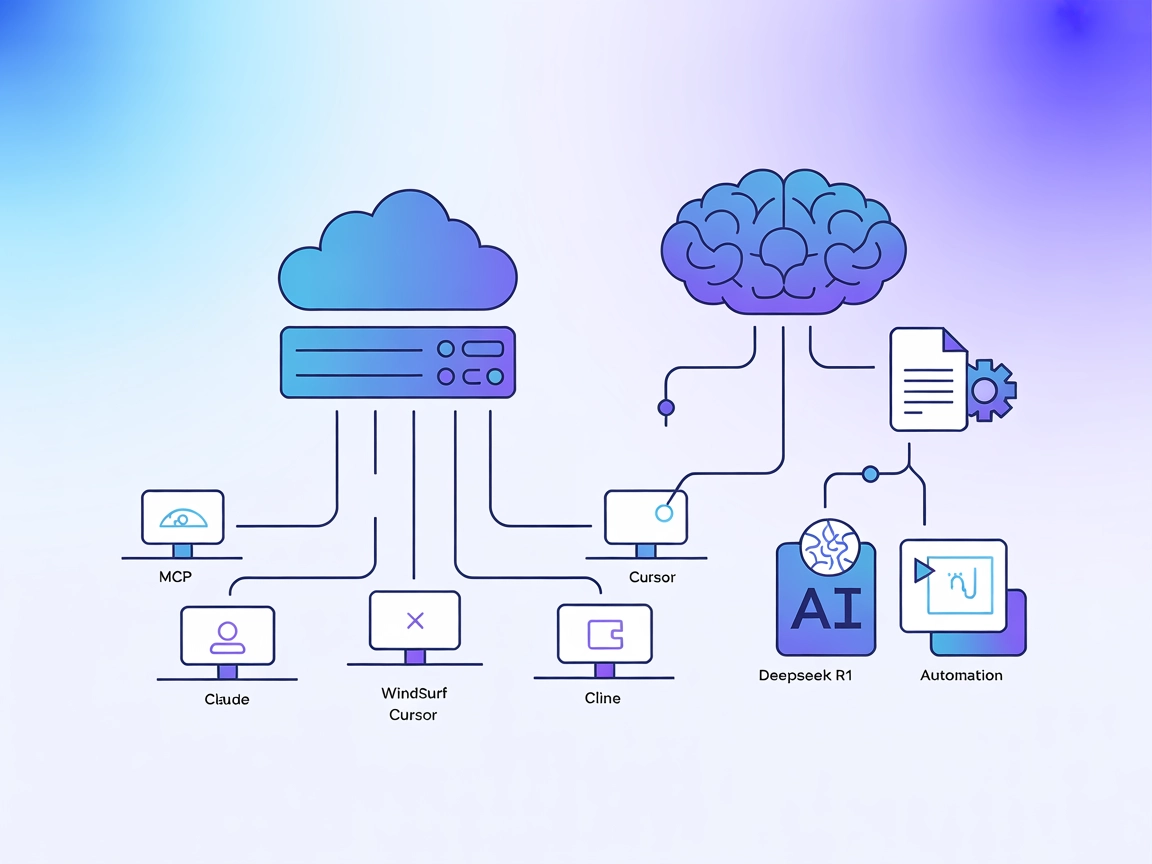

Serwer Deepseek R1 MCP to implementacja Model Context Protocol (MCP) zaprojektowana do połączenia Claude Desktop z zaawansowanymi modelami językowymi DeepSeek, takimi jak Deepseek R1 i DeepSeek V3. Działając jako pomost między asystentami AI a potężnymi modelami DeepSeek zoptymalizowanymi pod kątem wnioskowania (z oknem kontekstowym 8192 tokenów), serwer ten umożliwia agentom AI wykonywanie zaawansowanych zadań rozumienia i generowania języka naturalnego. Programiści mogą wykorzystać Deepseek R1 MCP Server do płynnej integracji tych modeli z własnymi workflow, ułatwiając zaawansowane generowanie tekstu, wnioskowanie i interakcję z zewnętrznymi źródłami danych lub API w obsługiwanych platformach. Implementacja koncentruje się na zapewnieniu stabilnej, niezawodnej i wydajnej integracji przy użyciu Node.js/TypeScript dla optymalnej kompatybilności i bezpieczeństwa typów.

Lista szablonów promptów

W repozytorium nie udokumentowano żadnych szablonów promptów.

Lista zasobów

W repozytorium nie udokumentowano żadnych jawnych zasobów MCP.

Lista narzędzi

- Zaawansowane narzędzie do generowania tekstu

- Umożliwia LLM generowanie tekstu przy użyciu Deepseek R1 (lub V3), wykorzystując duże okno kontekstowe i zdolności wnioskowania modelu.

Przypadki użycia tego serwera MCP

- Zaawansowane generowanie tekstu

Wykorzystaj duże okno kontekstowe DeepSeek R1 (8192 tokeny), aby tworzyć obszerne i złożone treści do dokumentacji, opowieści lub tekstów technicznych. - Zadania wymagające wnioskowania

Używaj zoptymalizowanych możliwości Deepseek R1 do zadań logicznych lub wieloetapowego wnioskowania, idealnych do rozwiązywania problemów i analiz. - Bezproblemowa integracja z Claude Desktop

Integruj nowoczesne modele językowe bezpośrednio ze środowiskiem Claude Desktop, rozszerzając możliwości asystenta AI w codziennej pracy. - Elastyczny wybór modelu

Przełączaj się między modelami Deepseek R1 i DeepSeek V3, zmieniając konfigurację w zależności od potrzeb projektu. - Automatyzacja oparta na API

Umożliwiaj automatyzację opartą na AI tam, gdzie dostępne jest API DeepSeek, usprawniając tworzenie treści lub zarządzanie bazą wiedzy.

Jak to skonfigurować

Windsurf

- Upewnij się, że masz zainstalowane Node.js (v18+) i npm.

- Sklonuj repozytorium i zainstaluj zależności:

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git cd deepseek-r1-mcp npm install - Skopiuj plik

.env.exempledo.envi ustaw swój klucz API DeepSeek. - Edytuj konfigurację Windsurf, aby dodać serwer MCP:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "twój-klucz-api" } } } } - Zapisz, zrestartuj Windsurf i upewnij się, że serwer działa.

Claude

- Zainstaluj Node.js (v18+) i npm.

- Sklonuj i skonfiguruj serwer Deepseek R1 MCP jak wyżej.

- W konfiguracji Claude dodaj:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "twój-klucz-api" } } } } - Zrestartuj Claude i sprawdź dostępność serwera MCP.

Cursor

- Zainstaluj wymagane narzędzia (Node.js, npm).

- Skonfiguruj serwer oraz zmienne środowiskowe.

- Dodaj serwer do konfiguracji Cursor:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "twój-klucz-api" } } } } - Zapisz, zrestartuj Cursor i przetestuj integrację serwera.

Cline

- Upewnij się, że Node.js i npm są zainstalowane.

- Sklonuj i zbuduj serwer Deepseek R1 MCP.

- Dodaj serwer do konfiguracji Cline:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "twój-klucz-api" } } } } - Zrestartuj Cline i potwierdź połączenie z serwerem MCP.

Zabezpieczenie kluczy API

Używaj zmiennych środowiskowych w konfiguracji, aby bezpiecznie przechowywać klucze API:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

Jak używać tego MCP we flows

Używanie MCP w FlowHunt

Aby zintegrować serwery MCP z workflow FlowHunt, zacznij od dodania komponentu MCP do flow i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji MCP wklej dane serwera MCP w tym formacie JSON:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://twojserwermcp.przyklad/sciezka_do_mcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjonalnościami i możliwościami. Pamiętaj, by zmienić “deepseek_r1” na faktyczną nazwę swojego serwera MCP oraz podmienić URL na adres swojego MCP.

Przegląd

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista szablonów promptów | ⛔ | Brak udokumentowanych szablonów |

| Lista zasobów | ⛔ | Brak jawnych zasobów MCP |

| Lista narzędzi | ✅ | Zaawansowane narzędzie do generowania tekstu |

| Zabezpieczanie kluczy API | ✅ | Używanie zmiennych środowiskowych w configu |

| Obsługa sampling-u (mniej istotne) | ⛔ | Brak dokumentacji |

| Obsługuje Roots | ⛔ | Brak dokumentacji |

Na podstawie dostępnej dokumentacji Deepseek R1 MCP Server oferuje czystą, ukierunkowaną implementację, którą łatwo skonfigurować i używać, ale brakuje dokumentacji dla promptów, zasobów oraz zaawansowanych funkcji MCP jak roots czy sampling. Czyni to rozwiązanie bardzo praktycznym do generowania tekstu, choć mniej rozbudowanym pod kątem skomplikowanych workflow.

Ocena MCP

| Posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Ma przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 12 |

| Liczba gwiazdek | 58 |

Najczęściej zadawane pytania

- Czym jest Deepseek R1 MCP Server?

To serwer Model Context Protocol (MCP), który działa jako most między Claude Desktop (lub innymi platformami) a zaawansowanymi modelami językowymi DeepSeek (R1, V3), umożliwiając rozszerzone generowanie tekstu, wnioskowanie i automatyzację w Twoich workflow AI.

- Jakie modele są obsługiwane?

Serwer wspiera Deepseek R1 i DeepSeek V3 — oba modele są zoptymalizowane pod kątem dużych okien kontekstowych i złożonych zadań wnioskowania.

- Jakie są główne przypadki użycia?

Przypadki użycia to zaawansowane generowanie tekstu (długie formy, techniczne lub kreatywne), zadania logiczne, bezproblemowe rozszerzenie możliwości asystenta AI w Claude Desktop oraz automatyzacja tworzenia treści lub zarządzania wiedzą przez API.

- Jak zabezpieczyć klucze API?

Zawsze używaj zmiennych środowiskowych w konfiguracji serwera MCP, by zapobiec przypadkowemu ujawnieniu klucza API DeepSeek.

- Czy są obsługiwane szablony promptów lub zasoby?

W repozytorium nie udokumentowano szablonów promptów ani jawnych zasobów MCP; serwer nastawiony jest na bezpośredni dostęp do modeli i integrację.

- Jakiej wielkości jest okno kontekstu?

DeepSeek R1 oferuje okno kontekstowe 8192 tokenów, co pozwala obsłużyć obszerne i złożone zadania.

- Czy projekt jest open source?

Tak, jest na licencji MIT i dostępny na GitHubie.

Podkręć swojego AI dzięki Deepseek R1

Odblokuj zaawansowane generowanie tekstu i wnioskowanie, łącząc FlowHunt lub Claude Desktop z potężnymi modelami DeepSeek R1. Zacznij budować inteligentniejsze workflow już dziś.