LLM Context MCP Server

Połącz płynnie agentów AI z projektami kodu i tekstu dzięki LLM Context MCP Server—optymalizując przepływy pracy deweloperskiej dzięki bezpiecznej, bogatej w kontekst i zautomatyzowanej pomocy.

Co robi serwer „LLM Context” MCP?

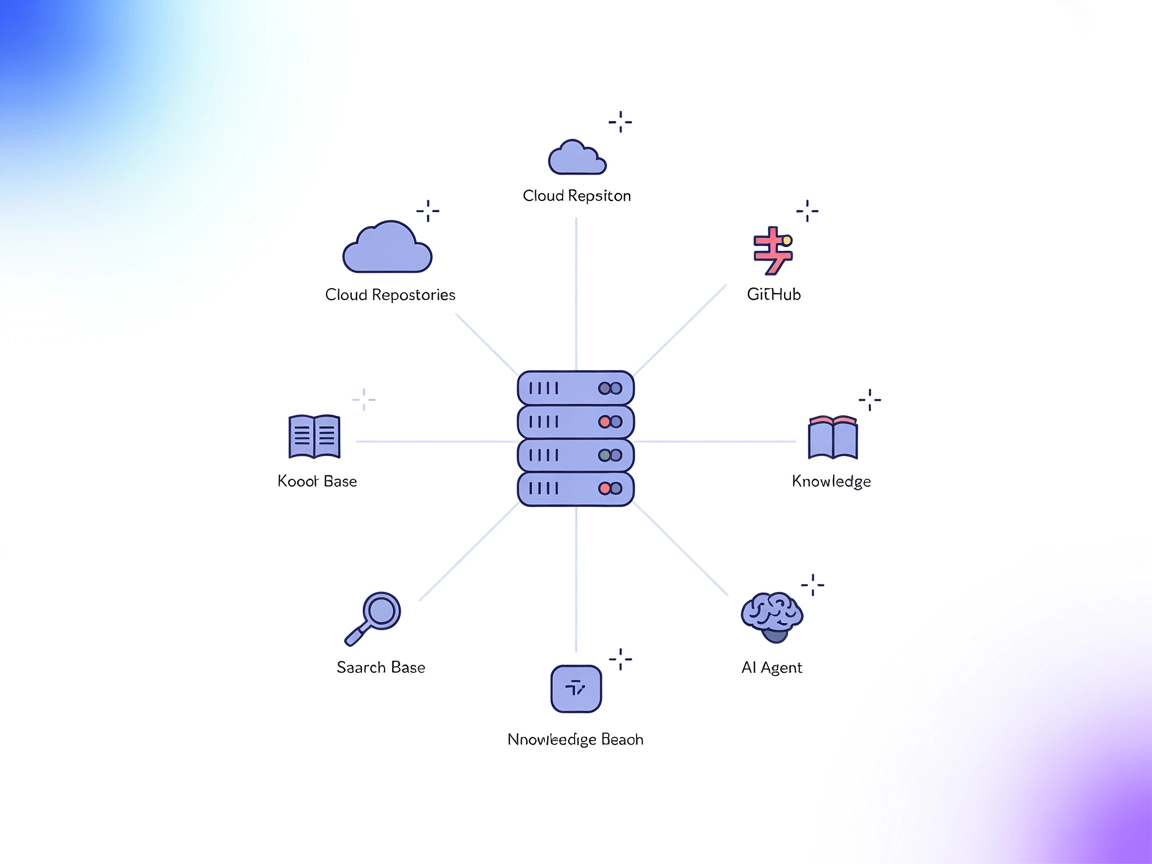

LLM Context MCP Server to narzędzie zaprojektowane do płynnego łączenia asystentów AI z zewnętrznymi projektami kodu i tekstu, usprawniające workflow deweloperski poprzez Model Context Protocol (MCP). Wykorzystując wzorce .gitignore do inteligentnego wyboru plików, pozwala deweloperom wstrzykiwać wysoce relewantne treści bezpośrednio do interfejsów czatu LLM lub korzystać z uproszczonego workflow ze schowkiem. Umożliwia to efektywne realizowanie zadań takich jak przegląd kodu, generowanie dokumentacji czy eksploracja projektu z pomocą kontekstowego wsparcia AI. LLM Context sprawdza się zarówno w repozytoriach kodu, jak i kolekcjach dokumentów tekstowych, stanowiąc uniwersalne łącze między danymi projektowymi a workflow opartym na AI.

Lista promptów

Brak informacji o zdefiniowanych szablonach promptów w repozytorium.

Lista zasobów

W udostępnionych plikach lub dokumentacji nie wspomniano o żadnych zasobach.

Lista narzędzi

W widocznej strukturze repozytorium nie występuje plik server.py ani równoważny plik z listą narzędzi. Nie znaleziono informacji o dostępnych narzędziach.

Przypadki użycia tego serwera MCP

- Automatyzacja przeglądu kodu: Wstrzykuje odpowiednie fragmenty kodu do interfejsów LLM, wspomagając automatyczne lub wspierane przeglądy kodu.

- Generowanie dokumentacji: Umożliwia AI dostęp do dokumentacji i jej podsumowanie bezpośrednio z plików projektu.

- Eksploracja projektu: Pomaga deweloperom i agentom AI szybko zrozumieć duże bazy kodu lub projekty tekstowe przez wyeksponowanie kluczowych plików i konspektów.

- Workflow ze schowkiem: Pozwala kopiować treści do i ze schowka w celu szybkiego udostępniania LLM, zwiększając produktywność w czatowych przepływach pracy.

Jak skonfigurować

Windsurf

- Upewnij się, że masz zainstalowane Node.js oraz Windsurf.

- Zlokalizuj plik konfiguracyjny Windsurf (np.

windsurf.config.json). - Dodaj LLM Context MCP Server korzystając z poniższego fragmentu JSON:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Zapisz konfigurację i zrestartuj Windsurf.

- Zweryfikuj konfigurację, sprawdzając czy serwer MCP pojawia się w Windsurf.

Claude

- Zainstaluj Node.js i upewnij się, że Claude obsługuje integrację MCP.

- Edytuj plik konfiguracyjny Claude, aby dodać serwer MCP:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Zapisz plik i zrestartuj Claude.

- Potwierdź dostępność serwera w ustawieniach MCP Claude.

Cursor

- Zainstaluj wszystkie wymagane zależności do edytora Cursor.

- Otwórz plik konfiguracyjny MCP dla Cursor.

- Dodaj LLM Context MCP Server:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Zapisz zmiany i zrestartuj Cursor.

- Zweryfikuj, czy serwer MCP działa poprawnie.

Cline

- Zainstaluj Node.js oraz Cline.

- Edytuj konfigurację Cline, aby zarejestrować serwer MCP:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": []

}

}

}

- Zapisz i zrestartuj Cline.

- Sprawdź, czy serwer MCP jest dostępny.

Zabezpieczanie kluczy API

Ustaw zmienne środowiskowe, aby chronić klucze API i sekrety. Przykładowa konfiguracja:

{

"mcpServers": {

"llm-context": {

"command": "llm-context-mcp",

"args": [],

"env": {

"API_KEY": "${LLM_CONTEXT_API_KEY}"

},

"inputs": {

"apiKey": "${LLM_CONTEXT_API_KEY}"

}

}

}

}

Jak używać tego MCP w flow

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP z workflow w FlowHunt, zacznij od dodania komponentu MCP do swojego flow i połącz go z agentem AI:

Kliknij na komponent MCP, aby otworzyć panel konfiguracyjny. W sekcji konfiguracji systemowej MCP wstaw szczegóły swojego serwera MCP używając tego formatu JSON:

{

"llm-context": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po zapisaniu agent AI będzie mógł korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, aby zmienić “llm-context” na faktyczną nazwę swojego serwera MCP i podać własny adres URL serwera MCP.

Przegląd

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak znalezionych informacji |

| Lista zasobów | ⛔ | Brak znalezionych informacji |

| Lista narzędzi | ⛔ | Brak znalezionych informacji |

| Zabezpieczanie kluczy API | ✅ | Podany przykład zmiennej środowiskowej |

| Sampling Support (mniej istotne przy ocenie) | ⛔ | Brak znalezionych informacji |

Na podstawie obu tabel, ten serwer MCP posiada mocny przegląd oraz dobre praktyki bezpieczeństwa, ale brakuje mu jasnej dokumentacji dotyczącej promptów, zasobów i narzędzi. Jest zatem najbardziej przydatny do podstawowych workflow dzielenia się kontekstem i wymaga dalszej dokumentacji, by w pełni wykorzystać zaawansowane możliwości MCP.

Ocena MCP

| Czy posiada LICENCJĘ | ✅ (Apache-2.0) |

|---|---|

| Czy ma przynajmniej jedno narzędzie | ⛔ |

| Liczba forków | 18 |

| Liczba gwiazdek | 231 |

Najczęściej zadawane pytania

- Czym jest LLM Context MCP Server?

LLM Context MCP Server łączy agentów AI z zewnętrznymi projektami kodu i tekstu, oferując inteligentny wybór kontekstu poprzez wzorce .gitignore i umożliwiając zaawansowane przepływy pracy, takie jak przegląd kodu, generowanie dokumentacji i eksploracja projektu bezpośrednio w interfejsach czatu LLM.

- Jakie są główne zastosowania tego serwera MCP?

Kluczowe zastosowania to automatyzacja przeglądu kodu, generowanie dokumentacji, szybka eksploracja projektu oraz udostępnianie treści ze schowka do LLM dla większej produktywności w przepływach opartych o czat.

- Jak bezpiecznie skonfigurować klucze API dla LLM Context MCP Server?

Ustaw zmienne środowiskowe z kluczami API (np. LLM_CONTEXT_API_KEY) i odwołaj się do nich w konfiguracji serwera MCP, aby klucze nie trafiały do kodu źródłowego ani plików konfiguracyjnych.

- Czy serwer posiada szablony promptów lub wbudowane narzędzia?

Nie, obecna wersja nie zawiera zdefiniowanych promptów ani wyraźnych narzędzi, przez co jest idealna do podstawowych workflow dzielenia się kontekstem, jednak wymaga dalszej personalizacji dla bardziej zaawansowanych funkcji.

- Na jakiej licencji działa LLM Context MCP Server?

Serwer jest open-source na licencji Apache-2.0.

- Jak użyć LLM Context MCP Server w FlowHunt?

Dodaj komponent MCP do swojego flow w FlowHunt, wpisz szczegóły serwera MCP w panelu konfiguracyjnym używając podanego formatu JSON i połącz go ze swoim agentem AI, aby uzyskać ulepszoną, kontekstową automatyzację.

Zwiększ swój workflow AI dzięki LLM Context MCP

Zintegruj LLM Context MCP Server z FlowHunt, aby uzyskać inteligentniejszą, kontekstową automatyzację w procesach kodowania i dokumentacji.