Integracja z serwerem Milvus MCP

Połącz LLM-y i agentów AI z Milvus, aby uzyskać potężne wyszukiwanie wektorowe, kontekstową pamięć oraz rekomendacje oparte na danych bezpośrednio w swoich przepływach FlowHunt.

Co robi serwer „Milvus” MCP?

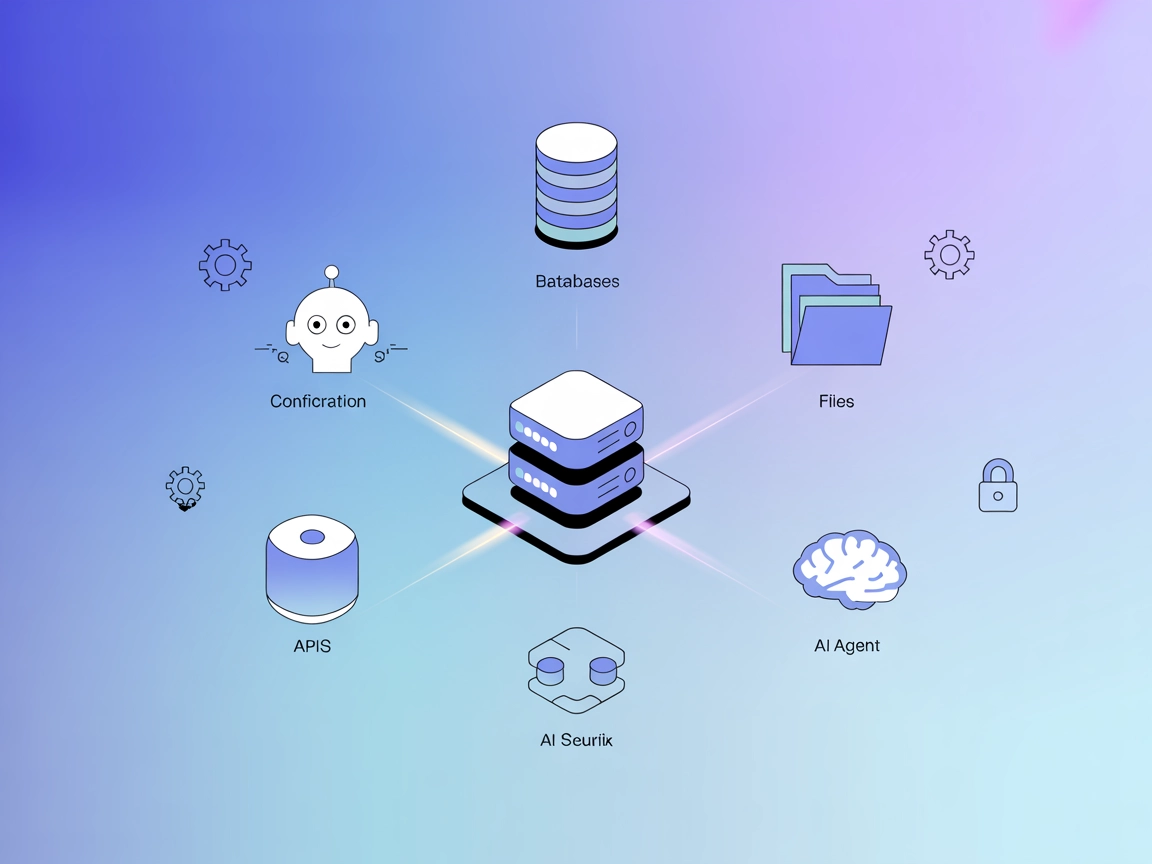

Serwer Milvus MCP (Model Context Protocol) łączy asystentów AI oraz aplikacje oparte na LLM z bazą wektorową Milvus. Umożliwia to płynną interakcję modeli językowych z wielkoskalowymi danymi wektorowymi, zapewniając standaryzowany sposób dostępu, zapytań i zarządzania Milvus z poziomu przepływów AI. Dzięki Milvus MCP Server deweloperzy mogą integrować wyszukiwanie, pobieranie i zarządzanie danymi opartymi o Milvus bezpośrednio w agentach AI, IDE lub interfejsach czatu. Serwer obsługuje wiele trybów komunikacji (stdio oraz Server-Sent Events), dzięki czemu pasuje do różnych scenariuszy wdrożeniowych i środowisk developerskich. Łącząc LLM-y z Milvus, znacząco zwiększa możliwości systemów AI w operacjach kontekstowych na danych o wysokiej wymiarowości, odblokowując bogatsze i bardziej inteligentne doświadczenia zasilane LLM.

Lista promptów

W repozytorium nie ma informacji o szablonach promptów.

Lista zasobów

W dostępnej dokumentacji ani kodzie nie opisano jawnej listy zasobów Model Context Protocol.

Lista narzędzi

W dostępnej dokumentacji i plikach kodu, w tym server.py, nie udokumentowano jawnej listy narzędzi ani nazw funkcji.

Przykładowe zastosowania tego serwera MCP

- Integracja wyszukiwania wektorowego: Pozwala deweloperom wykorzystywać LLM-y do wyszukiwania i pobierania odpowiednich dokumentów lub punktów danych z Milvus, ulepszając kontekstowe wyszukiwanie w aplikacjach AI.

- Zarządzanie embeddingami: Umożliwia LLM-om i agentom przechowywanie oraz zarządzanie embeddingami wektorowymi w Milvus, wspierając zaawansowane przepływy wyszukiwania semantycznego.

- Kontekstowa pamięć chatbotów: Ułatwia chatbotom lub asystentom AI utrzymanie długoterminowej pamięci poprzez zapisywanie danych konwersacyjnych jako wektory w Milvus do późniejszego pobrania.

- Analiza danych i rekomendacje: Napędza systemy rekomendacyjne oparte na AI, pozwalając LLM-om wykonywać wyszukiwania podobieństwa na dużych zbiorach danych przechowywanych w Milvus.

- Dostęp do danych w czasie rzeczywistym: Wspiera agentów AI wymagających dostępu do danych o wysokiej wymiarowości w czasie rzeczywistym do analityki, rozpoznawania wzorców czy detekcji anomalii.

Jak skonfigurować

Windsurf

- Upewnij się, że masz Python 3.10+ oraz uruchomioną instancję Milvus.

- Sklonuj repozytorium:

git clone https://github.com/zilliztech/mcp-server-milvus.git - Uruchom serwer:

uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530 - Dodaj serwer MCP do konfiguracji Windsurf:

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

- Zapisz i uruchom ponownie Windsurf. Zweryfikuj połączenie w interfejsie.

Zabezpieczanie kluczy API:

Jeśli serwer wymaga poufnych danych, użyj zmiennych środowiskowych:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

Claude

- Zainstaluj wymagane zależności: Python 3.10+, Milvus oraz uv.

- Sklonuj repozytorium i uruchom serwer jak powyżej.

- W ustawieniach Claude dodaj serwer MCP:

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

- Zapisz i uruchom ponownie Claude. Sprawdź, czy Milvus MCP pojawia się w dostępnych narzędziach.

Zabezpiecz dane logowania za pomocą zmiennych środowiskowych jak wyżej.

Cursor

- Zainstaluj Python 3.10+ oraz Milvus, a także

uv. - Sklonuj repozytorium i uruchom:

uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530 - W konfiguracji Cursor dodaj:

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

- Uruchom ponownie Cursor i zweryfikuj konfigurację.

Zabezpieczanie kluczy API:

Użyj zmiennych środowiskowych jak powyżej.

Cline

- Wymagania: Python 3.10+, Milvus oraz

uv. - Sklonuj repozytorium i uruchom serwer.

- Edytuj konfigurację Cline, aby dodać:

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

- Zapisz zmiany i uruchom ponownie Cline.

Zmienna środowiskowa:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

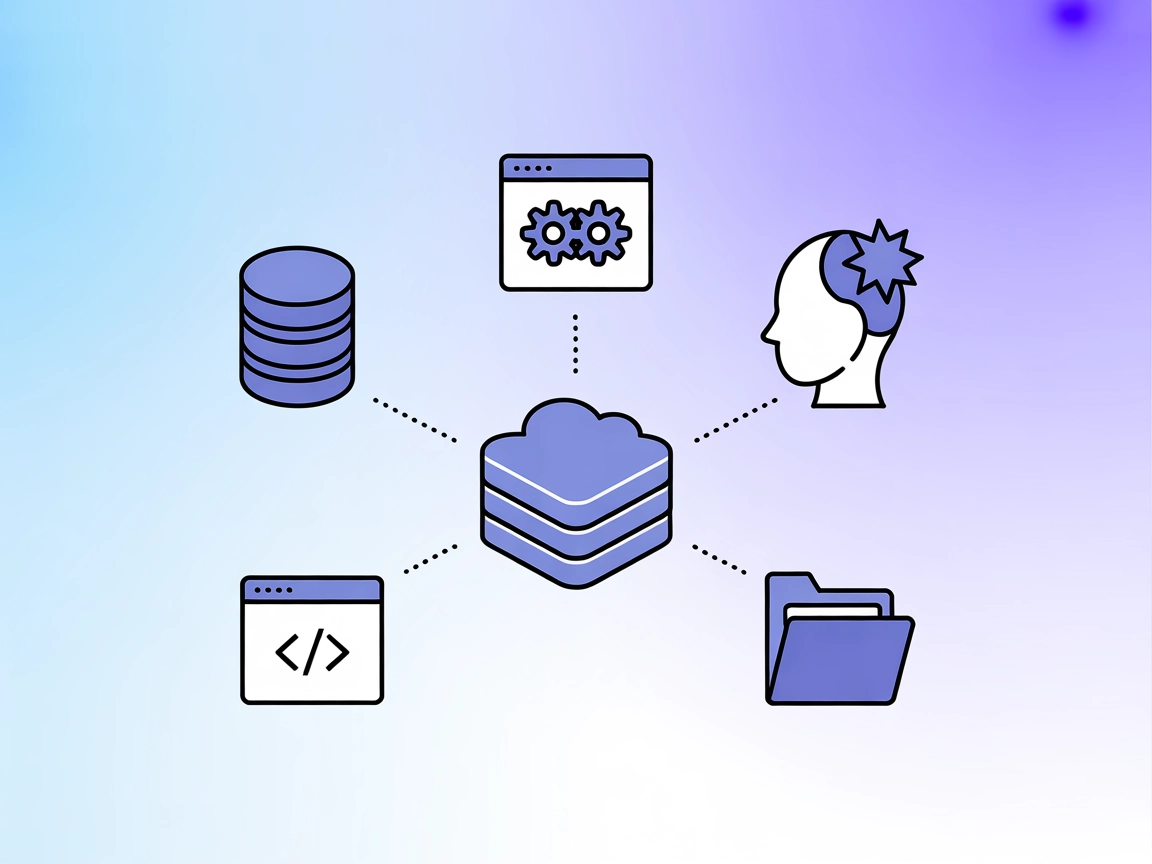

Jak używać tego MCP w przepływach

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP w swoim przepływie FlowHunt, rozpocznij od dodania komponentu MCP do przepływu i połączenia go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wklej dane serwera MCP w tym formacie JSON:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia, uzyskując dostęp do wszystkich jego funkcji i możliwości. Pamiętaj o zmianie “milvus-mcp” na faktyczną nazwę swojego serwera MCP oraz podmianie adresu URL na własny.

Przegląd

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnej listy zasobów MCP |

| Lista narzędzi | ⛔ | Brak jawnych narzędzi w dostępnych plikach |

| Zabezpieczanie kluczy API | ✅ | Użycie zmiennych środowiskowych, opisane w przykładach konfiguracji |

| Sampling Support (mniej istotne w ocenie) | ⛔ | Nie wspomniano |

Wsparcie dla “roots”: Nie wspomniano

Wsparcie dla sampling: Nie wspomniano

Nasza opinia

Serwer Milvus MCP to praktyczny i skoncentrowany most łączący LLM-y z Milvus, z jasnymi przewodnikami konfiguracji dla popularnych narzędzi developerskich. Niemniej jednak, dokumentacja jest uboga w szczegóły dotyczące zasobów MCP, promptów oraz działających API narzędzi, co ogranicza łatwość odkrywania „out-of-the-box”. Nadal jednak to solidna podstawa pod integracje AI oparte na bazach wektorowych.

Ocena MCP

| Czy ma LICENCJĘ | ✅ (Apache-2.0) |

|---|---|

| Ma przynajmniej jedno narzędzie | ⛔ |

| Liczba Forków | 32 |

| Liczba Gwiazdek | 139 |

Ogólnie: 4/10

Serwer jest użyteczny w swoim niszowym zastosowaniu, ale znacznie zyskałby na bardziej szczegółowej dokumentacji dotyczącej zasobów, szablonów promptów i API narzędzi, co ułatwiłoby interoperacyjność oraz obsługę.

Najczęściej zadawane pytania

- Czym jest serwer Milvus MCP?

Serwer Milvus MCP łączy asystentów AI i aplikacje LLM z bazą wektorową Milvus, umożliwiając płynne wyszukiwanie wektorowe, kontekstową pamięć oraz zarządzanie danymi dla zaawansowanych przepływów AI.

- Jakie są typowe zastosowania integracji z serwerem Milvus MCP?

Kluczowe zastosowania to wyszukiwanie wektorowe, zarządzanie embeddingami, kontekstowa pamięć chatbotów, rekomendacje oparte na AI oraz analiza danych w czasie rzeczywistym z wykorzystaniem Milvus w FlowHunt.

- Jak zabezpieczyć konfigurację serwera Milvus MCP?

Aby przechowywać poufne dane połączenia, skorzystaj ze zmiennych środowiskowych (np. MILVUS_URI), zgodnie z instrukcjami w przewodnikach dla poszczególnych klientów.

- Czy serwer Milvus MCP zapewnia szablony promptów lub API narzędzi?

Nie udokumentowano żadnych szablonów promptów ani API narzędzi. Serwer koncentruje się na dostarczaniu mostu do operacji wektorowych i zarządzania embeddingami.

- Jak wygląda ogólna ocena serwera Milvus MCP?

To solidna podstawa do łączenia LLM-ów z bazami wektorowymi, z jasnymi instrukcjami instalacji, ale skorzystałby z bardziej rozbudowanej dokumentacji dotyczącej promptów i API narzędzi dla łatwiejszego odkrywania i integracji.

Wzmocnij FlowHunt dzięki Milvus MCP

Rozszerz możliwości swoich agentów AI o płynny dostęp do baz wektorowych – uzyskaj inteligentniejsze wyszukiwanie, rekomendacje i pamięć kontekstową. Zintegruj serwer Milvus MCP z FlowHunt już teraz!